Ejercicios y problemas (Vol. II)

Título de la obra:

Álgebra Lineal Interactiva. Ejercicios y problemas. (Vol. II)

Autor:

Augusto Spela

Universidad tecnológica Nacional - FRBA

Buenos Aires (Argentina)

Código JavaScript para el libro: Joel Espinosa Longi, IMATE, UNAM.

Recursos interactivos: DescartesJS, WebSim, GeoGebra.

Fuentes: Lato y UbuntuMono

Imagen de portada: ilustración generada por Lexica

Red Educativa Digital Descartes

Córdoba (España)

descartes@proyectodescartes.org

https://proyectodescartes.org

Proyecto iCartesiLibri

https://proyectodescartes.org/iCartesiLibri/index.htm

ISBN: 978-84-10368-17-0

Esta obra está bajo una licencia Creative Commons 4.0 internacional: Reconocimiento-No Comercial-Compartir Igual.

Este libro interactivo continúa la senda trazada en el Volumen 1, el cual fue muy bien recibido por la comunidad educativa. En esta nueva entrega, abordamos más temas que continúan desarrollando los conceptos esenciales de la materia, ampliando y profundizando la comprensión adquirida previamente. De hecho, fue la solicitud de los propios alumnos lo que impulsó la creación de este segundo tomo, motivados por el interés y entusiasmo generado en el primero.

Al igual que su predecesor, no pretende ser un libro de referencia exhaustivo, apenas un complemento interactivo enfocado en el "hacer", que apoya a los buenos recursos que existen en la actualidad sobre Álgebra Lineal. Una lista sugerida de los mismos se ofrece en la

Especial mención y agradecimiento a la UDB Matemática de la Universidad Tecnológica Nacional FRBA, que una vez más me permitió utilizar parte del excelente material disponible en su sitio web de Álgebra y Geometría Analítica https://aga.frba.utn.edu.ar

Del mismo modo quiero expresar mi más sincero reconocimiento a la labor de los académicos Juan Guillermo Rivera Berrío, Ramiro Antonio Lopera Sánchez, Joel Espinosa Longi y demás desarrolladores del Proyecto iCartesiLibrihttps://proyectodescartes.org/iCartesiLibri/, por su invaluable ayuda y aporte de recursos y conocimientos, siempre ofrecidos de manera desinteresada y generosa.

En esta oportunidad hemos seguido trabajando con adaptaciones de recursos y applets disponibles en Geogebra. En cada caso compartimos la información sobre la autoría de los diseñadores de los mismos.

También hemos utilizado videos y algunas escenas interactivas realizadas en DescartesJS; pero la novedad en este volumen es el uso de las inteligencias artificiales generativas que han permitido realizar cuestionarios (aparecen al final de cada capítulo); diseñar páginas web como las nuevas secciones "¿Y esto para qué sirve?" y la "Herramienta IA con Pollinations.AI" inspiradas en trabajos del Dr. Juan Guillermo Rivera Berrío.

Por primera vez también habrá secciones que requerirán de conexión a internet, hemos propuesto un juego de "sala de escape" realizado en Genially, que no podrá concretarse sin conexión. Igualmente necesitaremos conectarnos para utilizar el interactivo "Herramienta IA". Además hay varios enlaces que complementan información que requerirán de dicha conexión.

El script que acompaña el inicio de cada capítulo es obra de Dan Margalit y Joseph Rabinoff, quienes junto a Larry Rolen han escrito el maravilloso libro interactivo Interactive Linear Algebra que ha sido fuente de inspiración conjuntamente con los libros de la colección iCartesiLibri para quien esto escribe. Gracias a ChatGPT he podido diseñar una página para que pueda correr dicho script, adaptada a nuestro libro y con todas las funcionalidades disponibles.

Para quienes gusten de la lectura más cruda, todos los temas "teóricos" del libro pueden leerse descargándolo en un dispositivo digital, así como el 99% del contenido interactivo.

Confío en que el enfoque de este libro sea una fuente de inspiración y aprendizaje, y que disfrute el usuario de cada paso del camino en su exploración del álgebra lineal. ¡Que esta obra los acompañe y los motive a seguir creciendo en su conocimiento!

En primer lugar, una transformación lineal es una función. Por ser función, tiene su dominio y su codominio, con la particularidad de que éstos son espacios vectoriales. Tenemos dos espacios vectoriales \(V\) y \(W\), y una función que va de \(V\) a \(W\). O sea una regla de asignación que transforma vectores de \(V\) en vectores de \(W\). Pero no toda función que transforme vectores de \(V\) en vectores de \(W\) es una transformación lineal. Debe cumplir ciertas condiciones:

\(F:V \to W\) es una transformación lineal si y sólo si:

La imagen del vector nulo del dominio \({0_V}\) es el vector nulo del codominio \({0_{W\;}}\):

\[T\left( {{0_V}} \right) = {0_W}\]

\[T\left( {{0_V}} \right) = T\left( {0\,v} \right) = 0\,T\left( v \right) = 0\,w = {0_W}\]

Donde hemos expresado a \({0_V}\) como el producto del escalar \(0\) por cualquier vector del espacio vectorial \(V\), hemos usado la segunda condición que debe cumplir una transformación lineal, y finalmente hemos vuelto a usar la propiedad de espacios vectoriales sobre el producto del escalar 0 por cualquier vector.

La imagen del vector \( -\, v\) es igual al opuesto de la imagen de \(v\):

\[T\left( { - \, v} \right) = - \; T\left( v \right)\]

\[T\left( { - v} \right) = T\left( { - 1\,v} \right) = - 1\,T\left( v \right) = - \, T\left( v \right)\]

La justificación de los pasos dados en la demostración es similar a la anterior.

Consideremos \(r\) vectores del espacio vectorial \(V\):

\[{v_1},{v_2}, \ldots ,{v_r} \in V\]

Tomemos una combinación lineal en el dominio:

\[{\alpha _1}{v_1} \, + \,{\alpha _2}{v_2} + \,{\alpha _3}{v_3} \,+ ..{\rm{\;}}.{\rm{\;}} + {\alpha _r}{v_r}\]

Donde \({\alpha _i} \in \mathbb{R}\).

Si aplicamos la transformación lineal \(F\) de \(V\) a \(W\), teniendo en cuenta las propiedades enunciadas en la definición, resulta:

\[ \small{F\left( {{\alpha _1}{v_1} + {\alpha _2}{v_2}\,\; + ...{\rm{\;}}.{\rm{\;}} + \; {\alpha _r}{v_r}} \right) = {\alpha _1}F\left( {{v_1}} \right) + {\alpha _2}F\left( {{v_2}} \right) + \ldots + {\alpha _r}F\left( {{v_r}} \right){\rm{\;}}}\]

Es decir que una transformación lineal «transporta» combinaciones lineales de \(V\) a \(W\), conservando los escalares de la combinación lineal.

Ejemplo 1

Analizar si la siguiente función es una transformación lineal:

\[T:\mathbb{R}^3\to \mathbb{R}^2/ \: T\left ( \underbrace{x,y,z}_{\in \; \mathbb{R}^3} \right )=\left ( \underbrace{x+z,y-2z}_{\in \;\mathbb{R}^2} \right )\]Resolución

Controlemos primero que el transformado del \({0_V}\) sea el \({0_W}\). Ésta es una condición necesaria: si no se cumpliera, no sería transformación lineal. Como \(T\left( {\left( {0,0,0} \right)} \right) = \left( {0,0} \right)\), la función dada es «candidata» a ser transformación lineal. Para demostrar que es una transformación lineal tenemos que comprobar las condiciones dadas en la definición.Veamos si \( \:\, T\left( {u + v} \right) = T\left( u \right) + T\left( v \right)\)

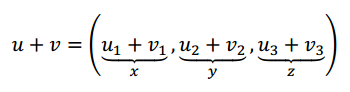

Primero hacemos la suma de \(u\) y \(v\):

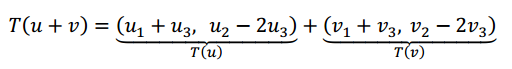

Y ahora aplicamos \(T\):

\[T\left( {u + v} \right) = \left( {{u_1} + {v_1} + {u_3} + {v_3}{\rm{\;}},{\rm{\;}}{u_2} + {v_2} - 2{u_3} - 2{v_3}} \right)\]

\[T\left( {u + v} \right) = T\left( u \right) + T\left( v \right)\]

En conclusión: se cumple la primera de las condiciones.

Nos faltaría la otra propiedad.

Condición 2: \(\;\;T\left( {k\,v} \right) = k\,T\left( v \right){\rm{\;\;\;}}\forall v \in V,{\rm{\;}}\forall k \in \mathbb{R}\)

\[T\left( {k\,v} \right) = T\left( {\left( {k{v_1},k{v_2},k{v_3}} \right)} \right) = \left( {k{v_1} + k{v_3},{\rm{\;}}k{v_2} - 2k{v_3}} \right)\]

\[ = k \, \left( {{v_1} + {v_3},{v_2} - 2{v_3}} \right) = k \, T\left( v \right)\]

Como \(T\) cumple las dos condiciones, es una transformación lineal.

Ejemplo 2

Analizar si la siguiente función es una transformación lineal:

\[F:{P_2} \to \mathbb{R}\;\;\;|\;\;F\left( p \right) = p\left( 0 \right)\]

Observación: con \({P_2}\) se designa al conjunto de todos los polinomios de grado menor o igual que dos, con el polinomio nulo.

Entonces a un polinomio \(p\) de grado menor o igual que dos, le aplicamos la función \(F\) y obtenemos un número real que proviene de evaluar el polinomio en \(x = 0\).

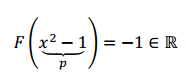

$$ p\in {P_2}\to p\left( 0 \right)\in \mathbb{R}$$ Por ejemplo evaluemos la transformación en \({x^2} - 1\):

Veamos si el vector nulo del espacio vectorial \({P_2}\) va al \(0 \in \mathbb{R}\) (es condición necesaria).

El polinomio cero es:

\[{0_{{P_2}}} = {\rm{\;}}0{x^2} + 0x + 0\]

¿Cuánto vale el polinomio nulo evaluado en \(0\,\)? \(\,0\)

\[{0_{{P_2}}}\left( 0 \right) = {0 \; 0^2} + 0 \; 0 + 0 = 0\]

Entonces la condición necesaria para este ejercicio se cumple, porque \(F\left( {{0_{{P_2}}}} \right) = 0\)

Primera condición \(\;F\left( {u + v} \right) = F\left( u \right) + F\left( v \right){\rm{\;\;}}\forall u,v \in V\)

Para que sea transformación lineal se debe cumplir la primera condición. Veamos qué pasa con el transformado de la suma:

\[\left( {p + q} \right) \in {P_2}\]

\[F\left( {p + q} \right) = \left( {p + q} \right)\left( 0 \right) = p\left( 0 \right) + q\left( 0 \right)\]

Observación: evaluar una suma de funciones en \(0\), es evaluar cada una en \(0\) y sumarlas. Esto no es una particularidad de los polinomios, sino que se corresponde con la definición de suma de funciones:

Para cualquier función: \(\left( {f\; + \;g} \right)\;\left( x \right)\; = \;f\left( x \right)\; + \;g\left( x \right)\), para todo \(x\) perteneciente al dominio de \(f\) y de \(g\).

Otra forma de pensar la misma propiedad. Si consideramos

\(p\left( x \right) = a{x^2} + bx + c\) y \(q\left( x \right) = d{x^2} + ex + f\)

\[p{\rm{\;}} + {\rm{\;}}q{\rm{\;}} = {\rm{\;}}\left( {a + d} \right){x^2}{\rm{\;}} + {\rm{\;}}\left( {b + e} \right){\rm{\;}}x{\rm{\;}} + {\rm{\;}}\left( {c + f} \right)\]

\[F\left( {p + q} \right){\rm{\;}} = {\rm{\;}}c{\rm{\;}} + {\rm{\;}}f{\rm{\;}} = {\rm{\;}}F\left( p \right){\rm{\;}} + {\rm{\;}}F\left( q \right)\]

Por los dos caminos arribamos a la misma conclusión.

Segunda condición \(F\left( {k \, v} \right) = k \, F\left( v \right){\rm{\;\;\;}}\forall v \in V,{\rm{\;}}\forall k \in \mathbb{R}\)

Veamos si se cumple la segunda condición. Para esto podemos recordar que dada una función \(f\left( x \right)\) y un escalar \(k\), la función \(\left( {kf} \right)\left( x \right)\) se define como \(k \, f\left( x \right)\). De esta forma podemos decir:

Otra forma de verlo es escribir a un polinomio \(p \in {P_2}\) de forma genérica y aplicar la transformación sobre \(k\,p\,\):

\[p\left( x \right) = a{x^2} + bx + c\]

\[F\left( {k\,p} \right) = F\left( {k\left( {a{x^2} + bx + c} \right)} \right) = F\left( {ka{x^2} + kbx + kc} \right) \] $$ F\left( {k\,p} \right) = F\left( {k\,a\,{0^2} + k\,b\,0 + k\,c} \right)= kc = k\;F\left( p \right)$$Ejemplo 3

Consideremos la transformación lineal: \[T:{R^3} \to {R^3}{\rm{\;\;}},{\rm{\;\;\;}}T\left( v \right) = v \times {w_0}{\rm{\;}}\] Siendo \({w_0}\) un vector fijo y \(\;v\) un vector cualquiera de \({R^3}\). Veamos que se trata de una transformación lineal.Condición 1: \(\quad T\left( {u + v} \right) = T\left( u \right) + T\left( v \right){\rm{\;\;}}\forall u,v \in V\)

Para ver que se cumple esta condición usaremos la propiedad distributiva del producto vectorial respecto de la suma de vectores:

\[{v_1},{v_2} \in {R^3},{\rm{\;\;\;\;}}T\left( {{v_1} + {v_2}} \right) = \left( {{v_1} + {v_2}} \right) \times {w_0} =\] \[={v_1} \times {w_0} + {v_2} \times {w_0} = T\left( {{v_1}} \right) + T\left( {{v_2}} \right)\]

Condición 2: \(\quad T\left( {k\,v} \right) = k \, T\left( v \right){\rm{\;\;\;}}\forall v \in V,{\rm{\;}}\forall k \in \mathbb{R}\)

Para ver que se cumple esta condición podemos extraer el escalar:

\[T\left( {k\,v} \right) = \left( {kv} \right) \times {w_0} = k\,\left( {v \times {w_0}} \right) = k\,T\left( v \right)\]

Ejemplo 4

Consideremos las siguientes transformaciones:

\[{T_1}:{\mathbb{R}^2} \to {\mathbb{R}^2}{\rm{}},{\rm{\;\;\;}}{T_1}\left( {\left( {x,y} \right)} \right) = \left( {2x - 1,y} \right)\]

\[{T_2}:{\mathbb{R}^2} \to {\mathbb{R}^2}{\rm{}},{\rm{\;\;\;\;}}{T_2}\left( {\left( {a,b} \right)} \right) = \left( {{a^2},b} \right)\]

¿Cómo analizamos si son o no son transformaciones lineales?

Para la primera transformación basta con ver que la imagen de \(\left( {0,0} \right)\) es \(\left( { – 1,0} \right)\). No se cumple una de las propiedades de las transformaciones lineales, entonces no es una transformación lineal. La segunda transformación no cumple con la segunda condición ya que:

Luego, como no se cumple que \(T\left( {k\,v} \right) = k\,T\left( v \right)\) podemos afirmar que \({T_2}\,\) no es una transformación lineal.

Sea \(F:V \to W\;\) una transformación lineal. Llamamos núcleo de \(F\) al conjunto de vectores del dominio cuya imagen por \(F\) es el \(0_{W}\)

Llamamos imagen de \(F\) al conjunto de vectores de \(W\) que son imagen de algún vector de \(V\).

El teorema de las dimensiones establece una relación aritmética sencilla entre la dimensión de \(V\) y la dimensión del núcleo y de la imagen.

Sea \(F:V \to W \,\)una transformación lineal\(.\)

Si \(dim\left( V \right) = n\) (finita) entonces:

Sea \(F:V \to W \;\) una transformación lineal, y \(B = \left\{ {{v_1}, \ldots ,{v_n}} \right\}\) una base de\(\;V.\;\) Entonces: \[w \in Im\left( F \right) \Leftrightarrow {\rm{\;}}w = F\left( v \right),{\rm{\;}}v \in V \Leftrightarrow {\rm{\;}}w = F\left( {{a_1}{v_1} + \ldots + {\alpha _n}{v_n}{\rm{\;}}} \right)\] \[ \Leftrightarrow {\rm{\;}}w = {\alpha _1}F\left( {{v_1}} \right) + \ldots + {\alpha _n}F\left( {{v_n}} \right){\rm{\;}}\]

Hemos demostrado que:

O sea, aplicando la transformación lineal a los vectores de una base (cualquiera) del dominio, se obtiene un conjunto de generadores de la imagen: \[\left\{ {F\left( {{v_1}} \right),F\left( {{v_2}} \right),F\left( {{v_3}} \right), \ldots ,F\left( {{v_n}} \right)} \right\}{\rm{\;}}generan{\rm{\;}}Im\left( F \right)\] No estamos diciendo que constituyan una base de la imagen, sino que la generan. Veremos dos ejemplos sobre cómo se aplica esto:

En el último ejemplo resuelto de la página anterior nos preguntábamos si se podría haber pensado geométricamente. ¿Cuál es el conjunto de vectores que se obtiene al hacer el producto vectorial de cualquier vector \(v \in {\mathbb{R}^3}\) con \(\left( {0,0,1} \right)\)? ¿Cómo generalizaríamos para un \({w_0}\) cualquiera, no nulo?

En el siguiente applet de GeoGebra se puede explorar la situación. Hay tres vectores:

Te proponemos que muevas el vector verde y veas que se va obteniendo cómo el conjunto de vectores que se obtienen de los sucesivos productos vectoriales:

Recordemos que una función \(F:A \to B\;\) es inyectiva si verifica la siguiente propiedad: \[F\left( {{x_1}} \right) = {\rm{\;}}F\left( {{x_2}} \right) \Rightarrow {x_1} = {x_2}{\rm{\;\;\;}}\forall {x_1},{x_2} \in A\] En el caso particular de las T.L., puede demostrarse que:

Sea \(F:\;V \to \;W\) una transformación lineal,

Consideremos la siguiente transformación lineal \[T:{\mathbb{R}^2} \to {\mathbb{R}^3}/\;\;T\left( {\left( {x,y} \right)} \right) = \left( {x + y,\;x - y,\;2x} \right)\] Saquemos el núcleo de la transformación: \[\left( {x,y} \right) \in Nu\left( T \right) \Leftrightarrow T\left( {\left( {x,y} \right)} \right) = \left( {0,0,0} \right)\] \[\left( {x + y,\;x - y,\;2x} \right) = \left( {0,0,0} \right){\rm{\;\;}} \Rightarrow {\rm{\;\;}}x = 0 \wedge y = 0\] Entonces por la propiedad enunciada anteriormente podemos decir que \(T\) es un monomorfismo. Por el teorema de las dimensiones resulta: \[\dim \left( {Im} \right) = \dim \left( {{\mathbb{R}^2}} \right) - \dim \left( {Nu} \right) = 2 - 0 = 2\] Como la dimensión de la imagen es 2, entonces no es un epimorfismo (sobreyectiva). Conclusión: \(T\) es un monomorfismo.

Consideremos la transformación lineal \[F:{\mathbb{R}^{2 \times 2}} \to {\mathbb{R}^2}{\rm{\;}}/{\rm{\;\;}}F\left( {\left( {\begin{array}{*{20}{c}}a&b\\c&d\end{array}} \right)} \right) = \left( {a + b, - d} \right)\] Busquemos su imagen:

Consideremos la siguiente transformación lineal \[G:{\mathbb{R}^2} \to {P_1}\;/{\rm{\;\;}}G\left( {\left( {a,b} \right)} \right) = 2a - bx\] Busquemos su núcleo: \[2a - bx = 0 + 0.x{\rm{\;}} \Rightarrow a = 0{\rm{\;}} \wedge {\rm{\;}}b = 0 \Rightarrow Nu\left( G \right) = \left\{ {\left( {0,0} \right)} \right\} \Rightarrow\] \[ \Rightarrow \dim \left( {Nu\left( F \right)} \right) = 0\] Por la propiedad enunciada anteriormente, podemos afirmar que \(G\) es un monomorfismo.

Veamos cuál es la imagen: \[2a.\left( 1 \right) + b.\left( { - x} \right){\rm{\;}} \Rightarrow Im\left( G \right) = gen\left\{ {1, - x} \right\} \Rightarrow \dim \left( {Im\left( G \right)} \right) = 2\] Por lo tanto la imagen es \({P_1}\) y la transformación es un epimorfismo (sobreyectiva).

Como es monomorfismo y epimorfismo, entonces es un isomorfismo.

¿Habrá alguna TL que no sea ni monomorfismo, ni epimorfismo? ¿Que no sea ni inyectiva ni sobreyectiva? Consideremos la siguiente TL que analizamos en el ejemplo 2 de "Imagen de una TL": \[F:{\mathbb{R}^3} \to {\mathbb{R}^{2 \times 2}}\;/{\rm{\;\;}}F\left( {\left( {x,y,z} \right)} \right) = \left( {\begin{array}{*{20}{c}}{x + y}&{x - z}\\0&{y + z}\end{array}} \right)\] Vimos que \({B_{Nu}} = \left\{ {\left( {1, - 1,1} \right)} \right\}\), así que no es un monomorfismo.

Vimos que \({B_{Im}} = \left\{ {\left( {\begin{array}{*{20}{c}}1&1\\0&0\end{array}} \right),\left( {\begin{array}{*{20}{c}}1&0\\0&1\end{array}} \right)} \right\}\), así que no es un epimorfismo.

Conclusión: existen TL que no son ni monomorfismos ni epimorfismos.

Sea \(F:\;V \to W\) una TL., \(\;dim\left( V \right) = \;dim\left( W \right) = \;n\)

Puede afirmarse que:

Sugerimos al lector demostrar esta propiedad, teniendo en cuenta que:

\(F\) es inyectiva \( \Leftrightarrow \) \(Nu\left( F \right) = \left\{ {{0_V}} \right\}{\rm{\;}}\) \( \Leftrightarrow {\rm{\;\;}}dim\left( {Nu} \right){\rm{\;}} = {\rm{\;}}0\)

Dada la TL \[T:{\mathbb{R}^3} \to {\mathbb{R}^3}/\;\; T\left( {x,y,z} \right) = \left( {x + y + z\;,\;\;2y + z,\;\;3y + kz} \right)\] encontrar todos los valores de \(k\) para los cuales \(T\) es biyectiva (isomorfismo).

Como la TL va de \({\mathbb{R}^3}\) a \({\mathbb{R}^3},\,\) es suficiente analizar para qué valores de \(k\,\) es inyectiva (o sobreyectiva).

Por inyectividad:

Si pensamos en la inyectividad, tenemos que buscar que el núcleo sea \(\left\{ {\left( {0,0,0} \right)} \right\}\). Es decir que el sistema \[\left\{ {\begin{array}{*{20}{c}}{x + y + z = 0}\\{2y + z = 0}\\{3y + kz = 0}\end{array}} \right.\] tiene que ser compatible determinado. Hemos visto que un sistema de ecuaciones \(A.X = b\) es compatible determinado \( \Leftrightarrow \) \(\det \left( A \right) \ne 0\), así que planteamos esta condición para hallar los valores de \(k\): \[\left| {\begin{array}{*{20}{c}}1&1&1\\0&2&1\\0&3&k\end{array}} \right| = 1.\left( {2k - 3} \right) \ne 0 \Rightarrow k \ne \frac{3}{2}\] Luego \(\;\forall k \in \mathbb{R},\;\;k \ne \dfrac{3}{2}\;\;\) la transformación lineal \(T\) es biyectiva.

Por sobreyectividad

Si pensamos en la sobreyectividad, tenemos que buscar que la dimensión de la imagen sea 3 (o sea que la imagen sea \({\mathbb{R}^3}\)). Recordemos que los transformados de una base del dominio generan la imagen: \[T\left( {1,0,0} \right){\rm{\;}} = \left( {1,0,0} \right)\] \[T\left( {0,1,0} \right){\rm{\;}} = \left( {1,2,3} \right)\] \[T\left( {0,0,1} \right){\rm{\;}} = \left( {1,1,k} \right)\]

Como queremos que sea sobreyectiva, los tres vectores que se obtuvieron deben generar todo \({\mathbb{R}^3}\), así que deben ser LI. Recordemos que: \[det\left( A \right) \ne 0 \Leftrightarrow rango\left( A \right) = n \Leftrightarrow las\;filas\;\left( {columnas} \right)de\;A\;son\;LI\] Apliquemos esta propiedad: \[\left| {\begin{array}{*{20}{c}}1&0&0\\1&2&3\\1&1&k\end{array}} \right| = 2k -3 \ne 0 \Rightarrow k \ne \frac{3}{2}\] Así que hemos llegado a la misma conclusión: si \(k \ne \frac{3}{2}\) la transformación lineal \(T\) es biyectiva.

Resumiendo: no es necesario analizar inyectividad y sobreyectividad separadamente, ya que una de ellas implica la otra y por lo tanto, que se cumpla una de ellas implica que la transformación lineal es biyectiva. Esto sólo ocurre cuando el dominio y el codominio tienen la misma dimensión.

Si las dimensiones del dominio y del codominio son distintas, ¿la TL puede ser biyectiva? Para responder, les sugerimos que consideren dos casos:

i) \(dim\left( V \right) > dim\left( W \right)\)

ii) \(dim\left( V \right) < dim\left( W \right)\)

Dada la transformación lineal \[T:{\mathbb{R}^3} \to {\mathbb{R}^3}/ \;T\left( {x,y,z} \right) = \left( {x + y + z,\;x + ky - z,\;3y - kz} \right)\] Hallar en cada caso los valores de \(k\) para los cuales:

a) \(T\) es biyectiva.

b) \(T\) no es biyectiva y \(\left( {0,1, - 1} \right)\) pertenece a la imagen de \(T\).

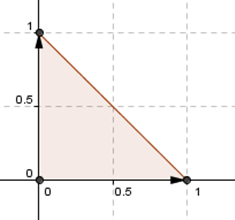

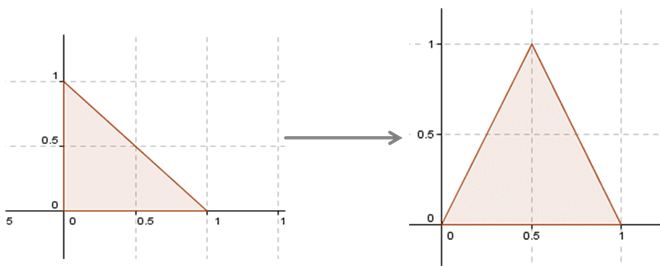

Consideremos el siguiente triángulo en \({\mathbb{R}^2}\):

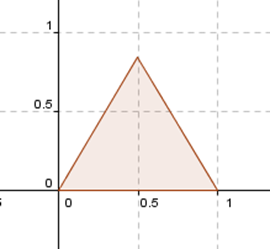

¿Existirá alguna transformación lineal que permita modificar de cierta manera este triángulo? Por ejemplo, una \(F\) que transforme el triángulo dado en este otro:

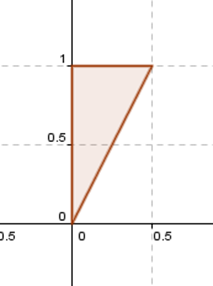

O alguna que lo transforme así:

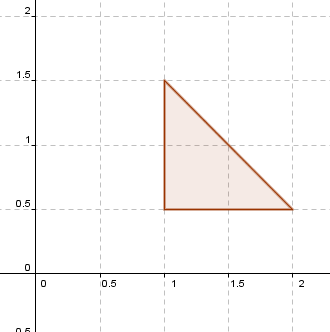

O un movimiento como éste:

El triángulo 4 no contiene al (0,0), por lo tanto no puede obtenerse aplicando una transformación lineal al triángulo 1.

¿Por qué?

¿Los otros podrán obtenerse mediante una transformación lineal? ¿Existe alguna herramienta teórica que permita asegurarlo?

Sí, es el teorema fundamental de las transformaciones lineales.

Este teorema, conocido también como "Teorema de existencia y unicidad de una transformación lineal", dice lo siguiente:

Para demostrarlo habría que demostrar que esa transformación existe, que es única, y que es lineal. Una demostración se puede encontrar en el texto recomendado de Ana María Kozak y otros autores, Nociones de Geometría Analítica y Algebra Lineal. Se puede hallar en página 561 y siguientes.

Sean \(V = {\mathbb{R}^2}\;\) y \(W = {\mathbb{R}^3}\).

Consideremos la base \(B = \left\{ {\left( {1,0} \right),\left( {1,1} \right)} \right\}\), y sean

\({w_1} = {w_2} = \left( {0,1,0} \right).\) De acuerdo con el teorema, existe una única transformación lineal \(T:{\mathbb{R}^2} \to {\mathbb{R}^3}\;\) que verifica: \[T\left( {\left( {1,0} \right)} \right) = \left( {0,1,0} \right)\] \[T\left( {\left( {1,1} \right)} \right) = \left( {0,1,0} \right)\] ¿Cómo buscamos la fórmula de la transformación lineal? Tomamos un vector genérico de \({\mathbb{R}^2}\) y lo escribimos como combinación lineal de la base, o sea buscamos sus coordenadas respecto de B: \[\left( {x,y} \right) = \alpha \left( {1,0} \right) + \beta \left( {1,1} \right) \Rightarrow \left\{ {\begin{array}{*{20}{c}}{x = \alpha + \beta }\\{y = \beta }\end{array}} \right. \Rightarrow {\rm{\;}}\left\{ {\begin{array}{*{20}{c}}{\alpha = x - y}\\{\beta = y}\end{array}} \right.\] Los escalares \(\alpha ,\beta \) son las cordenadas del vector \(\left( {x,y} \right)\) en la base \(B\):\[{\left[ {\left( {x,y} \right)} \right]_B} = \left( {\begin{array}{*{20}{c}}{x - y}\\y\end{array}} \right)\] Donde recordemos que la escritura \({\left[ {\left( {x,y} \right)} \right]_B}\) significa "las coordenadas del vector \(\left( {x,y} \right)\) en la base \(B\;\)".

\[\left( {x,y} \right) = \alpha \left( {1,0} \right) + \beta \left( {1,1} \right)\]

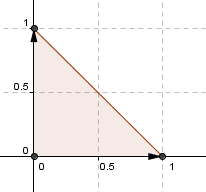

Vamos a ver si podemos transformar el triángulo del esquema de la izquierda, en el triángulo del esquema que está a la derecha:

Nosotros tenemos que dar una base de \({\mathbb{R}^2}\) y asignarle sus transformados.

Por ejemplo consideremos los versores canónicos que definen al primer triángulo:

Entonces podríamos hacer la siguiente asignación:

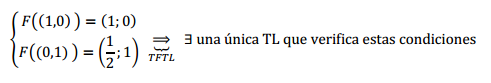

\[F\left( {\left( {1,0} \right){\rm{\;}}} \right) = \left( {1;0} \right)\] \[F\left( {\left( {0,1} \right){\rm{\;}}} \right) = \left( {\frac{1}{2};1} \right)\]

Como \(\left( {1,0} \right),\;\left( {0,1} \right)\) constituyen una base del dominio, el teorema fundamental permite afirmar que existe una única transformación lineal que verifica esto:

Para encontrar la fórmula de esta trasformación vamos a escribir a un vector genérico de \({\mathbb{R}^2}\) como combinación lineal de los vectores de la base dada: \[\left( {x,y} \right) = \alpha \left( {1,0} \right) + \beta \left( {0,1} \right) \; \Rightarrow {\rm{\;}}\left\{ {\begin{array}{*{20}{c}}{x = \alpha }\\{y = \beta }\end{array}} \right.\;\; \Rightarrow \;\left\{ {\begin{array}{*{20}{c}}{\alpha = x}\\{\beta = y}\end{array}} \right.\]

Ahora aplicamos la transformación lineal sobre ese vector genérico, y resolvemos para llegar a una expresión analítica de la transformación lineal: \[F\left( {\left( {x,y} \right)} \right) = F\left( {\alpha \left( {1,0} \right) + \beta \left( {0,1} \right)} \right)\] \[F\left( {\left( {x,y} \right)} \right) = \alpha \,F\left( {\left( {1,0} \right)} \right) + \beta \,F\left( {\left( {0,1} \right)} \right)\] \[F\left( {\left( {x,y} \right)} \right) = x\left( {1,0} \right) + y\left( {\frac{1}{2};\;1} \right)\] \[F\left( {\left( {x,y} \right)} \right) = \left( {x,0} \right) + \left( {\frac{1}{2}y;\;y} \right)\] \[F\left( {\left( {x,y} \right)} \right) = \left( {\frac{1}{2}y + x;\;y} \right)\]

Para encontrar la fórmula de esta trasformación vamos a escribir a un vector genérico de \({\mathbb{R}^2}\) como combinación lineal de los vectores de la base dada: \[\left( {x,y} \right) = \alpha \left( {1,0} \right) + \beta \left( {0,1} \right) \; \Rightarrow {\rm{\;}}\left\{ {\begin{array}{*{20}{c}}{x = \alpha }\\{y = \beta }\end{array}} \right.\;\; \Rightarrow \;\left\{ {\begin{array}{*{20}{c}}{\alpha = x}\\{\beta = y}\end{array}} \right.\]

Ahora aplicamos la transformación lineal sobre ese vector genérico, y resolvemos para llegar a una expresión analítica de la transformación lineal: \[F\left( {\left( {x,y} \right)} \right) = F\left( {\alpha \left( {1,0} \right) + \beta \left( {0,1} \right)} \right)\] \[F\left( {\left( {x,y} \right)} \right) = \alpha \,F\left( {\left( {1,0} \right)} \right) + \beta \,F\left( {\left( {0,1} \right)} \right)\] \[F\left( {\left( {x,y} \right)} \right) = x\left( {1,0} \right) + y\left( {\frac{1}{2};\;1} \right)\] \[F\left( {\left( {x,y} \right)} \right) = \left( {x,0} \right) + \left( {\frac{1}{2}y;\;y} \right)\] \[F\left( {\left( {x,y} \right)} \right) = \left( {\frac{1}{2}y + x;\;y} \right)\]

Hallar la expresión analítica de cada una de las siguientes transformaciones de \( \mathbb{R}^2 \to \mathbb{R}^2 \):

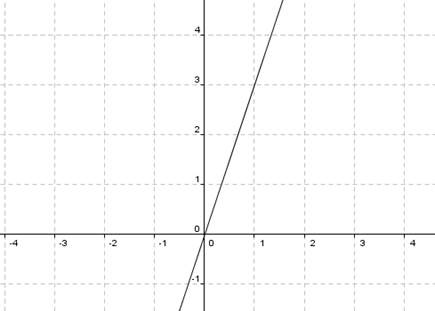

a) Simetría respecto de la recta \(y = 3x\)

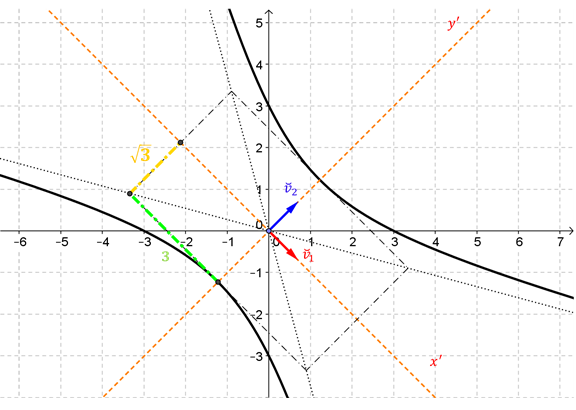

La clave para resolver este ejercicio es elegir una base conveniente para definir la simetría. Grafiquemos la recta \(y = 3x\):

Primero hay que entender qué significa una reflexión respecto de una recta. Supongamos que nos piden una simetría respecto del eje \(x\).

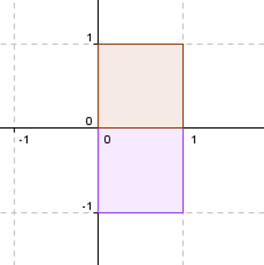

Si tenemos un cuadrado así como el rojo, se transforma en un cuadrado como el violeta:

Todos los puntos que pertenecen al eje \(x\) quedan idénticos. Y los puntos que están sobre el eje \(y\) se transforman en su opuesto. Entonces: \[\left\{ {\begin{array}{*{20}{c}}{F\left( {\left( {1,0} \right)} \right) = \left( {1,0} \right)}\\{F\left( {\left( {0,1} \right)} \right) = \left( {0, - 1} \right)}\end{array}} \right.\] Considerando estas ideas sobre simetría, en nuestro caso tomamos un vector que esté sobre el eje de simetría y otro perpendicular a él:

\[v = \left( {1,3} \right){\rm{\;}},{\rm{\;}}w = \left( { - 3,1} \right)\] ¿Cuál es el transformado del vector \(\left( {1,3} \right)\) que está sobre el eje de simetría? ¿Cuál es el transformado del vector \(\left( { - 3,1} \right)\) que es perpendicular al eje de simetría? Entonces: \[\left\{ {\begin{array}{*{20}{c}}{F\left( {\left( {1,3} \right)} \right) = \left( {1,3} \right)\;\;porque\;está \;sobre\;el\;eje\;de\;simetría}\\{F\left( {\left( { - 3,1} \right)} \right) = \left( {3, - 1} \right)\;\;porque\;es\;perpendicular\;al\;eje\;de\;simetría}\end{array}} \right.\]

Ahora queda el problema técnico de buscar la fórmula de esta transformación lineal: \[(x,y) = \alpha (1,3) + \beta (- 3,1) \Rightarrow \left\{\begin{matrix} x = \alpha - 3\beta\\y = 3\alpha + \beta \end{matrix}\right.\] \[\Rightarrow \beta = \frac{{y - 3x}}{{10}} \wedge \; \alpha = \frac{{x + 3y}}{{10}} \]

Podemos ver en GeoGebra cómo opera la transformación:

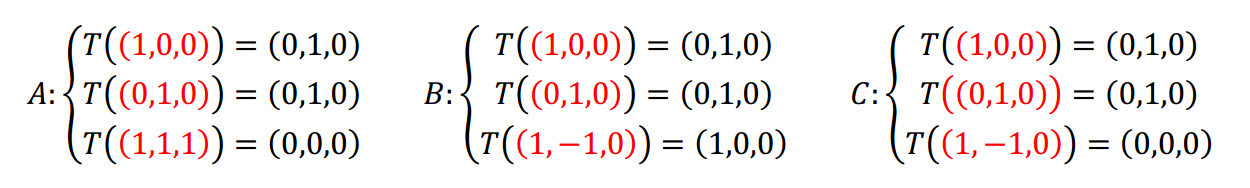

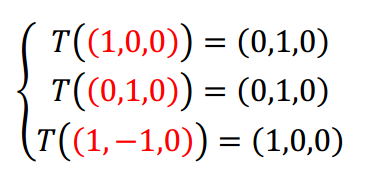

El propósito de este ejercicio es destacar cuándo es posible aplicar el teorema fundamental de las transformaciones lineales. Sugerimos una lectura cuidadosa de cada uno de los casos presentados a continuación:

Analizar si existe y es única la transformación lineal \(T:{\mathbb{R}^3} \to {\mathbb{R}^3}\) que verifica:

Caso A \[\left\{ {\begin{array}{*{20}{c}}{T\left( {\left( {1,0,0} \right)} \right) = \left( {0,1,0} \right)}\\{T\left( {\left( {0,1,0} \right)} \right) = \left( {0,1,0} \right)}\\{T\left( {\left( {1,1,1} \right)} \right) = \left( {0,0,0} \right)}\end{array}} \right.\]

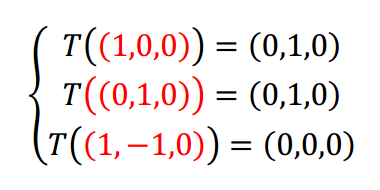

Caso B \[\left\{ {\begin{array}{*{20}{c}}{T\left( {\left( {1,0,0} \right)} \right) = \left( {0,1,0} \right)}\\{T\left( {\left( {0,1,0} \right)} \right) = \left( {0,1,0} \right)}\\{T\left( {\left( {1, - 1,0} \right)} \right) = \left( {1,0,0} \right)}\end{array}} \right.\]

Caso C \[\left\{ {\begin{array}{*{20}{c}}{T\left( {\left( {1,0,0} \right)} \right) = \left( {0,1,0} \right)}\\{T\left( {\left( {0,1,0} \right)} \right) = \left( {0,1,0} \right)}\\{T\left( {\left( {1, - 1,0} \right)} \right) = \left( {0,0,0} \right)}\end{array}} \right.\]

¿Cuál es la hipótesis del teorema? O sea, ¿qué debe cumplirse para que el teorema tenga validez?

Los vectores del dominio deben ser una base, es decir que debemos prestar atención en cada caso a los vectores señalados:

Caso A

En el caso A los tres vectores son base de \({\mathbb{R}^3}\;\) y entonces podemos aplicar el Teorema Fundamental de las Transformaciones Lineales. Como lo establece el teorema, se puede afirmar que existe una única transformación lineal que verifica las condiciones dadas. ¿Cuál es el mecanismo para buscar la fórmula? Consideramos un vector \(\left( {x,y,z} \right)\) y buscamos sus coordenadas respecto de la base de partida: \[\left( {x.y,z} \right) = \alpha \left( {1,0,0} \right) + \beta \left( {0,1,0} \right) + \gamma \left( {1,1,1} \right)\] \[\left\{ {\begin{array}{*{20}{c}}{x = \alpha + \gamma }\\{y = \beta + \gamma }\\{z = \gamma }\end{array}} \right.{\rm{\;\;}} \Rightarrow {\rm{\;}}\left\{ {\begin{array}{*{20}{c}}{\alpha = x - z}\\{\beta = y - z}\\{\gamma = z}\end{array}} \right.\] Aplicamos la transformación lineal a ambos miembros: \[T\left( {\left( {x,y,z} \right)} \right) = \alpha\, T\left( {\left( {1,0,0} \right)} \right) + \beta\, T\left( {\left( {0,1,0} \right)} \right) + \gamma\, T\left( {\left( {1,1,1} \right)} \right)\]

Caso B

En el caso B, el conjunto de vectores de partida es linealmente dependiente, no es base de \({\mathbb{R}^3}\). Si no se cumplen las hipótesis de un teorema, éste no puede aplicarse. ¿Cómo podemos determinar si existe una transformación lineal que verifique estas condiciones?

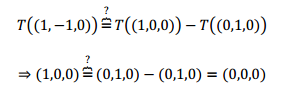

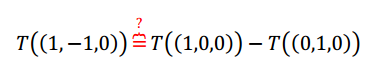

Lo que define a una transformación lineal es la conservación de las combinaciones lineales. ¡Esto es lo que debemos controlar! Veamos la diferencia entre el caso B y el C: Observamos que el tercer vector se puede obtener como combinación lineal de los primeros dos: \[\left( {1, - 1,0} \right) = \left( {1,0,0} \right) -\left( {0,1,0} \right)\] Entonces entre sus transformados debería cumplirse la misma relación:

No se conserva la combinación lineal, entonces no existe una transformación lineal que cumpla las condiciones dadas.

Caso C

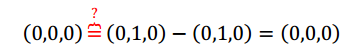

En el caso C tenemos la siguiente información:

Tampoco se puede aplicar el TFTL, porque el conjunto de vectores de partida es linealmente dependiente. Igualmente podemos preguntarnos: ¿Se conserva la combinación lineal? Notemos que el tercer vector es la diferencia del primero con el segundo: \[\left( {1, - 1,0} \right) = \left( {1,0,0} \right) - \left( {0,1,0} \right)\] Aplicamos la transformación lineal suponiendo que se conservan las combinaciones lineales:

Reemplazando:

Reemplazando:

Lo cual es verdadero. Entonces podemos concluir que existe la transformación lineal aunque no quede unívocamente determinada por la información disponible. Para definir una TL bastaría con establecer cuáll es el transformado de un tercer vector LI con \(\left( {1,0,0} \right)\) y \(\left( {0,1,0} \right)\). Agreguemos un dato nuevo para que quede bien definida: \[T\left( {\left( {0,0,1} \right)} \right) = \left( {0,0,1} \right)\] ¿Existe una TL que cumpla con las condiciones iniciales más ésta que acabamos de agregar? Llamemos: \[\left\{ {\begin{array}{*{20}{c}}{{T_1}\left( {\left( {1,0,0} \right)} \right) = \left( {0,1,0} \right)}\\{{T_1}\left( {\left( {0,1,0} \right)} \right) = \left( {0,1,0} \right)}\\{{T_1}\left( {\left( {0,0,1} \right)} \right) = \left( {0,0,1} \right)}\end{array}} \right.\] Ahora \({T_1}\) queda bien definida y podríamos hallar su fórmula. ¿Cómo podrían definir una transformación \({T_2}\) distinta de \({T_1}\) que también cumpla con las condiciones iniciales? Resumamos lo que obtuvimos analizando estos tres casos:

Halle la expresión analítica de cada una de las siguientes transformaciones de \({\mathbb{R}^3} \to {\mathbb{R}^3}\):

a) Reflexión respecto del plano \(x = y\)

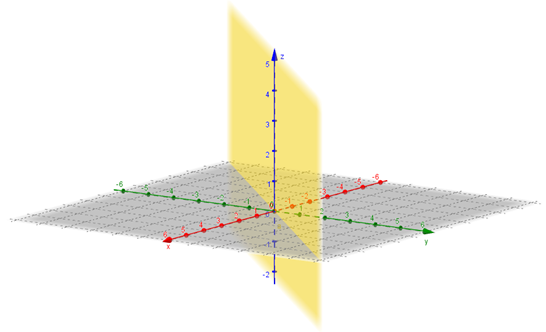

Este ejercicio requiere elegir una buena base. Una gráfica del plano \(x = y\;\) se puede ver a continuación:

El arte para resolver este ejercicio es elegir tres vectores linealmente independientes que sepamos en qué se transforman.

¿Cuál es el simétrico de un vector que esté sobre el plano? El mismo vector. Entonces podemos elegir dos vectores no paralelos incluidos en el plano: \[T\left( {{v_1}} \right) = {v_1}\] \[T\left( {{v_2}} \right) = {v_2}\] ¿Y si tomamos un vector perpendicular al plano, digamos \({v_3}\), en que se transforma? \[T\left( {{v_3}} \right) = - {v_3}\] Ahora debemos elegir \({v_1}\), \({v_2}\) y \({v_3}\) de acuerdo con el plano dado. Proponemos: \[{v_1} = \left( {1,1,0} \right)\] \[{v_2} = \left( {0,0,1} \right)\] \[{v_3} = \left( {1, - 1,0} \right)\] Donde los vectores \({v_1}\) y \({v_2}\) están en el plano y el vector \({v_3}\) es perpendicular al plano. De esta forma sabemos cómo se transforman: \[\left\{ {\begin{array}{*{20}{c}}{T\left( {\left( {1,1,0} \right)} \right) = \left( {1,1,0} \right)}\\{T\left( {\left( {0,0,1} \right)} \right) = \left( {0,0,1} \right)}\\{T\left( {\left( {1, - 1,0} \right)} \right) = \left( { - 1,1,0} \right)}\end{array}} \right.\] Ya queda definida la transformación lineal sobre una base del dominio. Dejamos a cargo del lector encontrar la fórmula de la TL.

Les proponemos que definan la TL sobre otra base con las mismas características: dos vectores del plano y uno perpendicular a él. Luego busquen la expresión analítica, ¿coincide con la anterior? Los vectores no son únicos: \({v_1}\) y \({v_2}\) son dos vectores cualesquiera (LI) del plano y \({v_3}\) es un vector perpendicular cualquiera. No importa cuáles elijamos, obtendremos la misma transformación lineal.

Definir una transformación lineal \(F\) de \({\mathbb{R}^3} \to {\mathbb{R}^{2 \times 2}}\) que verifique las dos condiciones que siguen:

i) \(Nu\left( F \right)\; = \;gen\;\left\{ {\left( {1,1,0} \right)} \right\}\)

ii) \(Im\left( F \right) \subseteq \;S = \left\{ {A \in {\mathbb{R}^{2×2}}\;/\;\;A = {A^t}\;} \right\}\)

Obtener la fórmula de la transformación definida.

Observación: este ejercicio no es de respuesta única.

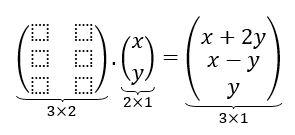

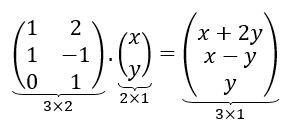

Sea \(T\;\) la siguiente transformación lineal: \[T:{\mathbb{R}^2} \to {\mathbb{R}^3}{\rm{\;}}|{\rm{\;\;}}T\left( {\left( {x,y} \right)} \right) = \left( {x + 2y,\;x - y,\;y} \right)\] ¿Existirá una matriz \(A\) que multiplicada por \(\left( {x,y} \right)\) dé por resultado \(\left( {x + 2y,\;x - y,\;y} \right)\)? Para esto vamos a escribir los vectores como columna: \[A.\left( {\begin{array}{*{20}{c}}x\\y\end{array}} \right) = \left( {\begin{array}{*{20}{c}}{x + 2y}\\{\begin{array}{*{20}{c}}{x - y}\\y\end{array}}\end{array}} \right)\]

¿Cuál debería ser el tamaño de la matriz?

Efectuando el producto de matrices, podemos obtener los coeficientes de \(A\) :

Efectuando el producto de matrices, podemos obtener los coeficientes de \(A\) :

Encontramos una matriz que realiza la transformación lineal. Se conoce como la matriz estándar de la transformación lineal.

Notemos que la transformación va de \({\mathbb{R}^2}\) a \({\mathbb{R}^3}\), y que el orden de la matriz es \(3 \times 2\).

Ahora consideremos la siguiente transformación lineal:

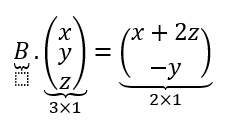

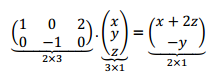

\[F:{\mathbb{R}^3} \to {\mathbb{R}^2}{\rm{\;}}|{\rm{\;}}F\left( {\left( {x,y,z} \right)} \right) = \left( {x + 2z, - y} \right)\]

Queremos buscar una matriz \(B\) tal que:

Pensando el orden de la matriz y el valor de sus elementos llegamos a:

Hemos hallado de manera intuitiva la matriz estándar de la transformación lineal. Notemos que la transformación va de \({\mathbb{R}^3}\) a \({\mathbb{R}^2}\) y que el orden de la matriz asociada a la transformación lineal es \(2 \times 3\).

Hemos visto ejemplos de cómo surge a partir del producto de matrices, la matriz estándar de una transformación lineal de \({\mathbb{R}^n}\) a \({\mathbb{R}^m}\). En lo que sigue intentaremos generalizar para cualquier espacio vectorial de dimensión finita, el concepto de matriz asociada a una transformación lineal. Aunque en el caso de TL en \({\mathbb{R}^n}\), veremos que no siempre la matriz estándar es la más conveniente para trabajar.

Sea \(T:V \to W\;\) transformación lineal, y

\[\operatorname{dim}(V) = n, \quad\;\;\; \operatorname{dim}(W) = m\] \[B = \left\{ {{v_1},{v_2}, \ldots ,{v_n}} \right\}{\rm{\;}}base{\rm{\;}}de{\rm{\;}}V\] \[B\,' = \left\{ {{w_1}, \ldots ,{w_m}} \right\}{\rm{\;}}base{\rm{\;}}de{\rm{\;}}W\]

Designamos:

\(M{\left( T \right)_{BB\,'}}\) a la matriz asociada a la transformación lineal \(T\) respecto de las bases \(B\) y \(B\,'\).

Esta matriz se construye por columnas transformando los vectores de la base \(B\) (del dominio), y expresando los transformados en sus coordenadas en la base \(B\,'\):

La matriz asociada tiene \(n\) columnas porque la base \(B\) tiene \(n\) vectores, y tiene \(m\) filas porque las coordenadas en \(B\,'\) se escriben con \(m\) componentes.

O sea que si \(dim\left( V \right){\rm{\;}} = {\rm{\;}}n\) y \(dim\left( W \right){\rm{\;}} = {\rm{\;}}m,\;\) \(M{\left( T \right)_{BB\,'}} \in {\mathbb{R}^{m \times n}}\)

La matriz asociada a una transformación lineal cumple la siguiente propiedad:

Retomemos la transformación lineal:

\[T:{\mathbb{R}^2} \to {\mathbb{R}^3}{\rm{\;}}|{\rm{\;\;}}T\left( {\left( {x,y} \right)} \right) = \left( {x + 2y,\;x - y,\;y} \right)\] Consideremos las siguientes bases para el dominio y codominio:

\[B = \left\{ {\left( {0,1} \right),\left( {1,1} \right)} \right\}{\rm{\;}}\] \[B\,' = \left\{ {\left( {1,0,0} \right),\left( {1,1,0} \right),\left( {0,1,1} \right)} \right\}\]

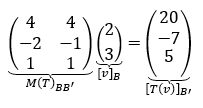

Construyamos la matriz asociada a la transformación \(T\) de la base \(B\) a la base \(B\,',\;\) es decir \(M{\left( T \right)_{BB\,'}}\;\):

Dado un vector cualquiera, aunque no conozcamos la fórmula, conociendo la matriz y las dos bases podemos calcular su transformado. Vamos a tomar un vector cualquiera de \({\mathbb{R}^2}\) y lo transformamos… sin mirar la fórmula. Hallemos \(T\left( {\left( {3,5} \right)} \right)\) mediante la matriz asociada \(M{\left( T \right)_{BB\;'}}\) : \[M{\left( T \right)_{BB\;'}}{\left[ v \right]_B} = {\left[ {T\left( v \right)} \right]_{B\;'}}\] No podemos operar con \(\left( {3,5} \right)\) porque la matriz asociada opera con coordenadas. Debemos buscar las coordenadas de \(\left( {3,5} \right)\) en la base \(B\). \[\left( {3,5} \right) = \alpha \left( {0,1} \right) + \beta \left( {1,1} \right) \Rightarrow \beta = 3{\rm{\;}},{\rm{\;}}\alpha = 2\]

El vector obtenido no es el transformado del vector (3,5) sino que son sus coordenadas en la base \(B\;'\).

Para hallar \(T\left( {3,5} \right)\) debemos multiplicar las coordenadas obtenidas por los vectores de la base \(B\;'\):

\[T\left( {\left( {3,5} \right)} \right) = 20\left( {1,0,0} \right) - 7\left( {1,1,0} \right) + 5\left( {0,1,1} \right)\] \[T\left( {\left( {3,5} \right)} \right) = \left( {13, - 2,{\rm{\;}}5} \right)\]Ahora en lugar de tomar estas bases, tomemos las bases canónicas de \({\mathbb{R}^2}\;\) y de \({\mathbb{R}^3}\).

Busquemos \(M{\left( T \right)_{{E_2}{E_3}}}\) donde:

\[{E_2} = \left\{ {\left( {1,0} \right),\left( {0,1} \right)} \right\}{\rm{\;}}\] \[{E_3} = \left\{ {\left( {1,0,0} \right),\left( {0,1,0} \right),\left( {0,0,1} \right)} \right\}{\rm{\;}}\]

El procedimiento es el mismo pero las cuentas son más fáciles

\[T\left( {\left( {1,0} \right)} \right) = \left( {1,1,0} \right) = \alpha \left( {1,0,0} \right) + \beta \,\left( {0,1,0} \right) + \gamma \, \left( {0,0,1} \right)\] \[ \Rightarrow {\rm{\;}}\left( {\begin{array}{*{20}{c}}{\begin{array}{*{20}{c}}1\\1\end{array}}\\0\end{array}} \right){\rm{\;}}1^\circ {\rm{\;}}columna\]Estos vectores hay que expresarlos en coordenadas respecto de la base canónica de \({\mathbb{R}^3}\), pero justamente por tratarse de la base canónica, el vector y sus coordenadas son iguales. Entonces resulta:

\[M(T)_{E_2E_3}=\begin{pmatrix} 1 & & 2 \\ 1 & & -1 \\ 0 & & 1 \end{pmatrix}=A\]¡Qué es la matriz estándar de la TL! Es decir que la matriz estándar es la que trabaja con las bases canónicas.

Consideremos la siguiente transformación lineal: \[F:{\mathbb{R}^2} \to {P_1}\;/\;\;M{\left( F \right)_{BB\;'}} = \left( {\begin{array}{*{20}{c}}1&2\\1&2\end{array}} \right)\] \[B = \left\{ {\left( {1,0} \right),\left( {1,1} \right)} \right\}\] \[B\;' = \left\{ {\color{blue}{1},{\rm{\;}}\color{blue}{1 - x}} \right\}\]

Ítem a

No tenemos la fórmula. Tenemos que trabajar con la matriz asociada. ¿Qué propiedad tiene la matriz asociada? \[M{\left( F \right)_{BB\,'}}\;{\left[ v \right]_B} = {\left[ {F\left( v \right)} \right]_{B\;'}}\]

Donde:

Las matrices asociadas no operan con los vectores, sino con las coordenadas de los vectores en alguna base. Entonces no podemos multiplicar la matriz por el vector \(\left( {2,1} \right)\).

Para operar, tenemos que encontrar las coordenadas de \(\left( {2,1} \right)\) en la base \(B\):

\[\left( {2,1} \right) = \alpha \left( {1,0} \right) + \beta \left( {1,1} \right){\rm{\;\;}} \Rightarrow {\rm{\;\;}}\alpha = 1 \wedge \beta = 1{\rm{\;\;}} \Rightarrow {\rm{\;\;}}{\left[ {\left( {2,1} \right)} \right]_B} = \left( {\begin{array}{*{20}{c}}1\\1\end{array}} \right)\]

Ahora multiplicamos por la matriz y obtenemos las coordenadas en \(B\,'\) del transformado de \(\left( {2,1} \right)\):

\[{\left[ {F\left( {\left( {2,1} \right)} \right)} \right]_{B\,'}} = \left( {\begin{array}{*{20}{c}}1&2\\1&2\end{array}} \right)\left( {\begin{array}{*{20}{c}}1\\1\end{array}} \right) = \left( {\begin{array}{*{20}{c}}\color{#F05}{3}\\\color{#F05}{3}\end{array}} \right)\]

¿Qué objeto esperamos obtener como imagen de esta transformación?

¿Un vector de \({\mathbb{R}^2}\)? No, esperamos obtener un polinomio de grado menor o igual que uno.

Para obtener \(F\left( {\left( {2,1} \right)} \right)\) debemos multiplicar estas coordenadas por los vectores de la base \(B\,'\):

\[F\left( {\left( {2,1} \right)} \right) = \textcolor{#F05}{3}.\textcolor{blue}{1} + \textcolor{#F05}{3}.\left( {\textcolor{blue}{1-x}} \right) = 6 - 3x\]

Ítem b

En el ítem (a) buscamos la imagen del vector \(\left( {2,1} \right)\). Ahora nos proponemos obtener la fórmula de la transformación, esto significa encontrar la imagen de cualquier vector \(\left( {x,\;y} \right)\) de \({\mathbb{R}^2}\). Teniendo en cuenta que en el polinomio usamos la variable \(x\), llamaremos \(\left( {a,b} \right)\) a los vectores de \({\mathbb{R}^2}\).

Busquemos \(F\left( {\left( {a,b} \right)} \right)\) tal como buscamos \(F\;\left( {\left( {2,1} \right)} \right)\): \[\left( {a,b} \right) = \alpha \left( {1,0} \right) + \beta \left( {1,1} \right) \Rightarrow {\rm{\;}}\left\{ {\begin{array}{*{20}{c}}{a = \alpha + \beta }\\{b = \beta }\end{array}} \right. \Rightarrow \left\{ {\begin{array}{*{20}{c}}{\alpha = a - b}\\{\beta = b}\end{array}} \right.\] \[{\left[ {\left( {a,b} \right)} \right]_B} = \left( {\begin{array}{*{20}{c}}{a - b}\\b\end{array}} \right)\]

\[\left[F((a,b))\right]_{B^{\prime}}=\begin{pmatrix} 1 & 2 \\ 1 & 2 \\ \end{pmatrix}\begin{pmatrix} a-b \\ b \end{pmatrix}=\begin{pmatrix}{\color{#F05} a+b} \\ {\color{#F05} a+b} \end{pmatrix}\]Éstas son las coordenadas del vector que estamos buscando. Falta multiplicar por los vectores de la base B\,':

\[F\left( {\left( {a,b} \right)} \right) = \left( {\textcolor{#F05}{a + b}} \right) \,\textcolor{blue}{1} + \left( {\textcolor{#F05}{a + b}} \right)\left( {\textcolor{blue}{1-x}} \right) = 2a + 2b - \left( {a + b} \right).x\]

Ésta es la fórmula de la transformación lineal.

Ahora podemos hallar base y dimensión de núcleo e imagen.

Ítem c

La definición de núcleo dice que son los vectores del dominio que se transforman en el vector nulo del codominio.

\[ - \left( {a + b} \right)x + 2\left( {a + b} \right) = {0_{{P_1}}} = 0x + 0\] \[ \Rightarrow {\rm{\;}}\left\{ {\begin{array}{*{20}{c}}{a + b = 0}\\{a + b = 0}\end{array} \;\;\Rightarrow \;\; a = - b} \right.\]

\[ \Rightarrow Nu(F) = \left\{ {({a, - a}) \in {\mathbb{R}^2}} \right\} \Rightarrow {B_{Nu}} = \left\{ {\begin{pmatrix} -1 \\ 1 \end{pmatrix}} \right\}\]

\[ \Rightarrow \dim ({Nu(F)}) = 1\]Ítem d

Por el teorema de las dimensiones:

\[\dim \left( {Im\left( F \right)} \right) = \dim \left( {{\mathbb{R}^2}} \right) - \dim \left( {Nu\left( F \right)} \right) = 1\]Queremos una base de la imagen. ¿En qué espacio vectorial está la imagen? En \(\,P_{\,1}\).

Recordemos que los transformados de una base (cualquiera) del dominio, generan la imagen de la transformación lineal: \[F\left( {\left( {1,0} \right)} \right) = 2 - x\] \[F\left( {\left( {0,1} \right)} \right) = 2 - x\]

Entonces ¿Cuál es una base de la imagen de la transformación lineal?

\[{B_{Im}} = \left\{ {2 - x} \right\}\]Veamos que la imagen no depende de la base del dominio que elijamos. Por ejemplo tomemos la base \(B\):

\[F\left( {\left( {1,0} \right)} \right) = 2 - x\] \[F\left( {\left( {1,1} \right)} \right) = 4 - 2x\]\(\left\{{2 - x\; , \; 4 - 2x} \right\}\) generan \(Im\left( F \right)\)

\[\Rightarrow\;\;{B_{Im}} = \left\{ {2 - x} \right\}\]Ítem e

No es necesario buscar la fórmula para obtener la imagen. Las columnas en la matriz nos dan las coordenadas en la base \(B\,'\) de los transformados de una base del dominio:

\[M{\left( F \right)_{BB\,'}} = \left( {{{\left[ {F\left( {{v_1}} \right)} \right]}_{B\,'}}{\rm{\;\;\;\;}}{{\left[ {F\left( {{v_2}} \right)} \right]}_{B\,'}}{\rm{\;}}} \right) = \left( {\begin{array}{*{20}{c}}1&2\\1&2\end{array}} \right)\]Entonces:

\[F\left( {\left( {1,0} \right)} \right) = 1\;\textcolor{blue}{1} + 1\;\left( {\textcolor{blue}{1 - x}} \right) = 2 - x\] \[F\left( {1,1} \right) = 2\;\textcolor{blue}{1} + 2\left( {\textcolor{blue}{1 - x}} \right) = 4 - 2x\]Luego:

\[Im\left( F \right) = gen\left\{ {2 - x{\rm{\;}},{\rm{\;}}4 - 2x} \right\}\]

Como \(4 - 2x\) es combinación lineal de \(2 - x\) podemos quedarnos con la siguiente base: \[{B_{Im\left( F \right)}} = \left\{ {2 - x} \right\}\]

Ítem f

¿Y para el núcleo sin la fórmula? Queremos hallar los \(v \in {\mathbb{R}^2}\) tales que al aplicarles la transformación den por resultado el polinomio nulo:

\[F\left( v \right) = {0_{{P_1}}}\]

Éstas son las coordenadas en la base \(B\) de una base del núcleo:

\[v=2 \, (1,0)-(1,1)=\underbrace{(1,-1)}_{B_{Nu}}\]Vamos a retomar el ejemplo 3, ítem a, de la página 40 que decía:

Hallar la expresión analítica de la siguiente transformación de \( \mathbb{R}^2 \to \mathbb{R}^2\;:\; \) Simetría respecto de la recta \(y = 3x\)

En ese ejemplo habíamos obtenido la fórmula de la transformación lineal:

\[T\left( {\left( {x,y} \right)} \right) = \left( { -\, \frac{4}{5}x + \frac{3}{5}y; \;\;\frac{3}{5}x + \frac{4}{5}y} \right)\]

La matriz estándar (referida a la base canónica de\({\;\mathbb{R}^2}\,\)), \(M{\left( T \right)_{EE}}\;\) es la siguiente:

\[M\left( T \right) = \left( {\begin{array}{*{20}{c}}{ - \dfrac{4}{5}}&{\dfrac{3}{5}}\\{\dfrac{3}{5}}&{\dfrac{4}{5}}\end{array}} \right)\]

Observación: cuando se trata de las bases canónicas para simplificar la notación se escribe \(M\left( T \right)\) en lugar de \(M{\left( T \right)_{EE}}\).

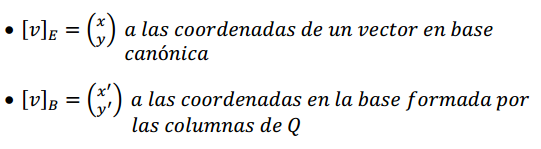

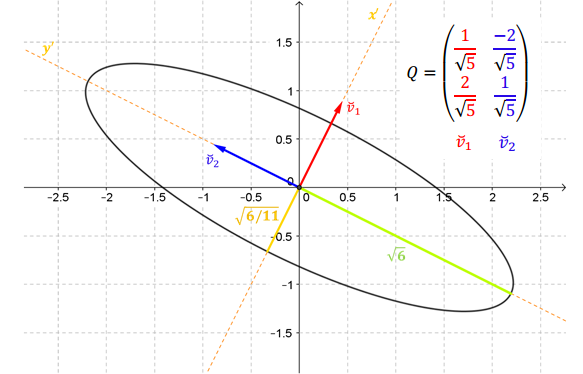

Veamos si podemos hallar una representación matricial más sencilla para esta simetría.

¿Qué significa una simetría respecto de la recta \(y = 3x\,\)? Recordemos que el transformado de un vector que esté sobre la recta es el mismo vector, y el transformado de un vector perpendicular a la recta es su opuesto.

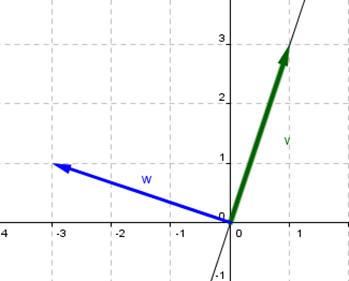

Armemos una base de \({\mathbb{R}^2}\) formada por un vector \(\vec v\) sobre la recta \(y = 3x\) y un vector \(\vec w\) perpendicular a dicha recta. Por ejemplo:

¿Cuál es la matriz asociada a la transformación lineal en esta nueva base?

\[M{\left( T \right)_{BB}} = \left( {\begin{array}{*{20}{c}}1&0\\0&{ - 1}\end{array}} \right)\]

Eligiendo una base conveniente, pudimos caracterizar la simetría mediante una matriz diagonal. Continuaremos desarrollando este tema en el próximo capítulo (autovalores y autovectores).

Dada la transformación lineal \(F\) de \({\mathbb{R}^3}\) a \({P_1}\) cuya matriz asociada es:

\[M{\left( F \right)_{BE}} = \left( {\begin{array}{*{20}{c}}1&0&1\\{ - 1}&0&0\end{array}} \right)\]

siendo \(B = \left\{ {\left( {1,0,0} \right)\;,\;\left( {1,1,0} \right)\;,\;\left( {1,0,1} \right)} \right\}\) y \(E = \left\{ {1,\;x} \right\}\) bases de \({\mathbb{R}^3}\) y \({P_1}\) respectivamente.

Recordemos que:

Para obtener una base de \(Im\left( T \right)\) tenemos que determinar cuántos son LI. Se puede demostrar que en \(\left\{ {T\left( {{v_1}} \right), \ldots ,T\left( {{v_n}} \right)} \right\}\) habrá tantos vectores LI como columnas LI en la matriz. Dado que el rango de una matriz es el número de columnas LI, entonces el rango de la matriz asociada a la transformación lineal respecto de las bases \(B\) y \(B\,'\) es igual a la dimensión de la imagen de la trasformación lineal.

Observación: La dimensión de la imagen no depende de las bases elegidas, por esto el rango tampoco depende de ellas.

Sea \(T:{\mathbb{R}^2} \to {\mathbb{R}^3}\) una transformación lineal tal que su matriz estándar es: \(M\left( T \right) = \left( {\begin{array}{*{20}{c}}1&2\\1&a\\0&{ - 1}\end{array}} \right) \in {\mathbb{R}^{3 \times 2}}\)

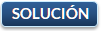

Sean \(F\) y \(G\,\) dos transformaciones lineales tales que: \[F:U \to V;{\rm{\;\;\;\;\;}}G:V \to W\]

\[\exists \; GoF:U \to W{\rm{\;}}|{\rm{\;}} \left(GoF\right) \left( u \right) = G\left( {F\left( u \right)} \right){\rm{\;\;}}\forall u \in U\] Propiedad: la composición de transformaciones lineales, es una transformación lineal.

\[F:{\mathbb{R}^2} \to {\mathbb{R}^3}{\rm{\;}}|{\rm{\;}}F\left( {\left( {x,y} \right)} \right) = \left( {x - y,\;x + y,\;2x} \right)\] \[G:{\mathbb{R}^3} \to {\mathbb{R}^2}{\rm{\;}}|{\rm{\;}}G\left( {\left( {x,y,z} \right)} \right) = \left( {x - z,{\rm{\;}}y + z} \right)\]

Hallar la fórmula de \(GoF\) y \(Fo\,G\), indicando en cada caso dominio y codominio. \[GoF:{\mathbb{R}^2} \to {\mathbb{R}^2},{\rm{\;\;\;}}Go\,F\left( {\left( {x,y} \right)} \right) = G\left( {\left( {x - y,\;x + y,\;2x} \right)} \right)\] \[ = \left( {x - y - \left( {2x} \right){\rm{\;}},{\rm{\;\;\;}}x + y + 2x} \right) = \left( { - x - y,{\rm{\;}}3x + y} \right)\] \[Fo\,G:{\mathbb{R}^3} \to {\mathbb{R}^3},{\rm{\;}}Fo\,G\left( {\left( {x,y,z} \right)} \right) = F\left( {\left( {x - z,\; y + z} \right)} \right)\] \[ =\left(x - z - (y + z), \, x - z + (y + z),\, 2x - 2z \right)\; \Rightarrow\] \[\left(Fo\,G\right)(x,y,z) = ({x - y - 2z,\; x + y,\; 2x - 2z})\] ¿Con qué operación de matrices se relaciona la composición de transformaciones lineales?

Busquemos las matrices estándar: \[M\left( F \right) \in {\mathbb{R}^{3 \times 2}},{\rm{\;\;}}M\left( F \right) = \left( {\begin{array}{*{20}{c}}1&{ - 1}\\1&1\\2&0\end{array}} \right)\] \[M\left( G \right) \in {\mathbb{R}^{2 \times 3}},{\rm{\;\;\;\;\;}}M\left( G \right) = \left( {\begin{array}{*{20}{c}}1&0&{ - 1}\\0&1&1\end{array}} \right)\] Recuerden que cuando no colocamos subíndices, significa que es la matriz estándar, referida a las bases canónicas.

Calculemos los productos: \[M\left( F \right).M\left( G \right) = \left( {\begin{array}{*{20}{c}}1&{ - 1}\\1&1\\2&0\end{array}} \right)\left( {\begin{array}{*{20}{c}}1&0&{ - 1}\\0&1&1\end{array}} \right) = \left( {\begin{array}{*{20}{c}}1&{ - 1}&{ - 2}\\1&1&0\\2&0&{ - 2}\end{array}} \right)\]Sean \(F\) y \(G\) dos transformaciones lineales tales que: \[F:U \to V;{\rm{\;\;\;\;\;}}G:V \to W\] Y sean \({B_1},{B_2},{B_3}\) bases de \(U,V\) y \(W\) respectivamente, entonces

se puede demostrar que:

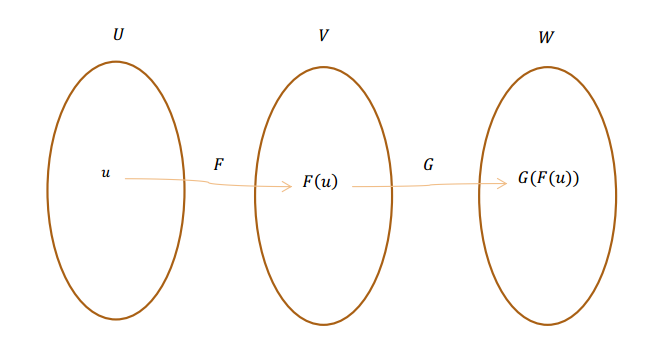

\({T^{ - 1}}\) también es una transformación lineal biyectiva: \[{T^{ - 1}}o\,T = I{d_V}\] \[To\,{T^{ - 1}} = I{d_w}\] Observación: Para que exista una transformación lineal biyectiva entre dos espacios vectoriales, éstos deben tener la misma dimensión. ¿Por qué?

Sea la transformación lineal \(T:{\mathbb{R}^2} \to {\mathbb{P}_1}\), \(T\left( {\left( {a,b} \right)} \right) = a - b + 2ax\)

¿Cuál es el núcleo de \(T\)?

\[a - b + 2ax = 0x + 0 \Rightarrow {\rm{\;}}\left\{ {\begin{array}{*{20}{c}}{a - b = 0}\\{2a = 0}\end{array}{\rm{\;}}} \right. \Rightarrow a = 0 = b\] \[Nu\left( T \right) = \left\{ {\left( {0,0} \right)} \right\}\] ¿Cuál es la imagen de \(T\)? \[T\left( {\left( {1,0} \right)} \right) = 2x + 1\] \[T\left( {\left( {0,1} \right)} \right) = - 1 + 0x\] Estos dos polinomios ¿son LI o LD? Son LI, y por lo tanto la dimensión de la imagen es 2. La imagen ‘vive’ en \({\mathbb{P}_1}\), entonces: \[Im\left( T \right) = {\mathbb{P}_1}\]

¿Está bien definida \({T^{ - 1}}\)? Sí, porque \(\left\{ {2x + 1, - 1} \right\}\) es una base de \({P_1}\) (por

Sea \(T:V \to W\) isomorfismo, \(\dim \left( V \right) = \dim \left( W \right) = n\), y \(M{\left( T \right)_{BB\,'}} \in {\mathbb{R}^{n \times n}}\;\) la matriz asociada a \(T\,\) respecto de las bases \(B\) y \(B\,'\).

Recordemos que el rango de la matriz asociada es igual a la dimensión de la imagen.

Como \(T\) es isomorfismo, \(Im\left( T \right)\; = \;W\) y por lo tanto: \(rg\left( {M{{\left( T \right)}_{BB\,'}}} \right) = n\).

Entonces\(\;\;\;M{\left( T \right)_{BB\,'}}\) es inversible y su inversa es la matriz de \({T^{ - 1}}\) respecto de las bases \(B\,'\) y \(B\):

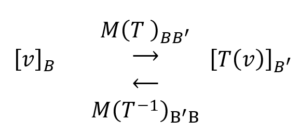

En el siguiente esquema se puede observar cómo operan las matrices \(M{\left( T \right)_{BB\,'}}\) y \(M{\left( {{T^{ - 1}}} \right)_{B\,'B}}\,\):

Caso particular: \(V = W = {\mathbb{R}^n}\),

Sea \(T:{\mathbb{R}^3} \to {\mathbb{R}^3}\) una TL, tal que \(\;T\left( {x,y,z} \right) =\left( {x + y,\;x - z,\;z} \right)\), hallar la fórmula de \({T^{ - 1}}\).

Construyamos la matriz asociada a la TL en las bases canónicas: \[M\left( T \right) = A = \left( {\begin{array}{*{20}{c}}1&1&0\\1&0&{ - 1}\\0&0&1\end{array}} \right)\]

Sabemos que \({A^{ - 1}}\) será la matriz asociada a la TL inversa: \[M\left( {{T^{ - 1}}} \right) = \;{A^{ - 1}} = \left( {\begin{array}{*{20}{c}}0&1&1\\1&{ - 1}&{ -1}\\0&0&1\end{array}} \right)\]

Y a partir de la matriz estándar de la TL inversa podemos hallar la fórmula de la TL inversa:

\[{T^{ - 1}}:{\mathbb{R}^3} \to {\mathbb{R}^3},\;\;\;{T^{ - 1}}\left( {\left( {x,y,z} \right)} \right) = \left( {y + z,\;x - y - z,\;z} \right)\]Dadas las transformaciones lineales: \(F\) de \({\mathbb{R}^3} \to {\mathbb{R}^2}\), \(F\left( {x,y,z} \right)\; = \left( {x - y\;,\;y + z} \right)\) y \(G\) de \({\mathbb{R}^2} \to {\mathbb{R}^3}\), \(G\left( {a,b} \right)\; = \;\left( {a + b\;,\;0,\;2a + kb} \right)\)

a) Determinar todos los valores de \(k\) para los cuales \(F \circ G\) es biyectiva (isomorfismo).

b) Para \(k = 1\), obtener \({\left( {F \circ G} \right)^{ - 1}}\left( {1,0} \right)\).

Queremos construir una matriz que nos permita cambiar las coordenadas de un vector en una base por las coordenadas del mismo vector en otra base.

Consideremos en un espacio vectorial \(V\) la función identidad, que transforma cada vector en sí mismo. Dejamos a cargo del lector demostrar que es una T.L. \[Id:V \to V{\rm{\;}}|{\rm{\;}}Id\left( v \right) = v\]

Observación: Si \(V = \mathbb{R}\), la función identidad es \(f\left( x \right) = x\). Tomemos un par de bases del mismo espacio vectorial \(V\): \[B = \left\{ {{v_1}, \ldots ,{v_n}} \right\}\] \[B\,' = \left\{ {{w_1}, \ldots ,{w_n}} \right\}\] Construyamos ahora la

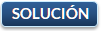

¿Qué efecto produce esta matriz? Cambia las coordenadas, o sea el sistema de referencia. No transforma el vector pues \(Id\left( v \right) = v\).

\[M{\left( {Id} \right)_{BB\,'}}\;\text{se denomina matriz de cambio de base de}\; B \;a\; B\,'. \]¿Qué rango tiene esta matriz? Tiene rango \(n\) ya que sus columnas son LI por ser coordenadas de vectores de una base de \(V\).

Por ser \(M{\left( {Id} \right)_{BB\,'}} \in {\mathbb{R}^{n \times n}}\) de rango \(n\), es inversible.

¿Qué efecto produce la matriz inversa? Nos permite volver a la primera base, como lo indica el siguiente esquema:

Consideremos las siguientes bases de \({\mathbb{R}^2}\): \[{B_1} = \left\{ {\left( {1,0} \right),\;\left( {1,3} \right)} \right\}\] \[{B_2} = \left\{ {\left( {0,1} \right),\left( {1,1} \right)} \right\}\] \[E = \left\{ {\left( {1,0} \right),\left( {0,1} \right)} \right\}\]

a) Hallar \(M{\left( {Id} \right)_{{B\displaystyle_{1}}{B\displaystyle_2}}}\)

b) Hallar \(M{\left( {Id} \right)_{{B\displaystyle_1}E}}\)

c) Hallar \(M{\left( {Id} \right)_{E{B\displaystyle_1}}}\)

Ítem a

Se construye la matriz de cambio de base buscando las coordenadas en la base \({B\displaystyle_2}\) de los vectores de la base \({B\displaystyle_1}\).

\[M{\left( {Id} \right)_{{B\displaystyle_1}{B\displaystyle_2}}} = \left( {{{\left[ {{v_1}} \right]}_{{B\displaystyle_2}}}\;\;\;\;{{\left[ {{v_2}} \right]}_{{B\displaystyle_2}}}} \right)\]

Busquemos las coordenadas de \(\left( {1,0} \right)\) en la base \({B\displaystyle_2}\;\):

\[\left( {1,0} \right) = \alpha \left( {0,1} \right) + \beta \left( {1,1} \right)\] \[ \Rightarrow \alpha = \; - 1\;\; \wedge \;\;\beta = 1\] \[ \Rightarrow {\left[ {\left( {1,0} \right)} \right]_{{B\displaystyle_2}}} = \left( {\begin{array}{*{20}{c}}{ - 1}\\1\end{array}} \right)\] Busquemos las coordenadas de \(\left( {1,3} \right)\) en la base \({B\displaystyle_2}\;\): \[\left( {1,3} \right) = \alpha \left( {0,1} \right) + \beta \left( {1,1} \right)\] \[ \Rightarrow \alpha = 2\;\; \wedge \;\beta = 1\] \[ \Rightarrow {\left[ {\left( {1,3} \right)} \right]_{{B_2}}} = \left( {\begin{array}{*{20}{c}}2\\1\end{array}} \right)\]

Ítem b

Se construye la matriz de cambio de base buscando las coordenadas en la base \(E\) de los vectores de la base \({B\displaystyle_1}\). \[M{\left( {Id} \right)_{{B\displaystyle_1}E}} = \left( {{{\left[ {{v_1}} \right]}_E}\;\;\;\;{{\left[ {{v_2}} \right]}_E}} \right)\] Pero las coordenadas en base canónicas son las mismas componentes del vector. Podemos verificarlo para \(\left( {1,0} \right)\): \[\left( {1,0} \right) = \alpha \left( {1,0} \right) + \beta \left( {0,1} \right) \Rightarrow \alpha = 1,\;\beta = 0\] Entonces las coordenadas de \(\left( {1,0} \right)\) en la base canónica son justamente \(\left( {\begin{array}{*{20}{c}}1\\0\end{array}} \right)\): \[{\left[ {\left( {1,0} \right)} \right]_E} = \left( {\begin{array}{*{20}{c}}1\\0\end{array}} \right)\] Para el vector \(\left( {1,3} \right)\) podemos escribir: \[{\left[ {\left( {1,3} \right)} \right]_E} = \left( {\begin{array}{*{20}{c}}1\\3\end{array}} \right)\] Así que la matriz de cambio de base resulta: \[M{\left( {Id} \right)_{{B\displaystyle_1}E}} = \left( {\begin{array}{*{20}{c}}1&1\\0&3\end{array}} \right)\]

Que podemos decir que se construyó ubicando a los vectores de la base \({B_1} = \left\{ {\left( {1,0} \right),\left( {1,3} \right)} \right\}\) como columnas de la matriz.

Ítem c

Se pide que hallemos \(M{\left( {Id} \right)_{E{B\displaystyle_1}}}\), pero según hemos visto esta matriz es la inversa de \(M{\left( {Id} \right)_{{B\displaystyle_1}E\;}}\): \[M{\left( {Id} \right)_{E{B\displaystyle_1}}} = \dfrac{1}{3}\left( {\begin{array}{*{20}{c}}3&{ - 1}\\0&1\end{array}} \right) = \left( {\begin{array}{*{20}{c}}1&{ - \frac{1}{3}}\\0&{\frac{1}{3}}\end{array}} \right)\]

Sean \({B_1}\) y \({B_2}\) bases de \({\mathbb{R}^2}\) tales que \(P = \left( {\begin{array}{*{20}{c}}1&1\\0&{ - 3}\end{array}} \right)\) es la matriz de cambio de base de \({B_1}\) a \({B_2}.\)

a) Si \({\left[ u \right]_{{B\displaystyle_1}}} = \left( {\begin{array}{*{20}{c}}{ - 1}\\4\end{array}} \right)\) calcular \({\left[ u \right]_{{B\displaystyle_2}}}\)

b) Si \({\left[ v \right]_{{B\displaystyle_2}}} = \left( {\begin{array}{*{20}{c}}3\\5\end{array}} \right)\) calcular \({\left[ v \right]_{{B\displaystyle_1}}}\)

c) Si \({B_1} = \left\{ {\left( {1,3} \right),\left( {0,4} \right)} \right\}\), obtener la base \({B_2}\). ¿Es única?

Ítem a

Según la propiedad de la matriz de cambio de base:

¿Podemos determinar cuál es el vector \(u\)? No, porque no tenemos información sobre las bases.

Ítem b

Ahora es en sentido contrario: \[{\left[ v \right]_{{B\displaystyle_2}}} = \left( {\begin{array}{*{20}{c}}3\\5\end{array}} \right) \to {\left[ v \right]_{B\displaystyle_1 \;}} = \;?\] \[P.{\left[ v \right]_{{B\displaystyle_1}}} = {\left[ v \right]_{{{\rm{B}}\displaystyle_2}}} \Rightarrow \left( {\begin{array}{*{20}{c}}1&1\\0&{ - 3}\end{array}} \right){\left[ v \right]_B} = \left( {\begin{array}{*{20}{c}}3\\5\end{array}} \right){\rm{\;}} \Rightarrow {\left[ v \right]_B} = \left( {\begin{array}{*{20}{c}}{\dfrac{{14}}{3}}\\{ - \dfrac{5}{3}}\end{array}} \right)\]

Ítem c

En este punto nos dan la base \({B_1}\): \[{B_1} = \left\{ {\left( {1,3} \right),\left( {0,4} \right)} \right\}\] ¿Puede determinarse \({B_2}\)? Sabemos que: \[Id\left( {\left( {1,3} \right)} \right) = \left( {1,3} \right)\] \[Id\left( {\left( {0,4} \right)} \right) = \left( {0,4} \right)\] \[{v_1} = \left( {1,3} \right){\rm{\;\;}}{v_2} = \left( {0,4} \right)\]

Queremos obtener: \[{B\displaystyle_2} = \left\{ {{w\displaystyle_{1{\rm{\;}}}},{\rm{\;}}{w\displaystyle_2}} \right\}\] \[\left( {1,3} \right) = 1\,{w\displaystyle_1} + 0\,{w\displaystyle_2} \Rightarrow {w\displaystyle_1} = \left( {1,3} \right)\] \[\left( {0,4} \right) = 1\,{w\displaystyle_1} + \left( { - 3} \right)\,{w\displaystyle_2} \Rightarrow {w\displaystyle_2} = \frac{{\left( {0,4} \right) - \left( {1,3} \right)}}{{ - 3}} = \left( {\frac{1}{3}, - \frac{1}{3}} \right)\] Quiere decir que si tenemos como dato la matriz de cambio de base, podemos determinar la base \({B\displaystyle_2}\;\)a partir de la base \({B\displaystyle_1}\) y viceversa.

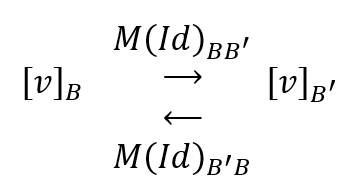

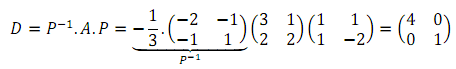

En este apartado nos interesa estudiar cuál es la relación entre dos matrices asociadas a una misma transformación lineal, pero que están expresadas en bases diferentes.

Sean:

¿Qué relación existe entre \(M{\left( T \right)_{{B\displaystyle_1}{B\displaystyle_2}}}\) y \(M{\left( T \right)_{{B\displaystyle_3}{B\displaystyle_4}}}\;\)? ¿Cómo se podría a partir de una de ellas calcular la otra?

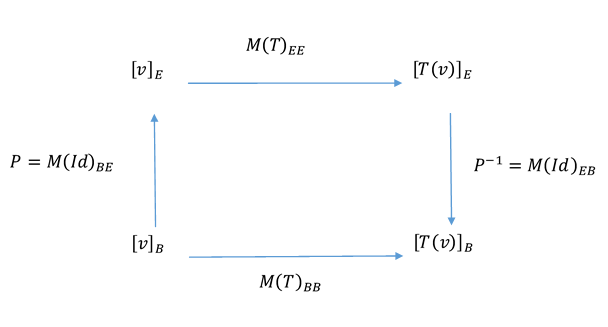

Por las propiedades de las matrices asociadas a una TL, puede afirmarse que: \[M{\left( T \right)_{{B\displaystyle_1}{B\displaystyle_2}}}{\left[ v \right]_{{B\displaystyle_1}}} = {\left[ {T\left( v \right)} \right]_{{B\displaystyle_2}}}\] \[M{\left( T \right)_{{B\displaystyle_3}{B\displaystyle_4}}}{\left[ v \right]_{{B\displaystyle_3}}} = {\left[ {T\left( v \right)} \right]_{{B\displaystyle_4}}}\] \[M{\left( {I{d_V}} \right)_{{B\displaystyle_3}{B\displaystyle_1}}}{\left[ v \right]_{{B\displaystyle_3}}} = {\left[ v \right]_{{B\displaystyle_1}}}\] \[M{\left( {I{d_W}} \right)_{{B\displaystyle_2}{B\displaystyle_4}}}{\left[ {T\left( v \right)} \right]_{{B\displaystyle_2}}} = {\left[ {T\left( v \right)} \right]_{{B\displaystyle_4}}}\] Si el lector leyó cuidadosamente las igualdades anteriores, estará convencido de que son válidas. Las relaciones enunciadas pueden verse convenientemente en el siguiente esquema:

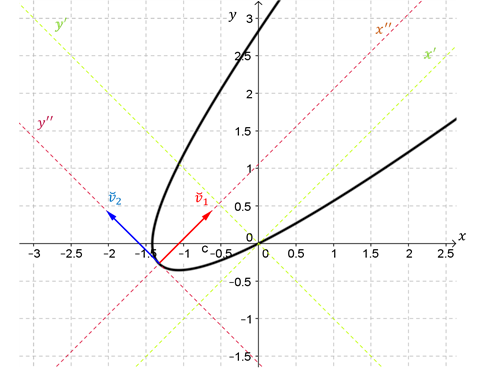

Nos interesa especialmente el caso de las TL \(T:{\mathbb{R}^n} \to {\mathbb{R}^n}\), y la relación entre la matriz estándar y otra matriz asociada \(M{\left( T \right)_{BB}}\) , con \(\;B\) base de \({\mathbb{R}^n}\). Volvamos a construir el esquema para este caso particular:

Por lo tanto:

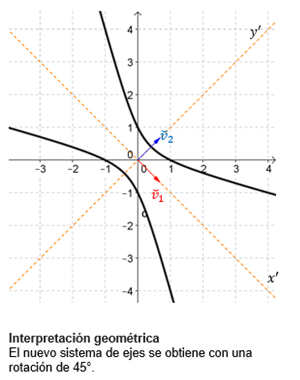

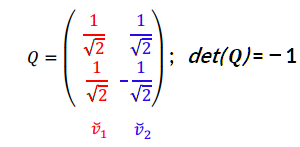

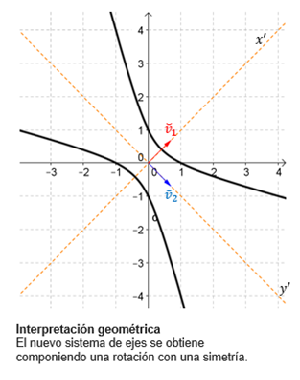

Queremos encontrar \(M{\left( T \right)_{BB}}\) . Calculamos la matriz de cambio de base: \[P = M{\left( {Id} \right)_{BE}} = \left( {\begin{array}{*{20}{c}}1&3\\1&{ - 2}\end{array}} \right)\] Buscamos su inversa: \[{P^{ - 1}} = M{\left( {Id} \right)_{EB}} = - \, \frac{1}{5}\left( {\begin{array}{*{20}{c}}{ - 2}&{ - 3}\\{ - 1}&1\end{array}} \right)\] Entonces resulta: \[M{\left( T \right)_{BB}} = {P^{ - 1}}\,M{\left( T \right)_{EE}}\,P = \left( {\begin{array}{*{20}{c}}4&0\\0&{ - 1}\end{array}} \right)\]

Observemos que en esta base \(B\), la matriz asociada es diagonal. Dada una TL en \({\mathbb{R}^n}\), ¿cuándo es posible hallar una base \(B\) de modo que la matriz asociada en esa base resulte diagonal? La respuesta la encontraremos en el próximo capítulo.

a) Eligiendo una base adecuada, definir una transformación lineal \(T:{\mathbb{R}^3} \to {\mathbb{R}^3}\) que represente la simetría (reflexión) respecto del plano \(\pi :\;\;x - z = 0\) .

b) Hallar si es posible, una base \(B\) de \({\mathbb{R}^3}\) de modo que la matriz asociada a \(T\) sea: \[M{\left( T \right)_{BB}} = \left( {\begin{array}{*{20}{c}}1&0&0\\0&1&0\\0&0&{ - 1}\end{array}} \right)\] Sugerencia: si \(B = \left\{ {{v_1},{v_2},{v_3}} \right\}\), ¿cuáles son los transformados de los vectores de \(B\,\)? (Tener en cuenta cómo se construye \(M{\left( T \right)_{BB}}\)).

c) Obtener la matriz de \(T\) respecto de la base canónica de \({\mathbb{R}^3}\).

Muchos cuestionan la utilidad de las matemáticas, y los propios matemáticos a veces las defendemos más como un arte que por sus aplicaciones, que consideramos propiedad privada de los ingenieros. Sin embargo, están presentes en todo lo que nos rodea: desde la seguridad en internet hasta los gráficos de los videojuegos y la compresión de imágenes. En una era tan tecnológica, ¿no deberíamos saber más matemáticas?

Veamos algunas aplicaciones (información que hemos obtenido gracias a la IA Gemini 2.0)

Cliquea en el botón superior derecho del interactivo para tener el recurso abierto de forma independiente y navega por las distintas pestañas.

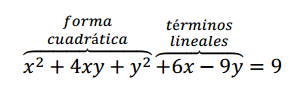

En la siguiente página podemos observar algunas transformaciones lineales asociadas a movimientos geométricos conocidos: homotecias de razón positiva, reflexiones (simetrías axiales), cizallamientos respecto de cada uno de los ejes de coordenadas, rotaciones, rotaciones compuestas con escalados y un sexto movimiento que llamamos "Ejemplo".

¿Puedes interpretar que tipos de movimientos son los que se producen en el "Ejemplo"?

Sugerimos que pruebes con distintos valores del parámetro. Por ejemplo:

Si el elemento variable de la matriz es 2, el determinante de la matriz es \(-3\), Como \(\det(A) \neq \pm1\), la transformación no es una isometría (no conserva distancias). Además, \( \det(A) < 0 \) implica que la transformación "invierte la orientación", lo que sugiere que podría ser una reflexión combinada con otro tipo de transformación.

Los autovalores nos ayudan a entender la transformación en términos de direcciones invariantes. Los autovalores son: \(\;\lambda_1 = 3, \quad \lambda_2 = -1.\)

Un autovector asociado a \( \lambda_1 = 3 \) es \( v_1 = (1,1), \, \) mientras que uno asociado a \( \lambda_2 = -1 \) es \( v_2 = (1,-1) \).

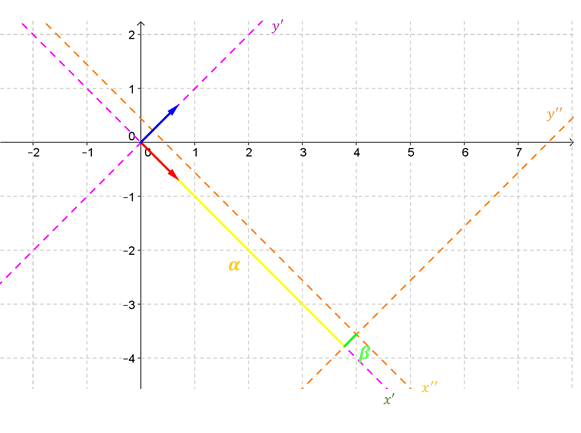

En esta animación podemos mover el cuadrado de área 1 moviendo el vértice inferior izquierdo. Una vez que decidimos donde localizarlo, podemos transformar los versores de la base canónica arrastrando sus extremos. ¿Cómo se refleja este movimiento en las columnas de la matriz?

Podemos tildar la casilla "Cuadrícula" pudiendo observar cómo se transforma todo el espacio. Para ello, una vez marcada dicha casilla, usamos el botón "Animar".

Para restablecer el plano y el cuadrado original cliqueamos en "Comenzar". El botón "Ortogonal" permite visualizar dos vectores ortogonales como referencia.

En el siguiente interactivo te proponemos que explores 5 transformaciones y trates de describir que tipo de movimiento producen. Luego dirígete a la herramienta de IA de la página siguiente y te proponemos que utilices un prompt similar a: "¿Qué tipo de movimiento geométrico representa la transformación lineal dada por la matriz:

Ten especial cuidado al escribir la matriz en el formato sugerido (latex) para que la IA interprete correctamente los datos ingresados. Puedes cambiar los valores numéricos de manera de usar los de cada ejemplo.

Ten especial cuidado al escribir la matriz en el formato sugerido (latex) para que la IA interprete correctamente los datos ingresados. Puedes cambiar los valores numéricos de manera de usar los de cada ejemplo.

Introduce el prompt sugerido: "¿Qué tipo de movimiento geométrico representa la transformación lineal dada por..."

En caso de utilizar valores decimales recuerda que el separador decimal es "." (debemos escribir 0.5 si queremos referirnos al número "un medio".)

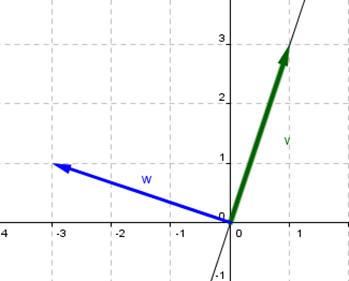

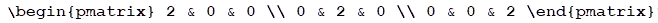

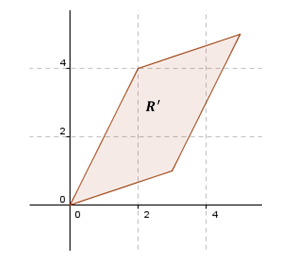

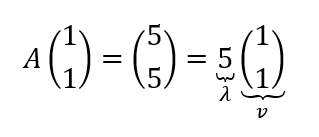

Consideremos la matriz: \[A = \left( {\begin{array}{*{20}{c}}3&2\\1&4\end{array}} \right)\] Queremos ver cuál es el efecto que provoca esa matriz al multiplicarla por los vectores de \({\mathbb{R}^2}\). ¿Qué pasa cuando uno multiplica esa matriz A por un vector? \[A.\left( {\begin{array}{*{20}{c}}x\\y\end{array}} \right) = \left( {\begin{array}{*{20}{c}}3&2\\1&4\end{array}} \right).\left( {\begin{array}{*{20}{c}}x\\y\end{array}} \right) = \left( {\begin{array}{*{20}{c}}{3x + 2y}\\{x + 4y}\end{array}} \right)\] Pensemos para que sea sencillo que tomamos el cuadrado con vértice en el origen de lado 1 y que está en el primer cuadrante:

Digamos que llamamos a esta zona el recinto \(R\). ¿En qué se transformaría este recinto bajo el efecto de esa matriz? Para responder esta pregunta podemos ver en que se transforman sus vértices. Sabemos que el vector nulo se va a transformar en el vector nulo. Los demás serán: \[A\left( {\begin{array}{*{20}{c}}1\\0\end{array}} \right) = \left( {\begin{array}{*{20}{c}}3\\1\end{array}} \right)\] \[A\left( {\begin{array}{*{20}{c}}0\\1\end{array}} \right) = \left( {\begin{array}{*{20}{c}}2\\4\end{array}} \right)\] \[A\left( {\begin{array}{*{20}{c}}1\\1\end{array}} \right) = \left( {\begin{array}{*{20}{c}}5\\5\end{array}} \right)\]

Uno se podría hacer esta pregunta: ¿Habrá vectores que después de la deformación conservan la dirección?

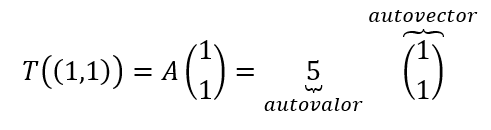

Ese vector que mantuvo su dirección se denomina autovector, y el factor por el cual se dilató es el autovalor correspondiente.

En el ejemplo que vimos recién el transformado de \(\left( {1,1} \right)\) es \(\left( {5,5} \right)\), entonces:

Veamos cómo hallar los autovalores y autovectores: Según la definición, debe cumplirse esta condición: \[Av = \lambda v\;\;{\rm{\;con\;}}v \ne {0_V}\] Restamos a ambos miembros \(\lambda v\): \[Av \; - \; \lambda v = {0_V}\] Premultiplicamos a \(v\) por \(I\), esto lo podemos hacer porque \(Iv = v\): \[Av \; - \; \lambda \,I\,v = {0_V}\]

Entonces:

\[ \underbrace{\left ( A -\lambda I\ \right )}_{\displaystyle{nxn}}\,v = 0_{v} \]Resulta un sistema homogéneo con \(n\) ecuaciones y \(n\) incógnitas, donde \(A - \lambda I\) es la matriz de los coeficientes.

¿Cómo puede ser un sistema homogéneo en cuanto a su compatibilidad?

Respuesta: siempre compatible, porque siempre tiene la solución trivial. ¿Cómo queremos que sea en nuestro problema si estamos buscando vectores que no cambien su dirección?

¿Sistema compatible determinado (SCD) o sistema compatible indeterminado (SCI)?. Si es SCD, tiene únicamente la solución trivial y \(v\) es el vector nulo. Nuestro objetivo es obtener los autovectores (que son distintos del vector nulo), por eso necesitamos que este sistema sea compatible indeterminado.

Entonces: buscamos un sistema compatible indeterminado.

En un sistema cuadrado y homogéneo, el determinante decide: si es distinto de cero, tiene solución única. Entonces queremos que sea igual a cero:

Esta es la ecuación característica de la matriz \(A\).

Y \(p\left( \lambda \right) = {\rm{det}}\left( {A - \lambda I} \right)\) es un polinomio de grado \(n\) dependiente de \(\lambda\, \) que se llama polinomio característico de la matriz \(A\).

Las raíces del polinomio característico son los autovalores de\(A\).

Una vez hallados los autovalores, ¿cómo obtenemos los autovectores?

Volvemos a la expresión original.

Para cada \(\lambda \) resolvemos el sistema:

\[\left( {A - \lambda I} \right)\,v = {0_V}\]Y hallamos los autovectores correspondientes.

Si la matriz es de 2 por 2, el polinomio quedará de grado 2.

Si la matriz es de 3 por 3, el polinomio quedará de grado 3.

Otros nombre que se les suele dar a los autovectores y autovalores son:

Volvamos al ejemplo inicial. \[A - \lambda I = \left( {\begin{array}{*{20}{c}}3&2\\1&4\end{array}} \right) - \lambda \left( {\begin{array}{*{20}{c}}1&0\\0&1\end{array}} \right) = \left( {\begin{array}{*{20}{c}}{3 - \lambda }&2\\1&{4 - \lambda }\end{array}} \right)\] \[\det \left( {A - \lambda I} \right) = 0\] \[\left( {3 - \lambda } \right)\left( {4 - \lambda } \right) - 2 = 0\] \[{\lambda ^2} - 7\lambda + 10 = 0\] \[{\lambda _1} = 2 \wedge {\lambda _2} = 5\] Para \(\lambda = 2\,\) resolvemos el sistema de ecuaciones: \[\left( {A - 2I} \right)\left( {\begin{array}{*{20}{c}}x\\y\end{array}} \right) = \left( {\begin{array}{*{20}{c}}0\\0\end{array}} \right)\]

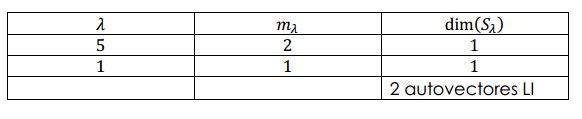

Consideremos la siguiente matriz de \(3 \times 3\): \[B = \left( {\begin{array}{*{20}{c}}3&2&{ - 1}\\2&3&1\\0&0&5\end{array}} \right)\] Busquemos sus autovalores resolviendo el polinomio característico: \[\left| {\begin{array}{*{20}{c}}{3 -\lambda }&2&{ - 1}\\2&{3 - \lambda }&1\\0&0&{5 - \lambda }\end{array}} \right| = 0\] \[\left( {5 - \lambda } \right)\left( {{{\left( {3 - \lambda } \right)}^2} - 4} \right) = 0\] Luego los autovalores son: \[{\lambda \displaystyle_1} = 5\;\; \vee \;\;\;{\lambda\displaystyle_2} = 5\;\; \vee \;\;{\lambda\displaystyle_3} = 1\] Donde la multiplicidad algebraica de \(5\) es 2. Esto significa que 5 es raíz doble del polinomio característico.

Para cada autovalor debemos resolver el sistema de ecuaciones \[\left( {\begin{array}{*{20}{c}}{3 - \lambda }&2&{ - 1}\\2&{3 - \lambda }&1\\0&0&{5 - \lambda }\end{array}} \right) \left( {\begin{array}{*{20}{c}}x\\{\begin{array}{*{20}{c}}y\\z\end{array}}\end{array}} \right) = \left( {\begin{array}{*{20}{c}}0\\{\begin{array}{*{20}{c}}0\\0\end{array}}\end{array}} \right)\] Para obtener cuales son los autoespacios correspondientes a cada autovalor.

Autovectores asociados a \({\rm{\lambda }} = 5\):

Resolvamos el sistema compatible indeterminado: \[\left( {\begin{array}{*{20}{c}}{ - 2}&2&{ - 1}\\2&{ - 2}&1\\0&0&0\end{array}} \right)\left( {\begin{array}{*{20}{c}}x\\{\begin{array}{*{20}{c}}y\\z\end{array}}\end{array}} \right) = \left( {\begin{array}{*{20}{c}}0\\{\begin{array}{*{20}{c}}0\\0\end{array}}\end{array}} \right) \Rightarrow \left\{ {\begin{array}{*{20}{c}}{ - 2x + 2y - z = 0}\\{2x - 2y + z = 0}\\{0 = 0}\end{array}} \right.\] \[\Rightarrow - 2x + 2y - z = 0\]

El subespacio asociado a este autovalor es: \[{S\large_5} = gen\left\{ {\left( {\begin{array}{*{20}{c}}1\\{\begin{array}{*{20}{c}}0\\{ - 2}\end{array}}\end{array}} \right),\left( {\begin{array}{*{20}{c}}0\\{\begin{array}{*{20}{c}}1\\2\end{array}}\end{array}} \right)} \right\}\;\]

Luego dos autovectores son: \[{v_1} = \left( {\begin{array}{*{20}{c}}1\\{\begin{array}{*{20}{c}}0\\{ - 2}\end{array}}\end{array}} \right)\;;\;\;\;{v_2} = \left( {\begin{array}{*{20}{c}}0\\{\begin{array}{*{20}{c}}1\\2\end{array}}\end{array}} \right)\]

Autovectores asociados a \({\rm{\lambda }} = 1\):

Resolvamos el sistema compatible indeterminado: \[\left( {\begin{array}{*{20}{c}}2&2&{ - 1}\\2&2&1\\0&0&4\end{array}} \right)\left( {\begin{array}{*{20}{c}}x\\{\begin{array}{*{20}{c}}y\\z\end{array}}\end{array}} \right) = \left( {\begin{array}{*{20}{c}}0\\{\begin{array}{*{20}{c}}0\\0\end{array}}\end{array}} \right) \Rightarrow \left\{ {\begin{array}{*{20}{c}}{2x + 2y - z = 0}\\{2x + 2y + z = 0}\\{4z = 0}\end{array}} \right.\] \[\Rightarrow z = 0 \; \wedge \; y = - x\]

El subespacio asociado a este autovalor es: \[{S\large_1} = gen\left\{ {\left( {\begin{array}{*{20}{c}}1\\{\begin{array}{*{20}{c}}{ - 1}\\0\end{array}}\end{array}} \right)} \right\}\;\]

Luego un autovector es: \[{v_3} = \left( {\begin{array}{*{20}{c}}1\\{\begin{array}{*{20}{c}}{ - 1}\\0\end{array}}\end{array}} \right)\]

Finalmente hemos obtenido tres autovectores: \[{v_1} = \left( {\begin{array}{*{20}{c}}1\\{\begin{array}{*{20}{c}}0\\{ - 2}\end{array}}\end{array}} \right)\;;\;\;\;{v_2} = \left( {\begin{array}{*{20}{c}}0\\{\begin{array}{*{20}{c}}1\\2\end{array}}\end{array}} \right)\;;\;\;{v_3} = \left( {\begin{array}{*{20}{c}}1\\{\begin{array}{*{20}{c}}{ - 1}\\0\end{array}}\end{array}} \right)\]

Donde \({v_1}\) y \({v_2}\) son autovectores asociados al autovalor \(\lambda = 5\) y \({v_3}\) es un autovalor asociado a \(\lambda = 1\).

Consideremos la siguiente matriz de \(2 \times 2\): \[C = \left( {\begin{array}{*{20}{c}}0&{ - 2}\\2&0\end{array}} \right)\]

Busquemos sus autovalores resolviendo el polinomio característico: \[\left| {\begin{array}{*{20}{c}}{ - \lambda }&{ - 2}\\2&{ - \lambda }\end{array}} \right| = 0\] \[ \Rightarrow \;{\lambda ^2} + 4 = 0\] Este polinomio no tiene raíces reales. Con lo cual diremos que \(C\) no tiene autovalores reales. Más adelante estudiaremos los números complejos y podremos hallar las raíces (complejas) del polinomio característico de \(C\).

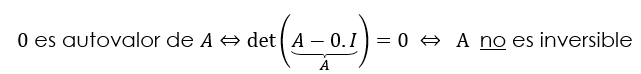

Demuestre la siguiente propiedad para \(A \in {\mathbb{R}^{n \times n}}\)

\(\lambda = 0\,\) es autovalor de \(A \Leftrightarrow A\) no es inversible