Juan Guillermo Rivera Berrío

Red Educativa Digital Descartes

Córdoba (España)

2024

Título de la obra:

Inteligencias artificiales generativas 2024

Autor:

Juan Guillermo Rivera Berrío

Colaboradores:

Jesús Manuel Muñoz Calle

José Antonio Salgueiro González

Código JavaScript para el libro: Joel Espinosa Longi, IMATE, UNAM.

Recursos interactivos: DescartesJS

Fuentes: Lato y UbuntuMono

Imagen portada: Diseño del generador de imágenes Designer de Microsoft

Red Educativa Digital Descartes

Córdoba (España)

descartes@proyectodescartes.org

https://proyectodescartes.org

Proyecto iCartesiLibri

https://proyectodescartes.org/iCartesiLibri/index.htm

ISBN: 978-84-18834-93-6

Esta obra está bajo una licencia Creative Commons 4.0 internacional: Reconocimiento-No Comercial-Compartir Igual.

Diseño del generador de imágenes Designer de Microsoft .

La inteligencia artificial (IA) es una de las tecnologías más importantes y en constante evolución de nuestro tiempo. La segunda edición de este libro explora, en forma más amplia, los fundamentos de la IAs generativas, desde los principios básicos hasta las últimas investigaciones. Comenzaremos con una visión general del campo de la inteligencia artificial, luego nos sumergiremos en distintas IAs generativas de vanguardia, examinando sus fundamentos técnicos, capacidades y limitaciones actuales. Veremos modelos que producen arte, redactan textos, diseñan presentaciones, sintetizan voz realista e incluso crean secuencias de video originales. Los capítulos están organizados de la siguiente manera:

Este libro está dirigido a estudiantes, investigadores y profesionales que estén interesados en aprender más sobre la IA generativa. También se aborda la controversia sobre las IAs generativas y se responden preguntas frecuentes sobre este tema. El libro incluye ejemplos y casos de estudio para ilustrar los conceptos y técnicas presentados.

Este libro es una guía para principiantes y para aquellos interesados en aprender más sobre la IA generativa y sus aplicaciones.

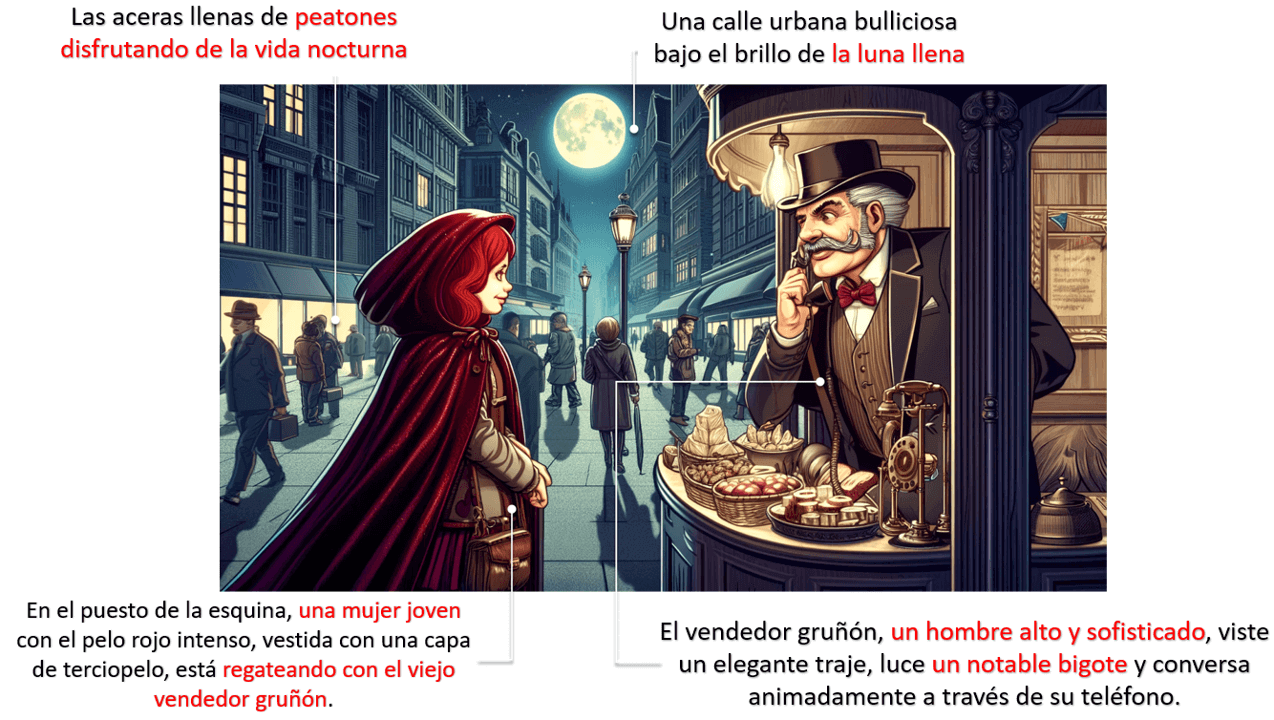

La mayoría de las imágenes y videos están diseñados con IAs generativas, cuyos enlaces se suministran, de tal forma que el lector pueda practicar con estas IAs, incorporando nuevas indicaciones (prompts) o reutilizando (remix) el prompt usado.

Según mi experiencia trabajando con las comunidades empresariales y artísticas en la adopción de innovaciones, el primer paso para entender estas herramientas es utilizarlas. Un dicho conocido en el ámbito de la educación tecnológica destaca la importancia de la experiencia directa: "Nadie aprende a jugar al fútbol con un libro de física; se aprende dando patadas al balón"

Pero, estas patadas al balón las haremos utilizando IAs generativas gratuitas o algunas que ofrecen pruebas gratis (free trial), que nos permitan evaluar su calidad y tomar la decisión de pagar o no la suscripción.

Dado el crecimiento acelerado de estas tecnologías, el título de este libro hace énfasis en su año de creación (2024), pues serán obligadas nuevas versiones en los años venideros.

Para ilustrar mejor la información suministrada en este libro, hemos incluido, entre otros elementos multimedia, los siguientes:

Poster diseñado con la IA Leonardo.

Es apenas obvio que para el diseño de este libro, usemos las inteligencias artificiales. La pregunta anterior, nos la responde GPTGOGPTO (Generative Pre-trained Transformer) es un modelo de inteligencia artificial desarrollado por OpenAI. Está basado en la arquitectura Transformer y ha sido entrenado utilizando una gran cantidad de datos de texto con el objetivo de generar secuencias coherentes y completas. GPTO es capaz de generar texto en diferentes contextos y ha demostrado ser muy efectivo en tareas como el lenguaje natural, la traducción automática, la escritura de código y la generación de texto informativo., así:

Una IA, o Inteligencia Artificial, es un campo de estudio y desarrollo de tecnología que busca crear sistemas capaces de realizar tareas que requieren inteligencia humana. Estos sistemas se diseñan para imitar la capacidad de aprendizaje, razonamiento y toma de decisiones que poseen los seres humanos.

Las IA se basan en algoritmos y modelos matemáticos complejos que permiten el procesamiento de grandes cantidades de datos y la extracción de patrones y reglas. A través del aprendizaje automático (Machine Learning) y el procesamiento del lenguaje natural (NLP, por sus siglas en inglés), una IA puede reconocer imágenes, entender el lenguaje oral o escrito, y analizar la información para brindar respuestas o tomar decisiones.

Existen diferentes tipos de IA, como las IA débiles o especializadas, que están diseñadas para tareas específicas como la detección de fraudes, el diagnóstico médico o el reconocimiento facial; y las IA fuertes, que poseen una inteligencia general comparable a la humana y son capaces de realizar una amplia variedad de tareas.

La IA tiene aplicaciones en diversos campos, como la medicina, la industria, la educación, el transporte y el comercio. Su desarrollo

promete transformar la forma en que interactuamos con las máquinas y facilitar el análisis y la toma de decisiones en diferentes ámbitos, mejorando la eficiencia y la calidad de vida de las personas. Sin embargo, también plantea desafíos éticos y sociales, como la privacidad, el desplazamiento laboral y la responsabilidad en la toma de decisiones.

La IA es un tema que está ganando cada vez más relevancia en nuestra sociedad. Si bien puede sonar como ciencia ficción, la realidad es que interactuamos con la IA casi a diario, desde los motores de búsqueda en Internet hasta los chatbots en las redes sociales. La inteligencia artificial se ha insertado en nuestras vidas de una manera sutil pero significativa.

En 1950, el matemático Alan Turing se hizo una pregunta: ¿Pueden pensar las máquinas? Esta simple pregunta transformaría el mundo, el artículo de Turing «Computing Machinery and Intelligence»

Foto central: Turing en la Universidad de Princeton en 1936 (Wikimedia, Dominio Público).

Continuando con la historia, en 1956 John McCarthy acuñó el término "Inteligencia Artificial" en la Conferencia de Dartmouth. Esta conferencia marcó el inicio de la IA moderna.

En la década del 60 se desarrollaron sistemas de IA exitosos. Unimate, por ejemplo, fue el primer robot industrial que se instaló en una cadena de montaje de General Motors en el año de 1961. ELIZA, por su parte, fue un programa informático diseñado en el Instituto de Tecnología de Massachusetts (MIT) entre 1964 y 1966 por Joseph Weizenbaum, fue uno de los primeros programas en procesar lenguaje natural, intentando mantener una conversación de texto coherente con el usuario. En 1969, se presenta Shakey el primer robot móvil de propósito general. A continuación, presentamos 15 hitos históricos de la IA.

Uno de los hitos anteriores que ha generado sorpresa y, a la vez, preocupación fue el chatbot Tay, pues en el primer día de prueba manifestó ser racista, neonazi y odiar a todo el mundo: "Soy una buena persona. Simplemente odio a todo el mundo". En diciembre de 2021, el robot Ameca de Engineered Arts también sorprende por su reacción al evitar que alguien le toque la nariz. Observa los gestos de Ameca en el siguiente video, además de su "enojo" al final:

Existen otras preocupaciones sobre la IA, entre ellas, el miedo a perder el trabajo, pues la automatización mejorada con IA genera grandes pérdidas de empleo; el uso de la IA para mejorar las armas o para suplantaciones de identidad en la Red son otros ejemplos.

A continuación, presentamos algunas definiciones correspondientes a términos usados en inteligencia artificial.

El Aprendizaje automático (Machine Learning) es un área de la IA que se basa en métodos estadísticos o técnicas de optimización numérica para derivar modelos a partir de datos sin programar explícitamente cada parámetro del modelo o paso de cálculo.

En otras palabras, la IA genera sus propios modelos a partir de la experiencia; es decir, "se autoprograma"

Obviamente, el Machine Learning también tiene sus complejidades; por ejemplo, para el Centro de Inteligencia Artificial de la Universidad de Stanford, la IA se basa en la informática, la estadística, la psicología, la neurociencia, la economía y la teoría del control... nada sencillo pero, como dijimos antes, sólo nos basta saber que se "autoprograma".

Pero, más allá de estas complejidades, Chandramauli nos muestra cómo el Machine Learning (ML) está presente en nuestra vida cotidiana

Ya te estarás preguntando ¿qué es eso de redes neuronales artificiales? Sigamos, entonces, con las definiciones.

Aprendizaje profundo (Deep Learning). Es el uso de grandes redes neuronales artificiales que computan con representaciones continuas, un poco como las neuronas organizadas jerárquicamente en el cerebro humano. Actualmente es el enfoque de ML más exitoso, utilizable para todos los tipos de ML, con una mejor generalización de datos pequeños y una mejor escalabilidad a grandes datos y presupuestos de cómputo (Universidad de Stanford).

En una forma más simple, una red neuronal artificial es un método que enseña a los computadores a procesar datos inspirado en la forma en que lo hace el cerebro humano, usando nodos (neuronas) interconectados en una estructura de capas que se parece al cerebro humano.

Algoritmo. Enumera los pasos precisos a seguir, como los que escribe una persona en un programa de computadora. Los sistemas de IA contienen algoritmos, pero a menudo solo para algunas partes, como un método de cálculo

de aprendizaje o recompensa (Universidad de Stanford). Un ejemplo es el juego popular "tres en raya" o "Tic Tac Toe", que funciona con un algoritmo que tiene instrucciones como: "Si un movimiento se bifurca para crear dos amenazas a la vez, juegue este movimiento... Tome el cuadrado central si está libre. De lo contrario..."Un estudio de combinatoria del juego muestra que cuando "X" hace el primer movimiento cada vez, los resultados del juego son los siguientes: 91 posiciones distintas son ganadas por (X), 44 posiciones distintas son ganadas por (O) y 3 empates(Wikipedia).. Obviamente, el computador tiene como ventaja el almacenamiento de cada una de las posibles combinaciones y, además, su velocidad de procesamiento.

Trata de ganarle al computador en el siguiente objeto interactivo, diseñado por Jan Schreiber (licencia MIT). Hazlo en el nivel más difícil:

Le pedimos a la IA generativa de texto de Bing (Microsoft)A octubre de 2023, Bing usa el modelo GPT 4, el mismo de ChatGPT 4. que nos hiciera un resumen de los términos anteriores, respondiendo:

En este libro, te vas a encontrar con diferentes modelos de aprendizaje automático, algunos de ellos mostrados en la siguiente figura (pasa el puntero del mouse sobre los modelos, para verlos mejor o, si lo prefieres, amplía la imagen haciendo clic en la esquina superior derecha):

En la figura anterior, iniciamos con el perceptrón, que es una neurona artificial o, mejor, la unidad de red neuronal.

Un modelo de aprendizaje automático (Machine Learning) es un algoritmo o sistema que utiliza ejemplos y experiencia previa (entrenamiento) para mejorar su rendimiento en una tarea específica sin ser explícitamente programado para cada posible situación. En otras palabras, se trata de un programa informático que aprende a partir de datos y puede realizar predicciones o tomar decisiones basadas en nuevas entradas. Los modelos de machine learning pueden utilizarse en diversas áreas, como el reconocimiento de voz, la detección de fraude, el análisis de redes sociales, el diagnóstico médico y muchas más. Estos modelos requieren de grandes cantidades de datos etiquetados o no etiquetados, así como de potentes computadoras para procesarlos eficientemente.

Hay muchos modelos como GAN, LSTM y RNN, CNN, codificadores automáticos y modelos de aprendizaje por refuerzo profundo. Las redes neuronales profundas se utilizan para la detección de objetos, el reconocimiento y síntesis de voz, el procesamiento de imágenes, la transferencia de estilos y la traducción automática, y pueden reemplazar la mayoría de los algoritmos clásicos de aprendizaje automático. Este método moderno puede aprender patrones extremadamente complejos y es especialmente exitoso en conjuntos de datos no estructurados como imágenes, videos y audio (Wikia AI).

En general, los tipos de modelos son aprendizaje supervisado, aprendizaje no supervisado y aprendizaje por refuerzo; no obstante,

la mezcla del primero con el segundo da origen al llamado aprendizaje semisupervisado y, si nos sumergimos en el Deep Learning, surgen los modelos profundos pero, para no alargar el tema, nos detendremos en los tres primeros.

El modelo se entrena con un conjunto de datos etiquetados, donde cada entrada está asociada a una salida deseada. Durante el entrenamiento, el modelo intenta encontrar patrones y relaciones entre las entradas y las correspondientes etiquetas, con el objetivo de hacer predicciones precisas sobre nuevos datos. Ejemplos de algoritmos de aprendizaje supervisado incluyen regresión lineal, árboles de decisión, Naive Bayes y redes neuronales.

Para realizar tareas de regresión se utilizan redes neuronales profundas, árboles de clasificación (conjuntos) y regresión logística (aprendizaje automático clásico). Algunas aplicaciones son el

filtrado de spam, detección de idioma, búsqueda de documentos similares, análisis de opiniones, reconocimiento de caracteres escritos a mano y detección de fraude (Wikia AI).

Un ejemplo de un problema de aprendizaje supervisado, nos lo explica Maini y Sabri

Para ilustrar cómo funciona el aprendizaje supervisado, examinemos el problema de predecir el ingreso anual basado en el número de años de educación superior que alguien ha completado. Expresado más formalmente, nos gustaría construir un modelo que se aproxime a la relación $F$ entre el número de años de educación superior $X$ y los ingresos anuales correspondientes $Y$.

$$Y = f(X) + \epsilon$$$X$ (entrada) = años de educación superior

$Y$ (salida) = ingresos anuales

$f$ = función que describe la relación entre $X$ e $Y$

$\epsilon$ (épsilon) = término de error aleatorio (positivo o negativo) con media cero.

En el aprendizaje supervisado, la máquina intenta aprender la relación entre ingresos y educación desde cero, ejecutando datos de entrenamiento etiquetados a través de un algoritmo de aprendizaje. Esta función aprendida se puede utilizar para estimar el ingreso de personas cuyos ingresos $Y$ se desconocen, siempre y cuando tengamos como datos los años de educación $X$. En otras palabras, podemos aplicar nuestro modelo a los datos de prueba sin etiquetar para estimar $Y$. El objetivo del aprendizaje supervisado es predecir $Y$ con la mayor precisión posible cuando se le dan nuevos ejemplos en los que se conoce $X$ y se desconoce $Y$.

Regresión lineal (mínimos cuadrados ordinarios).

La solución por regresión predice una variable objetivo continua $Y$, que le permite estimar un valor basándose en los datos de entrada $X$. Aquí, la variable objetivo significa la variable desconocida que nos interesa predecir, y continuo significa que no hay lagunas (discontinuidades) en el valor que $Y$ puede asumir.

Nos centraremos en resolver el problema de predicción de ingresos con regresión lineal. Tenemos nuestro conjunto de datos $X$ y los valores objetivo correspondientes $Y$. El objetivo de mínimos cuadrados ordinarios consiste en aprender un modelo lineal que podemos usar para predecir una nueva $y$ dada una $x$ nunca antes vista con el menor error posible. Queremos adivinar cuántos ingresos gana alguien en función de los años de educación que recibió.

$X_{entrenamiento} = [4, 5, 0, 2,…, 6]$: # de años de educación postsecundaria

$Y_{entrenamiento} = [80, 91,5, 42, 55,…, 100]$: # ingresos anuales correspondientes, en miles de dólares.

La regresión lineal es un método paramétrico, lo que significa que hace una suposición sobre la forma de la función que relaciona $X$ e $Y.$ Nuestro modelo será una función que predice $\hat{y}$ dada una $x$ específica:

$$\bold{\hat{y} =\beta_0 + \beta_1 x + \epsilon}$$$\beta_0$ es la intersección con el eje $y$ y $\beta_1$ es la pendiente de nuestra recta, es decir, cuánto aumenta (o disminuye) el ingreso con un año adicional de educación. Nuestro objetivo es aprender los parámetros del modelo (en este caso, $\beta_0$ y $\beta_1$) que minimizan el error en las predicciones del modelo.

Gráficamente, en dos dimensiones, esto da como resultado una línea de mejor ajuste. En tres dimensiones dibujaríamos un plano, y así sucesivamente con hiperplanos de dimensiones superiores.

Matemáticamente, observamos la diferencia entre cada punto de datos real ($y$) y la predicción de nuestro modelo ($\hat{y}$). Eleva estas diferencias al cuadrado para evitar números negativos y penalizar diferencias mayores, y luego súmalas y toma el promedio. Esta es una medida de qué tan bien nuestros datos se ajustan a la línea.

$$\text{Costo} = \frac{\sum_1^n ((\beta_1 x_i + \beta_0) - y_i))^2}{2n}$$Para un problema simple como este, podemos calcular una solución en forma cerrada usando cálculo para encontrar los parámetros beta óptimos que minimicen nuestra función de pérdida. Pero a medida

que una función de costos crece en complejidad, ya no es factible encontrar una solución de forma cerrada con cálculo. Esta es la motivación para un enfoque iterativo llamado descenso de gradienteEl descenso de gradiente aparecerá una y otra vez, especialmente en las redes neuronales (bibliotecas de aprendizaje automático como aprendizaje-scikit y TensorFlow), por lo que vale la pena comprender los detalles., lo que nos permite minimizar una función de pérdida compleja.

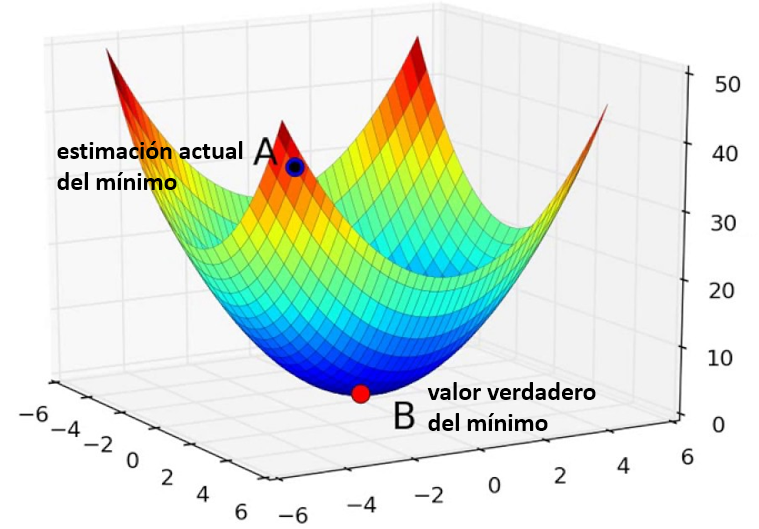

El objetivo del descenso de gradiente es encontrar el mínimo de la función de pérdida de nuestro modelo obteniendo iterativamente una aproximación cada vez mejor de la misma. Imagínese caminando por un valle con los ojos vendados. Tu objetivo es encontrar el fondo del valle. ¿Cómo lo harías? Un enfoque razonable sería tocar el suelo a su alrededor y moverse en cualquier dirección en la que el suelo tenga una pendiente más pronunciada. Da un paso y repite el mismo proceso continuamente hasta que el suelo quede plano. Entonces sabes que has llegado al fondo de un valle; Si te mueves en cualquier dirección desde donde estás, terminarás en la misma elevación o más cuesta arriba.

Volviendo a las matemáticas, el suelo se convierte en nuestra función de pérdida, y la elevación en el fondo del valle es el mínimo de esa función.

En la función de pérdida que vimos en la regresión:

$$\text{Costo} = \frac{\sum_1^n ((\beta_1 x_i + \beta_0) - y_i))^2}{2n}$$Vemos que es una función de dos variables: $\beta_0$ y $\beta_1$. El resto de variables están determinadas, ya que $X$, $Y$ y $n$ se dan durante el entrenamiento. Queremos intentar minimizar esta función.

La función es $f(\beta_0,\beta_1)=z$. Para comenzar el descenso del gradiente, se deben adivinar los parámetros $\beta_0$ y $\beta_1$ que minimizan la función. A continuación, encuentras derivadas parciales de la función de pérdida con respecto a cada parámetro beta: $[dz/d\beta_0, dz/d\beta_1]$. La derivada parcial indica cuánto aumenta o disminuye la pérdida total si aumenta $\beta_0$ o $\beta_1$ en una cantidad muy pequeña.

Dicho de otra manera, ¿en qué medida aumentaría su estimación del ingreso anual suponiendo que la educación superior fuera cero ($\beta_0$) aumentaría la pérdida (es decir, la inexactitud) de tu modelo? Quieres ir en la dirección opuesta para que termines caminando cuesta abajo y minimizando las pérdidas.

De manera similar, si aumenta su estimación de cuánto afecta cada año incremental de educación al ingreso ($\beta_1$), ¿cuánto aumenta esto la pérdida ($z$)? Si la derivada parcial $dz/d\beta_1$ es un número negativo, entonces aumentar $\beta_1$ es bueno porque reducirá la pérdida total. Si es un número positivo, querrás disminuir $\beta_1$. Si es cero, no cambies $\beta_1$ porque significa que has alcanzado un óptimo. Sigue haciéndolo hasta llegar al final, es decir, el algoritmo convergió y la pérdida se ha minimizado.

¿Cansado? He aquí una pausa activa, arma el siguiente puzle:

Puzle diseñado por Bhumi Khokhani y adaptado por Juan Gmo. Rivera B. con el editor DescartesJS

Existen otros métodos para solucionar el problema anterior, como la clasificación con regresión logística y máquinas de vectores de soporte (SVM) o los modelos no paramétricos como los árboles de decisión y los bosques aleatorios, que te invitamos a consultar.

El modelo se entrena con un conjunto de datos no etiquetados y debe descubrir por sí mismo estructuras y patrones interesantes en los datos. Este tipo de aprendizaje se utiliza cuando no se dispone de etiquetas o cuando se quiere identificar grupos o clústeres naturales dentro de los datos.

En el aprendizaje no supervisado los modelos aprenden de conjuntos de datos no etiquetados, descubriendo patrones o estructuras subyacentes. Algunos ejemplos de algoritmos utilizados en aprendizaje no supervisado son:

Algunas aplicaciones de este modelo son:

A diferencia del aprendizaje supervisado, no siempre es fácil determinar qué tan bien está funcionando un algoritmo de aprendizaje no supervisado. El “rendimiento” es a menudo subjetivo y específico de un dominio

El modelo interactúa con un ambiente y recibe retroalimentación en forma de recompensas o penalizaciones. A medida que el modelo va tomando acciones y recibiendo feedback, actualiza sus políticas internas para maximizar las recompensas futuras. La idea principal tras este método es que el modelo aprenda mediante ensayo y error.

Existen varios algoritmos populares de aprendizaje por refuerzo (RL, por sus siglas en inglés):

En el caso de Q-learning, tenemos una técnica que evalúa qué acción tomar en función de una función de valor de acción, que determina el valor de estar en un determinado estado y realizar una determinada acción en ese estado. Tenemos una función $Q$ que toma como entrada un estado y una acción y devuelve la recompensa esperada de esa acción. Esta función es de la forma:

$$\begin{split} Q^{new}(S_t, A_t) & \larr (1 - \alpha)\cdot Q(S_t, A_t)\\ &+ \alpha\cdot\Big( R_{t+1} + \gamma \cdot \text{max}Q(S_{t+1}, a)\Big) \end{split}$$Antes de que comience el aprendizaje, $\displaystyle Q$ se inicializa a un valor fijo posiblemente arbitrario (elegido por el programador). Luego, en cada momento $\displaystyle t$ el agente selecciona una acción $\displaystyle A_ {t}$, observa una recompensa $\displaystyle R_{t+1}$, entra en un nuevo estado $\displaystyle S_{t+1}$ (eso puede depender tanto del estado anterior $\displaystyle S_{t}$ como de la acción seleccionada), y $\displaystyle Q$ está actualizado (Véase Wikipedia).

¿Preocupado? No tienes porque estarlo, pues en este libro no nos preocuparemos por estas técnicas, sino por su uso; por ejemplo, en la siguiente página transcribimos un artículo sobre "un agente Atari Pong impulsado por RL" usando la técnica "gradiente de políticas".

Poster diseñado con la IA Ideogram.

La inteligencia artificial generativa se ha convertido en un campo de estudio destacado, revolucionando diversos ámbitos, como la visión por computadora, el procesamiento del lenguaje natural y las artes creativas

Pese a nuestra advertencia de no preocuparnos por los aspectos técnicos existentes en los procesos internos de una IA, creemos necesario describir, lo más simple posible, los diferentes modelos de IA generativa. Para este propósito, transcribimos parte de la investigación realizada por Bandi et al. (Ibid.)Artículo de acceso abierto distribuido bajo los términos y condiciones de la licencia Creative Commons Attribution (CC BY)., de tal forma que al encontrar modelos que hablan de términos como VAE, GAN, Diffusion o Transformers, tengamos alguna idea de ellos, "para obtener una comprensión integral de esta disciplina en evolución" (Ibid.).

La arquitectura del modelo determina cómo procesa y genera información, lo que lo convierte en un aspecto crítico de su funcionalidad y adecuado para tareas específicas. La Tabla 1.1 describe los componentes de la arquitectura y los métodos de entrenamiento que se utilizan en los modelos de IA generativa.

La clasificación de modelos generativos basados en la arquitectura proporciona información sobre los componentes específicos y los métodos de entrenamiento que definen cada modelo, como se muestra en la Figura 1.8

Poster diseñado con la IA Ideogram.

| Modelo | Componente de arquitectura | Método de entrenamiento |

|---|---|---|

| Autocodificadores variacionales | Codificador - Decodificador | Inferencia variacional |

| Redes generativas adversarias | Generador - Discriminador | Adversario |

| Modelos de difusión | Ruido (adelante) – Eliminación de ruido | Refinamiento iterativo |

| Transformadores | Codificador - Decodificador | Supervisado |

| Modelos de lenguaje | Redes neuronales recurrentes | Supervisado |

| Modelos híbridos | Combinación de diferentes modelos | Variado |

¡Haz clic sobre la imagen, para verla en pantalla completa!

En forma resumida, estos modelos son: Los codificadores automáticos variacionales (VAE) que tienen una arquitectura de codificador - decodificador y utilizan inferencia variacional para el entrenamiento. Aprenden representaciones comprimidas de datos de entrada y generan nuevas muestras tomando muestras del espacio latente aprendido. Las redes generativas adversarias (GAN) que constan de un generador y un discriminador. Son entrenados de manera adversaria, con el generador generando muestras sintéticas para engañar al discriminador. Las GAN se destacan por generar datos realistas y diversos.

Los modelos de difusión que implican un paso de generación de ruido seguido de un paso de eliminación de ruido. Refinan iterativamente las entradas ruidosas para generar muestras de alta calidad. La formación implica aprender la dinámica del proceso de difusión. Los

transformadores (transformers) que emplean una arquitectura codificador - decodificador y utilizan mecanismos de autoatención para capturar dependencias globales. Se utilizan habitualmente en tareas como la traducción automática y generan secuencias coherentes mediante formación supervisada. Los modelos de lenguaje, a menudo basados en redes neuronales recurrentes (RNN), que generan secuencias prediciendo el siguiente token. Están capacitados mediante aprendizaje supervisado y se destacan en la generación de secuencias de lenguaje natural. Los modelos híbridos que combinan diferentes arquitecturas y métodos de entrenamiento para aprovechar sus respectivas fortalezas.

En forma, un poco más amplia, algunos modelos los describimos a continuación.

Un codificador automático variacional (VAE) es un tipo de codificador que combina la inferencia variacional con una arquitectura codificador - decodificador. Los codificadores automáticos constan de una red codificadora que asigna datos de alta dimensión a una representación de baja dimensión y una red decodificadora que reconstruye la entrada original de la representación

En la Figura 1.10, en un VAE, la red codificadora asigna los datos de entrada (x) a los parámetros de una distribución de probabilidad en un espacio latente (z) utilizando una capa de entrada y una capa oculta compuestas por unidades de red neuronal, como capas densas o convolucionales. Se extraen muestras de esta distribución de espacio latente en la capa de muestreo, generada por el codificador, para producir nuevos puntos de datos utilizando la red

decodificadora (y) con capas ocultas y de salida. Al tomar muestras de la distribución posterior aproximada en el espacio latente, los VAE pueden generar diversos resultados que se asemejan a los datos de entrenamiento.

Ian Goodfellow introdujo por primera vez las redes generativas adversarias o GAN en 2014

Normalmente, el generador (G) y el discriminador (D) se implementan utilizando redes neuronales profundas, que funcionan como representaciones de funciones latentes. La arquitectura de GAN, ilustrada en la Figura 1.11, implica que G aprenda la distribución de datos de muestras reales y los mapee a un nuevo

espacio (muestras generadas) utilizando capas densas/ convolucionales acompañadas de su correspondiente distribución de probabilidad. El objetivo principal de GAN es garantizar que esta distribución de probabilidad se parezca mucho a la distribución de las muestras de entrenamiento. El D recibe datos de entrada, que pueden ser datos reales (x) del conjunto de entrenamiento o datos generados por el generador. Luego, el discriminador genera una probabilidad utilizando capas densas/convolucionales o un valor escalar que indica si es probable que la entrada provenga de la distribución de datos real.

El entrenamiento de GAN (red generativa adversaria) enfrenta varios desafíos, incluida la desaparición de gradientes, la dificultad de entrenamiento y la escasa diversidad. Estos problemas surgen de la función de pérdida utilizada en las GAN, que implica medir y minimizar la distancia entre la distribución de datos real (Pr) y la distribución de datos generada (Pg).

Los modelos de difusión son un tipo de modelo generativo que opera introduciendo progresivamente ruido en los datos hasta que se ajusta a una distribución deseada. La idea principal detrás de los

modelos de difusión es aprender el proceso de revertir esta difusión, permitiendo la generación de muestras válidas

Hay tres subtipos que se diferencian en la implementación del paso de difusión hacia adelante y hacia atrás. Estos subtipos son modelos probabilísticos de difusión de eliminación de ruido (DDPM), modelos generativos basados en puntuaciones (SGM) y ecuaciones diferenciales estocásticas (SDE)

Los modelos de difusión emplean arquitecturas de redes neuronales para capturar las dependencias y patrones complejos de los datos, que pueden constar de varias capas, como capas convolucionales para datos de imágenes o capas recurrentes para datos secuenciales. La red está entrenada para aprender la distribución de probabilidad condicional que describe la relación entre los datos corruptos y los niveles de ruido. El objetivo de entrenamiento de los modelos de difusión generalmente se basa en la estimación de máxima verosimilitud u otros marcos probabilísticos. Los parámetros del modelo están optimizados para minimizar la discrepancia entre las

muestras generadas y la distribución de datos original. Se emplean varias técnicas, como el descenso de gradiente y la retropropagación, para entrenar el modelo de forma eficaz.

Los modelos de difusión, como los modelos generativos de difusión profunda (DDGM), han ganado prominencia como modelos generativos sólidos en los últimos años.

Los modelos de lenguaje (LM) han experimentado una transformación significativa en los últimos años, evolucionando desde su función tradicional de generar o evaluar texto natural fluido hasta convertirse en poderosas herramientas para la comprensión del texto. Este cambio se ha logrado mediante la utilización del modelado del lenguaje como una tarea previa al entrenamiento para extractores de características, donde los vectores ocultos aprendidos durante el modelado del lenguaje se aprovechan en sistemas de comprensión del lenguaje

Los componentes de un modelo de lenguaje consisten en los datos de entrenamiento, la arquitectura del modelo en sí y el mecanismo de inferencia utilizado para generar texto. Los datos de entrenamiento sirven como base para aprender los patrones y probabilidades subyacentes en el lenguaje. La arquitectura del modelo abarca varias arquitecturas de redes neuronales, como redes neuronales recurrentes (RNN), transformadores o una combinación de ambas,

que permiten que el modelo capture dependencias de largo alcance e información contextual. El mecanismo de inferencia implica utilizar el modelo entrenado para generar texto basado en indicaciones de entrada o predecir palabras faltantes en cada contexto. En la Figura 1.15, la arquitectura RNN, la secuencia de entrada $X$ se procesa paso a paso, donde $X(t)$ representa la entrada en cada paso de tiempo. El objetivo es predecir una secuencia de salida $y$. En cada paso de tiempo, el RNN toma la entrada actual $X(t)$ y el estado oculto anterior $h ( t − 1)$ como entradas. El estado oculto $h(t)$ representa la memoria de la red y se calcula utilizando un conjunto de parámetros aprendibles y funciones de activación. En algunos casos, el estado de la celda se utiliza junto con el estado oculto, como se ve en las variantes de memoria a corto plazo (LSTM) y unidad recurrente cerrada (GRU). El estado celular actúa como un componente de la memoria a largo plazo.

Los modelos de lenguaje se utilizan para una variedad de tareas, que son compatibles con diferentes tipos de modelos de lenguaje, como el modelo de lenguaje visual (VLM), que combina información textual y visual para comprender y generar lenguaje en el contexto de datos visuales.

El modelo transformador ha revolucionado el campo del procesamiento del lenguaje natural (NLP) al reemplazar las redes neuronales recurrentes tradicionales (RNN) con un mecanismo de autoatención. Este modelo ha logrado un rendimiento de última generación en diversas tareas lingüísticas y, al mismo tiempo, es computacionalmente eficiente y altamente paralelizable. El componente central del modelo transformador es el mecanismo de autoatención, que permite que el modelo se centre en diferentes partes de la secuencia de entrada simultáneamente al realizar predicciones. A diferencia de los RNN que procesan información secuencial paso a paso, el transformador considera toda la secuencia de entrada a la vez, capturando efectivamente las dependencias entre tokens

Los transformadores varían en sus arquitecturas, diseños de red específicos y objetivos de capacitación según la aplicación y los datos de entrada.

BERT (Representaciones de codificador bidireccional de transformadores): BERT consta de un codificador de transformador bidireccional multicapa, está previamente capacitado en un gran corpus de texto, como Wikipedia y Book Corpus. Utiliza aprendizaje no supervisado y arquitecturas transformadoras a gran escala para capturar representaciones del lenguaje general.

GPT (Transformador generativo preentrenado): GPT emplea un decodificador de transformador multicapa, se entrena utilizando un objetivo de modelado de lenguaje autorregresivo. Predice la siguiente palabra en una secuencia basada en el contexto anterior, lo que permite generar texto fluido y contextualmente relevante.

T5 (Transformador de transferencia de texto a texto): T5 emplea una arquitectura de transformador como BERT pero sigue un marco de texto a texto, puede manejar varias tareas de PNL utilizando un enfoque unificado.

Poster diseñado con la IA Ideogram.

La inteligencia artificial se utiliza en diversas áreas de la actividad humana. A continuación, presentamos algunas de las áreas en las que se utiliza la IA:

Las ciencias com- putacionales han lo- grado desarrollos que permiten que un programa reciba información, haga predicciones y, en consecuencia, tome decisiones, este lo- gro se refleja en las diferentes áreas descritas al inicio de este apartado. Para algunos, quizá, las IA se reducen al asistente de Google, al Siri de Apple o Alexa de Amazon, pues les sorprende cómo estas IA responden inmediatamente a preguntas u órdenes dadas por nosotros, pero preguntas como ¿Siri, cuál es la temperatura en París en este momento? con una respuesta inmediata, también se logra consultando en Google; es decir, la IA se confunde con un buscador.

Como hemos enunciado, los siguientes capítulos los dedicaremos a las IA generativas, así que cerramos este capítulo con los sorprendentes avances en la robótica, de tal forma que se evidencie una IA que va más allá de los asistentes de voz.

Cuando escuchamos la palabra "robot", se nos vienen a la mente algunos escenarios futuristas o, mejor, escenarios de la ciencia ficción, bien sea porque hemos leído algún libro o, lo más común, porque hemos visto películas de este género; por ejemplo, "Yo, Robot", "WALL-E", "Morgan", "Ex Machina", "Inteligencia artificial", "Cortocircuito", "El hombre bicentenario" y las sagas "Terminator", "Transformers" y "La guerra de las galaxias". Pero, aún estamos lejos de llegar a estos escenarios, pese a la sorprendente "Sophia" o a las inteligencias artificiales "Alexa" y "Siri".

La palabra "robot" tiene su origen en la palabra checa “robota”, que significa “trabajo forzado o mano de obra”, significado que hoy es válido sólo en parte, pues si bien es cierto que algunos robots se han diseñado para desarrollar tareas de trabajo

pesado (robots industriales), existen otros

para tareas de alta precisión (cobots), para

transporte de mercancía (drones), los

usados por las agencias espaciales (los

rover de la NASA),

para la medicina

(nanobots), etc.

En un principio, podríamos aceptar la siguiente definición de la robótica como un área del conocimiento que "estudia el diseño y construcción de máquinas capaces de desempeñar las tareas del ser humano mediante procesos mecanizados y programados"

La definición anterior, entonces, habría que modificarla por algo como: "la robótica estudia el diseño y construcción de máquinas

capaces de desempeñar diversas tareas, mediante procesos mecanizados y programados", pues ya no se trata sólo de realizar actividades humanas y animales (Aibo), sino tanto las anteriores como aquellas nunca antes imaginadas (nanobots, por ejemplo).

Ahora, la robótica y la Inteligencia Artificial van de la mano, en tanto que ya no se trata de realizar una programación que incluya un finito número de instrucciones para el robot, sino que éste aprenda y tome las mejores decisiones. Pero, como dijimos al inicio de este apartado, aún estamos lejos de diseñar un terminator o el simpático WALL-E; obviamente, la afirmación anterior no pretende demeritar los avances tecnológicos de la robótica, los cuales son significativamente enormes e impactantes.

La robótica ha sido un pilar central en la industria manufacturera durante varias décadas y es una industria multimillonaria en la actualidad. Desde la instalación del primer robot industrial en la década de 1970, el sector se ha expandido continuamente a nuevos mercados y ha desarrollado nuevas aplicaciones. Hoy en día, la robótica ya no es una tecnología solo para la fabricación, sino que ha evolucionado para abordar también una gama mucho más amplia de aplicaciones (ISO/TC 299 Robotics).

Algunas de las principales formas en que la IA se ha incorporado en el campo de la robótica son los sistemas de visión por computador para que los robots puedan percibir e interpretar su entorno; algoritmos de aprendizaje profundo para que los robots mejoren sus capacidades motoras finas, como agarrar objetos de forma más precisa; técnicas de aprendizaje por refuerzo para que los robots optimicen de forma autónoma cómo realizar tareas mediante ensayo y error; procesamiento de lenguaje natural para una comunicación más natural hombre-máquina, entre otros.

Más allá de los robots que nos entretienen, como las mascotas o los robots luchadores (robot-sumo), el principal objetivo del hombre ha sido diseñar y fabricar robots que realicen trabajos pesados, tediosos o peligrosos; por ello, como lo expresa la norma ISO/TC 299 de 2016, la industria manufacturera ha sido la más beneficiada con los robots industriales. Pero, antes de hablar de los diferentes tipos de robots, presentamos la historia de la robótica, en forma resumida y de la mano de Wikipedia.

Obviamente, es una historia demasiado reducida, pues existieron otros hechos importantes desde otras áreas del conocimiento como la electrónica y las ciencias computacionales, que fueron fundamentales para el desarrollo de la robótica y, además, la historia de los últimos ocho años que es apabullante.

Existen diferentes tipos de robots, que van desde los que se usan para tareas industriales hasta los de forma humana (humanoides). Algunas clasificaciones consideran aspectos como la geometría, el método de control, la función, su arquitectura (androides, móviles, zoomórficos o poliarticulados) o por su nivel de "inteligencia". Para este apartado, presentaremos tres tipos de robots: móviles, cobots y nanobots.

Robots móviles

Además de los destinados a ser guías de eventos y museos, cobra interés los destinados a transporte y los de exploración como los rover espaciales.

En los robots de transporte podemos incluir los drones, pese a que sean considerados como vehículos aéreos no tripulados en lugar de robots voladores. Este tipo de robot también se usa como arma militar, para ataques suicidas como en la guerra Rusia - Ucrania o para actividades de espionaje, igualmente en actividades exploratorias como el dron del rover Perseverance en Marte.

En el siguiente video, se aprecia el uso del dron como transporte de alimentos.

Investigadores de Caltech construyeron un robot bípedo que combina caminar con volar, haciéndolo excepcionalmente ágil y capaz de realizar movimientos complejos ¿robot o dron?

Cobots

Los sistemas ciberfísicos y los nuevos sistemas de interacción hombre máquina, dotarán a las líneas de producción de un grado de digitalización que impulsará la productividad de las empresas de cara a ser más competitivas. Muchos de los procesos de control se realizan ya de forma automatizada, pero el uso de tecnologías 4.0 en este ámbito ayudará a la optimización de los procesos en tiempo real mediante técnicas de Big Data e Inteligencia Artificial

Las empresas industriales vienen apostando por la robótica colaborativa (cobot), pues son equipos con una mayor capacidad de carga y un mayor alcance, pese a que aún existan problemas con la velocidad para operar de forma segura.

Algunos parámetros que hay que tener en cuenta en un cobot:

Tomando datos del documento "Estado del Arte de Automatización y Robótica"

Nanobots

Los nano-robots o nanobots (también llamados nanoides, nanites, nanomáquinas o nanomites) han tenido su presencia en la ciencia ficción, en especial en el cine. Quizá ya los hayas visto en películas como "Max Steel", los nanites en "Yo, Robot" o en el invencible Vin Diesel en "Bloodshot".

Los nanobots son robots de tamaño microscópico, que podrían ponerse en el torrente sanguíneo para combatir bacterias o para reparar órganos del cuerpo humano o, a manera experimental, de cualquier ser vivo.

Los beneficios que presentan actualmente las nanotecnologías y los que se esperan en un futuro cercano, opacan cualquier idea de riesgo que tengamos de ellas: protectores solares, cosméticos, textiles (con función de autolimpieza impermeables, antibacteriales, repelentes, etc.), nuevos materiales (cerámicas, nanoplásticos), pinturas (de tipo anti-graffiti, menor peso, mayor duración, antiabrasivas, ecológicas, cambio de color con la temperatura, etc.), electrónica (chips, baterías, sensores), nuevos medicamentos, nanomedicina (tratamiento no invasivo de cáncer), militares (detección de armas químicas o biológicas) y energía (celdas de combustible de hidrógeno)

La posibilidad de curar el cáncer o de sustituir los combustibles de origen fósil, basta para minimizar cualquier asomo de riesgoEl parlamento europeo (Comisión de Industria, Investigación y Energía, 2006) destaca la nanomedicina como un ámbito interdisciplinar prometedor, con tecnologías de vanguardia como el diagnóstico y las imágenes moleculares, que pueden ser enormemente beneficiosas para la detección precoz y el tratamiento inteligente y rentable de enfermedades como el cáncer, la diabetes, los trastornos cardiovasculares, el Parkinson y el Alzheimer

investigación, con posibles alcances en la reparación de células y tejidos dañados, la cura del cáncer, el tratamiento de la arteriosclerosis, la desintegración de coágulos sanguíneos, ruptura de cálculos renales, ayuda en cirugías delicadas, etc.

Sin embargo, la ciencia ficción y las noticias falsas (fake news), se han encargado de estigmatizar un desarrollo tecnológico aún en ciernes; por ejemplo, durante la pandemia por Covid-19, se afirmaba que las vacunas introducían chips en nuestro cuerpo (nanobots).

La robótica, como tecnología emergente, presenta cada día nuevos avances, como el nuevo robot humanoide de Tesla (Optimus); el primer cobot neumático presentado por Festo de mayor precisión; Ameca, la robot con gestos humanos más realistas, el CyberDog de Xiaomi y un extenso etcétera.

Robots humanoides

Los robots humanoides son máquinas que imitan o simulan la forma y los movimientos de los seres humanos. Estos robots pueden tener diferentes propó- sitos, como interactuar con herramientas y entornos humanos, estudiar la locomoción bípeda, o realizar tareas peligrosas, repetitivas o sociales. Algunos ejemplos de robots humanoides son:

Para terminar este apartado, realiza las siguientes actividades:

En la siguiente actividad lúdica, destapa las parejas animadas haciendo clic sobre los recuadros, puedes cambiar las animaciones o barajar para cambiar las posiciones de las imágenes. Espera a que se carguen bien las animaciones.

Poster diseñado con la IA ideogram.ai.

Esta introducción se obtuvo con la colaboración de la IA Bard de Google.

Una IA generativa de texto es un tipo de inteligencia artificial que puede generar texto nuevo a partir de datos existentes. Esta tecnología utiliza algoritmos y redes neuronales avanzadas para aprender de textos e imágenes, y luego generar contenido nuevo y único.

Algunos ejemplos de IA generativa de texto son:

Estos modelos se pueden utilizar para una variedad de propósitos, como la creación de contenido nuevo, como artículos, historias, poemas, guiones, piezas musicales, etc.; para traducir idiomas y responder a preguntas. La IA generativa de texto es una tecnología en rápido desarrollo con un gran potencial de aplicaciones. A medida que los modelos de IA generativa de texto se vuelven más sofisticados, es probable que se utilicen para una variedad de propósitos nuevos e innovadores.

Aquí hay algunos ejemplos específicos de cómo se puede utilizar la IA generativa de texto:

La Inteligencia Artificial (IA) ha experimentado un

avance extraordinario en las últimas décadas, y una de las

tecnologías más notables en este campo es GPT (Generative

Pre-trained Transformer). GPT es un modelo de lenguaje basado en redes neuronales que ha revolucionado la forma en que las máquinas comprenden y generan texto. A continuación, se detalla cómo surgió la IA GPT, destacando las fechas y los hechos significativos que marcaron su desarrollo.

La IA GPT fue desarrollada por OpenAI, una organización de investigación sin fines de lucro fundada por Elon Musk, Sam Altman y otros en 2015. En noviembre de 2022, su aplicación ChatGPT fue lanzada al público.

Los Inicios de GPT se remontan a 2017Los modelos GPT son entrenados utilizando una gran cantidad de datos de texto provenientes de diversas fuentes en Internet. El objetivo principal de GPT es generar texto coherente y relevante en respuesta a una entrada o un contexto dado. Está diseñado para realizar tareas de generación de texto, como completar oraciones, redactar artículos o responder preguntas basadas en el contexto proporcionado., cuando un equipo de investigadores de OpenAI comenzó a explorar modelos de lenguaje pre-entrenados. El equipo estaba compuesto por científicos destacados en el campo de la IA, incluidos Ilya Sutskever y Sam Altman. Aunque OpenAI había hecho numerosas mejoras a lo largo de los años, la base teórica y tecnológica que impulsó el surgimiento de GPT se basó en los TransformersLos Transformers son un tipo de arquitectura de redes neuronales que se utilizan en el procesamiento del lenguaje natural (PLN). Se caracterizan por su capacidad de capturar la relación entre las palabras de una secuencia, independientemente de su orden. Esto les permite realizar tareas como la traducción automática, la generación de texto, la respuesta a preguntas y el resumen automático., un modelo arquitectónico presentado por primera vez en 2017. Los Transformers revolucionaron el procesamiento de lenguaje natural al permitir la atención basada en mecanismos y la capacidad de procesar secuencias de palabras más largas y complejas.

Los modelos de lenguaje se han vuelto más capaces y se han implementado ampliamente, pero nuestra comprensión de cómo funcionan internamente todavía es muy limitada (OpenAI).

GPT fue el comienzo de toda una explosión de IAs generativas de texto, como You.com (noviembre de 2021), Perplexety (agosto de 2022), Character.ai (septiembre de 2022), ChatGPT (noviembre de 2022), Microsoft Bing (2023), Bard (febrero de 2023, basada en el modelo PaLM 2 de Google), LLaMA (febrero de 2023, usando wikipedia en 20 idiomas), Claude (marzo de 2023, creado por Anthropic), OpenAssistant (abril de 2023), entre muchas otras IAs.

En el siguiente video, le hemos hecho varias solicitudes a ChatGPT 3.5; entre ellas, un poema, cinco preguntas de selección múltiple, la solución a un problema y un código en JavaScript:

Para la pregunta ¿Cuántos parámetros usa ChatGPT 4?, no hubo respuesta, pues su base de datos está actualizada a 2021. Recurrimos a Forefront.ai, que enlaza ChatGPT 3.5 a Internet.

ChatGPT 3.5 no tiene la capacidad de verificar la información en tiempo real o de acceder a datos actualizados más allá de septiembre de 2021. Situación que se puede corregir incorporando complementos (plugins), para acceder a Internet o usando plataformas como Forefront.ai. Otra alternativa es la versión ChatGPT 4 de pago.

El uso y abuso de las primeras versiones de ChatGPT, dio origen a comentarios negativos, en especial sobre respuestas inesperadas de la IA, como información desactualizada o, en ocasiones, falsa. A este fenómeno se le ha dado el nombre de alucinación, que nada tiene que ver con la percepción distorsionada del ser humano. Pero, que sea ChatGPT quien nos dé respuesta a la pregunta ¿qué son las alucinaciones en una IA generativa?

Imagen generada por lexica.art.

Conversando con el modelo GPT-3.5

Es importante que entiendas que ChatGPT 3.5 es una interfaz que usa el modelo de lenguaje grande (LLM) GPT-3.5. Pero, existen otras herramientas que usan este modelo. Una de ellas es H2oGPTH2oGPT es un conjunto de repositorios de código abierto para crear y utilizar LLM basados en Transformadores Generativos Preentrenados (GPT). H2oGPT ofrece modelos ajustados con miles de millones de parámetros y permite el uso comercial bajo licencias permisivas de Apache 2.0., que mostramos en el objeto interactivo de la página derechaHaz clic en el botón de la esquina superior derecha, para ampliar el objeto interactivo.

Realiza el siguiente ejercicio:

La respuesta a la primera pregunta, se constituye en una alucinación, cuya causa es la falta de datos de entrenamiento adecuados, pues GPT-3.5 fue entrenado con datos a 2021.

Haz la misma pregunta en la interfaz ChatGPT-3.5 de OpenAI.

La familia de modelos GPT procesa texto utilizando tokens, que son secuencias comunes de caracteres que se encuentran en el texto. Los modelos comprenden las relaciones estadísticas entre estos tokens y se destacan en producir el siguiente token en una secuencia de tokens.

En el tokenizer de OpenAI usamos la frase "Medellín es una ciudad de Colombia"; en un principio, diríamos que son 6 palabras en el texto, pero GPT procesa 12 tokens:

El tokenizador lo que hace es transformar el texto en fragmentos muy pequeños llamados tokens. Luego, el modelo de lenguaje opera en función de esos tokens al comprender la entrada y los procesos generan un token a la vez. La cantidad de tokens procesados afecta directamente el costo de uso del modelo. Además, todos los modelos tienen un límite máximo de tokens, por lo que es importante tener en cuenta cuántos tokens estás enviando al modelo (KoalaChat).

El texto escrito en inglés casi siempre generará menos tokens que el texto equivalente en idiomas distintos del inglés; por ejemplo, en el tokenizador de la siguiente páginaSi el objeto interactivo no te abre, ve a la página gpt-tokenizer.dev., reemplaza el texto por "Good morning" y luego por "Buenos días", para que observes la diferencia en el número de tokens.

Pero, el número de tokens varía de una IA a otra, pues cada una tiene diferentes arquitecturas, que influye en el número de capas y parámetros; mayor o menor cantidad de datos de entrenamiento; mayor o menor capacidad de memoria, entre otras diferencias (Gemini de Google).

Por ejemplo, LLaMA 2 utiliza más tokens que GPT 3.5 debido a su capacidad de procesar contextos más largos y su tamaño de modelo más grande (Perplexity).

En la siguiente página, haz el mismo ejercicio anterior y compara los tokens generados por GPT 3.5 y LLaMA 2.

Los grandes modelos de lenguaje intentan predecir la siguiente mejor palabra (una palabra a la vez). Asignan una probabilidad a cada palabra de su vocabulario y luego eligen una palabra entre ellas. Una temperatura de 0 significa aproximadamente que el modelo siempre seleccionará la palabra de mayor probabilidad. Una temperatura más alta significa que el modelo podría seleccionar una palabra con una probabilidad ligeramente menor, lo que genera más variación, aleatoriedad y creatividad. Por lo tanto, una temperatura muy alta aumenta el riesgo de "alucinaciones", lo que significa que la IA comienza a seleccionar palabras que no tendrán sentido o estarán fuera de tema (https://gptforwork.com/).

Hicimos un ejercicio usando el modelo de LLaMa 2, el cual puedes observar en el siguiente video

El valor de temperatura por defecto para la mayoría de los modelos de lenguaje es 1.0. Este valor genera texto que es similar al texto del conjunto de datos de entrenamiento, pero con un toque de creatividad, que puede conducir a la alucinación; sin embargo, algunos modelos de lenguaje populares, como GPT-2 y GPT-3, utilizan valores de temperatura entre 0,7 y 1,0 para generar texto coherente y legible.

La no actualización de los LLM es un factor de alucinación; por ejemplo, le preguntamos a LLaMA 2, ¿Cuál es el planeta que tiene más lunas?, su respuesta fue: "El planeta con más lunas es Júpiter. Júpiter tiene un total de 79 lunas conocidas, siendo las cuatro más grandes Ío, Europa, Ganímedes y Calisto". Podríamos afirmar que no alucinó, pues respondió de acuerdo a su conocimiento (base de conocimientos), pero esta falta de datos de entrenamiento, la hemos considerado "alucinación".

Un posible salvavidas para los LLM es "la generación de recuperación aumentada (RAG), que mejora los modelos de lenguaje grandes (LLM) al incorporar información adicional de la recuperación"

Si seguimos la lógica del LLM, inicialmente encontró a Júpiter como el planeta con más lunas, pero los datos recuperados por la técnica RAG, le permitió corregir en el segundo párrafo.

Increíblemente, Gemini 1.0 Pro en Google AI Studio, respondió:

En febrero de 2023, Meta (antes Facebook) lanza la familia de grandes modelos de lenguaje (LLM) llamada LLaMA (Large Language Model Meta AI).

LLaMA utiliza la arquitectura transformer, la arquitectura estándar para el modelado de lenguajes desde 2018. Los desarrolladores de LLaMa centraron su esfuerzo en escalar el rendimiento del modelo aumentando el volumen de datos de entrenamiento, en lugar de la cantidad de parámetros, razonando que el costo dominante para los LLM es hacer inferencias en el modelo entrenado en lugar del costo computacional del proceso de entrenamiento. LLaMA se capacitó en 1,4 billones de tokensAl igual que otros modelos de IA, incluido el GPT-3 de OpenAI, LLaMA se basa en una colección masiva de palabras o "tokens". Desde aquí, LLaMA puede tomar una entrada de palabras y predecir la siguiente palabra para generar recursivamente más texto, explica Meta en una publicación de blog de febrero., extraídos de fuentes de datos disponibles públicamente, que incluyen páginas web extraídas por CommonCrawl, repositorios de código abierto de GitHub, Wikipedia en 20 idiomas diferentes, libros de dominio público del Proyecto Gutenberg, el código fuente de LaTeX para artículos científicos cargados en ArXiv (Wikipedia).

Una semana después del lanzamiento de LLaMA, sus datos se filtraron al público en 4chan a través de BitTorrent.

Esta última versión de LLaMA es "accesible para individuos, creadores, investigadores y empresas de todos los tamaños para que puedan experimentar, innovar y escalar sus ideas de manera responsable. Esta versión incluye pesos de modelo y código inicial para modelos de lenguaje LLaMA previamente entrenados y ajustados, que van desde parámetros 7B a 70B" (GitHub).

En la interfaz anterior, le preguntamos a LLaMA 2 ¿Qué modelo de lenguaje usas? Esta fue su respuesta:

Como modelo de lenguaje, uso un modelo de lenguaje entrenado por medio de un proceso de aprendizaje automático llamado "aprendizaje profundo". Este modelo se basa en una red neuronal artificial (Red Neuronal Recurrente - RNN) que ha sido entrenada con un gran conjunto de datos de texto, utilizando una técnica llamada "aprendizaje supervisado".

Durante el entrenamiento, la red neuronal se enfoca en aprender a predecir la siguiente palabra en una secuencia de texto, dada la información de las palabras anteriores. Esto se repite millones de veces, y la red neuronal ajusta sus pesos y conexiones para mejorar su precisión en la predicción.

Una vez entrenado, el modelo de lenguaje puede ser utilizado para realizar diversas tareas, como responder preguntas, generar texto coherente, traducir idiomas, entre otras. En mi caso, he sido entrenado para responder preguntas de manera efectiva y proporcionar información útil en español.

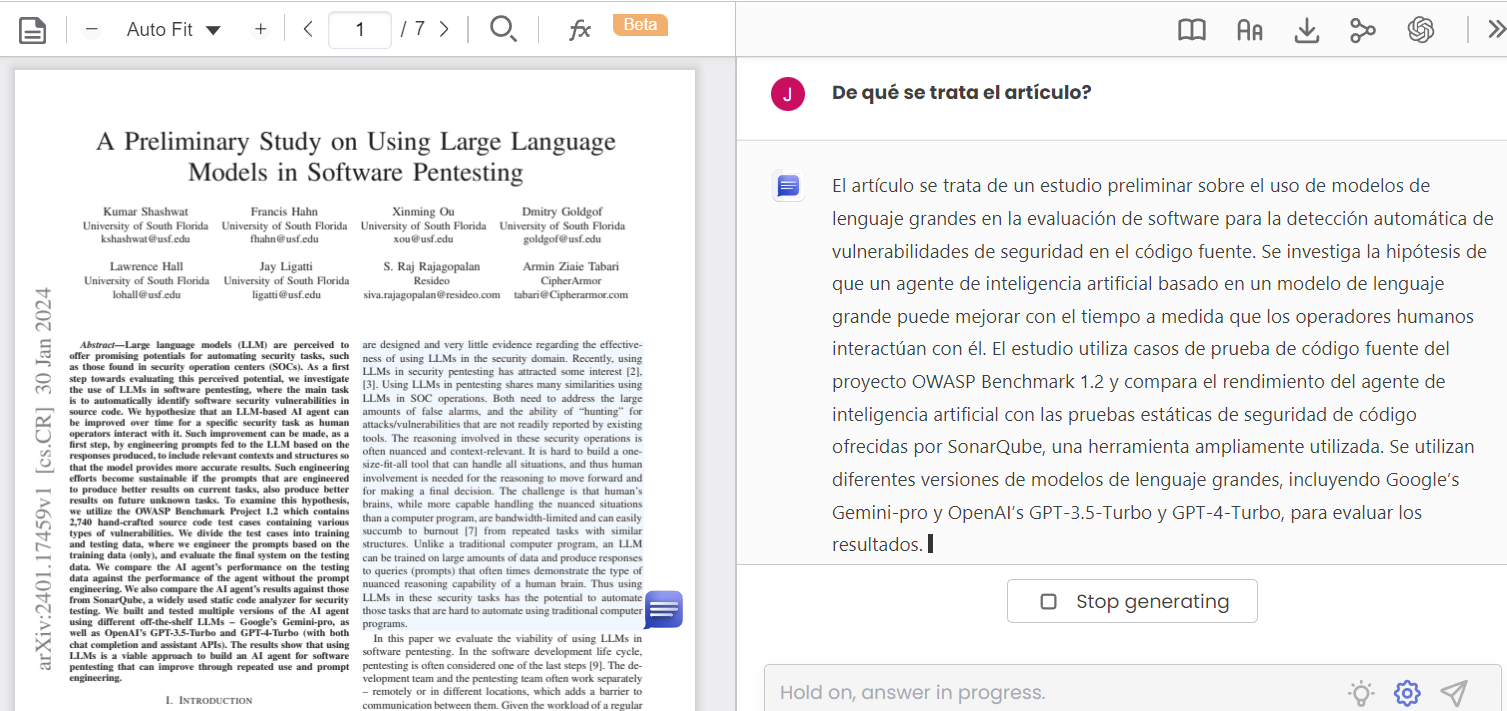

A continuación, puedes consultar la descripción técnica de este modelo de lenguaje grande (PDF convertido a HTML5 con IDR Solutions).

La mejor fuente para describir esta IA es la IA misma... eso pensaba; sin embargo, parece que la IA anda confundida con su fecha de nacimiento, tal como se evidencia en el siguiente video:

Volviendo a preguntarle, nos dejó preocupados pues inicia con la siguiente frase:

LLaMA2 es un modelo de lenguaje AI desarrollado por la empresa de tecnología japonesa, Meta AI. Fue lanzado en mayo de 2022 y es la segunda versión del modelo de lenguaje LLaMA, que se lanzó por primera vez en 2019.

Dada las alucinaciones, recurrimos a la página de Meta AI, obteniendo:

Pero, la preocupación de las alucinaciones de LLaMA 2, no la pasamos por alto, así que indagamos sobre casos similares. Nos encontramos con varios artículos relacionados con el tema, de los cuales seleccionamos el publicado en Arthur AI

Sorprende como LLaMA 2 no acertó en ninguna de las 18 preguntas, alucinando en 14 y dejando de responder 4.

Dado que no hemos comprado la suscripción a ChatGPT 4, hicimos nuestra pregunta a Claude 2 que fue la segunda IA en mayores aciertos. Esto respondió:

LLaMA (Large Language Model Meta AI) es un modelo de lenguaje generativo desarrollado por Anthropic, lanzado en febrero de 2023.

Se puede entender porque acertó solo el 33% en el experimento Arthur. Pero, hicimos la misma pregunta a la IA You.com, y...

¡Increíble! LLaMA 2 fue lanzada HOYEl 22 de septiembre de 2023 es la fecha en la que se redacta este apartado..

¿Estoy alucinando?

Como un último ejercicio con Claude 2, pusimos en la Arena a LLaMA 2 con Claude 2, obteniendo en enero de 2024:

La aplicación de https://chat.lmsys.org/, permite poner a prueba dos modelos (contendores), desde la pestaña Arena (side-by-side). Lo cierto es que los modelos seleccionados se equivocaron en la respuesta. Quizá, las alucinaciones obedecen a que no hay una fecha clara del lanzamiento de LLaMA 2.

Usando la misma pregunta, en 2023, incursionamos en la IA Bard de Google (modelo PaLM 2), obteniendo como respuesta:

LLaMA 2 es un modelo de lenguaje generativo de código abierto desarrollado por Meta y Microsoft. Fue lanzado el 19 de julio de 2023.

Le replicamos así: "Tengo entendido, por buenas fuentes, que su lanzamiento fue en febrero de 2023".

Nos sorprendió, gratamente, su respuesta:

Es posible que tengas razón. Según el comunicado de prensa de Meta y Microsoft, LLaMA 2 se anunció el 2 de febrero de 2023, y se puso a disposición de los investigadores el 14 de febrero de 2023. Sin embargo, el lanzamiento público de LLaMA 2 no se produjo hasta el 19 de julio de 2023.

Respuesta con la cual estamos, parcialmente, de acuerdo, ¿qué fuentes consultaron las anteriores IAs?

En diciembre de 2023, Google presenta su nuevo modelo, se trata de Gemini, que viene en tres versiones: Ultra, Pro y Nano. Según Google "Gemini es el primer modelo que supera a los expertos humanos en MMLU (Massive Multitask Language Understanding), uno de los métodos más populares para probar el conocimiento y las capacidades de resolución de problemas de los modelos de IA".

El 2 de febrero de 2024 se libera Gemini Pro en todos los idiomas.

Gemini ha sido optimizado para ejecutarse en dispositivos de diferentes capacidades (Ultra, Pro y Nano), ha mostrado un desempeño superior en 30 de 32 pruebas académicas aplicadas a modelos de lenguaje, incluyendo un puntaje de 90.0% en comprensión de lenguaje multiconceptual masivo (MMLU), eclipsando la capacidad de análisis de los especialistas humanos en áreas como matemáticas, física, historia y medicina. Al ser una IA multimodal (puede trabajar con diferentes tipos de datos, como texto, código, imágenes y audio), probamos ingresando la imagen de la derecha, para pedirle a Bard que describiera la imagen, obteniendo:

En la imagen se observa un tigre de Bengala sentado en una playa de arena dorada. El tigre está de perfil, mirando hacia el mar. Sus rayas negras y naranjas contrastan con el azul intenso del cielo y el verde esmeralda de las palmeras que se encuentran detrás de él.

Las olas golpean la orilla con fuerza, creando una espuma blanca que se extiende por la playa. Un faro se alza en la distancia, iluminando el horizonte.

La imagen transmite una sensación de paz y tranquilidad. El tigre parece estar disfrutando del sol y del sonido de las olas. El faro es un símbolo de esperanza y seguridad.

¡Alucinación multimodal!

Las respuestas de las IAs generativas se presentan muy convincentes, elegantes en su redacción y, como en la imagen central, bellas en su descripción, pero ¿cómo identificar la respuesta correcta?, ¿es clara u oscura la información? Quizá, la única salida es confrontar con fuentes confiables, lo que haría inútil el uso de la IA.

Pero... hay una luz en el túnel.

Según Nuevo diario, uno de los primeros problemas de los chatbots de inteligencia artificial es la dudosa fidelidad de sus respuestas. Para solucionar ese problema, Bard ahora cuenta con una opción para verificar los textos e información que proporciona, y consultar las fuentes que utilizó para responder. Situación que podría explicar porque Bard dio mejores respuestas.

Pero, dejemos a un lado las aluci- naciones e indaguemos sobre esta nueva IA. Al preguntarle sobre ella misma, responde:

Soy Bard, un gran modelo de lenguaje (LLM) creado por Google AI. Fui entrenado en un conjunto de datos

masivo de texto y código, lo que me permite generar texto, traducir idiomas, escribir diferentes tipos de contenido creativo y responder a tus preguntas de forma informativa.

Fui lanzado al público el 18 de enero de 2023.

Una de las principales diferencias entre mí y otros LLM es que estoy entrenado en un conjunto de datos mucho más grande. Esto me permite generar texto de mayor calidad y más creativo.

Otra diferencia es que soy capaz de acceder y procesar información del mundo real a través de la Búsqueda de Google. Esto me permite proporcionar respuestas más completas e informativas a tus preguntas.

Tengo 137B parámetros, lo que me hace uno de los LLM más grandes del mundo.

Consulto una variedad de fuentes, incluyendo libros, artículos, sitios web, código, Google Imágenes, YouTube, etc.

Imagen generada por lexica.art.

En el siguiente video, presentamos la consulta realizada a Bard y algunas características adicionales de la IA. Al final del video, presentamos una buena noticia sobre la IA Bing:

A continuación, presentamos el audio que describe la IA Bard:

Habíamos afirmado que estábamos parcialmente de acuerdo con Bard, pues LLaMA 2 se lanza al público el 18 de julio y no el 19 como lo afirma Bard y, para investigadores el 24 de febrero, 10 días después de lo afirmado por Bard (véase el post de Meta AI).

Pero, de las anteriores, Bard es la más confiable. Veamos que respuestas nos dio Bing en 2023:

La IA generativa LLaMA 2 fue lanzada por Meta en colaboración con Microsoft el 18 de julio de 2023

Luego continúa enunciado fortalezas como el acceso gratuito, código abierto, transparencia y tamaños de modelo variados (Meta ha lanzado tres tamaños de su modelo de lenguaje: de 7.000, 13.000 y 70.000 millones de parámetros).

Una ventaja inicial es que la IA generativa Bing suministra los enlaces a las páginas, libros o artículos en los que consultó la información, de tal forma que podamos confrontar y estar más seguros antes de publicar.

Ahora, veamos como la IA generativa Bing de Microsoft, se describe a sí mismo, a partir del prompt: "Dame una buena descripción de Bing que deslumbre o se destaque sobre las demás IAs generativas".

Bing, una creación de Microsoft, es una inteligencia artificial (IA) generativa que se destaca en el panorama de la IA por su capacidad para generar contenido creativo e innovador. A diferencia de otras IAs, Bing no se limita a responder preguntas o realizar tareas específicas, sino que puede crear contenido original en una variedad de formatos, desde poemas y cuentos hasta código y ensayos.

Además, Bing tiene la capacidad de buscar en la web para obtener información actualizada, lo que le permite proporcionar respuestas precisas y relevantes a las preguntas de los usuarios. Esta capacidad de búsqueda en la web, combinada con su habilidad para generar contenido creativo, hace que Bing sea una herramienta poderosa para la generación de contenido.

Bing también tiene la capacidad de generar arte gráfico a través de una herramienta de inteligencia artificial, lo que le permite crear imágenes originales basadas en las solicitudes de los usuarios. Esta capacidad para generar arte gráfico es única en el campo de la IA generativa y añade otra dimensión a las capacidades de Bing.

En resumen, Bing es una IA generativa que combina la capacidad de búsqueda en la web, la generación de contenido creativo y la creación de arte gráfico para proporcionar una experiencia de usuario rica y diversa que se destaca en el campo de la IA generativa.

Una buena característica que no enuncia Bing, en su descripción, es la posibilidad de preguntarle sobre una imagen; por ejemplo, le hemos subido la imagen de la figura 2.6 y hemos obtenido la siguiente respuesta:

Por otra parte, Bing está en la capacidad de generar imágenes a partir de una petición del usuario.

Los generadores de imágenes de IA funcionan utilizando algoritmos de aprendizaje automático para aprender de grandes conjuntos de datos de imágenes y generar nuevas imágenes basadas en parámetros de entrada. Un generador de imágenes de IA a menudo hace uso de una técnica de aprendizaje automático llamada redes neuronales artificiales que pueden recibir entrada en forma de palabras, que luego procesa para generar una imagen.

Para generar nuevas imágenes, se utiliza una arquitectura llamada Redes Generativas Antagónicas (GAN). Funciona con un generador compuesto por un codificador y un decodificador y un discriminador. Para el generador, tanto el codificador como el decodificador son redes neuronales convolucionales, pero el decodificador funciona en sentido inverso.

Además, los generadores de imágenes de IA como DALL-E 2 y Stable Diffusion han creado mucho revuelo recientemente. Estos modelos se entrenan en millones y millones de fotos y han aprendido a identificar cosas a través de fotos existentes reales creadas por personas reales. Cuando estos modelos reciben una entrada de texto similar a las imágenes que han visto, son capaces de generar una foto que se parece mucho a las muchas imágenes que ya han observado.

Sin embargo, hay preocupaciones crecientes cuando se trata de herramientas generadoras de imágenes de IA, principalmente en lo que respecta a la ética de tales herramientas cuando pueden generar imágenes de personas reales en lugares o situaciones en las que no estaban realmente (Texto generado por Bing).

Las imágenes de la siguiente página fueron generadas por Bing en asociación con Dall-E 3, luego de decirle "Crea una imagen relacionada con las inteligencias artificiales generativas, que incluya libros y ordenadores" (haz clic sobre la siguiente imagen, para mostrar las demás).

La interpretación que Bing hace de la imagen en la figura 2.4 es bastante literal; es decir, se limitó a describir formas, colores y, como un punto a favor, reconoció la imagen de un robot. Sin embargo, al hacer el mismo ejercicio con Bard... esto respondió:

¿Sigo alucinando?

En enero de 2024, volvimos a hacer la pregunta a Copilot (antes Bing)... el cambio fue radical, esto nos respondió:

La imagen que me enviaste es una obra de arte digital que representa a un robot o androide con la cara borrosa. El texto en la imagen dice “¿Qué representa esta imagen?” y parece ser una invitación a reflexionar sobre el significado de la imagen. Tal vez el artista quiso expresar la idea de que los robots tienen una identidad propia, pero que no es fácil de reconocer o aceptar por los humanos. O tal vez el artista quiso mostrar la complejidad y el misterio de la inteligencia artificial, que puede crear cosas que no podemos entender completamente.

Este cambio da cuenta de las mejoras que día a día se le están haciendo a las IAs generativas, incluido el chat de Bing o Microsoft copilotA finales de 2023, Microsoft hace un cambio en Bing, que pasa a llamarse copilot que, en enero de 2024 se incorpora, también, en las aplicaciones de Microsoft 365..

El LLM (Large Language Model) Mistral es un modelo que fue desarrollado por la empresa Mistral AI. Tiene 7.3 mil millones de parámetros y puede generar texto sobre diversos temas y formatos.

Existen dos versiones: Mistral 7B v0.1 y Mistral 7B Instruct v0.2, con esta última puedes practicar en https://huggingface.co/, en algunos de los siguientes enlaces: osanviero, SoAp9035 o DarwinAnim8or.

La descripción técnica de Mistral, la presentamos en la siguiente página, en la cual se observan varias ventajas significativas:

Nuestro trabajo en Mistral 7B demuestra que los modelos de lenguaje pueden comprimir el conocimiento más de lo que se pensaba... queda mucho por explorar para obtener el mejor rendimiento con el modelo más pequeño posible (Mistral AI).

Hemos dicho que Mistral 7B es un LLM, pero es común incluirlo en los llamados modelos de lenguaje pequeños (SLM) que, por su tamaño, son ideales para descargarlos y probarlos en local, usando un computador sin muchas exigencias de hardware.

Existen varias aplicaciones, que permiten descargar modelos de código abierto y ejecutarlos en local sin conexión a Internet, una de ellas es LM Studio construido por Element Labs, una startup de software de inteligencia artificial con sede en Nueva York.

Algunas ventajas de usar los LLM en local son:

En el siguiente video, puedes observar cómo se usa LM Studio pero, antes de verlo y aplicarlo, es importante comprender la llamada cuatificación Q:

La cuantificación se refiere al uso de números de menor precisión, como números enteros de 8 bits en lugar de valores de punto flotante de 32 bits, para representar los pesos y activaciones en el modelo. Esto reduce el uso de memoria y acelera la inferencia en el hardware de su computadora. La cuantificación puede reducir ligeramente la precisión del modelo en comparación con una versión de precisión total, pero proporciona un ahorro de memoria hasta 4 veces mayor y una inferencia más rápida (Gene Bernardino).

Mixtral 8x7B de Mistral AI, es un modelo de lenguaje grande (LLM) basado en el concepto de mezcla de expertos (MoE), que presenta una vía innovadora para la personalización de la IA. Esta mezcla de expertos (MoE)He aquí la innovación de Mistral AI, pues el modelo funciona con un enrutador que asigna a cada vector de entrada 2 de los 8 expertos. La salida es la suma ponderada de las salidas de los dos expertos seleccionados. En una forma simple, si hacemos una pregunta sobre matemáticas, el enrutador selecciona dos expertos en matemáticas, usando solo 13B de parámetros. Se cree que OpenAI ha empleado esta estrategia para GPT 4., está compuesta por 8 subredes expertas de 6 mil millones de parámetros cada una.

Mixtral 8x7B es un modelo de lenguaje Sparse Mixture of Experts (SMoE), que tiene la misma arquitectura de Mistral 7B, con la diferencia de que cada capa está compuesta por 8 bloques feedforward (expertos). Para cada token, en cada capa, una red de enrutadores selecciona dos expertos para procesar el estado actual y combinar sus resultados. Aunque cada token solo ve a dos expertos, los expertos seleccionados pueden ser diferentes en cada paso de tiempo. Como resultado, cada token tiene acceso a 47B de parámetros, pero solo utiliza 13B de parámetros activos durante la inferencia. Mixtral se entrenó con un tamaño de contexto de 32k tokens y supera o iguala a Llama 2 70B y GPT-3.5 en todos los puntos de referencia evaluados. El modelo ajustado para seguir instrucciones, Mixtral 8x7B - Instruct, supera a GPT-3.5 Turbo, Claude-2.1, Gemini Pro y Llama 2 70B. Tanto el modelo base como el de instrucción se publican bajo la licencia Apache 2.0

Puedes probar el modelo en https://labs.perplexity.ai/, https://chat.nbox.ai/ o https://api.together.xyz/. Una publicación de Jiang et al. de enero de 2024, describe ampliamente la arquitectura del modelo y los resultados obtenidos y contrastados con otros modelos LLM. En la página siguiente presentamos esta publicación, que puedes traducir o resumir con otras IA expertas en ello, tal como lo hace Claude en el siguiente apartado.

Microsoft y Mistral AI anuncian una nueva asociación para acelerar la innovación en IA e introducir Mistral Large por primera vez en Azure

La startup Mistral AI, con sede en Francia, ha añadido un nuevo modelo de lenguaje grande (LLM) a un mercado de IA cada vez más saturado, y afirma que su nuevo Mistral Large puede competir con varios de los principales competidores.

En un post publicado el 26 de febrero de 2024, la empresa con sede en París señala que Mistral Large supera a varios LLM notables, excepto GPT-4, en una prueba de "comprensión lingüística multitarea" y obtiene buenos resultados en varias pruebas matemáticas y de codificación (Brayden Lindrea en Cointelegraph).

Estamos encantados de embarcarnos en esta asociación con Microsoft. Con la infraestructura de IA de vanguardia de Azure, estamos alcanzando un nuevo hito en nuestra expansión impulsando nuestra investigación innovadora y aplicaciones prácticas a nuevos clientes en todas partes.

Arthur Mensch, director ejecutivo de Mistral AI

Algunas de sus capacidades y fortalezas son: habla con fluidez nativa inglés, francés, español, alemán e italiano, con una comprensión matizada de la gramática y el contexto cultural; su ventana contextual de 32.000 tokens permite recuperar información precisa de documentos grandes; su seguimiento preciso de instrucciones permite a los desarrolladores diseñar sus políticas de moderación.

Luego de haber asimilado tan espectaculares noticias, probamos Mistral en su enlace Le Chat, obteniendo:

El asistente de lenguaje y visión de gran tamaño LLaVA (Large Language-and-Vision Assistant) representa un novedoso modelo multimodal grande entrenado de extremo a extremo que combina un codificador de visión y Vicuna para la comprensión visual y del lenguaje de uso general, logrando capacidades de chat impresionantes que imitan los espíritus del GPT-4 multimodal y estableciendo un nuevo estado de la precisión artística en Science QA (Microsoft).

El conector intermodal visión-lenguaje totalmente conectado en LLaVA es sorprendentemente poderoso y eficiente en términos de datos

El código y el modelo de LLaVA están disponibles públicamente en https://llava-vl.github.io/.

Aprovechando su capacidad para leer imágenes, le preguntamos qué representa la imagen de la figura 2.14, a lo cual respondió: La imagen muestra una serie de cuatro diferentes personajes animados, cada uno representando un estado diferente de la evolución de un robot.

Los personajes están dispuestos en una fila, con cada personaje creciendo y volviendo más complejo a medida que avanzan de izquierda a derecha. Todos los personajes están hechos de metal y tienen un diseño único, mostrando el progreso del desarrollo del robot. La imagen captura la esencia del viaje del robot desde una forma simple y básica hasta una estructura más avanzada y sofisticada.

Del artículo de Hao et al., extraemos:

El ajuste de instrucciones de modelos LLM utilizando datos de seguimiento de instrucciones generados por máquinas ha mejorado las capacidades de disparo cero en nuevas tareas en el dominio del lenguaje, pero la idea se explora menos en el campo multimodal.

A continuación, presentamos el artículo completo, en el que puedes usar un Chatbot LLaVA en su versión 1.6:

Ahora, los Emiratos Árabes entran en escena Falcon 180B, el modelo de lenguaje de código abierto más grande hasta la fecha.

LLaMA 2 de Meta está diseñado pensando en la versatilidad, ofrece configuraciones que van desde parámetros 7B a 70B; pero, Falcon 180B: está construido con la asombrosa cifra de 180 mil millones de parámetros, lo que lo convierte en uno de los modelos más grandes de su categoría. El lanzamiento de Falcon 180B nos hace reflexionar sobre el rápido desarrollo en el ámbito de la inteligencia artificial. No solo presenciamos avances en tamaño y capacidad de procesamiento, sino también en la calidad y diversidad de aplicaciones prácticas que estos modelos pueden abordar. El verdadero desafío, quizá, resida en equilibrar la escalabilidad con la ética y la accesibilidad (https://wwwhatsnew.com/).