Introducción a la graficación por computadora

Melissa Méndez Servín

Universidad Nacional Autónoma de México

Título de la obra:

Introducción a la graficación por computadora

Autora:

Melissa Méndez Servín

Código JavaScript para el libro: Joel Espinosa Longi, IMATE, UNAM.

Fuentes:

Lora,

Cormorant Garamond,

Noto Sans SC,

Caveat,

UbuntuMono,

Glacial Indifference y

Press Start 2P.

Fórmulas matemáticas: $\KaTeX$

Red Educativa Digital Descartes

Córdoba (España)

descartes@proyectodescartes.org

https://proyectodescartes.org

Proyecto iCartesiLibri

https://proyectodescartes.org/iCartesiLibri/index.htm

ISBN:

978-84-18834-29-5

Esta obra está bajo una Licencia Creative Commons Atribución-NoComercial-CompartirIgual 4.0 Internacional.

El objetivo de este libro es proporcionar un material de apoyo para aquellos que estén interesados

en el área de graficación por computadora. Se presentan temas introductorios a este ámbito de conocimiento, en particular del renderizado en tiempo real, complementados

con ejemplos interactivos hechos con

El término de

Si bien, la graficación por computadora requiere de manera inevitable el conocimiento de ciertas APIs, hardware, y formatos de archivos específicos, este libro no tiene como cometido el enseñar a utilizar un API en algún lenguaje, software y/o hardware en particular, pues lo que se busca es dar un enfoque teórico de lo que son los fundamentos de la graficación, animando a los interesados a no limitarse y complementar lo aprendido realizando sus propias implementaciones en el ambiente de trabajo que más deseen.

Como nota personal me gustaría hacer un especial agradecimiento a mi madre, a mi padre, a Emmanuel, a Diego y, sobre todo, a mi profesor Joel Espinosa Longi, por el gran e invaluable apoyo que me brindaron durante todo el desarrollo de este libro, aportándome siempre muy buenas sugerencias, conocimientos y ánimo.

La graficación por computadora (GC) es un campo multidisciplinario bastante amplio, donde tanto computólogos, matemáticos, físicos, ingenieros, artistas y otros practicantes comparten un mismo objetivo "mostrar un mundo a través de una ventana", nos podemos referir como mundo a un modelo digital, una simulación, o bien, cualquier representación visual que se busque mostrar, y como ventana a cualquier medio para mostrar imágenes, como un proyector, la pantalla de un monitor, tablet, entre otros. Por lo que nos podemos dar una idea de las multiples aplicaciones que se pueden obtener en este campo sobre los diferentes ámbitos, veamos algunas de estas aplicaciones:

Creación de películas o caricaturas sintéticas, publicidad, efectos visuales y videojuegos.

Diseño de prototipos virtuales de partes mecánicas para su construcción, utilizando sistemas CAD/CAM (Computer-Aided Design/ Computer-Aided Manufacturing).

Uso del software CAD para la creación de planos de alguna estructura arquitectónica, visualizaciones de espacios antes y después de una construcción planeada.

Diseño y creación de productos, haciendo uso de sistemas CAD/CAM, promoviendo la creatividad del diseñador al permitirle experimentar con varias formas antes de producir la idea final.

Reconstrucciones virtuales de templos, monumentos, piezas antiguas, o bien, reconstrucciones hipotéticas de escenas.

Simulaciones virtuales de cirugías para entrenamiento y visualización de datos dados por algún instrumento de diagnóstico.

Asimismo, se han ido desarrollando un gran número de áreas de especialización, las cuales han ido evolucionando de acuerdo a las necesidades de los usuarios y al avance tecnológico en el hardware y software. Las principales suelen ser las siguientes:

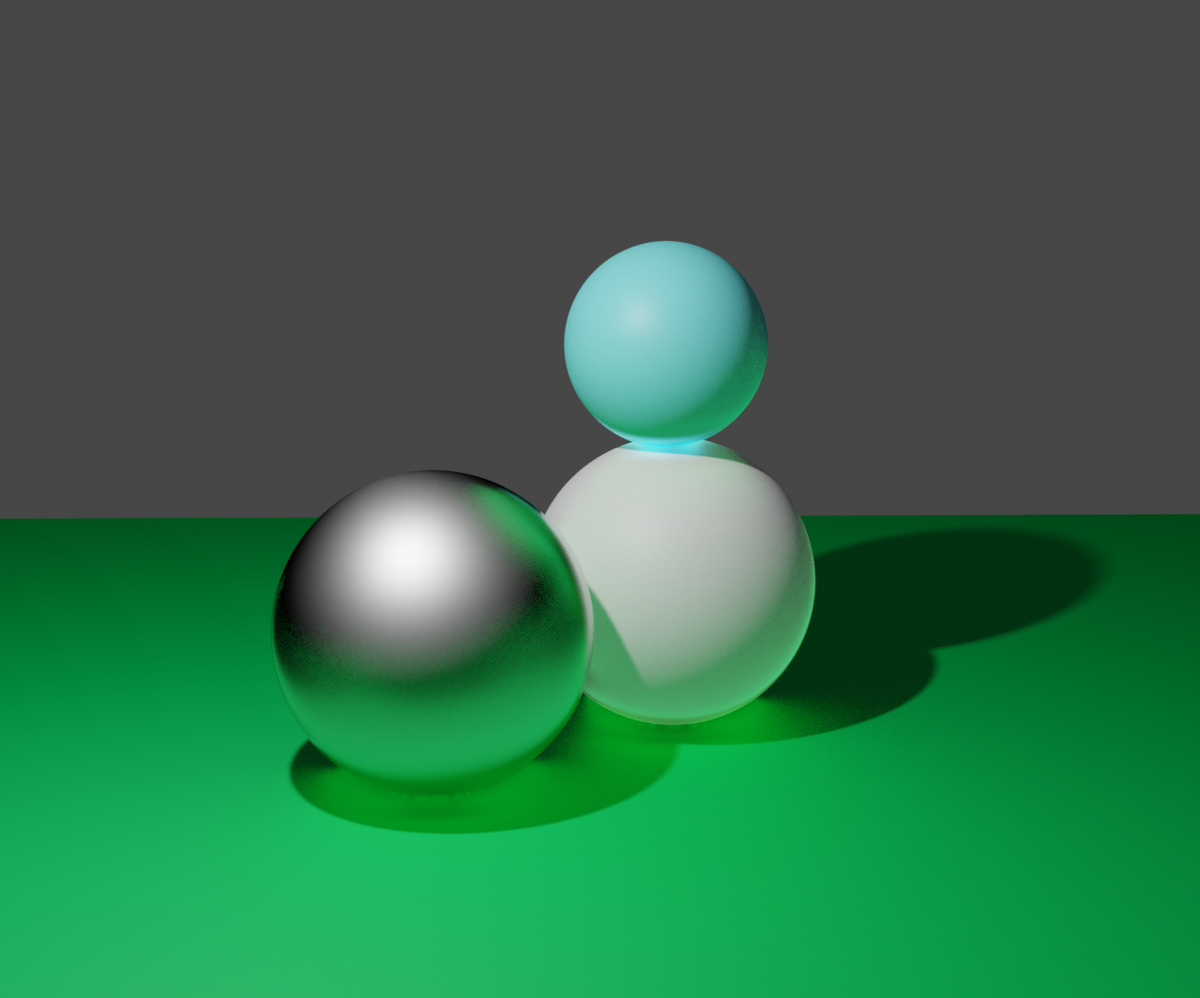

Es el proceso para generar una imagen final dada una entrada ordenada de datos, se suele clasificar dependiendo del algoritmo que se use, generalmente se toma como referencia el tiempo que a éste le tome en producir una imagen sintética (Real time rendering, Offline rendering), o bien, el tipo de técnica de renderizado que utilice (Photorealistic rendering, non-photorealistic rendering o information visualization).

Es la especificación matemática del mundo a representar, es decir, se describen los objetos y sus propiedades de un modo que éstos puedan ser almacenados en la computadora, por ejemplo, una manzana puede ser descrita como un conjunto de puntos 3D, los cuales forman caras ordenadas, con un modelo de iluminación especifico para describir cómo interactúa la luz con la manzana.

Es la creación de una secuencia de imágenes con una computadora, que tiene como finalidad producir la ilusión de movimiento. Si bien, hace uso de las dos áreas anteriores, no se encarga del estudio de éstas, pues su objetivo es añadir alguna animación sobre un rango de tiempo específico a los modelos, con la cual modifica algún aspecto de éstos, como su color, posición, apariencia, entre otros.

Y entre algunas otras áreas de relevancia se encuentran:

Es el proceso en el que un modelo matemático es ejecutado y representado con una computadora, la cual es usada para simular un comportamiento y su repercusión en el mundo real, o bien, dentro de un sistema físico impuesto, permitiendo revisar la fiabilidad del modelo, por lo cual es útil para modelar sistemas en física, astrofísica, climatología, química, biología, economía, ingeniería, etc. Por ejemplo, el movimiento de las partículas del agua en una ola, o bien, la simulación en tiempo real de un escenario de entrenamiento, como volar un avión. Las simulaciones garantizan un menor costo y mayor seguridad para los usuarios.

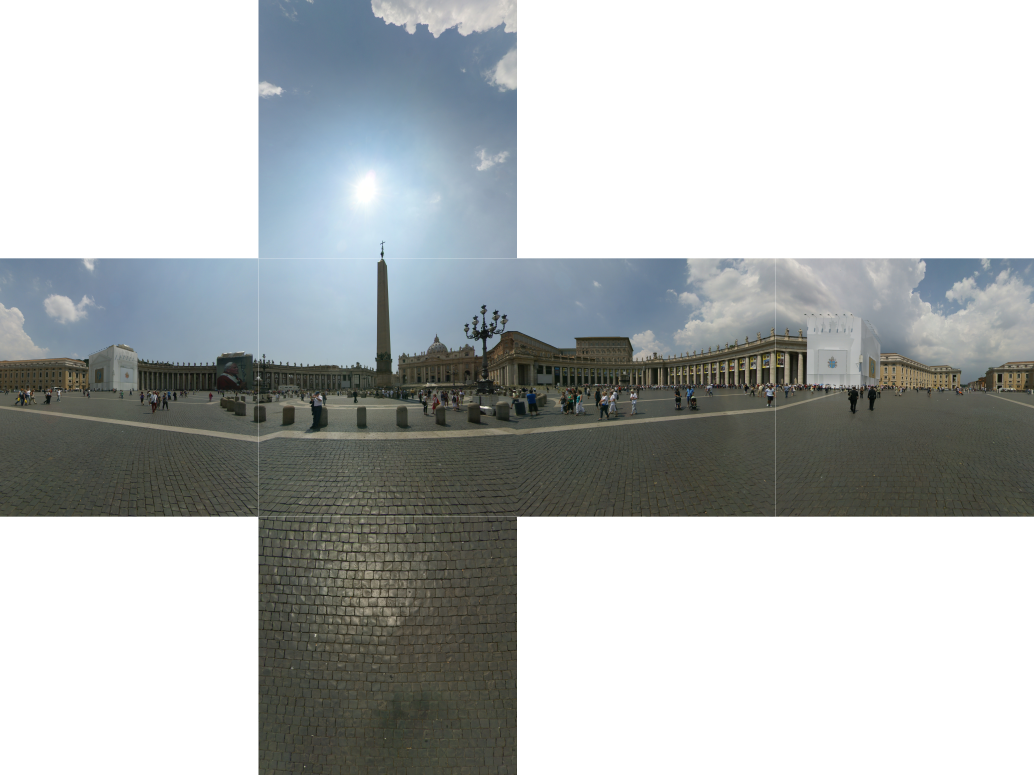

Es el uso de las técnicas de graficación por computadora, visión artificial y proceso digital de imágenes empleadas para mejorar el potencial de la fotografía digital y la calidad de la captura digital de imágenes, desarrollando otras formas de capturar objetos, escenas y ambientes. Permitiéndonos producir equipos fotográficos de bajo costo capaces de identificar caras, hacer reenfoques, panorámicas, e incluso hacer que el resultado luzca similar o mejor al de un equipo caro.

Es el proceso de colectar información de objetos del mundo real para crear un modelo 3D, desarrollando muchos dispositivos y algoritmos para obtener la geometría y apariencia del objeto real, dichos modelos son utilizados para crear visualizaciones.

Es la aplicación de técnicas y algoritmos para la manipulación de imágenes 2D, para obtener información de éstas, o bien, mejorar su calidad.

Es la simulación de un entorno virtual en 3D generado por computadora, que intenta hacer experimentar al usuario una sensación de estar inmerso en él. Aunque puede ser proyectado simplemente en la pantalla de un dispositivo como un monitor, se suelen utilizar otras tecnologías tales como cascos de realidad virtual, guantes, o incluso diseñar espacios, para intensificar las sensación de realidad y que además le permita una mejor interacción con el mundo virtual, creando imágenes realistas, sonidos y otras sensaciones.

Es la visualización de un espacio real en donde a los objetos tangibles de éste se les añade información gráfica generada por computadora, es decir, elementos virtuales son agregados al mundo real, cubriendo total o parcialmente a objetos del entorno, y permitiéndole al usuario interactuar en tiempo real dentro de este espacio mixto.

Para producir imágenes por computadora de escenas 3D, es importante entender primero cómo son producidas las imágenes de manera tradicional, con una cámara física y en el sistema de visión humano (que es el siguiente subtema), pues también vivimos en un mundo tridimensional.

La cámara estenopeica o cámara pinhole es la cámara real más simple que existe, lo cual la hace el modelo más utilizado en GC, ya que es más sencillo de reproducir y menos costoso. Es importante entender el funcionamiento de esta cámara ya que retomaremos algunos conceptos de ésta más adelante.

La cámara estenopeica es muy simple, consta de una caja a prueba de luz, con un agujero o apertura muy pequeña en el centro de uno de sus lados, y una película fotográfica o algún material fotosensible en la cara interior contraria al agujero, sobre la cual se proyecta la imagen invertida de la escena exterior cuando la apertura es abierta (Véase la ).

El principio que sigue esta cámara es el mismo que el de una cámara obscura, fenómeno que fue descubierto desde la antigüedad y que permitía estudiar eventos como el eclipse solar. Dicho fenómeno se experimentaba dentro cuartos obscuros con una pequeña abertura, la cual permitía la entrada de la luz, y formaba una imagen invertida de la escena exterior. El siguiente video es de National Geographic (todos los derechos reservados) y muestran cómo convertir tú propio cuarto en una cámara obscura.

En el mundo real tenemos varias fuentes de luz, siendo el sol la principal de éstas. Y cuando los rayos de luz chocan contra un objeto, éste puede absorberlos y/o reflejarlos en todas las direcciones. Por lo que, cuando tomamos una foto, solo aquellos rayos de luz que son reflejados del exterior hacia la cámara pasan a través de la pequeña apertura para formar la imagen sobre la película.

Supongamos que colocamos nuestra cámara a lo largo del eje $z$, con la apertura en el centro del sistema de coordenadas, mirando hacia $z+$. Y que la película fotográfica se encuentra a una distancia $d$ de la apertura.

Entonces, de todos los rayos que se reflejan desde algún punto $P =(x, y, z)$ en el exterior, solo un rayo, o más precisamente, un haz de luz muy estrecho logra entrar por la apertura, hasta que finalmente choca sobre el material fotosensible en el punto $P' =(x', y', z')$, véase .

Ahora bien, considerando lo que pasa cuando un rayo de luz atraviesa la apertura, de la , podemos observar que los dos triángulos rectángulos que se forman, uno con el punto exterior $P = (x,y,z)$ y otro el punto proyectado $P'$, son semejantes, permitiéndonos calcular la posición del punto proyectado $P'$. Sabemos que la película se encuentra a distancia $-d$ del origen en $z$, entonces: $$ y' = -\frac{y}{z/d} \quad \text{y} \quad x' = -\frac{x}{z/d} $$ $$ \Rightarrow P' = (x', y', -d)$$ Así el color del punto $P'$ en nuestra película sería el mismo que el del punto exterior $P$, proyectando la imagen de manera invertida.

Otro aspecto a considerar, es el ángulo de visión o campo de visión, que es qué tanto de la escena se alcanza a mostrar, o bien, qué tan grandes se ven los objetos del exterior.

Dicho aspecto depende también de la distancia $d$ que hay entre la película y la apertura, conocido como distancia focal. Ya que al acercar la película a la apertura, los objetos se hacen más pequeños y una mayor parte de la escena es proyectada, es decir, pareciera que nos alejamos, haciendo más amplio el ángulo de visión.

Y por el contrario, cuando alejamos la película de la apertura (mayor distancia focal), se muestra una porción más pequeña de la escena, es decir, como si nos acercáramos, haciendo más estrecho el ángulo de visión, como podemos notar en la

Por lo que sí la altura de la cámara es $\bm{h}$, entonces el ángulo de visión $\bm{ \theta}$ estaría dado por $$ tan \left( \frac{ \theta}{2} \right) = \frac{h/2}{d} \quad \Rightarrow \quad \theta = 2 tan^{-1} \frac{h}{2d}.$$

Dicho ángulo de visión puede ser definido de manera vertical, conectando la apertura con las esquinas superior e inferior de la película, o bien, de manera horizontal, conectado los extremos derecho e izquierdo de la película.

La cámara pinhole tiene un campo de profundidad infinito, esto quiere decir que cada punto en la escena dentro del campo de visión es proyectado dentro de la cámara.

En GC se suele posicionar el plano de proyección o película en $z = d$, que es algo que no funcionaría con una cámara real, pero en el mundo virtual de la computadora sí, evitando así los signos negativos y colocando la imagen en la posición original (de arriba hacia abajo).

Entonces, el punto proyectado estaría dado por $$P' = (x',y',z') = (\frac{dx}{z}, \frac{dy}{z}, d)$$

Renombrando también al punto estenopeico como el "ojo" o posición de la cámara, o solamente como viewpoint; y el plano de proyección o la película, como image plane, digamos nuestra imagen final compuesta de pixeles.

Si bien, lo ideal sería que la apertura de la cámara pinhole pudiera capturar un solo rayo de luz por punto, ya que de este modo, habría una única correspondencia entre los puntos en el exterior y los puntos proyectados, obteniendo una imagen nítida como resultado.

Pues de lo contrario, cada punto en el exterior podría proyectarse varias veces y producir una imagen desenfocada o borrosa. Este efecto se puede apreciar más cuando se fotografían objetos pequeños y brillantes con un fondo obscuro, generando círculos borrosos.

No obstante, en el mundo real, no es posible hacer tal apertura, ya que si el agujero es demasiado pequeño (comparable con el tamaño de la longitud de onda de la luz), lo rayos son difractados, sin embargo, se puede encontrar un

diámetro lo suficientemente pequeño para lograr obtener una buena imagen. Por ejemplo, una apertura de 2mm en una caja de zapatos, produce muy buenos resultados.

La cámara estenopeica tiene dos desventajas, una es que al tener una apertura muy pequeña, se requiere de más tiempo de exposición, pues se necesita de cierta cantidad de luz para formar la imagen sobre el material fotosensible; y en consecuencia se produce un efecto borroso si la cámara o algo en la escena exterior se mueve. La segunda es que no es posible modificar la distancia focal de la cámara, para obtener un mayor o menor campo de visión. Cabe mencionar, que éstos no son un problema en el mundo virtual.

Dichas desventajas se pueden solucionar agregando un lente sobre la apertura. Los lentes permiten una mayor apertura, para pasar más luz a la cámara y a su vez, redireccionando los rayos de luz reflejados por un mismo punto en el exterior a puntos únicos sobre la película. Proporcionando una imagen nítida en menor tiempo de exposición, lo cual resuelve el primer punto. Mientras que para el segundo, basta con elegir o ajustar los lentes a una distancia focal deseada.

La visión, es quizás el sentido más importante que tenemos, ya que nos proporciona información útil, como percibir increíbles imágenes, así como el movimiento y diferenciar objetos, siendo fundamental para la supervivencia del ser humano a lo largo del tiempo.

El sistema de visión humano (SVH) nos ayuda a comprender este complejo proceso biológico y psicológico, el cual, a pesar de ser tan complejo, sigue respetando los principios físicos de cualquier otro sistema óptico. Dicho sistema está compuesto por los ojos y el cerebro.

El proceso comienza cuando la luz llega al ojo y entra a través de la cornea (Ver )), que a su vez pasa por la pupila, la cual (controlada por el iris) puede cambiar el tamaño de su diámetro de 2mm a 8mm, regulando la cantidad de luz que entra, y que es refractada por el cristalino sobre la retina, proyectando la imagen de manera invertida (como en la cámara pinhole).

La retina contiene fotorreceptores o receptores de luz, llamados conos y bastones, estos receptores transforman la luz en pulsos eléctricos (de acuerdo a su sensibilidad y la intensidad de la luz), los cuales transportados por el nervio óptico, llegarán al cerebro para ser interpretados.

La luz es una forma de radiación electromagnética que se propaga en forma de onda, de la cual el ser humano sólo puede percibir aquella que se encuentre dentro del espectro visible (). La luz visible suele ser definida como aquella que tiene longitudes de onda que rondan en un rango de 380nm a 780nm, entre la luz ultravioleta e infrarroja.

Los bastones, son los más numerosos, y son responsables principalmente de nuestra visión nocturna (visión escotópica), debido a que pueden captar cantidades muy bajas de luz. Además, son más sensibles a la detección de movimiento o flicker y a la visión periférica, debido a su distribución sobre la retina.

Mientras que los conos son menos sensibles, y responden a niveles altos de luz (visión fotópica), es decir, durante el día, o bien, con cantidades normales de luz, éstos nos permiten percibir los colores, así como detalles más finos y un cambio de imágenes más rápido, esto último debido a que responden más rápido que los bastones.

Un punto medio, es decir, cuando los niveles de luz se encuentran en un nivel intermedio (visión mesópica), ambos receptores son utilizados. Aquí es donde empieza nuestra visión del color, así como la saturación de nuestros bastones. Un ejemplo de la visión mesópica sería, cuando vamos caminando por la calle de noche con alumbrado público.

La mayoría de los conos se concentran en la fóvea, por lo que es la área con mayor agudeza visual. Esta área está libre de bastones, sin embargo, a medida en que nos vamos alejando hacia la periferia del ojo, el número de conos decrece mientras que el número de bastones incrementa. Por esta razón también es que podemos ver una estrella con poca luminosidad al no enfocarnos en ella.

Existen tres tipos de conos: L (long), M (medium) y S (short), que como sus nombres lo indican, están definidos de acuerdo a la parte del espectro visible a la que son más sensibles.

Pues como podemos observar en , la distribución de las respuestas de cada uno de los conos no es uniforme, y abarcan rangos de longitudes de onda que se intersecan entre sí, sin embargo, cada tipo tiene un punto máximo diferente. De modo que, los conos L son más sensibles a las longitudes de onda más largas, correspondiendo a la parte roja del espectro visible, los conos M a las longitudes de onda medianas, siendo la parte verde del espectro y los S a las más cortas, es decir, la parte azul del espectro.

Cabe aclarar que no es que las longitudes de ondas sean de cierto color, puesto que no es una propiedad de la luz, es el cerebro quien las interpreta o produce la sensación del color, así como de tamaño y forma. Por lo que se podría decir que cada cono es capaz de percibir cierto rango de colores.

Por ejemplo, cuando percibimos el color amarillo es porque los conos tipo L se estimulan un poco más que los M. Del mismo modo, cuando percibimos el color azul es porque los conos tipo S se estimulan más. Mientras que para el blanco, todos los conos son estimulados por igual.

Como consecuencia, al tener solo a estos tres tipos de receptores del color (en lugar de tener un tipo de cono distinto para cada una de las longitudes de onda), se simplificó bastante la tarea de manejar los colores en una pantalla, pudiendo del mismo modo aproximarnos a cualquier otro color por medio de los tres primarios.

Otra característica interesante es que los humanos somos más sensibles a los cambios de brillo que de color, el brillo es la intensidad con la que percibimos la luz emitida por un objeto. Por lo que, dicha propiedad ha sido tomada para la compresión de imágenes, donde la información de los colores se comprime más que la información de la iluminación.

El color es un aspecto fundamental para la graficación por computadora, ya que además de ser una característica importante en los objetos, nos permite transmitir sensaciones y emociones. Por ejemplo, una escena con colores cálidos puede evocar desde sentimientos de calidez y confort hasta ira u hostilidad, mientras que una escena con colores fríos evoca calma, o bien, sentimientos de tristeza o indiferencia (ver ).

Podemos pensar en el color en dos niveles. En un nivel físico, que consiste en todas las leyes físicas que se involucran en el SVH para crear la sensación del color, y en un nivel perceptual o subjetivo, que se refiere a cómo lo percibimos.

Y debido a la influencia de los diferentes factores, tanto objetivos como subjetivos, se han creado una variedad de modelos para representar a los colores.

El modelo RGB, también conocido como Additive Color Model o modelo natural, ya que de manera similar a nuestros receptores de colores, se combinan las intensidades de los tres colores primarios (Rojo, Verde y Azul), para obtener un color y es el modelo más utilizado.

Podemos pensarlo como tres lámparas que proyectan los colores primarios sobre una pared blanca, en un cuarto obscuro. De este modo, en la pared blanca se reflejaría el color de las luces, así como la correspondiente combinación aditiva de las luces que estén superpuestas. En especial, al superponer las tres luces, podríamos obtener cualquier color al ir ajustando de manera adecuada la intensidad de cada una.

Su espacio de color puede ser representado por el cubo unitario $[0,1] \times [0,1] \times [0,1]$ como se muestra en la , donde un color es representado por

una tripleta (R,G,B), haciendo referencia a un punto en el cubo, e indicando al mismo tiempo la intensidad de cada componente. Se asigna el color negro al origen $(0,0,0)$, y conforme la intensidad de los colores incremente se llega al color blanco en $(1,1,1)$ al moverse a lo largo de los ejes.

Comúnmente, se utilizan 8-bits por componente, por lo que cada uno puede representar hasta $2^8 = 256$ valores diferentes.

Algunos de los dispositivos en los que se emplea este modelo son las pantallas (CRT, LCD, LED, OLED, AMOLED), cámaras digitales y escáneres. Por el contrario, la manera en que especifican un color RGB no es muy intuitiva.

El modelo HSV está basado en el sistema de color de Munsell, el cual intenta acercarse más a la manera en la que percibimos los atributos de los colores, simulando el modo en que un pintor obtiene un color, al mezclar el pigmento con color blanco y/o negro, con el fin de obtener un color más claro, más obscuro u opaco.

Su espacio de color es modelado con un cono o una pirámide hexagonal inversa, y como su nombre lo indica, está definido por sus componentes:

Cuando un modelo de color es asociado con una función que mapea los colores reales o físicos a los elementos del modelo, se le conoce como espacio de color.

Existen espacios de colores que son capaces de representar cualquier color, sin importar la manera en la que serán físicamente reproducidos, estos se conocen como espacios de color independientes de los dispositivos . Por otro lado, los espacios de colores dependientes de los dispositivos, tienen que lidiar con el hecho de que no todos los colores físicos pueden ser reproducidos.

De modo que, un dispositivo en particular puede producir un conjunto de colores específico, conocido como gamut o gama de colores reproducibles. Por lo que los colores que no se encuentren dentro de la gama, no podrán ser reproducidos de manera adecuada.

El gamut de los espacios de colores dependientes, suelen ser definidos en el diagrama de cromaticidad del espacio de color estándar CIEXYZ (Ver ), creado por la Comission International de l'Eclairage en 1931. El cual es un espacio de color independiente, basado en un experimento científico, que

engloba todos los colores del espectro visible que en promedio podemos distinguir. Estableciendo los tres colores primarios a partir de los cuales se generan todos los demás.

Por ejemplo los espacios sRGB y AdobeRGB, son dos espacios de colores distintos asociados a un mismo modelo de color, donde la tripleta RGB(21,03,97) podría mostrar un color diferente en cada espacio. Pues como podemos notar en la , a pesar de que comparten los colores primarios rojo y azul, el verde es distinto, haciendo que la gama de colores del espacio de color AdobeRGB sea más amplia que la del sRGB.

Otro ejemplo en donde encontramos una diferencia a simple vista, es entre la gama de colores de una impresora de oficina y un monitor, donde el rango de colores de la impresora está mucho más limitada.

El pipeline gráfico o rendering pipeline es el proceso que se requiere para renderizar o generar una imagen 2D, dado un conjunto de datos de entrada que describen un escena tridimensional.

El pipeline se divide en varias etapas, las cuales cumplen con cierta parte del proceso; estas etapas son ejecutadas en paralelo, pero cada una depende del resultado de la etapa previa.

Podemos pensarlo como el proceso dentro de una fábrica ensambladora, o bien, como la analogía

que nos dan en

Si bien, no hay una sola forma de llevar a cabo el pipeline, mencionaremos las 4 etapas

fundamentales: Aplicación, Procesamiento Geométrico, Rasterización y

Procesamiento de pixeles, dentro de las cuales también tienen sus propios pipelines,

es decir, se subdividen en varias etapas. REF.

Esta estructura es el motor del pipeline gráfico, y es usada en aplicaciones en tiempo real.

Vale la pena mencionar, que en este tipo de renderizado, también llamado renderizado por rasterización, es un proceso distinto al de ray tracing, donde por cada pixel se calcula su respectivo color de acuerdo a los objetos que lo intersecan. Ya que en el renderizado por rasterización se considera a cada objeto y se buscan los pixeles que lo conforman.

A continuación, explicaremos un poco de lo que trata cada etapa del pipeline (sin meternos en detalles de implementación).

La Aplicación, como su nombre lo indica esta etapa es ejecutada por la aplicación misma, es decir, el software que es ejecutado desde el CPU. Aquí es el programador quien tiene todo el control, pues es el que se encarga de definir las funcionalidades que ésta va a tener, por lo mismo, es también, donde se pueden hacer optimizaciones en el desempeño de dicha aplicación.

En esta etapa es donde son implementadas otras tareas de acuerdo a los objetivos del desarrollador, como detectar colisiones entre dos objetos, definir animaciones o simulaciones de modelos físicos, entre otras. Así como la implementación de algoritmos de aceleración.

También es la que se encarga de manejar la interacción con otros dispositivos de entrada, definiendo las acciones a ejecutar de acuerdo a la entrada, por ejemplo, cuando alguien presiona una tecla o mueve el cursor del ratón.

Y es donde se especifica la geometría que se quiere renderizar, para ser procesada en a la siguiente etapa. Dicha geometría es especificada con primitivas de renderizado, las cuales pueden ser líneas, puntos o triángulos que finalmente podrían ser mostradas en la pantalla.

A partir de la siguiente etapa las operaciones son realizadas desde el GPU.

El Procesamiento geométrico o de vértices, se encarga de convertir los vértices en primitivas, realizando la mayoría de las operaciones por vértice y por triángulo, dicho proceso se describe en el siguiente diagrama.

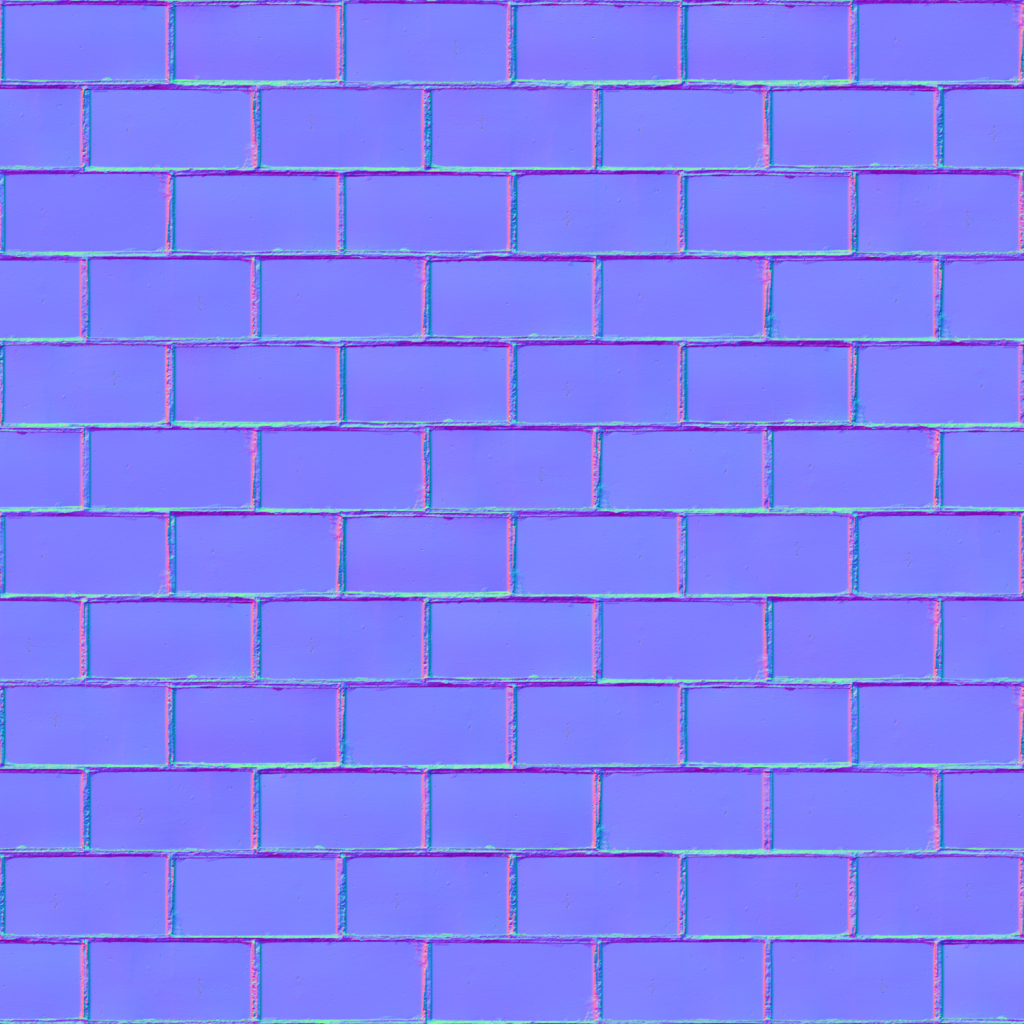

En el Vertex shading se efectuan la mayoría de las transformaciones para calcular las posiciones de los vértices y de otros datos o atributos asociados a éstos, como serían las normales de los vértices o algún otro vector que se quiera calcular, así como las coordenadas de textura o un color.

Para empezar, tenemos de entrada la descripción geometrica de cada uno de los modelos que queremos, es decir, por cada objeto, tenemos un conjunto de vértices ordenados, los cuales forman o describen a dichos objetos, y se encuentran descritos en su propio espacio local ().

Las coordenadas de un objeto se conocen como coordenadas locales, sobre las cuales se pueden aplicar una serie de transformaciones para modelar al objeto (escalarlo, rotalo y/o trasladarlo), a estas transformaciones se les llaman transformaciones de mundo o de modelo ().

Una vez que éstas han sido aplicadas, se dice que los objetos se encuentran posicionados en el espacio global o de mundo, donde los objetos ya están ordenados dentro de un mismo espacio.

La siguiente transformación a aplicar es la transformación de vista, ésta es la que modela la cámara, ya que lo que nos interesa renderizar será lo que la cámara (o el observador) esté viendo. Efectuando un cambio de base de las coordenadas del mundo a las coordenadas de la cámara, es decir, del espacio global al espacio de la cámara, también llamado view space o eye space. Colocando a la cámara en el origen, mirando comunmente en dirección al eje $z$ negativo ($z-$), con el eje $y$ positivo ($y+$) apuntando hacia arriba , y el eje $x$ positivo ($x+$) a la derecha ().

Hasta aquí ambas transformaciones (de modelo y de vista) también suelen ser aplicadas a las

normales de los vértices, así como otros véctores que ayuden a modelar el aspecto del objeto.

Por esta razón, la parte programable del procesamiento de vértices es llamada como

vertex shader.

Y dichas transformaciones pueden ser implementadas con matrices de 4x4, las cuales veremos

también en el

Sin embargo, tanto la posición de los vértices como de los otros atributos pueden ser calculadas o modelados como el programador prefiera.

La siguiente etapa es la de Proyección, y en ésta se efectúa otra transformación, la cual también puede ser efectuada con una matriz $4 \times 4$, por lo que suele ser concatenada a las matrices de transformación anteriores dentro del vertex shader. Este tipo de matrices de transformación son llamadas de proyección ya que lo que se busca es proyectar lo que se está viendo en la pantalla de la cámara, de manera similar a lo que ocurre con la cámara pinhole.

En esta etapa se define el volumen de visión que ve nuestra cámara, el cual define el espacio de la escena a renderizar, y que será transformado en un cubo unitario, también llamado volumen canónico de vista, el cual suele tener sus extremos en $(-1,-1,-1)$ y $(1,1,1)$. Para ello, se elige un tipo de proyección con la que se definirán los límites del volumen de visión o clipping volume y se transformará en el cubo unitario, para la conveniencia de las etapas posteriores, pasando las coordenadas de vista a coordenadas de clipping o de recorte. Los dos tipos de proyección más utilizados son la proyección ortográfica y la de perspectiva, obsérvese la .

En la primera se utiliza un volumen de visión con forma de prisma rectangular, en esta los puntos son proyectados de manera paralela y el volumen de visión ortogonal es transformado en un cubo unitario. Por otra parte, la proyección de perspectiva tiene un volumen de visión con forma de pirámide truncada o frustrum como el que vimos en la , este tipo de proyección nos proporciona una sensación más realista de profundidad, ya que mientras más alejado se encuentre un objeto de la cámara más pequeño se verá. Y del mismo modo, el frustrum es transformado a un cubo unitario.

Con ésta última transformación se finaliza el proceso del vertex shader.

El objetivo del Clipping es descartar total o parcialmente aquellas primitivas o partes de primitivas que queden fuera del volumen de visión. Pues recordemos que lo que nos interesa renderizar es lo que esté adentro de éste, por lo que sí la primitiva se encuentra completamente dentro del volumen entonces pasa a la siguiente etapa para ser renderizada y por el contrario, si se encuentra completamente fuera es descartada. Por otro lado, sí la primitiva se encuentra parcialmente dentro, entonces es recortada, generando nuevos vértices y primitivas a partir de la intersección con el volumen y los vértices que quedan fuera de éste son descartados ().

Finalmente, se normalizan las coordenadas de clipping con la división de perspectiva, al dividir las coordenadas entre su última componente $w$, convir-

tiéndolas a coordenadas normalizadas del dispositivo o NDC (Normalized Device Coordinates). El término de normalizadas en NDC viene de que las coordenadas de los puntos están dentro del rango de $[-1,1]$.

Como última etapa del procesamiento geométrico tenemos al Screen mapping, también conocida como

transformación de pantalla o viewport, que como su nombre

lo indica, se encarga de transformar las coordenadas $x$ y $y$ en coordenadas de pantalla o window coordinates,

las cuales son pasadas a la etapa de rasterización, en conjunto con su coordenda $z$.

Dicha transformación es efectuada de acuerdo a las coordenadas de pantalla de la ventana sobre la que

se renderizará la escena.

Esta etapa es también conocida como scan conversion, y es la responsable de convertir los vértices de coordenadas de pantalla, y otra información asociada a éstos, en pixeles. Este proceso consta de dos etapas.

La primera etapa, es el Ensamblado de primitivas o Triangle setup, que se encarga simplemente de ensamblar conjuntos de vértices en primitivas.

Y en la segunda, Triangle traversal, es donde se buscan aquellos pixeles que se encuentran dentro de una primitiva, o bien, que por lo menos su centro lo esté; generando un fragmento por cada uno de éstos, los cuales podemos pensarlos como un posible pixel con una información asociada, la cual es resultado de la interpolación entre los vértices a lo largo de la primitiva. Dicha información guarda la profundida de pixel (su valor en $z$) y cualquier otro dato del vertex shader.

Finalmente dichos fragmentos (o pixeles) son enviados a la siguiente y última etapa.

Es la última etapa del pipeline, y también se puede dividir en dos etapas: Pixel shading y Merging.

En el Pixel shading es donde se realizan las operaciones del fragment shader, utilizando la información

asociada de cada fragmento; y pasando finalmente el color (o los colores) resultantes de cada pixel.

Existen varias técnicas para producir el color de los pixeles; la más importante es el mapeado de texturas,

la cual consiste en aplicar una textura sobre un objeto, en otras palabras, es como si pegáramos o envolviésemos con

una o varias imágenes sobre un objeto.

Y por último tenemos el Merging, y en éste, prácticamente se determina el color final que tendrá cada pixel en la pantalla. Dichos colores son almacenados en el búfer de color, el cual es un arreglo bidimensional, y es inicializado con un color inicial o color de fondo.

Durante esta etapa se resuelve la visibilidad de los fragmentos de acuerdo a su valor de profundidad, es decir, los colores almacenados en el búfer de color deberá contener los colores de las primitivas que son visibles. Comúnmente ésto es calculado con el algoritmo del z-buffer.

También se pueden realizar otros efectos para determina el color final de cada pixel, como el de transparencia, donde se aplica una función de mezclado o blending que indica cómo se combinan los colores con transparencia. O bien, una operación de plantilla o stencil en el que se descartan ciertos fragmentos para después ser pasados por el test de profundidad (y descartar más).

Finalmente el contenido del búfer de color es desplegado en la pantalla.

Recordaremos algunos conceptos de álgebra lineal necesarios para tener una mejor comprensión en los temas posteriores.

Los ángulos pueden ser medidos ya sea en grados o radianes. La medida de

De modo que sí $r=1$, entonces el ángulo $\theta$ es justamente la longitud del arco definida

por el mismo ángulo al cortar el círculo unitario. Por otro lado, usando

Entonces, $360\degree = 2 \pi$ radianes, siendo $$ 180\degree = \pi \, \text{radianes}$$ Por lo que, $$ 1 \ radián = \frac{180}{\pi} \approx 57.3 \text{ grados} \quad \text{y} \quad 1 \ grado = \frac{\pi}{180} \approx 0.017 \ \text{radianes.}$$

Los radianes son la medida más utilizada para realizar cálculos, en particular para llevar acabo funciones trigonométricas. Por último, recordemos que los ángulos positivos se miden en sentido contrario a las manecillas del reloj, a partir del eje $x+$; y para los ángulos negativos es con respecto al sentido de las manecillas.

Veamos las funciones trigonométricas básicas. Para cubrir cualquier tipo de ángulo, trazaremos el ángulo dentro de un círculo de radio $r$, y estará definido por un punto $P = (x,y)$.

$$ \begin{aligned} \mathbf{Seno:} \ \sin\theta = \frac{y}{r} \quad &; \quad \mathbf{Coseno:} \ \cos\theta = \frac{x}{r} \\ \mathbf{Tangente:} \ \tan\theta = \frac{y}{x} \quad &; \quad \mathbf{Cotangente:} \ \cot\theta = \frac{x}{y} \\ \mathbf{Cosecante:} \ \csc\theta = \frac{r}{y} \quad &; \quad \mathbf{Secante:} \ \sec\theta = \frac{r}{x} \end{aligned} $$

Cuando $r=1$ podemos simplificar las igualdades como sigue: $$ \sin\theta = \frac{y}{1} = y \quad ; \quad \cos\theta = \frac{x}{1} = x $$ $$ \tan\theta = \frac{\sin\theta}{\cos\theta} \quad ; \quad \cot\theta = \frac{1}{\tan\theta} $$ $$ \csc\theta = \frac{1}{\sin\theta} \quad ; \quad \sec\theta = \frac{1}{\cos\theta} $$

Las siguientes identidades trigonométricas con dos ángulos arbitrarios $\alpha$ y $\beta$ también son usadas: $$ \sin(\alpha \pm \beta) = \sin\alpha \cos\beta \pm \cos\alpha \sin\beta $$ $$ \cos(\alpha \pm \beta) = \cos\alpha \cos\beta \mp \sin\alpha \sin\beta$$

Los vectores son fundamentales en GC, en especial para los gráficos en 3D. Ya que pueden ser utilizados para representar puntos, direcciones, velocidades, desplazamientos, etc. Aprovechando en su totalidad la definición tanto geométrica como algebráica de un vector.

Comúnmente para contabilizar objetos basta utilizar un solo número, por ejemplo, para medir la temperatura, la altura, el calzado, etc. Éste tipo de medidas son descritas únicamente por su magnitud y son representadas por número reales, llamados escalares, y claro su unidad base. Por otra parte existen fenómenos físicos que necesitan más que un solo número para ser medidos, como serían el movimiento del viento, la fuerza, la velocidad, entre otros. Los cuales poseen magnitud y dirección, éstos son llamados vectores.

En este libro los puntos se denotarán con letras mayúsculas en itálicas.

Podemos definir entonces a un vector como un segmento de recta que tiene una cierta magnitud y dirección. El cual es representado como una flecha que va de un punto inicial $P$ a un punto terminal $Q$, y se denota como: $$ \mathbf{v} = \overset{\rarr}{PQ}$$

Si dos segmentos de recta dirigidos tienen la misma magnitud y dirección, entonces se dice que son equivalentes, esto es, sin importar la posición inicial de cada uno.

Siendo más específicos, podemos ver a un vector como el conjunto de todos los segmentos dirigidos que son equivalentes entre sí.

La magnitud o longitud de un vector se denota como $\lVert \mathbf{v} \rVert$ y es un escalar; más adelante veremos cómo es que se calcula.

Observemos que los vectores $\overset{\rarr}{PQ}$ y $\overset{\rarr}{QP}$ son distintos, puesto que apuntan en direcciones opuestas, sin embargo, éstos siguen teniendo la misma longitud. Por otro lado, si tenemos $\overset{\rarr}{PP}$, entonces el vector tiene longitud cero, es decir, $\lVert \overset{\rarr}{PP} \rVert = 0$, ya que su punto inicial y terminal son el mismo, se dice que tampoco tiene dirección. A este vector, se lo conoce como el vector cero, y es denotado por $\mathbf{0}$.

Cuando multiplicamos a un vector $\mathbf{v}$ por un escalar $k$, se produce un efecto de escalamiento sobre la longitud del vector por un factor de $\mid k \mid$ unidades, obteniendo al vector $k \mathbf{v}$ como resultado, el cual es paralelo a $\mathbf{v}$ y tiene una longitud $k \lVert \mathbf{v} \rVert$.

Aunado a esto, su dirección sigue siendo la misma sí $k > 0$, pero si $k < 0$ entonces resulta tener una dirección opuesta. Finalmente, sí $k = 0$, entonces $k \mathbf{v} = \mathbf{0}$ (Ver )

La suma de dos vectores $\mathbf{u}$ y $\mathbf{v}$, se construye poniendo al vector $\mathbf{u}$ en alguna posición arbitraria, y al vector $\mathbf{v}$ de tal forma que su punto inicial coincida con el punto terminal o cabeza de $\mathbf{u}$. En la se muestra dicha construcción, donde $\mathbf{u + v}$ es la diagonal del paralelogramo formado por $\mathbf{u}$ y $\mathbf{v}$.

Cuando se quiere sumar más de dos vectores, se construye la suma de manera análoga, colocando ahora un vector a continuación del otro (Ver ).

Hasta ahora solo hemos ilustrado la suma en dos dimensiones, sin embargo, las operaciones de los vectores también pueden ser ilustradas en tres dimensiones, como se muestra a continuación.

Ahora bien, ya que hemos hablado de la suma y multiplicación por escalar de vectores, podemos seguir con la resta de vectores.

La resta de dos vectores $\mathbf{u} - \mathbf{v}$ es justamente una simplificación de $$ {\color{#008b8b}\underbrace{\color{black}\mathbf{u} + {\color{#008b8b}\underbrace{\color{black}(-1 \mathbf{v})}_{\color{black}\text{mult. por escalar}}} } _{\color{black}\text{suma}}} = \mathbf{u} + (- \mathbf{v}) = \mathbf{u} - \mathbf{v}$$ (Ver ).

Donde $-\mathbf{v}$ se conoce como el negativo de $\mathbf{v}$ o su inverso aditivo.

Un espacio vectorial $\mathit{V}$ sobre un campo de escalares $\mathit{K}$ se define como un conjunto (no vacío) de objetos, llamados vectores, con dos operaciones binarias: suma de vectores y multiplicación de vectores por un escalar; y que además satisfacen las siguientes propiedades:

Para cualesquiera tres vectores $\mathbf{u}$, $\mathbf{v},\mathbf{w}$ en $\mathit{V}$, y dos escalares $k$ y $l$ en $\mathit{K}$:

| (i) | $\mathbf{u} + \mathbf{v} = \mathbf{v} + \mathbf{u}$ | (Conmutatividad) |

| (ii) | $(\mathbf{u} + \mathbf{v}) + \mathbf{w} = \mathbf{v} + (\mathbf{u} + \mathbf{w})$ | (Asociatividad) |

| (iii) | $\mathbf{v} + \mathbf{0} = \mathbf{v}$ | (Existencia del vector cero o neutro aditivo) |

| (iv) | $\mathbf{v} + (-\mathbf{v}) = \mathbf{0}$ | (Existencia del negativo de un vector o inverso aditivo) |

| (v) | $(kl) \mathbf{v} = k(l \mathbf{v})$ | (Asociatividad) |

| (vi) | $k(\mathbf{u} + \mathbf{v}) = k\mathbf{v} + k\mathbf{u}$ | (Distributividad 1) |

| (vii) | $(k+l) \mathbf{v} = k\mathbf{v} + l\mathbf{v}$ | (Distributividad 2) |

| (viii) | $k \mathbf{0} = \mathbf{0}$ | (Multiplicación por vector cero) |

| (ix) | $0 \mathbf{v} = \mathbf{0}$ | (Multiplicación por escalar cero) |

| (x) | $1 \mathbf{v} = \mathbf{v}$ | (Unidad escalar) |

El campo al que nos limitaremos a usar será el conjunto de los números reales $\Reals.$

Los sistemas de coordenadas son utilizados para describir la posición de un objeto dentro de un espacio. El más usado es el sistema de coordenadas cartesianas, el cual consta de dos ejes perpendiculares del mismo tamaño, con el origen en el punto de intersección de éstos.

Podemos definir un sistema de coordenadas sobre cualquier espacio que queramos. Por ejemplo, sobre un mapa como en el siguiente interactivo.

Por otra parte, se dice que un espacio vectorial $\mathit{V}$ es de dimensión $\bm{n}$ finita o $\bm{n-}$dimensional si tiene bases de $n$ elementos. Por ejemplo, el sistema de coordenadas de la es un espacio vectorial de dimensión 2, y se toman los vectores $\mathbf{x}$, y $\mathbf{y}$ como la base del espacio.

Podemos referirnos a un espacio vectorial $n$-dimensional sobre $\Reals$, simplemente como $\Reals^{n}.$

Sea $\mathbf{e}$ un vector distinto al vector cero en un espacio unidimensional sobre $\Reals$, es decir, una línea recta. Se dice que $\mathbf{e}$ es un vector base, si para cualquier vector $\mathbf{v}$ en la línea, existe un único número $x$, tal que $$\mathbf{v} = x \mathbf{e}$$ Siendo $x$ la coordenada de $\mathbf{v}$ con $\{\mathbf{e}\}$ como base. Ver .

Sea $\mathbf{e_1}$ y $\mathbf{e_2}$ dos vectores sobre $\Reals^{2}$, distintos al vector cero y no paralelos entre sí. Se dice que $\mathbf{e_1}$ y $\mathbf{e_2}$ son vectores base, si para cualquier vector $\mathbf{v}$ en el plano, existe una única tupla $(x,y)$, tal que $$\mathbf{v} = x \mathbf{e_1} + y \mathbf{e_2}$$ Siendo $x$ y $y$ las coordenadas de $\mathbf{v}$ con $\{\mathbf{e_1}, \mathbf{e_2}\}$ como base. Ver .

Sea $\mathbf{e_1}, \mathbf{e_2}$ y $\mathbf{e_3}$ tres vectores en $\Reals^{3}$ distintos del vector cero, con los cuales no se forma ningún plano paralelo entre todos ellos. Se dice que $\{\mathbf{e_1}, \mathbf{e_2},\mathbf{e_3}\}$ es una base , si para cualquier vector $\mathbf{v}$ en el espacio tridimensional, existe una única tripleta de coordenadas $(x,y,z)$, tal que $$\mathbf{v} = x \mathbf{e_1} + y \mathbf{e_2} + z \mathbf{e_3}$$

Análogamente, si tenemos al conjunto $S = \{e_1, e_2, ..., e_n\}$ como la base de un espacio $n-dimensional$ sobre $\Reals$, entonces, para cualquier vector $\mathbf{v}$ en $\Reals^{n}$, existe una única tupla de escalares (coordenadas) $(v_1, v_2, ..., v_n)$, tales que $$ \mathbf{v} = \sum_{i = 1}^{n}v_i \mathbf{e_i} $$ y se dice que $\mathbf{v}$ es una combinación lineal de los vectores base.

Por otra parte, los vectores de una base siempre son linealmente independientes entre sí, esto es, que ninguno de los vectores puede ser expresado como múltiplo escalar de otro. De no ser así, se dice que el conjunto de vectores es linealmente dependiente.

Y ya que los vectores pueden ser identificados por sus coordenadas, es que surge la idea de representarlos por medio de las mismas.

Una forma de escribir a un vector es como un vector columna. Por ejemplo, si suponemos que la base que usaremos en un espacio tridimensional es $\{\mathbf{e_1}, \mathbf{e_2}, \mathbf{e_3}\}$, entonces podemos escribir al vector $\mathbf{v}$ como $$ \mathbf{v} = v_x \mathbf{e_1} + v_y \mathbf{e_2} + v_z \mathbf{e_3} = \begin{bmatrix} v_x \\ v_y \\ v_z \end{bmatrix}$$

En este libro, los vectores serán denotados de está manera, o bien, de una manera más compacta como la $n-tupla$ de las $n$ coordenadas del vector, que serán utilizados para representar puntos (posiciones) sobre los planos. En este mismo ejemplo esto sería $\mathbf{v} = (v_x, v_y, v_z)$.

Continuando, un vector renglón por otra parte, se escribe en horizontal $$\mathbf{v} = \begin{bmatrix} v_x & v_y & v_z \end{bmatrix},$$ siendo la traspuesta del vector columna, y viceversa. $$ \mathbf{v} = \begin{bmatrix} v_x \\ v_y \\ v_z \end{bmatrix} \quad ; \quad \mathbf{v}^{T} = \begin{bmatrix} v_x & v_y & v_z \end{bmatrix}$$

Siguiendo esta idea es fácil ver que dados dos puntos en el plano $P$ y $Q$, podemos obtener el vector que describe el desplazamiento de $P$ a $Q$ con la diferencia, es decir, $\overset{\rarr}{PQ} = Q-P$, pues nos interesa la distancia entre cada coordenada del punto de origen al punto destino.

Sean dos vectores $\mathbf{u} = \begin{bmatrix} u_1 \\ u_2 \\ \vdots \\ u_n \end{bmatrix} $ y $\mathbf{v} = \begin{bmatrix} v_1 \\ v_2 \\ \vdots \\ v_n \end{bmatrix}$ con la misma base, y un escalar $k$

la multiplicación $k\mathbf{v}$ está dada por

$$k\mathbf{v}= \begin{bmatrix} kv_1 \\ kv_2 \\ \vdots \\ kv_n \end{bmatrix}$$

Mientras que la suma $\mathbf{u} + \mathbf{v}$ se define como

$$\mathbf{u} + \mathbf{v}= \begin{bmatrix} u_1 + v_1 \\ u_2 + v_2 \\ \vdots \\ u_n + v_n \end{bmatrix}$$

Las bases canónicas o estándar suelen ser definidas como los vectores base $e_i$ con todas sus entradas en $0$, a excepción de su $i$-ésima componente, el cual es 1. Por ejemplo, la base estándar de un espacio 3D sería $\{(1,0,0),(0,1,0),(0,0,1)\}$

Primero, vale la pena recordar que dos vectores son ortogonales, si el ángulo más pequeño que se forma entre ellos, es de $\frac{\pi}{2}$ o $90\degree$, siendo perpendiculares entre sí. Y que si el ángulo es igual a cero, los vectores son colineales, pues comparten la misma línea, siendo paralelos entre sí.

El producto punto de dos vectores $\mathbf{u}$ y $\mathbf{v}$, es denotado como $\mathbf{u} \cdot \mathbf{v}$, y también es conocido como producto escalar, ya que se define como el escalar $$\mathbf{u} \cdot \mathbf{v} = \lVert \mathbf{u} \rVert \lVert \mathbf{v} \rVert \cos \theta $$ donde $\theta$ es el ángulo más pequeño comprendido entre los vectores $\mathbf{u}$ y $\mathbf{v}$.

Por consiguiente podemos deducir que: $$ \mathbf{u} \cdot \mathbf{v} = 0 \Longleftrightarrow \mathbf{u} = \mathbf{0} \text{ o } \mathbf{v} = \mathbf{0} \text{, o } \theta = \frac{\pi}{2} \text{ es decir, } \mathbf{u} \text{ y } \mathbf{v} \text{ son ortogonales.} $$

$$ \begin{aligned} \mathbf{u} \cdot \mathbf{v} > 0 \Longleftrightarrow 0 < \theta < \frac{\pi}{2} \\ \mathbf{u} \cdot \mathbf{v} < 0 \Longleftrightarrow \frac{\pi}{2} < \theta \leq \pi \\ \end{aligned} $$Un vector cuya magnitud es exactamente $1$, es llamado vector unitario, esto es, $\mathbf{v}$ es vector unitario si $\lVert \mathbf{v} \rVert = 1$. Para cualquier vector $\mathbf{v}$ distinto al vector cero, se puede obtener su respectivo vector unitario, es decir, un vector $\mathbf{n}$ de longitud $1$ con la misma dirección de $\mathbf{v}$.

Dicho proceso es conocido como normalización y se efectua cómo sigue

$$ \mathbf{n} = \frac{1}{\lVert \mathbf{v} \rVert} \mathbf{v}$$ Por lo que, al tener dos vectores $\mathbf{v}$ y $\mathbf{u}$ con $\lVert \mathbf{v} \rVert = \lVert \mathbf{u} \rVert = 1$, el cálculo del producto punto se simplifica a $\mathbf{v} \cdot \mathbf{u} = \cos \theta$.

Siendo muy útil en GC, para el computo de los shaders, pues se suele requerir el coseno del ángulo entre dos vectores.

Supongamos que queremos proyectar ortogonalmente al vector $\mathbf{u}$ sobre el vector $\mathbf{v}$, obteniendo un nuevo vector $\mathbf{w}$ como la proyección resultante.

De trigonometría básica, sabemos que dentro de un triángulo rectángulo podemos relacionar al coseno de uno de los ángulos pequeños con la longitud de su respectivo cateto adyacente y la hipotenusa.

Como podemos notar en el siguiente interactivo, se forma un triángulo rectángulo. En este caso, podemos pensar al vector $\mathbf{u}$ como la hipotenusa, y al vector $\mathbf{w}$ como el cateto adyacente al ángulo $\theta$ que se forma entre los vectores $\mathbf{u}$ y $\mathbf{v}$.

Teniendo entonces $\cos\theta = {\large\frac{\lVert \mathbf{w} \rVert}{\lVert \mathbf{u} \rVert}}.$

Con ésto, podemos deducir que $$ \lVert \mathbf{w} \rVert = \lVert \mathbf{u} \rVert \cos\theta $$ De modo que para obtener al vector $\mathbf{w}$, simplemente multiplicamos al vector unitario de $\mathbf{v}$ por $\lVert \mathbf{w} \rVert $, es decir, $$\mathbf{w} = \lVert \mathbf{w} \rVert \frac{ \mathbf{v}}{\lVert \mathbf{v} \rVert} = \frac{\lVert \mathbf{u} \rVert \cos\theta}{\lVert \mathbf{v} \rVert } \mathbf{v} $$ Pues sabemos que la normalización no afecta la dirección del vector, y si multiplicamos por $\frac{\lVert \mathbf{v} \rVert }{\lVert \mathbf{v} \rVert }$ tenemos que $$ \mathbf{w} = \frac{ \lVert \mathbf{u} \rVert \lVert \mathbf{v} \rVert \cos\theta }{{\lVert \mathbf{v} \rVert}^{2}}\mathbf{v}$$ $$ \Rightarrow \mathbf{w} = \frac{\mathbf{u} \cdot \mathbf{v}}{{\lVert \mathbf{v} \rVert}^{2}}\mathbf{v}$$

Entonces si tenemos un vector $\mathbf{v}$ distinto al vector cero, podemos definir la proyección de $\mathbf{u}$ sobre $\mathbf{v}$ como $$ P_{\mathbf{v}}\mathbf{u} = \frac{\mathbf{u} \cdot \mathbf{v}}{{\lVert \mathbf{v} \rVert}^{2}}\mathbf{v} $$

Notemos que sí $\mathbf{v}$ es un vector unitario entonces la fórmula se reduce a solo $ (\mathbf{u} \cdot \mathbf{v}) \mathbf{v} $.

A continuación se listan algunas propiedades útiles del producto punto. Sean $\mathbf{u}, \mathbf{v}$ y $\mathbf{w}$ tres vectores y $k$ un escalar, se satisface lo siguiente

| (i) | $\mathbf{u} \cdot \mathbf{v} = \mathbf{v} \cdot \mathbf{u}$ | (Conmutatividad) |

| (ii) | $ k (\mathbf{u} \cdot \mathbf{v}) = (k \mathbf{u}) \cdot \mathbf{v}$ | (Asociatividad) |

| (iii) | $\mathbf{u} \cdot (\mathbf{v} + \mathbf{w}) = \mathbf{u} \cdot \mathbf{v} + \mathbf{u} \cdot \mathbf{w}$ | (Distributividad) |

| (iv) | $\mathbf{v} \cdot \mathbf{v} = {\lVert \mathbf{v} \rVert}^{2} \leq 0 $ | (Longitud cuadrática) Siendo cero únicamente cuando $\mathbf{v} = \mathbf{0}$ |

Para cualquier base ortonormal $n$-dimensional $\{e_1,e_2,...,e_n\}$ se satisface lo siguiente $$ e_i \cdot e_j = \begin{cases} 1 &\text{si } e_i = e_j \\ 0 &\text{si } e_i \not = e_j \end{cases} $$ y como $e_i \cdot e_i = 1$, quiere decir que la longitud de los vectores base debe ser uno, es decir, están normalizados y son ortogonales entre sí.

Entonces, en cualquier base ortonormal, el producto punto entre dos vectores $n$-dimensionales $\mathbf{u}$ y $\mathbf{v}$, está dado por $$ \mathbf{u} \cdot \mathbf{v} = \sum_{i = 1}^{n}u_{i} v_{i} $$

Por ejemplo, el producto punto en una base de dimensión 3 sería $$ \mathbf{u} \cdot \mathbf{v} = u_x v_x + u_y v_y + u_z v_z$$

De la propiedad (iv) del producto punto tenemos que $\mathbf{v} \cdot \mathbf{v} = {\lVert \mathbf{v} \rVert}^{2} \leq 0 $, esto es, $\mathbf{v} \cdot \mathbf{v} = \lVert \mathbf{v} \rVert \lVert \mathbf{v} \rVert \cos\theta = {\lVert \mathbf{v} \rVert}^{2}$, pues $\theta = 0 \Rightarrow \cos \theta = 1$.

Entonces, si tomamos un vector 2D $\mathbf{v} = (v_x, v_y)$ en una base ortonormal, podemos utilizar (iv) para obtener su longitud, esto es ${\lVert \mathbf{v} \rVert}^{2} = \mathbf{v} \cdot \mathbf{v} = v_x^2 + v_y^2$, por lo que $$ \lVert \mathbf{v} \rVert = \sqrt{v_x^2 + v_y^2}$$ La cual también es una prueba del teorema de Pitágoras (Ver ).

De igual manera, para un vector 3D $\mathbf{v} = (v_x, v_y, v_z)$ en una base ortonormal, su longitud está dada por $$ \lVert \mathbf{v} \rVert = \sqrt{v_x^2 + v_y^2 + v_z^2}.$$

Entonces, la magnitud de un vector de una dimensión arbitraria $\bm{n}$, en una base ortonormal, se calcula como $$ \lVert \mathbf{v} \rVert = \sqrt{ \sum_{i = 1}^{n}v_{i}^2} = \sqrt{v_1^2 + v_2^2 + ... + v_n^2}.$$ satisfaciendo también las siguientes propiedades para cualesquiera dos vectores $\mathbf{u}$ y $\mathbf{v}$ en $\mathit{V}$, y un escalar $k$ en $\mathit{K}$:

| (i) | $ \lVert \mathbf{v} \rVert \ge 0$ |

| (ii) | $\lVert \mathbf{v} \rVert = 0 \iff \mathbf{v} = \mathbf{0} $ |

| (iii) | Los vectores $\lVert k \mathbf{v} \rVert = |k| \lVert \mathbf{v} \rVert $ |

El producto cruz de dos vectores tridimensionales, ya que solo está definido en $\Reals^{3}$, es definido como un nuevo vector $\mathbf{u} \times \mathbf{v}$ que cumple las siguientes propiedades:

Entonces, por (ii) tenemos que $\mathbf{u} \times \mathbf{v} = \mathbf{0}$, si $\mathbf{u} = \mathbf{0}$ o $\mathbf{v} = \mathbf{0}$, Así también si el ángulo $\theta$ es igual a cero, es decir, si $\mathbf{u}$ y $\mathbf{v}$ son paralelos entre sí.

Por otro lado, un método muy utilizado para conocer la dirección de $\mathbf{u} \times \mathbf{v}$ es el de la regla de la mano derecha, donde se posiciona la mano derecha de modo que el dedo índice apunte a la misma dirección que el vector $\mathbf{u}$ y el dedo medio a la de $\mathbf{v}$, entonces, el pulgar apuntará en dirección del vector $\mathbf{u} \times \mathbf{v}$.

Notemos también que la longitud del producto cruz puede ser interpretada geométricamente como el área del paralelogramo formado por ambos vectores, pues $\lVert \mathbf{v} \rVert \sin\theta$ es la altura del triángulo formado por $\mathbf{u}$ y $\mathbf{v}$, que es también la altura del paralelogramo, entonces $$ a = bh = \lVert \mathbf{u} \rVert \lVert \mathbf{v} \rVert \sin\theta = \lVert \mathbf{u} \times \mathbf{v} \rVert $$

El cálculo del producto cruz suele ser muy utilizado para gráficos 3D en particular, la propiedad (i) nos permite calcular la normal de una superficie en un punto en específico al utilizar dos vectores tangentes.

| (i) | $\mathbf{u} \times \mathbf{v} = -\mathbf{v} \times \mathbf{u}$ | (Conmutatividad) |

| (ii) | $\mathbf{u} \times (\mathbf{v} + \mathbf{w}) = \mathbf{u} \times \mathbf{v} + \mathbf{u} \times \mathbf{w}$ | (Distributividad) |

| (iii) | $(\mathbf{u} + \mathbf{v}) \times \mathbf{w} = \mathbf{u} \times \mathbf{w} + \mathbf{v} \times \mathbf{w}$ | (Distributividad) |

| (iv) | $ k (\mathbf{u} \times \mathbf{v}) = (k \mathbf{u}) \times \mathbf{v} = \mathbf{u} \times (k \mathbf{v})$ | (Asociatividad) |

Sean dos vectores $\mathbf{u}$ y $\mathbf{v}$ en $\Reals^{3}$, el producto cruz está dado por $$ \mathbf{u} \times \mathbf{v} = (u_y v_z - u_z v_y, u_z v_x - u_x v_z, u_x v_y - u_y v_x) $$

Una forma de recordar esta fórmula es utilizando el pseudodeterminante $$ \mathbf{u} \times \mathbf{v} = \begin{vmatrix} e_1 & e_2 & e_3 \\ u_x & u_y & u_z \\ v_x & v_y & v_z \\ \end{vmatrix} = e_1 \begin{vmatrix} u_y & u_z \\ v_y & v_z \\ \end{vmatrix} - e_2 \begin{vmatrix} u_x & u_z \\ v_x & v_z \\ \end{vmatrix} + e_3 \begin{vmatrix} u_x & u_y \\ v_x & v_y \\ \end{vmatrix} $$ $$ = (u_y v_z - u_z v_y)e_1 + (u_z v_x - u_x v_z)e_2 + (u_x v_y - u_y v_x)e_3 $$ Se dice que es pseudodeterminante ya que el primer renglón consta de vectores, considerando que las entradas deberían de ser solo escalares.

Otra forma de expresar el producto cruz es con la transformación lineal $$ \mathbf{u} \times \mathbf{v} = \begin{bmatrix} 0 & -u_z & u_y \\ u_z & 0 & -u_x \\ -u_y & u_x & 0 \\ \end{bmatrix} \begin{bmatrix} v_x \\ v_y \\ v_z \end{bmatrix} $$ Los temas de determinantes, matrices y transformaciones lineales serán tratados con más detenimiento en los siguientes subtemas.

Las matrices son una herramienta muy poderosa para manipular datos, y es por esta razón que son fundamentales en GC.

Una matriz $\mathbf{A}$ de dimensión $r \times c$ se define como un arreglo rectangular de $rc$ escalares $a_{ij}$ distribuidos en un orden de $r$ reglones y $c$ columnas, representada de la siguiente forma: $$ \mathbf{A} = \begin{bmatrix} a_{11} & a_{12} & \cdots & a_{1c} \\ a_{21} & a_{22} & \cdots & a_{2c} \\ \vdots & \vdots & \ddots & \vdots \\ a_{r1} & a_{r2} & \cdots & a_{rc} \end{bmatrix} $$ Siendo $a_{ij}$ el número que aparece en el renglón $i$ y en la columna $j$, también llamado como $ij-ésima$ componente o elemento de $\mathbf{A}$.

Notemos que en una matriz de $r \times c$ hay $r$ diferentes vectores renglón y $c$ diferentes vectores columna, los primeros compuestos por $c$ escalares y los segundos por $r$.

Y a su vez, una matriz con una sola columna es una matriz de dimensión $r \times 1$ o vector columna, asimismo, para una matriz con un solo renglón, se dice que es una matriz de dimensión $1 \times c$ o vector renglón.

Por otro lado, si $\mathbf{A}$ es una matriz con $r = c$ se dice que es una matriz cuadrada, y éstas son el tipo de matrices con las que se suele trabajar en GC.

Una matriz identidad $\mathbf{I}$ es una matriz cuadrada cuyos elementos de la diagonal principal son iguales a $1$ y todos los demás son $0$. Por ejemplo la matriz identidad de $3 \times 3$ sería $$ \mathbf{I} = \begin{bmatrix} 1 & 0 & 0 \\ 0 & 1 & 0 \\ 0 & 0 & 1 \end{bmatrix}$$

Se puede multiplicar una matriz $\mathbf{A}$ por un escalar $k$, obteniendo una matriz $S = k \mathbf{A}$ con las mismas dimensiones que $\mathbf{A}$, donde cada elemento está dado por $ka_{ij}$. $$ k \mathbf{A} = \begin{bmatrix} ka_{11} & ka_{12} & \cdots & ka_{1c} \\ ka_{21} & ka_{22} & \cdots & ka_{2c} \\ \vdots & \vdots & \ddots & \vdots \\ ka_{r1} & ka_{r2} & \cdots & ka_{rc} \end{bmatrix} $$

Si dos matrices $\mathbf{A}$ y $\mathbf{B}$ tienen las mismas dimensiones, entonces pueden sumarse, obteniendo una nueva matriz $\mathbf{A} + \mathbf{B}$, donde cada elemento está dado por $a_{ij} + b_{ij}$. $$ \mathbf{A+B} = \begin{bmatrix} a_{11} + b_{11} & a_{12} + b_{12} & \cdots & a_{1c} + b_{1c} \\ a_{21} + b_{21} & a_{22} + b_{22} & \cdots & a_{2c} + b_{2c} \\ \vdots & \vdots & \ddots & \vdots \\ a_{r1} + b_{r1} & a_{r2} + b_{r2} & \cdots & a_{rc} + b_{rc} \end{bmatrix}$$

Con las dos operaciones previas podemos definir la resta de dos matrices con la misma dimensión como $$ \mathbf{A-B} = \mathbf{A} + (-1) \mathbf{B} $$

Sí $\mathbf{A}$ es una matriz de $r \times s$ y $\mathbf{B}$ una matriz de $s \times t$, es decir, el número de columnas de la primera matriz es el mismo que el número de renglones que la segunda, entonces se pueden multiplicar, obteniendo la matriz $\mathbf{P = AB}$ de tamaño $r \times t$, donde cada elemento $$p_{ij} = \sum_{k = 1}^{s}a_{ik} b_{kj} = a_{i1}b_{1j} + a_{i2}b_{2j} + ... + a_{is}b_{sj}$$

Por ejemplo, al multiplicar una matrix $\mathbf{A}$ de $3\times2$ por una matriz $\mathbf{B}$ de $2\times3$

Teniendo como resultado una matriz de dimensión $(3\times\cancel{2})(\cancel{2}\times3) = 3\times3$.

Nótese que al utilizar matrices cuadradas de orden $n$ podemos realizar todas estas operaciones sin ningún problema, obteniendo nuevamente una matriz de $n \times n$ como resultado.

La matriz inversa de $\mathbf{A}$ se denota como $\mathbf{A^{-1}}$ y es aquella que nos asegura $\mathbf{A}\mathbf{A^{-1}} = \mathbf{A^{-1}}\mathbf{A} = \mathbf{I}$. No todas las matrices son invertibles.

En particular, una matriz cuadrada que no es invertible se denomina singular. Por otra parte, la inversa del producto de dos matrices es el producto de las inversas en orden contrario $$ (\mathbf{A}\mathbf{B})^{-1} = \mathbf{B}^{-1}\mathbf{A}^{-1} $$

La traspuesta de una matriz $\mathbf{A}$ de $r \times c$ se denota como $\mathbf{A}^{T}$, y es la matriz de $c \times r$ que se obtiene de intercambiar los renglones por columnas, es decir, donde cada entrada $a_{ij}$ de $A$ corresponde a la entrada $a'_{ji}$ de $A^T$. $$ \mathbf{A} = \begin{bmatrix} a_{11} & a_{12} & \cdots & a_{1c} \\ a_{21} & a_{22} & \cdots & a_{2c} \\ \vdots & \vdots & \ddots & \vdots \\ a_{r1} & a_{r2} & \cdots & a_{rc} \end{bmatrix} ; \mathbf{A^{T}} = \begin{bmatrix} a_{11} & a_{21} & \cdots & a_{r1} \\ a_{12} & a_{22} & \cdots & a_{r2} \\ \vdots & \vdots & \ddots & \vdots \\ a_{1c} & a_{2c} & \cdots & a_{rc} \end{bmatrix} $$

En otras palabras, el renglón $i$ de $\mathbf{A}$ se escribe como la columna $i$ de $\mathbf{A^{T}}$, y la columna $j$ de $\mathbf{A}$ como el renglón $j$ de $\mathbf{A^{T}}$.

Y visto que un vector puede ser representado como una matriz de una sola columna (o renglón), entonces podemos obtener la multiplicación de dos matrices, o bien, vectores, con el producto punto, pues

$$ \mathbf{u} \cdot \mathbf{v} = \mathbf{u}^T \mathbf{v} = \begin{bmatrix} u_1 & u_2 & \dots & u_n \end{bmatrix} \begin{bmatrix} v_1 \\ v_2 \\ \vdots \\ v_n \end{bmatrix} = \sum_{i = 1}^{n}u_{i} v_{i} $$

Además, se dice que una matriz $\mathbf{A}$ es simétrica si es una matriz cuadrada y se tiene que $\mathbf{A} = \mathbf{A}^T$.

Del manera similar que con la inversa del producto de dos matrices pasa con la traspuesta, es decir $$(\mathbf{A}\mathbf{B})^{T} = \mathbf{B}^{T}\mathbf{A}^{T}$$

Por último, un conjunto especial de matrices son las llamadas matrices ortogonales, donde una matriz ortogonal $\mathbf{B}$ es una matriz cuadrada conformada por vectores columna (o renglón) los cuales constituyen una base ortonormal. Por lo que se satisface que $$\mathbf{B^{-1}} = \mathbf{B^T} \quad \text{pues} \quad \mathbf{B}\mathbf{B^T} = \mathbf{I}$$ ya que por definición de base ortonormal tenemos que $b_i \cdot b_i = 1$ y $b_i \cdot b_j = 0$, sí $i \not = j$.

Esta propiedad suele ser muy conveniente en GC ya que se suelen usar frecuentemente este tipo de

matrices, por ejemplo, la matriz de rotación descrita en el

Se tiene también que $\lVert \mathbf{Bv} \rVert = \lVert \mathbf{v} \rVert $ y de ahí que $(\mathbf{Bu})\cdot(\mathbf{Bv}) = \mathbf{u} \cdot \mathbf{v}$. Finalmente, si multiplicamos dos matrices ortogonales $\mathbf{A}$ y $\mathbf{B}$, entonces $\mathbf{AB}$ también será ortogonal.

| (i) | $\mathbf{A} + \mathbf{B} = \mathbf{B} + \mathbf{A}$ | (Conmutatividad) |

| (ii) | $(\mathbf{A} + \mathbf{B}) + \mathbf{C} = \mathbf{A} + (\mathbf{B} + \mathbf{C})$ | (Asociatividad) |

| (iii) | $\mathbf{I} \mathbf{A} = \mathbf{A}$ | (Identidad multiplicativa) |

| (iv) | $(kl) \mathbf{A} = k(l \mathbf{A})$ | (Asociatividad) |

| (v) | $k(\mathbf{A} + \mathbf{B}) = k\mathbf{A} + k\mathbf{B}$ | (Distributividad) |

| (vi) | $(k+l) \mathbf{A} = k\mathbf{A} + l\mathbf{A}$ | (Distributividad) |

| (vii) | $ \mathbf{A} + (-1) \mathbf{A} = \mathbf{O}$ | (Inverso aditivo. Nótese que la matriz de la derecha se trata de la matriz cero) |

| (viii) | $\mathbf{A} (\mathbf{B} + \mathbf{C}) = \mathbf{A} \mathbf{B} + \mathbf{A} \mathbf{C}$ | (Distributividad) |

| (ix) | $(\mathbf{A}+\mathbf{B}) \mathbf{C} = \mathbf{A}\mathbf{C} + \mathbf{B}\mathbf{C}$ | (Distributividad) |

| (x) | $(\mathbf{A} \mathbf{B}) \mathbf{C} = \mathbf{A} (\mathbf{B} \mathbf{C})$ | (Asociatividad) |

| (xi) | $(k \mathbf{A})^{T} = k(\mathbf{A})^{T}$ | (Traspuesta 1) |

| (xii) | $(\mathbf{A}^{T})^{T} = \mathbf{A}$ | (Traspuesta 2) |

| (xiii) | $(\mathbf{A} + \mathbf{B})^{T} = \mathbf{A}^{T} + \mathbf{B}^{T}$ | (Traspuesta 3) |

| (xiv) | $(\mathbf{A} \mathbf{B})^{T} = \mathbf{B} \mathbf{A}$ | (Traspuesta 4) |

Las matrices nos proporcionan una forma compacta de expresar sistemas de ecuaciones lineales, por ejemplo, el siguiente sistema $$ {\color{#89c9c8}\begin{cases} \color{black} 2x_1 + 4x_2 + 6x_3 = 18 \\ \color{black}4x_1 + 5x_2 + 6x_3 = 24 \\ \color{black}3x_1 + x_2 - 2x_3 = 4 \end{cases}} $$ puede ser representado como $$ {\color{#89c9c8} \underbrace{ \color{black} \begin{bmatrix} 2 & 4 & 6 \\ 4 & 5 & 6 \\ 3 & 1 & -2 \end{bmatrix} }_{\color{black}\mathbf{A}} \underbrace{ \color{black} \begin{bmatrix} x_1 \\ x_2 \\ x_3 \end{bmatrix} }_{\color{black}\mathbf{x}} = \underbrace{ \color{black} \begin{bmatrix} 18 \\ 24 \\ 4 \end{bmatrix} }_{\color{black}b} } \\ \iff \\ \mathbf{Ax} = \mathbf{b}$$ donde cada columna de $\mathbf{A}$ corresponde a los coeficientes de las variables del sistema, $\mathbf{x}$ el vector columna con las variables o incógnitas y $\mathbf{b}$ el vector columna de los términos independientes.

Existen varias formas de resolver este tipo de sistemas, por mencionar algunos, el método de eliminación Gausiana el cual es uno de los más conocidos y la regla de Cramer, el cual suele ser un método apropiado ya que en GC se suele trabajar con matrices cuadradas de dimensión menor o igual a 4.

En el método de eliminación de Gaussiana se obtiene las soluciones mediante la reducción del sistema de ecuaciones dado utilizando operaciones elementales, dichas operaciones se aplican a los renglones de la matriz aumentada, transformando la matriz de coeficientes en una matriz triangular superior (o sistema triangular) para así realizar las sustituciones adecuadas y obtener las soluciones.

Las operaciones elementales son las siguientes:

Por ejemplo, utilizando el sistema de ecuaciones anterior su matriz aumentada sería $$ \begin{bmatrix} 2 & 4 & 6 & | & 18\\ 4 & 5 & 6 & | & 24\\ 3 & 1 & -2 & | & 4 \end{bmatrix} $$ Y utilizando las operaciones elementales, podemos resolver el sistema de la siguiente forma

Mientras que con la regla de Cramer se calcula el valor de cada incógnita utilizando determinates. Es decir, considerado el sistema de ecuaciones $\mathbf{Ax} = \mathbf{b}$, podemos obtener las soluciones con $$ x_j = \frac{\text{det}(\mathbf{A}_j)}{\text{det}(\mathbf{A})}$$ donde $\mathbf{A}_j$ es la matriz resultante de reemplazar la $j$-ésima columna de $\mathbf{A}$ por el vector columna $\mathbf{b}$. Vale la pena mencionar que el sistema tendrá una solución única si y solo si $\text{det}(\mathbf{A}) \not = 0$.

Entonces la solución del sistema de ecuaciones anterior estaría dada por $$ x_1 = \frac{ \begin{vmatrix} \color{#00CED1}18 & 4 & 6 \\ \color{#00CED1}24 & 5 & 6 \\ \color{#00CED1}4 & 1 & -2 \end{vmatrix} } { \begin{vmatrix} 2 & 4 & 6 \\ 4 & 5 & 6 \\ 3 & 1 & -2 \end{vmatrix} } \quad x_2 = \frac{ \begin{vmatrix} 2 & \color{#00CED1}18 & 6 \\ 4 & \color{#00CED1}24 & 6 \\ 3 & \color{#00CED1}4 & -2 \end{vmatrix} } { \begin{vmatrix} 2 & 5 & 6 \\ 4 & 5 & 6 \\ 3 & 1 & -2 \end{vmatrix} } \quad x_3 = \frac{ \begin{vmatrix} 2 & 4 & \color{#00CED1}18 \\ 4 & 5 & \color{#00CED1}24 \\ 3 & 1 & \color{#00CED1}4 \end{vmatrix} } { \begin{vmatrix} 2 & 4 & 6 \\ 4 & 5 & 6 \\ 3 & 1 & -2 \end{vmatrix} } $$

Los sistemas lineales como el que hemos visto, es decir, en los que su vector $\mathbf{b}$ es distinto de cero se le denomina no homogéneos. Para este tipo de sistemas, existen tres posibilidades, que tenga:

Por el contrario, cuando todas las constantes que constituyen a su vector $\mathbf{b}$ son iguales a cero, se le denominan homogéneos. Y son un caso especial ya que solo tiene la posibilidad de tener una única solución, que es la trivial, donde todas las variables son cero, o bien, tiene un número infinito de soluciones.

En la se observa que se puede describir geométricamente un sistema de dos ecuaciones con dos incógnitas mediante dos líneas rectas en $\Reals^2$. Si las líneas tienen un punto de intersección entonces tiene una solución única; si coinciden tienen un número infinito de soluciones y si son paralelas no se tiene ninguna solución. Algo similar se puede observar en el segundo interactivo (), donde cada ecuación corresponde a un plano en $\Reals^3$.

El determinante de una matriz $n$-cuadrada $\mathbf{A}$ es un escalar especial derivado de las entradas de dicha matriz y se denota como $\text{det}(\mathbf{A})$ o $$ \begin{vmatrix} a_{11} & a_{12} & \cdots & a_{1n} \\ a_{21} & a_{22} & \cdots & a_{2n} \\ \vdots & \vdots & \ddots & \vdots \\ a_{n1} & a_{n2} & \cdots & a_{nn} \end{vmatrix} $$

El determinante para matrices de 1 y 2 dimensiones $$ \begin{vmatrix} a_{11} \end{vmatrix} = a_{11} \quad \text{ y } \begin{vmatrix} a_{11} & a_{12} \\ a_{21} & a_{22} \end{vmatrix} = a_{11}a_{22} - a_{12}a_{21} $$

Y si pensamos las dos columnas de la matriz como dos vectores columna en el plano, como vimos en el producto cruz, el determinante es el área (con signo) del paralelogramo formado por dichos vectores.

Consideremos ahora una matriz de dimensión 3, el determinante está dado por $$ \begin{vmatrix} a_{11} & a_{12} & a_{13} \\ a_{21} & a_{22} & a_{23} \\ a_{31} & a_{32} & a_{33} \end{vmatrix} = a_{11} \begin{vmatrix} a_{22} & a_{23} \\ a_{32} & a_{33} \end{vmatrix} - a_{12} \begin{vmatrix} a_{21} & a_{23} \\ a_{31} & a_{33} \end{vmatrix} + a_{13} \begin{vmatrix} a_{21} & a_{22} \\ a_{31} & a_{32} \end{vmatrix} $$ $$ = a_{11}a_{22}a_{33} + a_{12}a_{23}a_{31} + a_{13}a_{21}a_{32} - a_{13}a_{22}a_{31} - a_{12}a_{21}a_{33} - a_{11}a_{23}a_{32} $$

Y análogamnte si pensamos las tres columnas de la matriz como tres vectores columna el determinante nos da el volumen del paralelepípedo formado por los tres vectores (interactivo de la página anterior).

Como podemos notar el determinate está dado por una fórmula recursiva. De hecho, el desarrollo de Laplace, el cual nos permite calcular el determinante de matrices de elevadas dimensiones, consiste en descomponer al determinante en una suma de determinates menores, veamos cómo.

Consideremos a la matriz $\mathbf{A}$ de $n\times n$ y a la matriz $\mathbf{A}_{ij}$ de $(n-1)\times(n-1)$ que se obtiene de $\mathbf{A}$ al eliminar el $i$-ésimo renglón y la $j$-ésima columna, llamada menor $ij$ de $\mathbf{A}$.

Ahora bien, definamos al cofactor $ij$ de $\mathbf{A}$ como $$C(\mathbf{A})_{ij} = (-1)^{i+j} \text{det}(\mathbf{A}_{ij})$$ es decir, se toma al determinate del menor $ij$ y multiplicándolo por $(-1)^{i+j}$. Observese que $(-1)^{i+j}$ es $1$ cuando $i+j$ es par, y $-1$ en otro caso.

Entonces el determinante de $\mathbf{A}$ se calcula como $$ \text{det}(\mathbf{A}) = \sum_{k = 1}^{n} a_{ik} C(\mathbf{A})_{ik} \text{ sobre el renglón } i$$ O bien como $$ \sum_{k = 1}^{n} a_{kj} C(\mathbf{A})_{kj} \text{ sobre la colúmna } j$$

Podemos ver este proceso, en particular, sobre el primer renglón, en el cálculo de los determinates de dos y tres dimensiónes descritos previamente. En términos de la fórmula, esto es $$ \sum_{k = 1}^{n} a_{1k} C(\mathbf{A})_{1k} = \sum_{k = 1}^{n} (-1)^{1+k} a_{1k} \text{ det}(\mathbf{A}_{1k}).$$

Como podemos notar, a medida que $n$ incremente, los cálculos se vuelven astronómicos y el algoritmo ineficiente. No obstante, se suelen utilizan algunas de las propiedades que se enlistan a continuación para reducir los cálculos. Por otra parte, como mencionábamos antes, esto no suele ser un problema en graficación porque las matrices que se utilizan tienen en su mayoría no más de cuatro dimensiones.

| (i) | $\text{det}(\mathbf{I}) = 1$ | |

| (ii) | $\small|\cdots \mathbf{a}_i \dots \mathbf{a}_j \dots | = 0$ | es cero si dos columnas son múltiplos |

| (iii) | $\small| \dots k_1\mathbf{a}_1 + k_2\mathbf{a}_2 \dots | \\ = k_1| \dots \mathbf{a}_1 \dots | + k_2|\dots \mathbf{a}_2 \dots|$ | |

| (iv) | $\small| \cdots \mathbf{0} \dots | = 0$ | es cero si alguna columna es cero $\mathbf{0}$ |

| (v) | $\small| \dots \mathbf{a}_i \dots \mathbf{a}_j \dots | = - | \dots \mathbf{a}_j \dots \mathbf{a}_i \dots |$ | intercambio de columnas (o renglones) |

| (vi) | $\small | \cdots \mathbf{a}_i \dots \mathbf{a}_j \dots | = | \cdots \mathbf{a}_i + k\mathbf{a}_j \dots \mathbf{a}_j \dots |$ | suma del múltiplo de una columna a otra |

| (vii) | $\text{det}(\mathbf{A}) = \text{det}(\mathbf{A}^T)$ | |

| (vii) | $\text{det}(\mathbf{AB}) = \text{det}(\mathbf{A})\text{det}(\mathbf{B})$ | |

| (ix) | $\text{det}(\mathbf{A^{-1}}) = \frac{1}{\text{det}(\mathbf{A})}$ |

Para calcular la matriz inversa primero necesitamos definir a la matriz adjunta de una matriz cuadrada $\mathbf{A}$.

Sea $\mathbf{C}$ la matriz de cofactores de $\mathbf{A}$, es decir, cada elemento $(i,j)$ de $\mathbf{C}$ corresponde al cofactor $C(\mathbf{A})_{ij} = (-1)^{i+j} \text{det}(\mathbf{A}_{ij})$. Entonces, podemos definir a la matriz adjunta como la traspuesta de $\mathbf{C}$.

Esto es $$ \text{adj}\mathbf{A} = \begin{bmatrix} \mathbf{C}(\mathbf{A}_{11}) & \mathbf{C}(\mathbf{A}_{21}) & \cdots & \mathbf{C}(\mathbf{A}_{n1}) \\ \mathbf{C}(\mathbf{A}_{12}) & \mathbf{C}(\mathbf{A}_{22}) & \cdots & \mathbf{C}(\mathbf{A}_{n2}) \\ \vdots & \vdots & \ddots & \vdots \\ \mathbf{C}(\mathbf{A}_{1n}) & \mathbf{C}(\mathbf{A}_{2n}) & \cdots & \mathbf{C}(\mathbf{A}_{nn}) \end{bmatrix}$$ Ahora, como

$$ \mathbf{A}(\text{adj}\mathbf{A}) = \begin{bmatrix} a_{11} & a_{12} & \cdots & a_{1n} \\ a_{21} & a_{22} & \cdots & a_{2n} \\ \vdots & \vdots & \ddots & \vdots \\ a_{n1} & a_{n2} & \cdots & a_{nn} \end{bmatrix} \begin{bmatrix} \mathbf{C}(\mathbf{A}_{11}) & \mathbf{C}(\mathbf{A}_{21}) & \cdots & \mathbf{C}(\mathbf{A}_{n1}) \\ \mathbf{C}(\mathbf{A}_{12}) & \mathbf{C}(\mathbf{A}_{22}) & \cdots & \mathbf{C}(\mathbf{A}_{n2}) \\ \vdots & \vdots & \ddots & \vdots \\ \mathbf{C}(\mathbf{A}_{1n}) & \mathbf{C}(\mathbf{A}_{2n}) & \cdots & \mathbf{C}(\mathbf{A}_{nn}) \end{bmatrix} $$ $$ = \begin{bmatrix} \text{det}(\mathbf{A}) & 0 & \cdots & 0 \\ 0 & \text{det}(\mathbf{A}) & \cdots & 0 \\ \vdots & \vdots & \ddots & \vdots \\ 0 & 0 & \cdots & \text{det}(\mathbf{A}) \end{bmatrix} = \text{det}(\mathbf{A})\mathbf{I} $$

Pues es fácil ver que al multiplicar el renglón $i$ de $\mathbf{A}$ por la columna $j$ de $\text{adj}\mathbf{A}$ se tiene la suma $\sum_{k = 1}^{n} a_{ik} C(\mathbf{A})_{jk}$, por lo que sí $i = j$ nos queda la expansión de $\text{det}(\mathbf{A})$ sobre el rengón $i$ de $\mathbf{A}$, por otro lado, sí $i \not = j$ la suma es igual a $0$. Ánalogamente para $(\text{adj}\mathbf{A})\mathbf{A} = \text{det}(\mathbf{A})\mathbf{I}.$

Por consiguiente, sí $\text{det} \not = 0$, entonces podemos calcular su invesa con $$\mathbf{A}^{-1} = \frac{1}{\text{det}(\mathbf{A})} \text{adj}\mathbf{A}.$$

Ya que $$ \mathbf{A} \Big ( \frac{1}{\text{det}(\mathbf{A})} \text{adj}\mathbf{A} \Big ) = \frac{1}{\text{det}(\mathbf{A})} [\mathbf{A}(\text{adj}\mathbf{A})] = \frac{1}{\text{det}(\mathbf{A})} \text{det}(\mathbf{A})\mathbf{I} = \mathbf{I} $$ Y como por definición tenemos que $\mathbf{A}\mathbf{B} = \mathbf{I} \Rightarrow \mathbf{B} = \mathbf{A}^{-1}$. Entonces $\dfrac{1}{\text{det}(\mathbf{A})} \text{adj}\mathbf{A} = \mathbf{A}^{-1}$.

En particular, calcular la matriz inversa de una matriz $2\times2$ es muy sencillo. Consideremos la matriz $\mathbf{A}$ de $2\times2$ y con $\text{det}(\mathbf{A}) \not = 0$, entonces su matriz adjunta es $$ \text{adj}\mathbf{A} = \begin{bmatrix} \mathbf{C}(\mathbf{A}_{11}) & \mathbf{C}(\mathbf{A}_{21}) \\ \mathbf{C}(\mathbf{A}_{12}) & \mathbf{C}(\mathbf{A}_{22}) \end{bmatrix} = \begin{bmatrix} a_{22} & -a_{12} \\ -a_{21} & a_{11} \end{bmatrix} $$

por lo que se tiene $$ \mathbf{A}^{-1} = \frac{1}{\text{det}(\mathbf{A})} \text{adj}(\mathbf{A}) = \frac{1}{a_{11}a_{22} - a_{12}a_{21}} \begin{bmatrix} a_{22} & -a_{12} \\ -a_{21} & a_{11} \end{bmatrix}. $$

A continuación se muestra un ejemplo del cálculo de la inversa de una matriz.

Existen un número infinito de bases con las que podemos trabajar, ya que como vimos en el tema de Espacios vectoriales, bases y coordenadas, dentro de un espacio vectorial de dimensión $n$, cualesquiera $n$ vectores linealmente independientes pueden formar una base.

Consideremos a los conjuntos de vectores $S_1 = \{\mathbf{e}_{1}, \mathbf{e}_{2}, ..., \mathbf{e}_{n}\}$ y $S_2 = \{\mathbf{\widehat{e}}_{1}, \mathbf{\widehat{e}}_{2}, ..., \mathbf{\widehat{e}}_{n}\}$ como dos bases del espacio vectorial $V$ $n$-dimensional.

Entonces podemos tomar a un vector cualquiera $\mathbf{u} \in V$, el cual puede ser descrito en términos de los vectores de la base $S_1$ como

$$ \mathbf{u}_{S_1} = \begin{bmatrix} u_1 \\ u_2 \\ \vdots \\ u_n \end{bmatrix} ; \quad \text{es decir, } \mathbf{u} = u_{1}e_{1} + u_{2}e_{2} + ... + u_{n}e_{n} $$

De manera similar, ese mismo vector puede ser expresado usando la base $S_2$ como $$ \mathbf{u}_{S_2} = \begin{bmatrix} \widehat{u}_1\\ \widehat{u}_2 \\ \vdots \\ \widehat{u}_n \end{bmatrix} ; \quad \text{es decir, } \mathbf{u} = \widehat{u}_{1}\widehat{e}_{1} + \widehat{u}_{2}\widehat{e}_{2} + ... + \widehat{u}_{n}\widehat{e}_{n} $$

Ahora, dependiendo de lo que se busque podemos construir la matriz de cambio de base. Llamaremos a $S_1$ como la base "original" y a $S_2$ como la base "nueva".

Definimos la matriz de cambio de base $\mathbf{P}$ como la matriz que transforma las coordenadas de $\mathbf{u}_{S_2}$ a coordenadas de la base original, esto es $$ \mathbf{P}\mathbf{u}_{S_2} = \mathbf{u}_{S_1} $$

Para ello, escribimos a cada vector $\mathbf{\widehat{e}}_i$ de la base nueva $S_2$ en términos de la base original $S_1$, es decir

$$ \mathbf{\widehat{e}}_1 = b_{11}\mathbf{e}_1 + b_{21}\mathbf{e}_2 + ... + b_{n1}\mathbf{e}_n \\ \mathbf{\widehat{e}}_2 = b_{12}\mathbf{e}_1 + b_{22}\mathbf{e}_2 + ... + b_{n2}\mathbf{e}_n \\ \vdots \\ \mathbf{\widehat{e}}_n = b_{1n}\mathbf{e}_1 + b_{2n}\mathbf{e}_2 + ... + b_{nn}\mathbf{e}_n $$

Por lo que si sustituímos en $\mathbf{u}_{S_2}$, tenemos $$ \mathbf{u} = \widehat{u}_{1}(b_{11}\mathbf{e}_1 + b_{21}\mathbf{e}_2 + ... + b_{n1}\mathbf{e}_n) \\ + \widehat{u}_{2}(b_{12}\mathbf{e}_1 + b_{22}\mathbf{e}_2 + ... + b_{n2}\mathbf{e}_n) + \\ \qquad \vdots \qquad \\ + \widehat{u}_{n}(b_{1n}\mathbf{e}_1 + b_{2n}\mathbf{e}_2 + ... + b_{nn}\mathbf{e}_n) $$

Entonces $$ \mathbf{P} = \begin{bmatrix} b_{11} & b_{12} & \cdots & b_{1n} \\ b_{21} & b_{22} & \cdots & b_{2n} \\ \vdots & \vdots & \ddots & \vdots \\ b_{n1} & b_{n2} & \cdots & b_{nn} \end{bmatrix} $$