Estadística, probabilidad e inferencia

INTERACTIVO

Juan Jesús Cañas Escamilla

José Román Galo Sánchez

Red Educativa Digital Descartes

Fondo Editorial RED Descartes

Córdoba (España)

2022

Título de la obra:

Estadística, probabilidad e inferencia

Interactivo

Autores:

Juan Jesús Cañas Escamilla

José Román Galo Sánchez

Editor técnico:

Juan Guillermo Rivera Berrío

Código JavaScript para el libro: Joel Espinosa Longi, IMATE, UNAM.

Núcleo del libro interactivo: julio 2022.

Recursos interactivos: DescartesJS

Fuentes: Lato y UbuntuMono

Fórmulas matemáticas: $\KaTeX$

Red Educativa Digital Descartes

Córdoba (España)

descartes@proyectodescartes.org

https://proyectodescartes.org

Proyecto iCartesiLibri

https://proyectodescartes.org/iCartesiLibri/index.htm

ISBN: 978-84-18834-44-8

Esta obra está bajo una licencia Creative Commons 4.0 internacional: Reconocimiento-No Comercial-Compartir Igual.

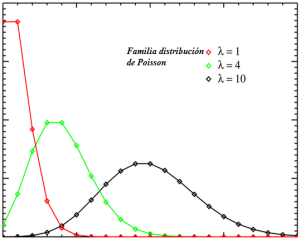

Pierre-Simon Laplace (Normandía, Francia, 23 de marzo de 17491 - París, 5 de marzo de 1827) fue un astrónomo, físico y matemático francés, como estadístico sentó las bases de la teoría analítica de la probabilidad (Crédito: Jean-Baptiste Paulin Guérin - http://www.photo.rmn.fr/, Dominio público, https://es.wikipedia.org/)

Este libro digital interactivo se ha diseñado utilizando el editor de DescartesJS, de tal forma que se pueda leer en ordenadores y dispositivos móviles sin necesidad de instalar ningún programa o plugin.

El libro es una tercera versión del publicado por los mismos autores en el proyecto iCartesiLibri (Estadistica Probabilidad e Inferencia).

Juan Jesús Cañas Escamilla

José R. Galo Sánchez

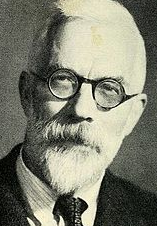

Francis Galton (Birmingham, 16 de febrero de 1822 - Haslemere, Surrey, 17 de enero de 1911) fue un polímata, antropólogo, geógrafo, explorador, inventor, meteorólogo, estadístico, psicólogo y eugenista británico, creó el concepto estadístico de correlación y regresión hacia la media (Crédito: Eveleen Myers - http://www.npg.org.uk/collections/, Dominio público, https://es.wikipedia.org/).

Vivimos en un mundo que cambia de forma acelerada. Todos formamos parte de una monumental gran base de datos a la que continuamente acceden y utilizan desde los estados y grandes multinacionales hasta el negocio más pequeño o el individuo más alejado de la última aldea de cualquier país. Ya nada es ajeno a nadie. Lo que ocurre en cualquier lugar del mundo es presentado por los medios de comunicación prácticamente en directo en los salones de las casas o en los teléfonos inteligentes de cada individuo, estableciéndose así multitud de interrelaciones que avivan la interdependencia de todos y todo termina por influir de un modo u otro en el resto. Esta nueva situación de aldea global proporciona a la estadística un nuevo y mayor protagonismo en prácticamente todos los aspectos de la vida.

Todas las ciencias, animadas por las nuevas posibilidades que permiten el manejo y la rápida transmisión de imponentes bases de datos utilizan a la estadística como herramienta básica de su espectacular desarrollo.

Este nuevo contexto nos sitúa en un punto de partida inicial motivante para iniciar nuestro curso.

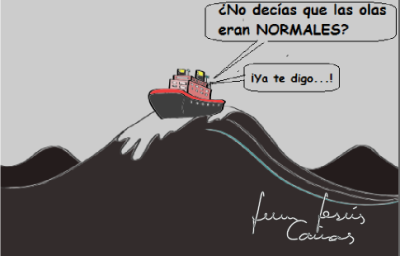

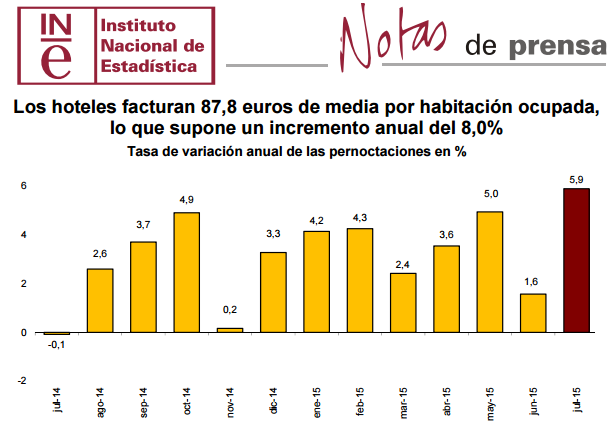

Como ya se ha mencionado, el primer contacto que se suele tener con la Estadística suele ser a través de los medios de comunicación. La lectura rápida de cualquier periódico enfoca nuestra atención en los titulares y en la imagen de portada. Es aquí donde se suelen presentar las tablas y gráficos estadísticos que tienen la gran virtud de actuar como elemento acaparador de atención, aunando tanto una capacidad importante de información como una gran facilidad y sencillez a la hora del descifrado de la misma.

Esta primera idea que todos tenemos puede suponer un aceptable punto de partida inicial para comenzar nuestro curso.

La palabra Estadística etimológicamente deriva de la palabra "status", que significa estado o situación.

Vamos a reflejar algunas pinceladas rápidas sobre la aparición de la Estadística, o algo parecido a ella, en algunos momentos históricos.

Seguramente para encontrar pistas sobre el origen de la estadística, tendríamos que remontarnos a antes del comienzo mismo de la propia Historia. Restos arqueológicos y monumentos prehistóricos contienen signos y muescas que pueden interpretarse como referencias a posibles anotaciones sobre cantidades, probablemente de ganado y caza que pueden indicarnos un rudimentario sistema de control sobre determinados datos.

|

|

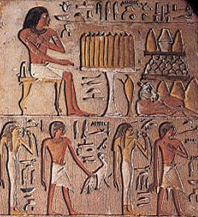

En muchos monumentos egipcios se encontraron interesantes estelas, jeroglíficos, en una palabra, "documentos" en los que se puede interpretar una gran organización y administración estatal en lo que se refiere a contabilización de riqueza agrícola, ganadera e industrial, así como a movimientos poblacionales, censos, etc.

|

|

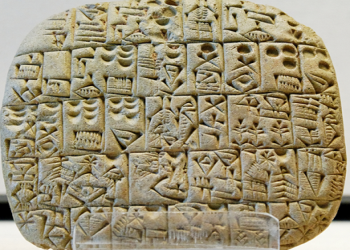

En la cultura asiria o mesopotámica se conservan tablillas con inscripciones cuneiformes sobre importantes datos estadísticos referentes a producciones agrícolas, ganaderas, así como también datos sobre contabilidad, medicina, astronomía, etc.

|

|

En la Biblia también podemos encontrar referencias estadísticas. Así por ejemplo, en uno de los libros del Pentateuco, bajo el nombre de Números, puede leerse lo que podría interpretarse como el censo que realizó Moisés después de la salida de Egipto.

“Haz un censo general de toda la asamblea de los hijos de Israel, por familias y por linajes, describiendo por cabezas los nombres de todos los varones aptos para el servicio de armas en Israel”.

|

|

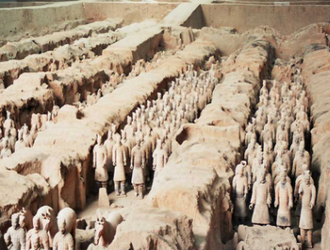

En China aparecen innumerables documentos con referencias a poblaciones, censos, recuentos bienes agrícolas, ganaderos, de origen militar. Por ejemplo, en uno de sus clásicos "Shu-King" escrito hacia el año 550 a.C., Cunfucio nos narra cómo el Rey Yao en el año 2238 mandó hacer una estadística agrícola, industrial y comercial en todos sus dominios.

|

|

Grecia, la cuna del pensamiento occidental, también tuvo importantes observaciones estadísticas en lo que refiere a distribución de terreno, servicio militar, etc.

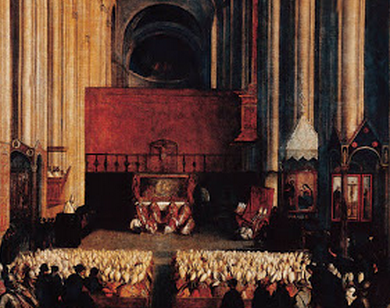

Es en Roma donde puede decirse que la Estadística adquiere un gran desarrollo. La burocracia romana utiliza la Estadística como instrumento de apoyo a la gran capacidad organizativa política, jurídica y administrativa del imperio. Una muestra es el Census que se realizaba cada 5 años y que tenía por objeto no sólo saber el número de habitantes, sino también su cantidad de bienes. El propio origen de la cultura cristiana está ligado a uno de los censos romanos

|

|

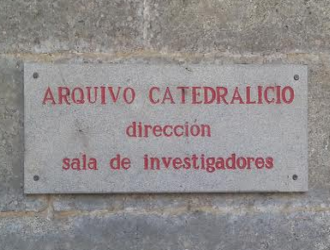

La Iglesia, después del Concilio de Trento estableció la obligación de la inscripción de nacimientos, matrimonio y defunciones de la población cristiana, con lo que se erige como creadora y también custodia de una impresionante base de datos de los cuales se han servido posteriormente las ciencias sociales para la elaboración de multitud de estudios.

|

|

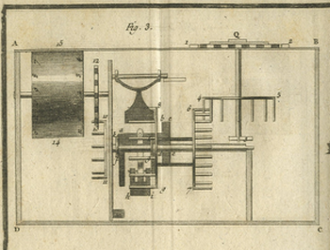

En la edad moderna se produce un gran desarrollo científico- matemático que enriquece mucho a la Estadística. Científicos importantes de esta época como Copérnico, Galileo, Bacon, Descartes…, contribuyen al desarrollo de lo que se conoce como el método científico donde la estadística tiene un papel fundamental.

Blaise Pascal y Christiaan Huygens, en el siglo XVII, realizan trabajos con bases de datos relativas a nacimientos y defunciones y la influencia de causas naturales y sociales en estas variables.

|

|

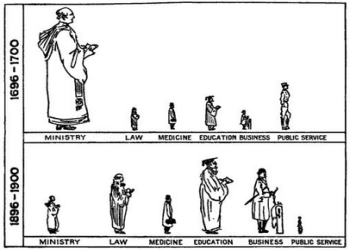

En el siglo XIX la estadística entra en una nueva fase de su desarrollo con el auge y generalización del método científico en todas las ciencias, tanto naturales como sociales. Figuras muy relevantes de esta época serían Francis Galton (1822 - 1911) y Karl Pearson (1857 – 1936), verdaderos pioneros de la estadística moderna.

|

|

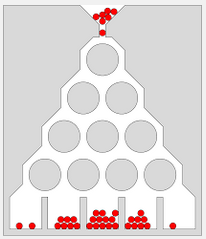

Siguiendo los pasos de Galton, Ronald Fisher (1890 – 1962), en su publicación Métodos estadísticos para investigadores establece los fundamentos de la metodología estadística actual.

Con la aparición de los ordenadores, en la segunda mitad del siglo XX, la estadística entra en una nueva era en la que metodología gira hacia técnicas de computación rápidas e iterativas que permiten actuar sobre grandes bases de datos en muy poco tiempo. Los paquetes estadísticos se popularizan y su aplicación en las distintas ciencias también.

|

|

Así pues, la estadística aparece a lo largo de la historia como un poderoso instrumento utilizado por gobiernos e instituciones así como tambien elemento auxiliar de las distintas ciencias, ayudando a estas a desentrañar las grandes preguntas que la curiosidad del ser humano siempre ha perseguido; es decir: qué variables intervienen en un fenómeno, que leyes permiten el comportamiento de las mismas y qué relación de dependencia hay entre ellas.

Video

En el siguiente vídeo, elaborado por la UNED, podemos ver una historia de la Estadística.

La estadística, en general, es la ciencia que trata de la recopilación, organización presentación, análisis e interpretación de datos que intervienen en un fenómeno, con el fin de realizar una perfecta descripción y en gran parte inferir resultados o tomar decisiones.

Dentro de la estadística se distinguen dos ramas fundamentales,

En la anterior escena interactiva tienes una introducción a la Estadística.

A continuación recordamos algunos de los conceptos generales relacionados con la estadística.

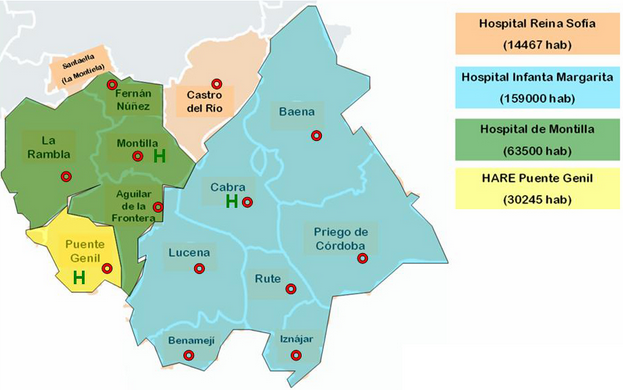

Es obvio que todo estudio estadístico ha de estar referido a un conjunto o colección de objetos. Este conjunto de personas o cosas es lo que denominaremos población.

Cada uno de estos objetos que forman parte de la población se denominan elemento o individuo. En sentido estadístico un individuo puede ser algo con existencia real, como un automóvil o una casa, o algo mucho más abstracto como la temperatura, una opinión, un voto, un sentimiento o un intervalo de tiempo.

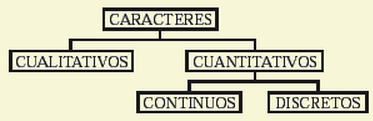

A su vez, cada elemento de la población tiene una serie de características que pueden ser objeto del estudio estadístico (carácter). Así, por ejemplo, si consideramos como elemento a una persona, podemos distinguir en ella multitud de caracteres como el sexo, la edad, estatura, peso, color de pelo, nivel de estudios, etc.

Normalmente en un estudio estadístico hay muchos condicionantes y de distinta naturaleza que impiden trabajar con todos los elementos de la población, por tanto, se suele recurrir a un subconjunto de la misma.

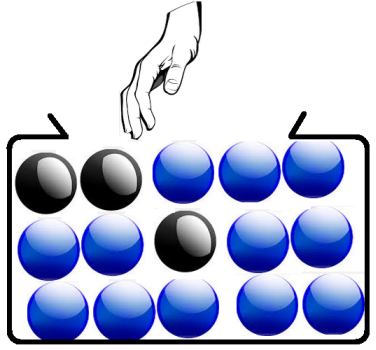

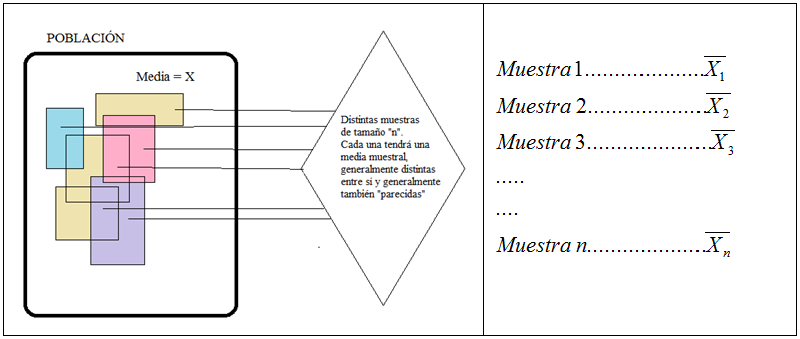

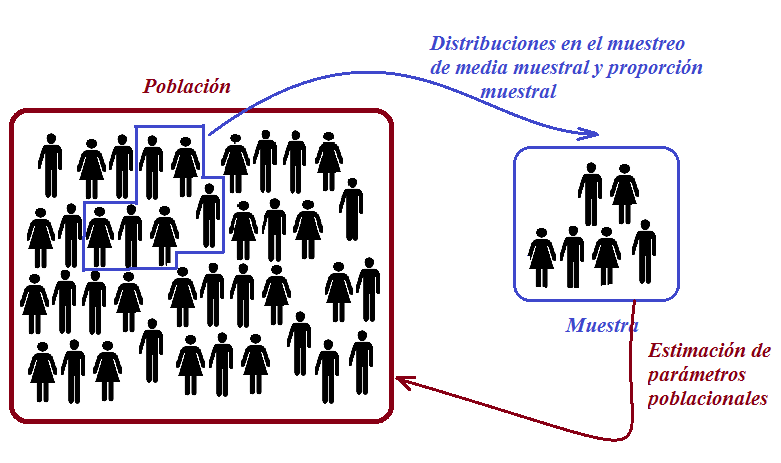

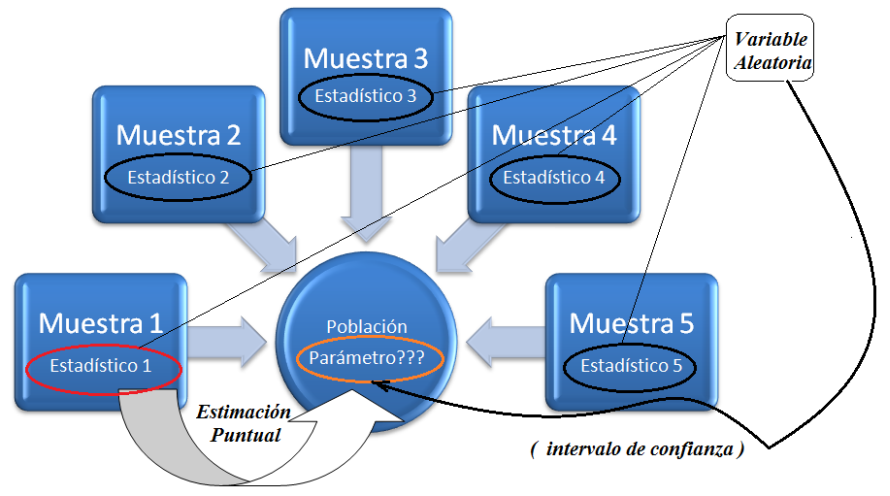

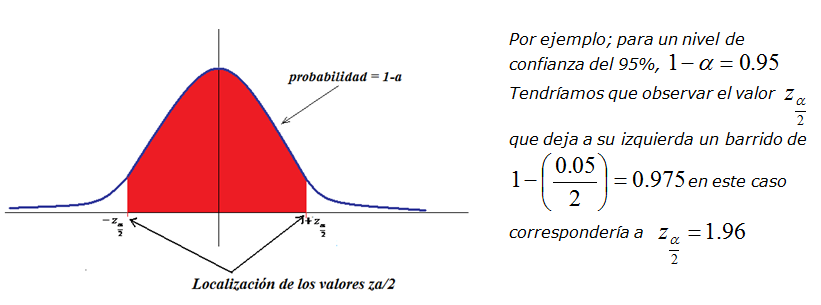

Una muestra es cualquier subconjunto de una población. Cuando los elementos que componen la muestra están escogidos aleatoriamente y todos los elementos tienen la misma probabilidad de ser elegidos diremos que la muestra es aleatoria simple.

|

|

En las siguientes escenas del subproyecto ED@D (Educación Digital con Descartes) de la RED Descartes podrás practicar un poco con los conceptos anteriores.

El paso siguiente a la recogida de datos en un trabajo de campo es una primera presentación de los mismos de manera que dicha representación sea fácil de visualizar, sencilla de interpretar y directa. Estas cualidades se reflejan bastante bien en las tablas estadísticas. Las listas, boletines y actas de notas, clasificación de equipos con puntuaciones, detalles de los goles, todo son en realidad tabulaciones de datos.

Con bastante frecuencia y como complemento a las tablas se recurre a los gráficos estadísticos. La mayor parte de la información que recibimos hoy en día proviene fundamentalmente de los medios de comunicación de masas.

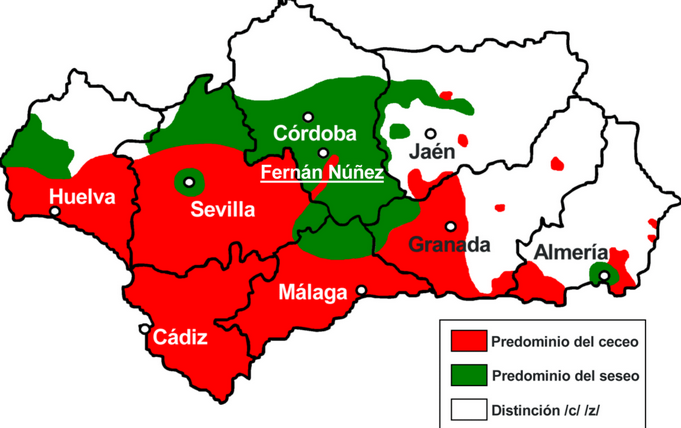

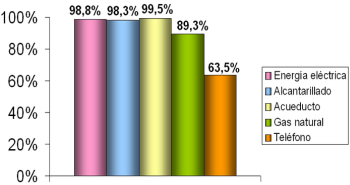

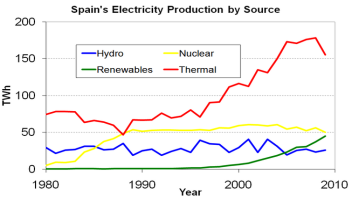

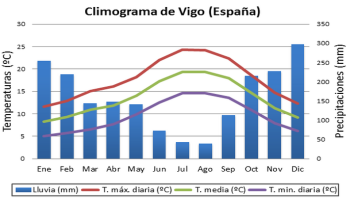

En prensa, internet y televisión fundamentalmente, y también en las ciencias sociales, se recurre de manera muy habitual a los gráficos estadísticos (pictogramas, climogramas, pirámides de población, diagramas de barras, de sectores) como elementos aglutinadores de la información a la par que fáciles de descifrar. Los gráficos estadísticos por tanto, constituyen también una herramienta fundamental en lo que se refiere a una primera información sencilla y rápida de las características más elementales de una distribución estadística.

|

|

|

|

|

|

Cualquier estudio estadístico comienza con la recogida de datos. Esta recogida puede ser física y directa o virtual mediante la importación de ficheros procedentes de distintas instituciones u organismos.

El segundo paso es la presentación de estos datos de forma sencilla, coherente y a ser posible atractiva para el lector. En este sentido, la estadística dispone los datos generalmente en tablas y se ayuda, a su vez, en muchas ocasiones de gráficos que resumen o aclaran aspectos reseñables de la distribución.

La forma más sencilla de tabular una variable estadística es mediante columnas. En la primera se proponen los distintos valores, generalmente ordenados, de la variable estadística o del correspondiente atributo. En la segunda, la cuantificación de esos valores en nuestro estudio, esto es las frecuencias absolutas. De esta forma efectuamos una tabulación mínima.

Desde el punto de vista didáctico, la tabulación se completa con varias columnas más en las que se anotan también las frecuencias relativas, y las acumuladas, tanto absolutas como relativas.

Generalmente las tablas que nos encontraremos reunirán la información mínima necesaria para la representación gráfica y el cálculo de parámetros estadísticos fundamentales en una distribución.

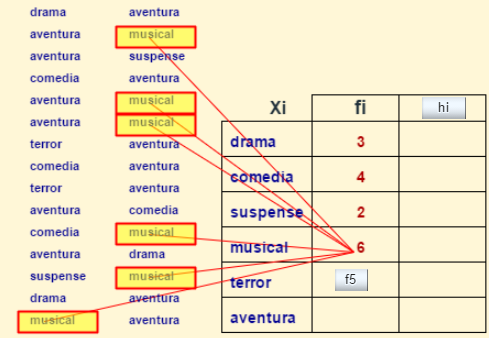

Para el caso de un carácter cualitativo:

Observa lo anterior en la siguiente imagen:

Y ahora realiza algunos ejercicios de tabulación en la siguiente escena interactiva.

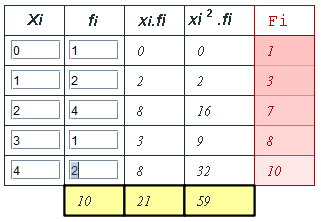

Para el caso de una variable discreta

Observa una tabulación mínima en la siguiente imagen:

Y ahora realiza algunos ejercicios de tabulación en la escena interactiva presentada en la siguiente página.

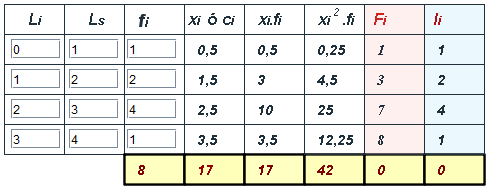

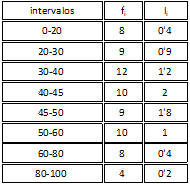

Para el caso de una variable continua:

Observa una tabulación mínima en la siguiente imagen:

Y ahora realiza algunos ejercicios de tabulación en la siguiente escena interactiva.

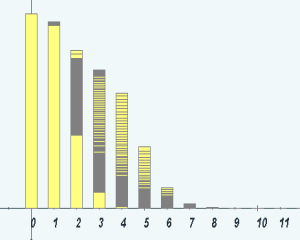

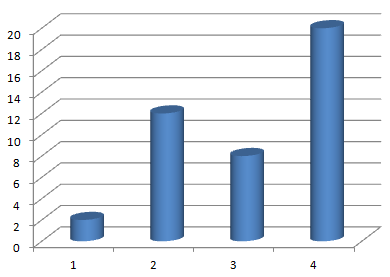

Diagramas de barras

El diagrama de barras es, junto al de sectores, el gráfico más utilizado para variable cualitativa y cuantitativa discreta. Se utiliza como complemento a la tabla de frecuencias o incluso en algunos casos como sustitución de ésta.

En el eje de abscisas se sitúan a igual distancia los distintos atributos o bien los valores discretos de la variable y posteriormente a partir de cada atributo o valor discretos se levantan barras de igual grosor y cuya altura sea la de la correspondiente frecuencia absoluta observada.

En la siguiente escena puedes observar como se construyen diagramas de barras y practicar realizando algunos ejemplos.

Y ahora practica en la escena interactiva de la siguiente página, realizando tú los gráficos.

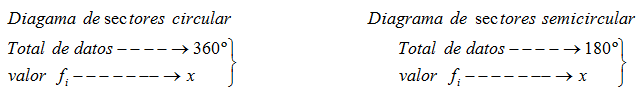

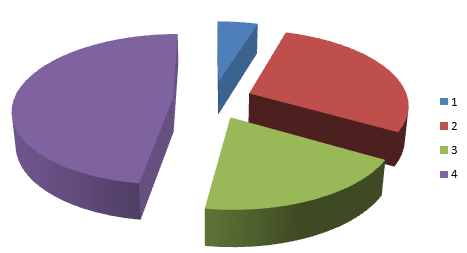

Diagrama de sectores

Tiene la misma filosofía de construcción que el diagrama de barras pero la representación en sectores circulares, figuradamente trozos de tarta. Requiere previamente que mediante proporcionalidaad directa asignemos a cada fecuencia absoluta un determinado ángulo.

En las siguientes escenas puedes observar como se construyen diagramas de sectores (pasa el ratón por los recuadros de colores).

Y ahora practica realizando tú los gráficos.

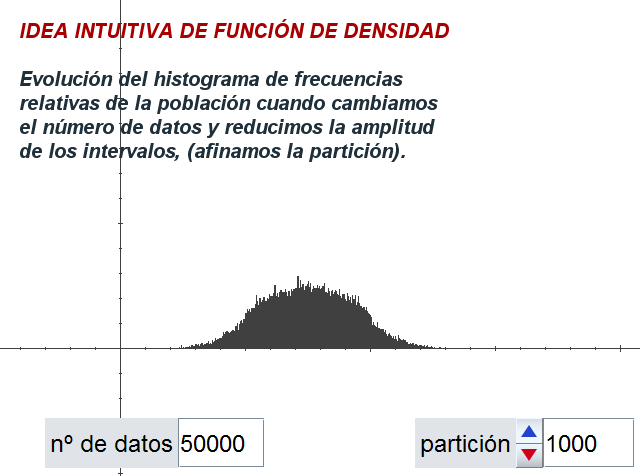

Histograma

Este tipo de gráfico es el que se utiliza con más frecuencia en el caso de variables cuantitativas continuas. Los datos se representan mediante rectángulos de base igual a la amplitud del intervalo y altura igual a la frecuencia absoluta si todos los intervalos tienen la misma amplitud.

Si no se cumple esta premisa de igualdad de amplitud, las alturas de los rectángulos serán calculadas de tal manera

que el área total de cada rectángulo

represente o sea proporcional a la

correspondiente frecuencia absoluta,

esto habitualmente se conoce con el

nombre de normalidar las frecuencias,

(dividir cada frecuencia entre la amplitud

del intervalo).

Si se unen los centros de los segmentos

superiores de cada rectángulo, se obtiene

una figura poligonal conocida como Polígono de frecuencias.

Cuando realizamos los gráficos anteriores utilizando

las frecuencias acumuladas obtenemos el denominado histograma de frecuencias acumuladas y el polígono de fecuencias acumuladas.

En la escena de la siguiente página, puedes generar

datos, hacer el recuento y ver el histograma

correspondiente.

También se traza el histograma de las frecuencias acumuladas, en cada dato se acumula la frecuencia de los datos anteriores.

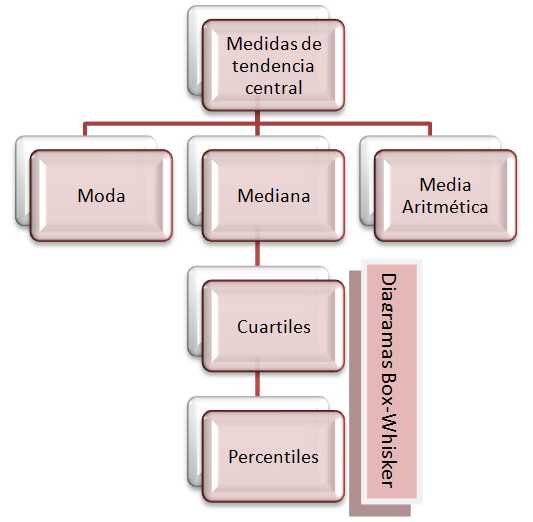

Todos sabemos lo que significa la nota media de los exámenes de un curso, o el hermano mediano en una familia o seguir la moda en cuanto a determinada tendencia. En estadística vamos a estudiar ciertos valores que resuman la tendencia habitual o central de los datos de una distribución. A los parámetros o medidas estadísticas que informan sobre la tendencia habitual o central de los datos de una distribución se les denomina en estadística medidas de tendencia central. Las más utilizadas son la media aritmética, la mediana y la moda.

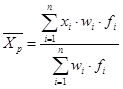

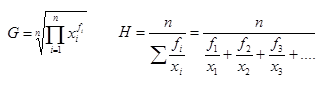

La palabra media, se ha incorporado al diccionario de cualquier persona. Continuamente nos estamos refiriendo a ella desde todos los órdenaes de la vida. hablamos de gasto medio, de sueldo medio, consumo eléctrico medio, notas medias, estar por encima de la media en consumo de tal cosa, inflacción media etc... En estadística la definición de media aritmética es muy sencilla. La media aritmética se define como la suma de todos los datos dividida entre el número total de los mismos. A veces no dispondremos de los valores concretos de los datos sino de una agrupación de los mismos en intervalos. En estos casos tendremos que elegir un valor de cada intervalo y que intervendrá en representación del mismo en el cálculo de la media. Como habitualmente dispondremos de una tabla de datos con sus correspondientes frecuencias absolutas, aplicaremos la siguiente fórmula:

Abreviadamente:

De la propia definición de media aritmética se desprenden algunas características y comentarios acerca de este parámetro, como por ejemplo:

| Para el caso de variable continua, sola- mente tenemos que sustituir $x_i$ por $c_i$, siendo ésta última la marca de clase de cada intervalo; es decir, el punto medio o valor central de cada intervalo. Por abuso de lenguaje se suele utilizar indistintamente también para variables continuas el símbolo $x_i$ para las marcas de clase | $$\={X} = \frac{\sum_{i=1}^n c_i\cdot f_i}{N}$$ |

Practica con el cálculo de la media para variable discreta.

Observa ejemplos para el cálculo de la media para variable discreta y continua.

En esta otra escena puedes ver más ejemplos.

Para completar el estudio sobre la media también puedes consultar más información sobre la Media ponderada pulsando sobre la imagen siguiente:

y sobre la Media geométrica y la Media armónica pulsando sobre esta otra imagen:

Todo el mundo entiende cuál es el hijo mediano de un matrimonio o lo que significa tener una altura mediana.

Estamos ante un parámetro que prioriza más la posición que ocupa el dato en cuestión que el propio valor en sí mismo.

Supongamos tres hermanos de $2, 7$ y $10$ años respectivamente. La mediana en este caso es $7$. Si otra familia también tiene tres hijos de $6, 7$ y $15$ años, la mediana también es $7$. Hemos cambiado los datos extremos y sin embargo la mediana no ha variado. Se define la mediana como aquel valor de la variable estadística que deja el $50\%$ de observaciones inferiores a él; así pues, la mediana divide en dos partes iguales a la distribución estadística. A partir de la definición se pueden extraer unas primeras propiedades de la mediana:

En el caso continuo se puede razonar exactamente igual identificando en este caso el intervalo mediana.

Si queremos asociar a la mediana un valor representativo del intervalo, muchos autores señalan simplemente la marca de clase de dicho intervalo y otros están de acuerdo en utilizar una fórmula que interpola linealmente el valor en el intervalo en el que se encuentre la mediana.

$$\begin{split} L_{i-1} &= \text{Límite inferior del intervalo mediana}\\ a &= \text{Amplitud del intervalo mediana}\\ F_{i-1} &= \text{Frecuencia acumulada anterior al intervalo mediana}\\ f_i &= \text{Frecuencia absoluta del intervalo mediana}\\ N &= \text{Total de datos} \end{split}$$

| En la siguiente escena puedes practicar con el cálculo de la mediana en casos muy sencillos, (pocos datos) y en otros en los que es necesaria la tabulación de los datos. Puedes también observar el polígono de frecuencias acumuladas y la interpretación gráfica de la mediana que se hace sobre este polígono en caso de variable discreta. |

|

En la siguiente escena puedes realizar ejercicios de cálculo de la mediana para caso discreto y del intervalo mediana para el caso continuo.

Nota: Para realizar ejercicios con la calculadora pasa al apartado número 6 de este tema.

Cuando alguien nos dice que determinada cosa está de moda, por ejemplo un equipo de fútbol, una canción, una prenda de vestir, un oficio, una tendencia u opinión política, etc., entendemos que ese algo es muy frecuente en nuestro entorno y que por tanto nos lo vamos a encontrar con mucha frecuencia.

Se define la moda como el valor de la variable estadística que tiene la frecuencia absoluta más alta. Si existen varios valores con esta característica, entonces se dice que la distribución tiene varias modas (distribución plurimodal).

Esta medida de centralización se puede calcular también en el caso de un carácter cualitativo y es sin duda la de más fácil cálculo. Se suele utilizar como complemento a la media aritmética y mediana ya que por sí sola no aporta una información determinante de la distribución.

Como principales características de la moda se pueden mencionar:

En el caso de variable continua se puede hablar de intervalo modal. Si queremos asociar un valor concreto del intervalo, algunos autores acuerdan utilizar la marca de clase y otros, cuando la amplitud de los intervalos es la misma, una fórmula que interpola linealmente el valor en el intervalo a partir de los intervalos anterior y posterior.

$$\begin{split} L_{i-1} &= \text{Límite inferior del intervalo modal}\\ a &= \text{Amplitud de los intervalos}\\ D_1 &= \text{Diferencia de la frecuencia absoluta entre el intervalo modal}\\ & \;\;\;\;\;\;\;\text{y el anterior}\\ D_2 &= \text{Diferencia de la frecuencia absoluta entre el intervalo modal}\\ & \;\;\;\;\;\;\;\text{y el siguiente} \end{split}$$

En la siguiente escena puedes practicar con el cálculo de la moda para variable discreta. También puedes relacionar el valor modal con el diagrama de barras en cada ejercicio que realices.

En la siguiente escena puedes practicar con el cálculo del intervalo modal para variable continua en el caso en que los intervalos tengan la misma amplitud. También en la escena puedes relacionar el valor modal con el histograma de frecuencias absolutas.

¿Cómo proceder cuando en una variable continua los intervalos de agrupación de los datos no son todos de la misma amplitud? Pulsa sobre la siguiente imagen y podrás verlo:

En las siguientes escenas puedes practicar con el cálculo de la moda y resto de parámetros para variables discretas, continuas y también continuas con intervalos de diferente amplitud. Es conveniente que realices algunos ejercicios de forma manual y que compruebes los resultados con los que se obtienen en la escena.

Variable discreta

Variable continua

Nota: Para realizar ejercicios con la calculadora pasa al apartado número 6 de este capítulo.

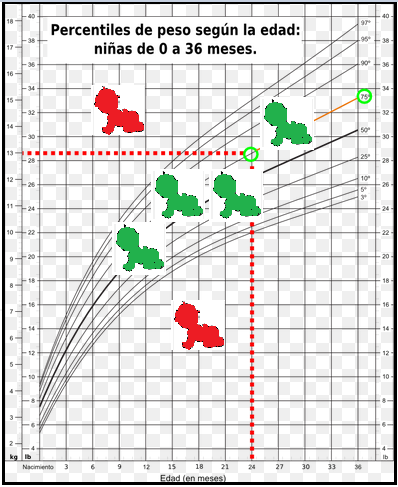

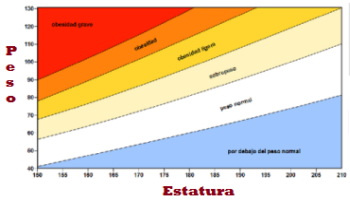

Hay ciertos valores en una distribución estadística que si se sobrepasan por exceso o por defecto pueden ser signo de alguna disfunción. Pensemos en el caso de los controles de crecimiento del feto en el embarazo o en los valores de seguridad de azúcar o colesterol en sangre.

Estos valores en estadística están relacionados con los parámetros de posición.

Los cuartiles constituyen las más populares de las medidas de localización. Se utilizan continuamente en multitud de disciplinas y representan valores estratégicos en cualquier distribución estadística ya que siguiendo el mismo patrón que la mediana, dividen a dicha distribución de tal forma que:

Para la variable continua, se puede razonar exactamente de la misma forma, identificando en este caso el intervalo cuartil primero o tercero. Si queremos asociar valores representativos del intervalo a los cuartiles, muchos autores señalan simplemente la marca de clase de dichos intervalos y otros están de acuerdo en utilizar una fórmula que interpola linealmente los valores en los correspondientes intervalos.

$$\begin{split} L_{i-1} &= \text{Límite inferior del intervalo } Q_1\\ a &= \text{Amplitud del intervalo } Q_1\\ F_{i-1} &= \text{Frecuencia acumulada anterior a } Q_1\\ f_i &= \text{Frecuencia absoluta del intervalo } Q_1\\ N &= \text{Total de datos} \end{split}$$

$$\begin{split} L_{i-1} &= \text{Límite inferior del intervalo } Q_3\\ a &= \text{Amplitud del intervalo } Q_3\\ F_{i-1} &= \text{Frecuencia acumulada anterior a } Q_3\\ f_i &= \text{Frecuencia absoluta del intervalo } Q_3\\ N &= \text{Total de datos} \end{split}$$

En las escenas de cálculo de la moda, para variables discreta o continua, del apartado anterior, puedes introducir datos y calcular, además de los cuartiles y percentiles, los demás parámetros estadísticos.

En la siguiente escena puedes practicar con el cálculo de cuartiles para variable discreta y continua.

Ahora puedes experimentar cómo los valores atípicos influyen sensiblemente en la media y en los cuartiles, y esa influencia es menor para la mediana.

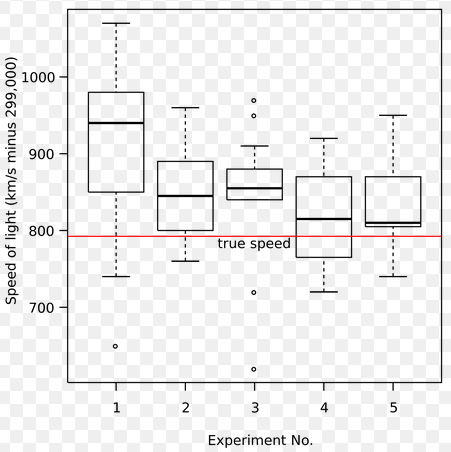

Este tipo de diagramas lo han popularizado mucho los distintos paquetes estadísticos que circulan por el universo informático y algunas calculadoras científicas, que en su modo de estadística, son capaces de generarlos. Se trata de un dibujo muy sencillo que refleja también de forma muy simple muchas de las características de la distribución.

Se construyen fundamentalmente a partir de la información que ofrecen la mediana y los cuartiles primero y tercero. Son los denominados diagramas de caja y bigotes. Para la construcción del rectángulo, la caja, solamente necesitamos las cotas que serán los valores de $Q_1$ y $Q_3$ y para la longitud de los bigotes los valores mínimo y máximo de la distribución. Los segmentos se dibujaran de forma continua o no dependiendo de la presencia de lo que se denominarán valores atípicos.

Para empezar, en la escena de la siguiente página puedes construir el diagrama con unos pocos datos.

En la siguiente escena podemos ver con más detalle cómo

se construye este tipo de diagramas.

Ahora puedes practicar y comprobar si has comprendido el significado y los elementos de los diagramas de cajas y bigotes.

Valores atípicos

La representación gráfica de los datos de una distribución estadística mediante los box-whisker se ha popularizado mucho y ofrece una primera visión gráfica muy acertada de las características principales de los elementos de la distribución.

El diagrama de cajas y bigotes nos proporciona información de cómo se encuentran concentrados los datos.

Sin embargo para saber si hay algún valor más alejado o atípico que pueda influir distorsionando el estudio de los diferentes parámetros estadísticos, algunos autores consideran el siguiente criterio para distinguir y localizar a dichos posibles valores atípicos

Cuando existen estos valores, el convenio que existe es dibujarlos en el box-whisker como puntos aislados en lugar de unirlos de forma continua mediante un segmento.

En la animación de la siguiente página puedes observar cómo se detectan los valores atípicos aplicando el criterio anterior.

Veamos otro ejemplo:

Supongamos que en una clase se pregunta por el número de hermanos que tienen los alumnos y se distribuyen los datos en la siguiente tabla. Nos preguntamos si alguno de los datos de la tabla puede considerarse atípico o aislado.

| No de hermanos | Frecuencia | Frecuencia acumulada |

|---|---|---|

| 0 | 2 | 2 |

| 1 | 8 | 10 |

| 2 | 15 | 25 |

| 3 | 6 | 31 |

| 7 | 1 | 32 |

| 9 | 1 | 33 |

Valores aislados por la izquierda

$\displaystyle x\lt Q_1 -1,5\cdot(Q_3-Q_1) \implies x\lt 1-1,5\cdot (2-1) \implies x \lt -0,5$

No hay valores aislados por la izquierda

Valores aislados por la derecha

$\displaystyle x\gt Q_1 +1,5\cdot(Q_3-Q_1) \implies x\gt 2+1,5\cdot (2-1) \implies x \gt 3,5$

$x=7$ y $x=9$ serían valores aislados por la derecha.

Un alumno tiene tres exámenes con notas $6, 5$ y $4$ y otro alumno con notas $1, 5$ y $9$. Las notas medias de ambos es $5$ y la mediana también $5$, sin embargo estos parámetros no describen las características de ambas distribuciones puesto que se observa claramente que las notas del primer alumno son más homogéneas que las del segundo.

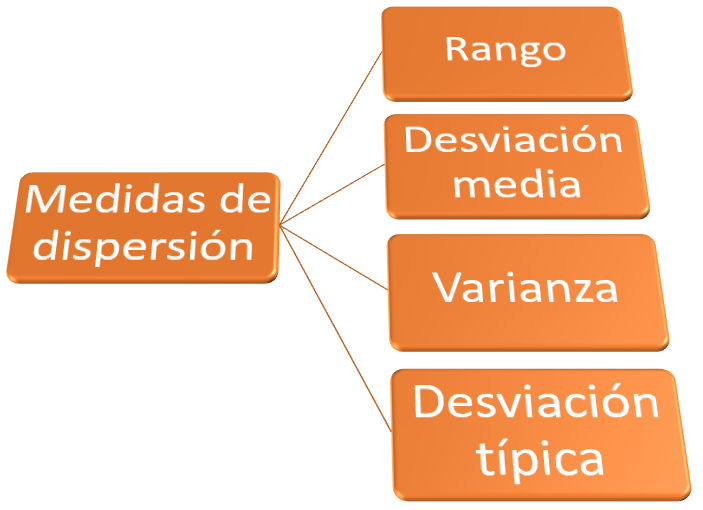

Por lo general, las medidas de centralización no detectan ciertas circunstancias de la distribución que son muy importantes y que deben tenerse en cuenta en lo que respecta a la descripción de dicha distribución. Las medidas de dispersión indican si los datos están más o menos agrupados respecto de las medidas de centralización. Fundamentalmente respecto a la media aritmética.

En muchos procesos de fabricación se requiere mucha precisión en las medidas de determinadas piezas. Es extremadamente difícil conseguir medidas exactas puesto que toda máquina construida por el hombre es susceptible del error, no existe la máquina de precisión perfecta. Sin embargo, a pesar de estas mínimas diferencias, hay algunas piezas que deben rechazarse puesto que no cumplen con los criterios de medición que establecen. ¿Hasta qué punto las diferencias observadas son admisibles, pues no ocasionan ningún tipo de problema en el engranaje de dichas piezas? En estos criterios aparecen involucradas las medidas de dispersión, y entre ellas el rango y la desviación media.

Llamamos rango o recorrido, a la diferencia entre el mayor y el menor valor de la variable, indica la longitud del intervalo en el que se hallan todos los datos de la distribución. El rango es una medida de dispersión importante aunque insuficiente para valorar convenientemente la homogeneidad de los datos, de ahí que deba complementarse con otras medidas.

En este sentido encontramos la variación media que nos sirve para calcular cuánto se desvían en promedio los datos de la media aritmética. Se define como la media de los valores absolutos de las diferencias entre la media aritmética y los diferentes datos. No es una de las medidas de dispersión más usuales.

En la siguiente escena puedes practicar con el cálculo del rango y la desviación media de variable tanto discreta como continua.

La medida de dispersión más popularizada es sin duda la varianza. La filosofía de esta medida es la misma que la de la desviación media; esto es, detectar las variaciones de cada valor respecto a la media aritmética. Sin embargo para ello en lugar de utilizar el valor absoluto, eleva esas diferencias al cuadrado, con ello evita posibles compensaciones, dado que todos los términos son positivos, y además al elevarlas al cuadrado amplifica estas diferencias si son mayores a uno en valor absoluto y las minora en caso de ser menores de uno (también en valor absoluto). Por último, considera el promedio de dichas diferencias al que denomina varianza.

Del mismo modo que ocurre para la media, la varianza es un parámetro muy sensible a las puntuaciones extremas. Ademas, las unidades en que se mide no son las mismas que las de los datos de la distribución.

Comparando con el mismo tipo de datos, una varianza elevada significa que los datos están más dispersos. Mientras que un valor de la varianza bajo indica que los valores están por lo general más próximos a la media.

Un valor de la varianza igual a cero implicaría que todos los valores son iguales, y por lo tanto también coinciden con la media aritmética.

Algunas propiedades de la varianza:

A partir de la definición de la varianza, si se desarrolla la expresión y simplificando los resultados se obtiene otra expresión para la misma que permite un cálculo más directo y sencillo.

Suele recordarse diciendo:

"La varianza es igual a la media de los cuadrados menos el cuadrado de la media"

El principal inconveniente que presenta la varianza es que las unidades no son las mismas que las de los datos de la distribución (se ha elevado al cuadrado). Esto se solventa con la definición de un nuevo parámetro que se calculará a partir del anterior que es la desviación típica y que definimos en el siguiente apartado.

La estadística ha irrumpido en todas las facetas de la vida. En el mundo del deporte también desde hace tiempo. Los ojeadores y cazatalentos americanos fundamentalmente de baloncesto o de beisbol utilizan las estadísticas de los jugadores como elementos clave a la hora de negociar traspasos o contratos. Dentro de los parámetros que se estudian en cada jugador, la desviación típica en alguna de las facetas del juego pueden ser un magnífico elemento que defina un jugador como muy seguro o como irregular.

El término desviación típica fue incorporado a la estadística por Karl Pearson en 1894. La principal ventaja que representa la desviación típica respecto a la varianza es que su unidad de medida es la misma que la de los datos. Esto hace mucho más sencilla la posible interpretación.

La desviación típica es una medida del grado de dispersión de las observaciones alrededor de su valor medio, se define como la raíz cuadrada positiva de la varianza. Tiene el mismo cometido que ésta y además la ventaja de que las unidades en las que se mide son las mismas que las de los datos de la distribución. Puede considerarse la medida de dispersión por excelencia y aparece como tecla o función directa en cualquier calculadora o programa estadístico.

Si partimos de la definición de varianza, la fórmula para el cálculo de la desviación típica sería:

De la misma forma que en el apartado anterior, si desarrollamos y simplificamos la expresión anterior se llega a otra mucho más simple que es la que se utiliza en la práctica y cuya expresión es:

Obviamente, cuanto mayor sea la desviación típica, mayor será la dispersión de los valores de la distribución respecto a la media aritmética y, por tanto, bajará el nivel de representatividad de ésta con respecto a las observaciones.

Algunas propiedades de la desviación típica son las siguientes:

En la página siguiente presentamos dos escenas interactivas. En la primera, además de la desviación típica, puedes practicar calculando la varianza de distintas series de datos, tanto para variable discreta como continua. En la segunda escena puedes practicar con el cálculo de la desviación típica de variables discretas y continuas.

Recuerda que puedes ampliar las escenas, para interactuar con ellas en una ventana aparte.

Puedes practicar con el cálculo de parámetros de dispersión en ejercicios que tú mismo puedes plantear en el apartado sexto: "6. Manejo de Calculadora".

Qué es más homogénea, una población de perros con desviación típica $2 Kg$ u otra de vacas de desviación típica $5 Kg$?

|

|

Si se realiza un estudio estadístico en dos poblaciones diferentes, y queremos comparar resultados, no se puede acudir simplemente al valor de la desviación típica para ver la mayor o menor homogeneidad de los datos, es decir, el valor numérico por sí solo no nos indicará que distribución de datos está más o menos dispersa.

Recurrimos para ello a otro parámetro, llamado coeficiente de variación y que se define como el cociente entre la desviación típica y la media de una población. Es un coeficiente carente de unidades y sirve para comparar la dispersión de dos poblaciones distintas, correspondiendo a la población más homogénea un coeficiente de variación menor y a la menos homogénea un coeficiente de variación mayor.

Practica con el cálculo del coeficiente de variación, en la siguiente escena.

Puntuaciones típicas o normalizadas

Antonio obtuvo una nota en Matemáticas de $6,75$ en una clase en la que la media del examen fué $7,25$ y la desviación típica $1,75$. Alberto en cambio obtuvo una nota de $5,75$ en una clase en la que la media fue de $4,75$ y la desviación típica de $2$. Si suponemos que el profesor era el mismo, podríamos pensar comparativamente con su clase que nota es mejor, la de Antonio o la de Alberto. En este sentido, las puntuaciones típicas sirven para comparar datos correspondientes de distintas poblaciones.

Estas puntuaciones típicas son valores que resultan de dividir la diferencia de cada valor menos la media entre la desviación típica de la población. A este proceso también se le suele denominar tipificación. Una vez efectuada la tipificación obtendremos una variable estadística cuya media aritmética es cero y cuya desviación típica es uno.

Las puntuaciones típicas son el resultado de dividir las puntuaciones diferenciales entre la desviación típica. Este proceso se llama tipificación.

En la escena anterior, puedes observar, mediante la normalización de datos, la comparación de las notas dadas a $100$ alumnos por dos profesores. Se presentan cuatro situaciones.

¿Quieres efectuar la comparación de las notas de dos profesores tuyos? Puedes hacerlo en la siguiente escena, la cual también puedes utilizar como simulador de situaciones.

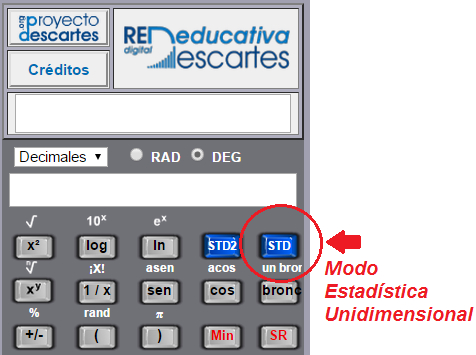

La utilización de calculadoras en ejercicios de estadística es obviamente fundamental, tanto si se hacen manualmente (utilización de la calculadora para largas operaciones elementales habituales en este tipo de ejercicios), o si se quieren aprovechar otras ventajas directas del modo estadístico. Cualquier calculadora científica ofrece de forma directa el cálculo de los parámetros estadísticos más usuales.

Dependiendo del modelo, debes consultar el manual de uso para aprender a disponer la calculadora en modo ESTADISTICA UNIDIMENSIONAL y la forma en la que han de introducirse los datos. Este proceso de introducción de datos es el que suele variar de un modelo a otro, aunque en la mayoría el procedimiento es sencillo.

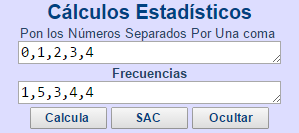

La calculadora de la RED DESCARTES, no tiene un condicionante material físico como las habituales del mercado, tiene un funcionamiento muy sencillo y alguna ventaja adicional con los modelos más simples que normalmente son de las que dispone el alumnado. Comentamos un poco la forma de trabajar con esta calculadora.

En la pantalla de resultados observarás:

En las siguientes escenas, diseñadas por Juan Jesús Cañas Escamilla, puedes plantear los ejercicios de variable discreta y continua con los datos que prefieras, inventados o procedentes de algún problema concreto. Las escenas admiten tabulaciones de hasta $36$ filas.

Una vez introducidos los datos al pulsar el control "Actualizar", se completa toda la tabla con todos los valores necesarios para el cálculo de los parámetros estadísticos. Si pulsas el control "Ver parámetros" puedes acceder al valor de dichos parámetros; media, mediana, moda, percentiles, desviación típica además de los diagramas de barras e histogramas de frecuencias relativas y relativas acumuladas.

Variable discreta

Variable continua

A continuación tienes el enunciado de diferentes problemas. Trabájalos y una vez los hayas resuelto puedes hacer clic sobre el botón para ver la solución.

Juan Jesús Cañas Escamilla

José R. Galo Sánchez

Karl Pearson (Londres, 27 de marzo de 1857, 27 de abril de 1936) fue un prominente científico, matemático y pensador socialista británico, que estableció la disciplina de la estadística matemática. Fue el fundador de la bioestadística, https://es.wikipedia.org/).

En definitiva, el hombre siempre ha intentado buscar relaciones entre magnitudes de manera que conocida una de ellas, generalmente la menos “costosa”, le permita inferir lo más acertadamente posible los valores de la otra magnitud.

En este sentido la Estadística también ofrece su ayuda y aborda con bastante éxito esta empresa.

Así pues, en muchas ocasiones un trabajo estadístico necesita estudiar sobre cada individuo varias variables con el objeto de encontrar una posible relación entre las mismas.

Cuando sobre una población estudiamos simultáneamente dos variables estadísticas, al conjunto de los pares de valores correspondientes a cada individuo se denomina distribución bidimensional.

|

|

|

|

EJEMPLO 1

Las notas de $10$ alumnos en Matemáticas y en Lengua vienen dadas en la siguiente tabla:

| MATEMÁTICAS | 2 | 4 | 5 | 5 | 6 | 6 | 7 | 7 | 8 | 9 |

| LENGUA | 2 | 2 | 5 | 6 | 5 | 7 | 5 | 8 | 7 | 10 |

Los pares de valores {(2,2), (4,2), (5,5), ..., (8,7), (9,10)}, forman la distribución bidimensional.

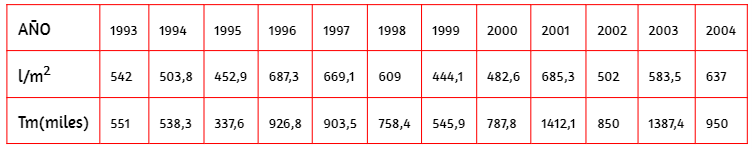

EJEMPLO 2

Vamos a estudiar en los últimos doce años las precipitaciones medias en nuestro país, en litros por metro cuadrado y la producción de aceite en miles de toneladas métricas. Los datos aparecen reflejados en la siguiente tabla:

EJEMPLO 3

En una clase de $30$ alumnos y alumnas se ha realizado un estudio sobre el número de horas diarias de estudio X y el número de asignaturas suspensas al final de curso Se obtuvieron los siguientes datos:

$(2,0) , (2,2) , (0,5) , (2,1) , (1,2) , (2,1) , (3,1) , (4,0) ,(0,4) ,(2,2) ,\\ (2,1) , (2,1) , (4,0) , (3,1) , (2,4), (2,1) , (1,2) , (2,1) , (2,0) , (3,0) ,\\ (3,1) , (2,2) , (2,2) ,(2,1) ,(0,5) , (1,3) , (2,2) , (2,1) , (1,3) , (1,4)$Una vez que hemos recogido todos los datos, la mejor forma de estudiarlos es disponerlos en una tabla estadística. Existen fundamentalmente dos tipos de tabulación para variables bidimensionales.

Tabla bidimensional simple. Está formada por tres filas o columnas en las que se representan ordenadamente los valores de las variables y sus frecuencias. La tabulación suele hacerse ordenando los datos de menor a mayor respecto a una de las variables. En caso de que todas las frecuencias sean iguales a uno, se puede omitir la fila o columna correspondiente a las mismas.

| $X_1$ | $Y_1$ | $f_1$ |

| $X_2$ | $Y_2$ | $f_2$ |

| $\cdots$ | $\cdots$ | $\cdots$ |

| $\cdots$ | $\cdots$ | $\cdots$ |

| $X_m$ | $Y_m$ | $f_m$ |

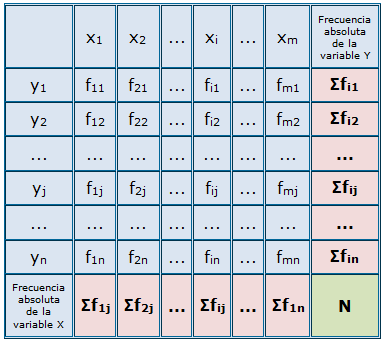

Tabla de doble entrada. Está formada por tantas filas y columnas como valores tengamos de cada una de las variables, añadiendo una fila y una columna más para representar los totales. Está indicada para casos con bastantes datos, en los que para cada valor de una variable, existen varios valores de la otra.

Escogiendo la primera y la última fila, tenemos la tabla estadística correspondiente a la primera variable unidimensional. Con la primera y última columnas construimos la tabla correspondiente a la segunda variable unidimensional.

Estas dos distribuciones reciben el nombre de distribuciones marginales. En la última celda aparecerá el total de la última fila y de la última columna, es decir, el número total de elementos estudiados

($N$).

Además, en esta tabla puede resultar de interés estudiar distribuciones unidimensionales correspondientes a un valor determinado de alguna de las variables, llamadas distribuciones condicionadas.

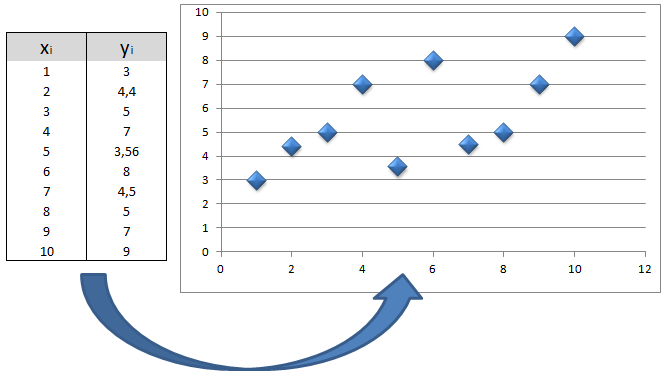

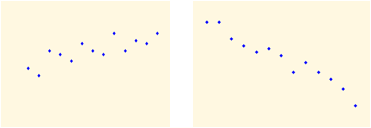

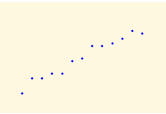

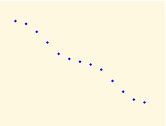

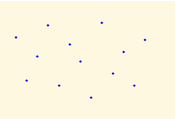

En el caso en el que todas las frecuencias absolutas de cada valor $(x_i , y_i)$ sean unitarias, un diagrama de dispersión consiste en hacer corresponder de forma cartesiana los valores de la variable bidimensional con los puntos del plano. Para representar el dato correspondiente al par $(x_i, y_i)$, colocaremos un punto en esas mismas coordenadas.

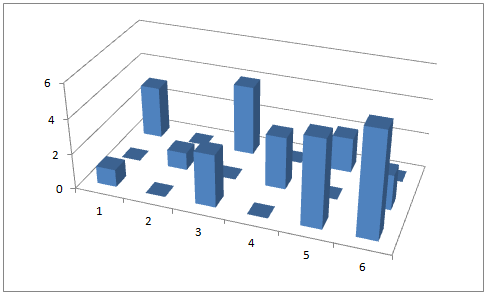

En el caso en el que existan frecuencias absolutas distintas de uno. Se puede utilizar el denominado prismograma. Es similar a un diagrama de barras o de rectángulos, pero intentando darle un aspecto tridimensional.

Representamos tres ejes (igual que representamos los ejes $x, y, z$). En el eje vertical representamos las frecuencias y en los otros los valores de las variables $X$ e $Y$. Para cada par de valores $(x_i, y_j)$, representamos un prisma o una barra vertical de altura igual a su frecuencia. Este gráfico no se utiliza apenas porque su interpretación suele ser complicada.

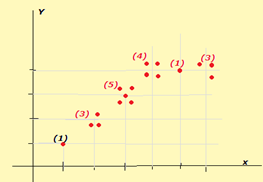

Nota: Como alternativa al prismograma, se puede utilizar un diagrama de puntos en los que de forma “artesanal” se disponga en las coordenadas de cada valor, tantos puntos como indique su frecuencia absoluta.

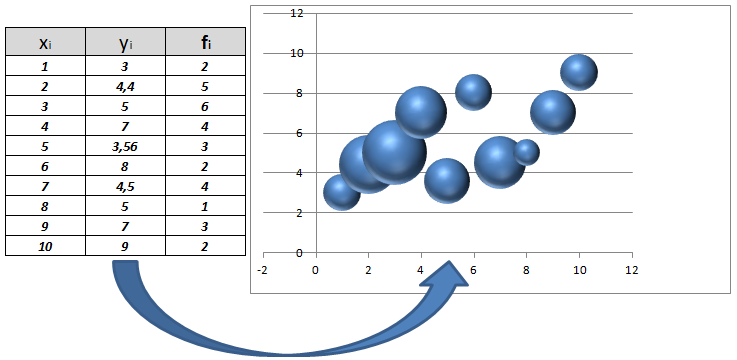

O también un diagrama de puntos de mayor o menor grosor según sea la frecuencia absoluta.

El objetivo de cualquier estudio bidimensional es observar si existe algún tipo de relación entre las dos variables estudiadas. La relación entre las dos variables cuantitativas queda reflejada mediante la función a la que parece acercarse la nube de puntos representada en el diagrama de dispersión. Prestaremos una especial atención a relación lineal aunque puedan existir otras interesantes como la cuadrática, exponencial, etc.

Los principales componentes elementales de una línea de ajuste y, por lo tanto, de una correlación, son la forma, la fuerza y el sentido.

Video

A continuación tenemos un vídeo que nos introduce en la idea general de relación entre variables o correlación.

Hasta ahora hemos hablado de correlación entre variables y del caso particular que nos ocuparemos en este tema como es el de la correlación lineal en un sentido global y difuso. Hemos mencionado en algún momento que la correlación puede ser fuerte o débil, positiva o negativa, sin embargo ¿qué entenderemos por fuerte o débil?, ¿cómo mediremos esta correlación? Nos hace falta un indicador o medidor que nos permita condensar en un parámetro todas estas facetas de la correlación. En este sentido vamos a estudiar un parámetro que será crucial en la cuantificación de la correlación lineal. A este nuevo parámetro lo denominamos covarianza y se define como:

La fórmula anterior es de difícil cálculo. Como ocurría en el caso de la varianza, desarrollando y simplificando la expresión anterior se llega a otra mucho más sencilla en lo que respecta al cálculo práctico y que es la que se utiliza normalmente en cualquier tipo de problema.

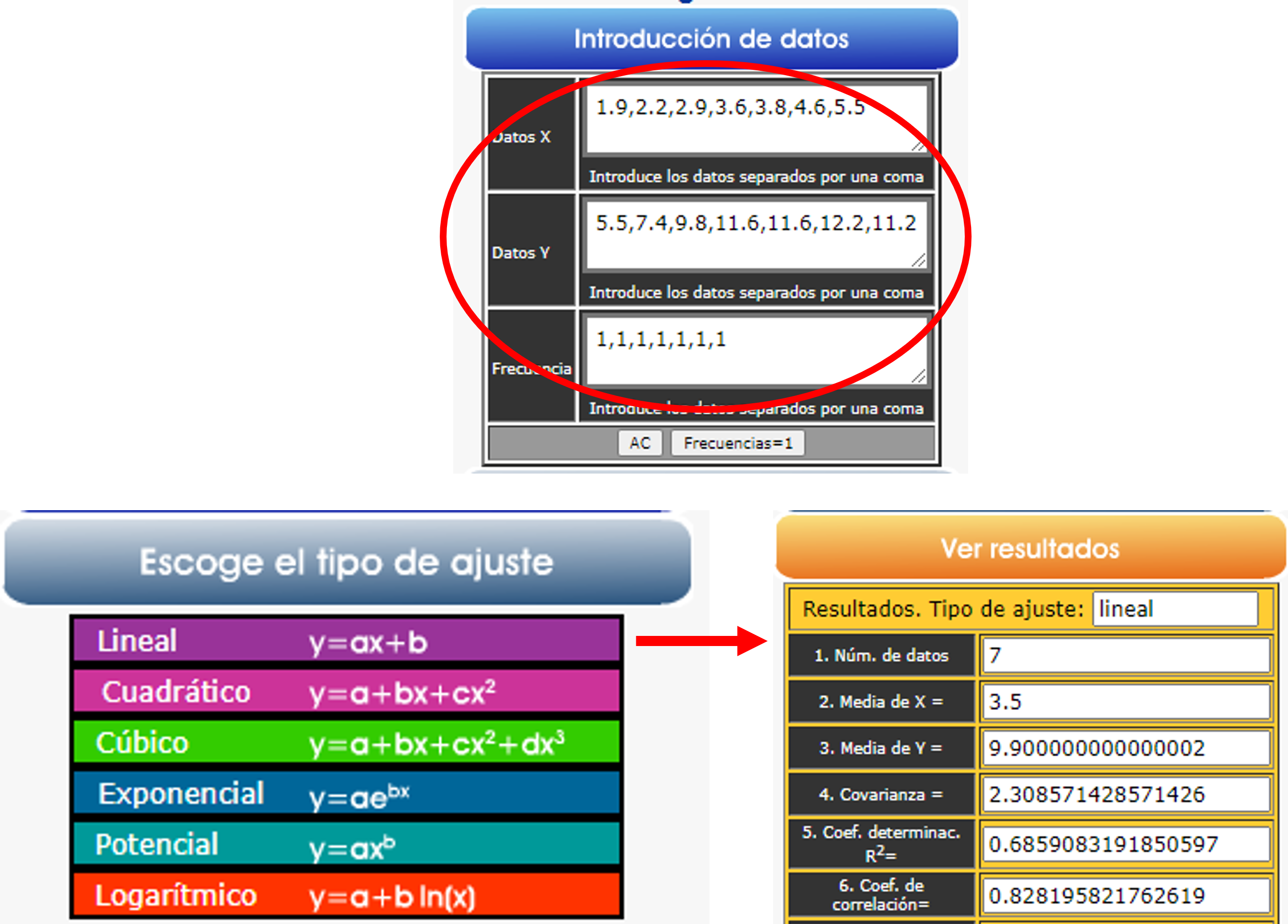

A pesar de disponer de las fórmulas anteriores, es muy importante que aprendas a utilizar tu calculadora para la realización de los problemas prácticos.

Lo más importante para la utilización de las calculadoras es la introducción de datos en el modo estadística, que todos los modelos de calculadora científica tienen.

En el caso de la calculadora Descartes, la introducción de datos es muy simple:

|

|

Puedes practicar con la calculadora de Descartes (haz clic en el icono de herramientas), aplicándola a ejemplos concretos.

Se define este coeficiente como el cociente entre la covarianza y el producto de las desviaciones típicas de ambas variables, es decir:

| $$r=\frac{\sigma_{xy}}{\sigma_x \cdot \sigma_y}$$ |  Karl Pearson

Karl Pearson

|

Este coeficiente tomará siempre valores comprendidos entre -1 y 1 y según sean estos, podremos deducir que:

En la siguiente escena puedes observar y relacionar una nube de puntos con su correspondiente coeficiente de correlación lineal. La escena te permite tanto elegir el número de puntos con el que quieres trabajar como la modificación de la posición de dichos puntos ya que se trata de controles gráficos que se pueden mover simplemente pulsando y arrastrando. Puedes comprobar que determinadas formas curvilíneas (dependencia casi funcional), sin embargo toman como coeficiente de correlación lineal números próximos a cero. Es interesante que manipules la escena y observes qué ocurre con el coeficiente de correlación lineal. Extrae tus propias conclusiones.

A continuación de la escena, tenemos en un vídeo una clase de la Universidad de Salamanca sobre la correlación lineal.

Nube de puntos y valores del coeficiente de correlación lineal

Video

Podemos decir que la regresión lineal es una técnica estadística que trata de estudiar la relación entre varias variables estadísticas. Cuando solamente tenemos dos variables diremos que estamos en regresión lineal simple. En investigación, el análisis de regresión se utiliza para predecir una de las variables a partir de la otra u otras.

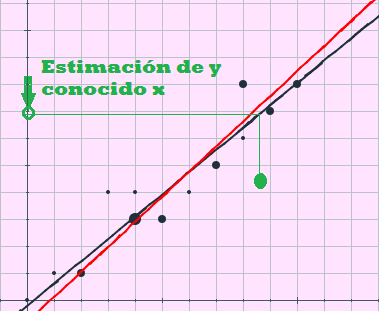

Cuando la nube de puntos de un diagrama de dispersión nos informe de una posible correlación lineal, el análisis de regresión tendrá como gran objetivo la predicción de valores para la variable dependiente ($Y$) a partir de los valores de la variable independiente ($X$) utilizando para ello una función (una recta) que aproximará lo mejor posible a la nube de puntos.

El método que se utiliza para la localización de esta recta es el llamado de los mínimos cuadrados.

Para el caso anterior, el método consiste en considerar la función que determinaría la suma de todas las distancias verticales (coordenada $y_i$), elevadas al cuadrado para evitar que las positivas y negativas se contrarresten, entre cada punto y su proyección vertical sobre la hipotética recta. A esta función posteriormente se le calcula dónde alcanzaría el mínimo.

El método de mínimos cuadrados

El día de Año Nuevo de 1801, el astrónomo italiano Giuseppe Piazzi descubrió el planeta enano Ceres. Fue capaz de seguir su órbita durante $40$ días.

Durante el curso de ese año muchos científicos intentaron estimar su trayectoria con base en las observaciones de Piazzi, pero resolver las ecuaciones no lineales de Kepler de movimiento es muy difícil.

La mayoría de las evaluaciones fueron inútiles y el único cálculo suficientemente preciso que permitió a Franz Xaver von Zach, astrónomo alemán, reencontrar al final de ese año a Ceres fue el de Carl Friedrich Gauss. Gauss por entonces era un joven de 24 años, pero los fundamentos de su enfoque ya los había planteado en 1795, cuando tenía 18 años. Sin embargo, su método de mínimos cuadrados no se publicó sino hasta 1809 en el segundo volumen de su trabajo sobre mecánica celeste, "Theoria Motus Corporum Coelestium in sectionibus conicis solem ambientium"".

El francés Adrien-Marie Legendre desarrolló el mismo método de forma independiente en 1805.

|

|

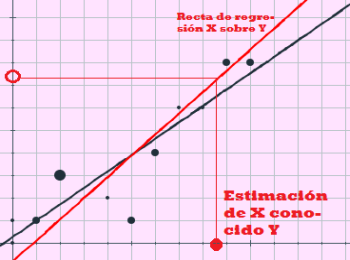

Como se ha mencionado anteriormente, en los casos en los que se observe cierto grado de correlación lineal, intentaremos aproximar la nube de puntos mediante una recta. A estas líneas se les llaman rectas de regresión. Dependiendo del procedimiento de minimización de distancias que se emplee, bien sean verticales u horizontales, y utilizando el procedimiento de mínimos cuadrados obtendremos dos tipos de recta:

Como puedes observar, se trata de las clásica expresión de una recta en su forma punto pendiente.

La obtención de las expresiones de las rectas anteriores no es sencilla. Como características fáciles de descubrir podemos señalar que el signo de la pendiente depende únicamente de la covarianza en ambas expresiones y que ambas pasan por el punto común:

$$\big(\={X}, \={Y}\Big)$$

En la siguiente escena puedes practicar con el cálculo de todos los parámetros relacionados con la regresión en variables bidimensionales. Puedes introducir los datos que desees seleccionando previamente las filas que necesites (máximo de $36$). Sigue las instrucciones y podrás comprobar el valor de todos los parámetros y la representación gráfica de la nube de puntos y de las dos rectas de regresión.

Es importante que practiques y construyas tablas tú mismo y que la escena te sirva de apoyo y comprobación de resultados. También convendría que supieras utilizar tu calculadora y usarla en los problemas prácticos. En este sentido, ten en cuenta que lo que puede variar en cada calculadora es la introducción de los datos.

Una vez que conozcas este procedimiento, el resto suele ser muy parecido. Como ejemplo, recordar el caso de la calculadora DESCARTES (ver el apartado 2.4.1). Realiza algún ejercicio de regresión utilizando la calculadora para variable bidimensional de DESCARTES.

Video

En el siguiente video puedes asistir a una clase sobre regresión lineal

En la siguiente escena puedes manipular la nube de puntos y observar como varía el ajuste por mínimos cuadrados y como cambian las rectas de regresión.

Una de las primeras acciones que se realizan en cualquier estudio estadístico es la depuración de los datos, localizando y decidiendo si los elementos anómalos que se denominan en la literatura científica como "outliers" o valores atípicos, deben tenerse en cuenta en la realización del estudio o no.

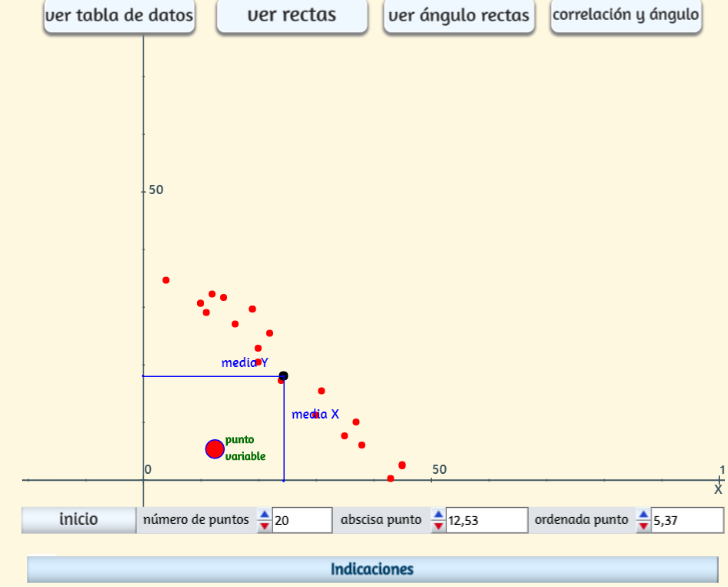

La siguiente escena sirve para analizar la influencia que puede tener la variación de un solo dato en un análisis estadístico, en concreto en la regresión lineal.

En la escena aparece una nube de puntos, el número de ellos se puede elegir mediante el control "número de puntos". A veces la nube aparece muy dispersa y aunque es posible realizar un ajuste lineal las conclusiones estadísticas serían muy poco o nada fiables, pero puede cambiarse sin más que pulsar el botón "Inicio". Uno de los puntos es un control gráfico que puede moverse y desplazarse a voluntad utilizando los dos controles situados abajo o directamente pulsando y arrastrando. Con el botón "ver rectas" se observa la solución global del problema. Mediante el botón "ver tabla" se pueden observar los datos reales del problema.

Con el botón "ver parámetros" puedes identificar todos los parámetros calculados y necesarios para el modelo de regresión. También se dispone de un botón para ver cómo varía el ángulo de las dos rectas y otro para un gráfico que relaciona el coeficiente de correlación y el ángulo al desplazar el punto variable. Haz clic en la imagen para abrir la escena.

Una vez que conocemos la mayor o menor relación entre las variables mediante el coeficiente de correlación lineal y que hemos calculado las rectas de regresión, podemos utilizarlas para predecir el valor de una de las variables a partir de la otra. La fiabilidad de la estimación depende fundamentalmente de dos consideraciones:

|

|

En la siguiente escena puedes realizar estimaciones para ejercicios concretos. Puedes introducir los valores de $X$, de $Y$ y las frecuencias que desees. Una vez introducidos los datos sólo tienes que seguir las indicaciones que se dan en la escena y realizar las estimaciones que quieras, tanto para la variable $X$ como para la variable $Y$.

A continuación tienes el enunciado de diferentes problemas. Trabájalos y una vez los hayas resuelto puedes hacer clic sobre el botón para ver la solución.

Juan Jesús Cañas Escamilla

José R. Galo Sánchez

Percy Alexander MacMahon (26 de septiembre de 1854 - 25 de diciembre de 1929) fue un matemático que se destacó especialmente en el campo de las particiones de números y la combinatoria enumerativa, https://es.wikipedia.org/).

En muchas ocasiones, en la vida real nos vemos en la necesidad de contar. Esta acción aparentemente sencilla puede llegar a ser muy complicada. El hecho de contar objetos presentes y observables directamente es muy simple, pero pensemos en situaciones donde la mera observación no basta. Imagina como contar todas las matrículas de automovil que pueden construirse con tres letras y cuatro números, imagina que necesitas conocer todos los signos de 5 elementos que se pueden formar con un punto y una raya, o todas las posibles banderas de tres franjas horizontales de distintos colores, ...

Como ves las situaciones son incontables y como ves también la expresión que continuamente aparece en este tipo de contexto es ¿CUÁNTOS...?

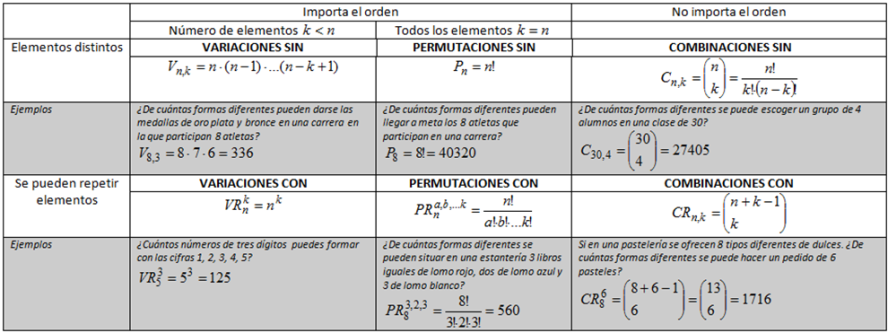

La parte de las matemáticas que se dedica al estudio de este tipo de situaciones es la Combinatoria. Esta teoría nos proporcionará las técnicas y fórmulas que permitan encontrar respuestas a muchos problemas como los anteriores. En combinatoria las cuestiones planteadas se analizan fundamentalmente atendiendo a las siguientes preguntas:

Es evidente también que con un manejo aceptable de las técnicas de recuento que analizaremos en esta unidad; se pueden abordar de una forma más interesante problemas de probabilidad en los que el único enfoque posible sea el concepto de probabilidad en el sentido clásico de Laplace y nos veamos obligados a contar casos posibles y favorables.

A continuación tenemos tres vídeos que nos pueden ayudar a introducirnos en la combinatoria y su aplicación en la probabilidad.

Video

Videos

A continuación veamos una curiosidad que relaciona la combinatoria con la filosofía. Imaginemos que el libro definitivo, el que explica las verdades universales existe y que tiene por ejemplo 100 páginas. Con este simple supuesto, la combinatoria nos dice que dicho libro, en realidad es el fruto de una variación con repetición de 30 elementos ($26$ letras, el espacio entre palabras, el punto, la coma y los dos puntos) tomados de n en n (donde n es el total de signos que se podrían introducir en 100 páginas). En realidad las posibles agrupaciones son inimaginables , pero eso sí finitas.

Bueno ¡pues a trabajar! Pongamos a escribir a $1000, 10000, 1000000$ monos y tarde o temprano alguno de los monos será el autor de la obra definitiva. Será cuestion de descubrir la variación con repetición "ganadora". Esta anécdota es conocida como el teorema de los mil o de los infinitos monos y relaciona a estos monos con las obras de Shakespeare. Observa el siguiente vídeo:

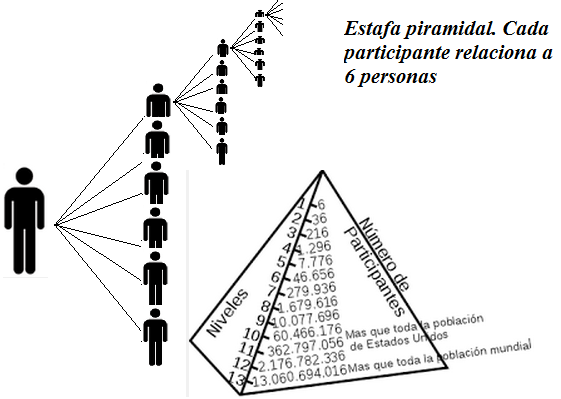

Las estafas piramidales, la extensión de rumores, las visitas a una página web,..., a menudo manejan o conducen a números escandalosamente grandes. Las circunstancias anteriores y muchas otras tienen como motor de transmisión algo tan simple como el "boca a boca", de manera que números pequeños conducen al final a situaciones inabarcables como resultado del principio general de recuento. También la base sobre la que se apoya el edificio de la teoría combinatoria es el principio general de recuento que a su vez es el mismo principio de cardinalidad del producto cartesiano en la teoría de conjuntos.

Si un experimento puede realizarse de $n$ formas diferentes y un segundo experimento puede hacerlo de $m$ formas diferentes; entonces los dos experimentos juntos se pueden realizar de $n\times m$ formas diferentes.

En el lenguaje de teoría de conjuntos se expresa como: $$\begin{rcases} Card(A) &= n \\ Card(B9 &= m \end{rcases}\implies Card(A\times B) = n\cdot m$$

Veamos un par de ejemplos:

Video

Observa el siguiente vídeo sobre el principio general de recuento:

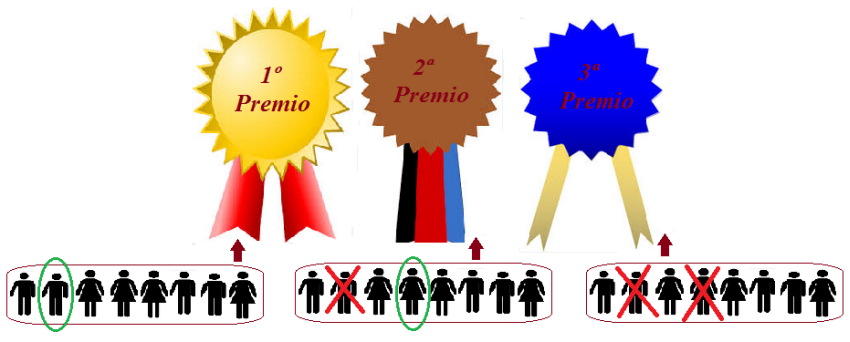

Supongamos que a un concurso literario en el que se conceden tres premios distintos, se presentan ocho escritores. Nos preguntamos por las distintas formas en las que se pueden conceder estos premios.

Este problema sin duda se puede resolver sin necesidad de conocimientos previos sobre combinatoria.

Pensemos que disponemos de tres puestos. Para el primero se puede elegir a cualquiera de los ocho participantes. Para el segundo, no puedo elegir al que ya está elegido para el primero, por tanto solamente podremos elegirlo entre los siete restantes. Para el tercero, siguiendo el mismo razonamiento nos quedarán seis participantes. Ahora aplicando el principio general de recuento al conjunto $(P1 \times P2 \times P3)$, el total de resultados posibles para el reparto de los tres premio sería: $8 \times 7 \times 6 = 336$.

En combinatoria, denominamos variaciones ordinarias o sin repetición de $n$ elementos tomados de $m$ en $m$ (siendo $m$ menor o igual que $n$) a cada uno de los distintos grupos de $m$ elementos escogidos de entre los $n$, de manera que:

El número de variaciones ordinarias lo representamos $V_{n,m}$ y se calcula:

En la siguiente escena puedes practicar con la formación de algunas variaciones sin repetición. A medida que practicas irás descubriendo como se van construyendo, sus características y la idea que permite calcular el número total de variaciones sin repetición.

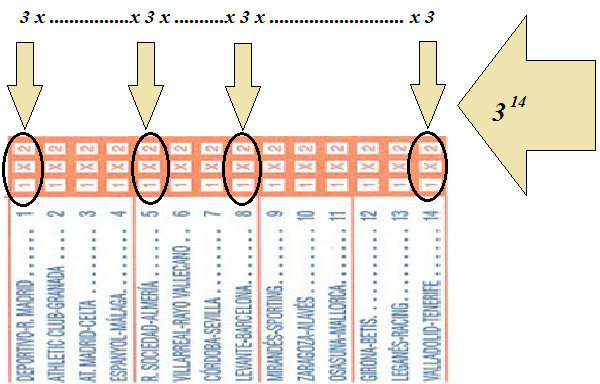

Dentro de los juegos de apuestas más populares en España se encuentra sin duda la quiniela de fútbol. ¿Cuántos resultados posibles pueden darse en catorce encuentros entre equipos de primera y segunda división?. Este problema puede resolverse también sin conocimientos previos de combinatoria.

Imaginamos que cada resultado es un grupo de $14$ símbolos y que dichos símbolos solamente pueden ser $1, X$ o $2$. Así para el primer signo que pongamos tendremos $3$ posibilidades, para el segundo también otras $3$ y así sucesivamente hasta llegar al símbolo $14$. Ahora no tenemos más que aplicar otra vez el principio general de recuento al conjunto $(P_1\times P_2\times \cdots \times P_{14})$.

Piensa también por ejemplo en:

En combinatoria denominamos variaciones con repetición de $n$ elementos tomados de $m$ en $m$, (obsérvese que no hay restricción alguna en cuanto a los valores de $n$ y $m$), a los distintos grupos de $m$ elementos, repetidos o no, que se pueden formar. Considerando:

Al número de variaciones con repetición lo denotaremos, $VR_{n,m}$ y se calcula:

En la siguiente escena puedes practicar con la formación de algunas variaciones con repetición. A medida que practicas irás descubriendo cómo se van construyendo, sus características y la idea que permite calcular el número total de variaciones con repetición.

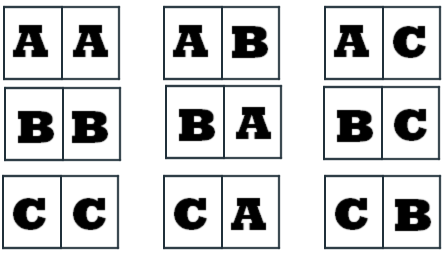

Observa que para $3$ elementos, tomados de $2$ en $2$, el número de variaciones es $3^2$:

Imaginemos cuatro amigos que deciden fotografiarse juntos en una fiesta para conservar el momento. Si deciden que la fotografía sea de los cuatros en línea. ¿De cuántas formas diferentes podrán realizar la fotografía?.

Un primer análisis de la situación nos sitúa el problema al mismo nivel del que se resolvió en el epígrafe correspondiente a las variaciones sin repetición. En realidad se trata del mismo razonamiento. La primera posición la pueden ocupar cualquiera de los cuatro amigos. La segunda la pueden ocupar cualquiera menos el que ocupó la primera, es decir tres posibilidades , y así seguiremos hasta la cuarta posición que podrá ser ocupada por una persona. Aplicando ahora el principio general de recuento al conjunto $(B_1\times B_2\times B_3\times B_4)$, el número de posibles agrupaciones sería $4 \times 3 \times 2 \times 1 = 24$ resultados distintos.

Un primer análisis de la situación nos sitúa el problema al mismo nivel del que se resolvió en el epígrafe correspondiente a las variaciones sin repetición. En realidad se trata del mismo razonamiento. La primera posición la pueden ocupar cualquiera de los cuatro amigos. La segunda la pueden ocupar cualquiera menos el que ocupó la primera, es decir tres posibilidades , y así seguiremos hasta la cuarta posición que podrá ser ocupada por una persona. Aplicando ahora el principio general de recuento al conjunto $(B_1\times B_2\times B_3\times B_4)$, el número de posibles agrupaciones sería $4 \times 3 \times 2 \times 1 = 24$ resultados distintos.

Existen muchas situaciones en las que se puede aplicar el mismo razonamiento.

Video

Denominamos permutaciones ordinarias o sin repetición de $n$ elementos, a cada uno de los distintos grupos que pueden formarse de manera que:

Al número de permutaciones ordinarias de $n$ elementos lo representaremos por $P_n$ y se calcula:

a este número se le denomina factorial de $n$ y se representa como $n!$ Se utiliza tanto, que aparece como tecla directa en todas las calculadoras científicas.

En la siguiente escena puedes practicar con la formación de algunas permutaciones sin repetición. A medida que practicas irás descubriendo como se van construyendo, sus características y la idea que permite calcular el número total de permutaciones sin repetición.

Supongamos que disponemos de $3$ vasos azules iguales, $2$ vasos iguales amarillos y $1$ naranja. Si quisiéramos ponerlos en línea recta en una estantería. ¿De cuántas formas distintas lo podríamos hacer?

Para ayudar a contar todos los casos y ayudándonos de que conocemos las permutaciones sin repetición, vamos a pegar en la parte opuesta, la que vemos, etiquetas que identifiquen y distingan como distintos a todos los vasos. De esta forma disponemos de $6$ vasos distintos que se pueden ordenar de $6!$ formas distintas.

Es decir, que si giramos los vasos para que se vean las etiquetas distinquiríamos todas las permutaciones, pero si no vemos las etiquetas, ordenaciones que antes eran distintas las veríamos iguales.

Las permutaciones anteriores serían identificadas como:

La idea, por tanto, para contar las permutaciones con repetición es identificar como una sola agrupación las, en nuestro caso, $2!$ y $3!$ reordenaciones que no distinguiríamos. No se distinguirían por tanto $(2! \times 3! \times 1!)$ permutaciones

A continuación puedes observar como se irían confeccionando algunas de las permutaciones con repetición de 6 elementos de los que uno se repite tres veces, otro dos veces y otro una vez:

Denominamos permutaciones con repetición de $n$ elementos en los que uno de ellos se repite $a$ veces, otro $b$ veces y así hasta el último que se repite $k$ veces, donde $(a+b+c+\cdot k = n)$ a todas las ordenaciones posibles de estos $n$ elementos.

Consideramos dos ordenaciones distintas si difieren en el orden de colocación de algún elemento (distinguible).

Denotaremos a este tipo de permutación como: $$\LARGE P_n^{a,b,c, \cdot k}$$ y se calcula como:

En la siguiente escena puedes practicar con ejemplos de formación de algunas permutaciones con repetición.

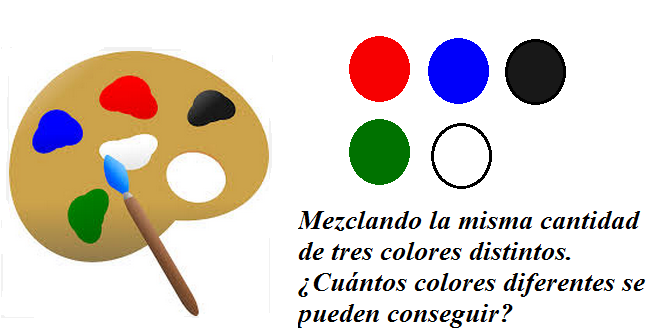

Existen muchas situaciones en las que el orden deja de ser determinante. Pensemos en un pintor que dispone de cinco colores, rojo, azul, verde, negro y blanco. Desea conseguir nuevos colores mezclando cantidades iguales de tres colores diferentes de los cinco que dispone en su paleta. El orden en que mezcle los colores seleccionados no es significativo, es decir, el resultado de mezclar rojo, blanco y verde es exactamente el mismo que el de mezclar verde, blanco y rojo.

Así pues, todas las permutaciones de estos tres colores se deberían analizar como una sola agrupación. Por tanto, para localizar todos los posibles colores resultantes de la mezcla de tres de los cinco de que disponemos, $V_{5,3}$ entre las $P_3$.

A este tipo de agrupación la denominaremos Combinación sin repetición

Existen otras muchas situaciones parecidas en las que necesitamos conocer el número de agrupaciones en las que NO IMPORTA EL ORDEN. Por ejemplo:

entre otras muchas más.

Denominamos combinaciones ordinarias o sin repetición de $n$ elementos tomados de $m$ en $m$, (siendo $m$ menor o igual que $n$) a las distintas agrupaciones de $m$ elementos de manera que:

Se puede observar fácilmente que: las combinaciones sin repetición de $n$ elementos tomados de $m$ en $m$, podrían formarse a partir de considerar las variaciones sin repetición de $n$ elementos tomados de $m$ en $m$ y posteriormente identificar las posibles reordenaciones de una agrupación, (permutaciones de $m$ elementos), como una única ya que el orden no interviene en la agrupación que estamos considerando; esto es:

Video

En el siguiente video podemos observar el planteamiento de un problema que requiere de la combinatoria y su solución.

En la siguiente escena puedes practicar con ejemplos de formación de algunas combinaciones sin repetición.

Propiedades de los números combinatorios

Los números combinatorios aparecen muy frecuentemente en multitud de situaciones en Matemáticas, Física, Biología, etc...Figuran como tecla directa en cualquier calculadora científica. Como propiedades más interesantes merecen destacarse:

$1. \dbinom{n}{0} = 1\\ 2. \dbinom{n}{n} = 1$

$3. \dbinom{n}{1} = n\\ 4. \dbinom{n}{m} = \dbinom{n}{n-m}\\ 5. \dbinom{n}{m} + \dbinom{n}{m+1} = \dbinom{n+1}{m+1}$

Cuando no existían calculadoras científicas, el cálculo de números combinatorios requería de un trabajo complicado. El triángulo de Pascal permitía de una forma recurrente y muy fácil calcular cualquier número combinatorio, aunque es verdad que para cantidades elevadas también era bastante engorroso.

En la siguiente escena puedes ver muchas líneas del triángulo de Pascal y unas propiedades curiosas.

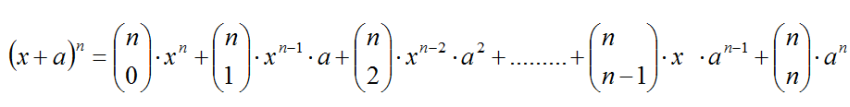

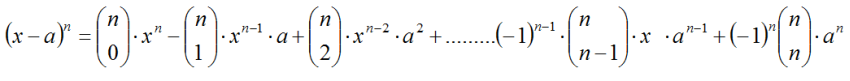

Binomio de Newton

Una de las aplicaciones más interesantes desde el punto de vista algebraico para los matemáticos, constituye el desarrollo de las distintas potencias de un binomio. Conocido como binomio de Newton, utiliza los números combinatorios y sus propiedades para desarrollar de forma fácil y directa la potencia natural de cualquier expresión del tipo:

Supongamos que un amigo nos invita a merendar a su casa. Como a las seis personas que estaremos en la merienda nos gustan los pasteles, quiero llevar media docena que compraré en la pastelería de la esquina. Al entrar en el establecimiento, la oferta es impresionante. Hay mucha variedad, piononos de Rute, piononos de Santa fé, milhojas, brazo de gitano, bizcotelas, borrachos, etc. En total la oferta es de $20$ variedades de pasteles diferentes. ¿De cuántas formas puedo hacer mi compra?

Analizando un poco el problema, en realidad no importa el orden en que aparezcan los pastelitos en mi bandeja. Observamos también que pueden repetirse pasteles, incluso se podría comprar una bandeja de seis dulces iguales.

Estamos por tanto ante una combinación (no importa el orden), y con posibilidad de repetición. Estamos ante una combinación con repetición de $20$ elementos tomados de $6$ en $6$: $CR_{20,6}$.

Denominamos combinaciones con repetición de $n$ elementos tomados de $m$ en $m$ (ninguna limitación con respecto a $n$ y $m$), a las distintas agrupaciones de $m$ elementos elegidos de entre los $n$ de manera que:

El número de combinaciones ordinarias de $n$ elementos tomados de $m$ en $m$, lo denotaremos $CR_{n,m}$ y se calcula:

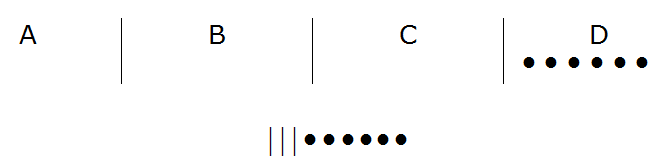

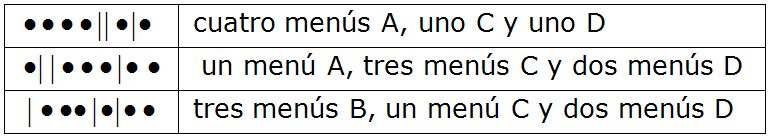

Para explicar la fórmula anterior vamos a desarrollar un método de codificación que nos ayude sobre un ejemplo concreto y que sea un poco más fácil que el del principio. Supongamos que en un restaurante se ofrecen cuatro posibilidades de menús; digamos $A, B, C$ y $D$. Si un grupo de $6$ amigos decide hacer un pedido, calculemos todos los casos distintos que podrían realizarse. Desde el punto de vista combinatorio, estamos ante combinaciones con repetición de cuatro elementos tomados de seis en seis.

En primer lugar utilizamos tres líneas (rayas) para separar las cuatro posibles opciones de los distintos menús. También utilizaremos el símbolo($\LARGE .$) (punto) para significar el pedido de cada persona. De esta forma, el pedido de por ejemplo cuatro menús $A$ y dos menús $B$ lo codificaríamos:

Es decir, el código del pedido sería:

Si por ejemplo quisiéramos expresar el pedido de seis menús $D$ su codificación sería la siguiente:

La posición inversa también se manifiesta asequible, es decir, descifrar cualquier código que se confeccione con tres rayas y seis puntos como un determinado y único pedido también sería sencillo. Por ejemplo si queremos descifrar el código $\LARGE ..|..||..$, lo podríamos interpretar como dos menús $A$, dos menús $B$, ningún menú $C$ y dos menús $D$.

Veamos algún ejemplo más de codificación:

Se ha establecido por tanto una correspondencia biunívoca entre las combinaciones con repetición de cuatro elementos tomados de seis en seis y las distintas agrupaciones de seis puntos y tres rayas; esto es, las permutaciones con repetición de 9 elementos donde uno se repite tres veces y otro seis. A su vez, este tipo de agrupación, podría ser considerada como una combinación de 9 elementos tomados de 6 en 6.

$$\large CR_{4,6} = PR_9^{6,3} = \frac{9!}{6!\cdot 3!} = \dbinom{9}{6} = \dbinom{4+6-1}{6}$$En la siguiente escena puedes practicar con ejemplos de formación de algunas combinaciones con repetición.

En el siguiente video puedes observar de forma resumida todos los casos de agrupaciones enumerados en este tema.

Desde el punto de vista práctico, es muy importante tener las ideas muy claras sobre el tipo de conjunto al que nos estemos refiriendo en cualquier problema de combinatoria.

Video

También conviene saber que a menudo los problemas de este tipo no son puros, es decir no se trata de combinaciones puras o variaciones puras,sino que tendremos que aplicar las técnicas de recuento y también la lógica y la particular creatividad que requiera la situación. En este sentido la siguiente escena te ayudará a manejar estos contextos en los que está involucrada la combinatoria.

El siguiente cuadro resumen con ejemplos también puede servirte de ayuda (haz clic en la imagen).

Video

Para empezar a hacer problemas, puedes ver el siguiente vídeo:

A continuación tienes el enunciado de diferentes problemas. Trabájalos y una vez los hayas resuelto puedes hacer clic sobre el botón para ver la solución.

Juan Jesús Cañas Escamilla

José R. Galo Sánchez

Christiaan Huygens (La Haya, 14 de abril de 1629 - ibídem, 8 de julio de 1695) fue un astrónomo, físico, matemático e inventor neerlandés. Hizo aportes importantes en la teoría de la probabilidad, fue miembro de la Royal Society (https://es.wikipedia.org/). Crédito imagen: Caspar Netscher , Dominio Púublico.

La innata curiosidad del ser humano, ha hecho que desde siempre el hombre se haya interesado tanto por el motivo por el que ocurren los fenómenos como por adivinar lo que deparará el futuro. Para ello ha recurrido a todo, astrólogos, profetas, adivinadores, brujos…, utilizando los métodos más inverosímiles; desde la superstición, la observación e interpretación de los vuelos de aves, la lectura de vísceras de animales sacrificados, la magia y rituales sacerdotales hasta las más sofisticadas formulaciones en las teorías más recientes.

| En muchas ocasiones el éxito ha sido completo de manera que ante unas determinadas condiciones iniciales se pueden concluir unos resultados determinados completos y precisos. Sin embargo existen experiencias que escapan al determinismo, es como si no se pudieran someter a las leyes que el hombre ha descubierto y que por tanto imposibilitan ante una determinada situación o experiencia concluir un resultado determinado. Estamos en un contexto tan difícil y extraño en el que las reglas dependen de tantos parámetros que hacen inviable la predicción o quizás ni siquiera existan estas reglas. Estamos en el territorio del azar Se dice que el origen de la probabilidad es un tanto accidental y fruto de las disquisiciones sobre una determinada jugada de dados que obsesionaba a un antiguo escritor y jugador francés del siglo XVII, Antoine Gombaud, conocido por Chevalier de Mère, amigo del matemático también francés Blaise Pascal al cuál pedía consejo respecto a las garantías de éxito que ofrecía dicha jugada. |

Chevalier de Mère

Chevalier de Mère Blaise Pascal

Blaise Pascal |

Video

En el siguiente vídeo se plantea el denominado problema del caballero de Mére. Se inicia en el instante que comienza a plantearse el mismo, pero si quieres puedes verlo desde su inicio.

El problema de Mére

La historia se pone de acuerdo en que el cruce de correspondencia respecto a dicho problema que establecen Pascal y el genial abogado y matemático también francés Pierre de Fermat, puede considerarse como origen de esta teoría.

Posteriormente es el matemático Christian Huygens quien publica en 1656 el primer libro impreso sobre probabilidad, De ratiociniis in ludo aleae. Es sobre todo en el siglo siguiente cuando el matemático francés Abraham de Moivre profundiza e impulsa de forma más intensa el estudio de la probabilidad con la introducción de importantes conceptos como el de la normal.

Video

En el siguiente vídeo podemos ver una visión de la probabilidad en el programa REDES

Existen experimentos en los que conocidas las condiciones iniciales se pueden predecir los resultados finales. Por ejemplo:

Sin embargo, existen experiencias en las que no ocurre esto o por lo menos así lo parece:

A todos estos experimentos se les denomina aleatorios. ¿Y quién se atreve a estudiar concienzudamente este tipo de experimentos cuyos resultados parecen escapar de todo control y lógica? La respuesta la encontramos, evidentemente, en las Matemáticas y sobre todo y especialmente en algunos matemáticos. Es fundamentalmente a partir del siglo XVIII cuando se estructuran, proponen y desarrollan los conceptos relacionados con la probabilidad hasta cotas realmente prodigiosas.

En este tema vamos a utilizar un vocabulario bastante específico con

algunos conceptos que seguramente ya conoces de cursos anteriores pero que conviene recordar.

En el siguiente enlace puedes informarte sobre alguno de los más importantes matemáticos que trabajaron sobre el tema así como de sus contribuciones (haz clic sobre la imagen).

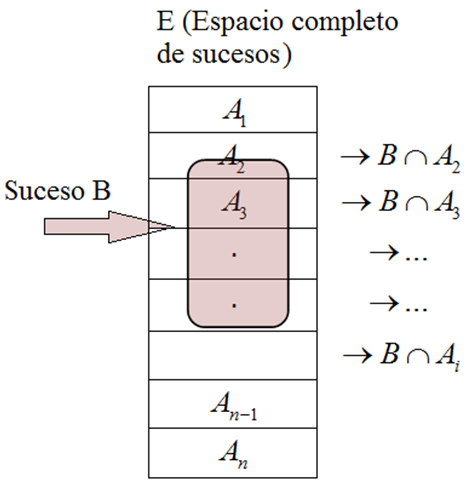

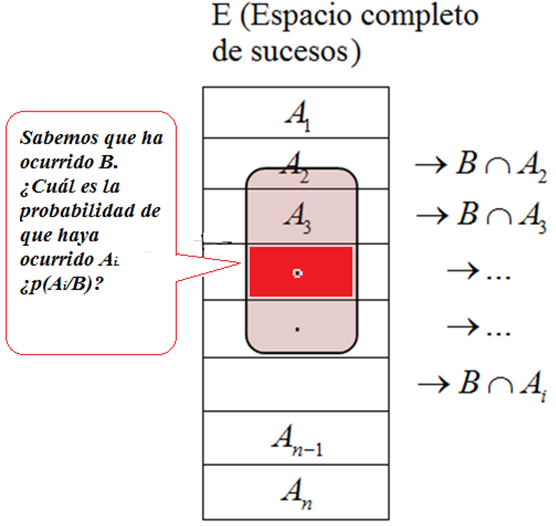

En cualquier experimento aleatorio la primera cosa que nos preguntamos es sobre lo que puede pasar. ¿Qué resultados puede ofrecer y cuáles no? Sería muy interesante disponer de todo el abanico de posibles resultados. En este sentido, al conjunto formado por todos los posibles resultados elementales de un experimento aleatorio se le denomina espacio muestral de dicho experimento. Dependiendo de como sea este conjunto, los espacios muestrales pueden ser:

Consideremos por ejemplo:

Los ejemplos que podrían exponerse son innumerables y seguro que ya estás pensando en diversas situaciones. No obstante, de partida, queremos que te fijes y pienses en lo que te vamos a exponer. Observa el ejemplo (1) y el (4), el espacio muestral es el mismo, pero ¿puede considerarse el mismo?, esto es, los sucesos que aparecen sí son los mismos pero la ocurrencia de cada suceso en el experimento (1) no tiene el mismo comportamiento que la ocurrencia de cada suceso en el experimento (4) ¿No te parece?

En la siguiente escena puedes observar algunos ejemplos de experimentos aleatorios, sus espacios muestrales y cómo construirlos.

En el contexto probabilístico, denominamos suceso a cualquier subconjunto de un espacio muestral; esto es, a cualquier posible resultado de un experimento aleatorio.

Entre los diferentes sucesos destacaremos los siguientes:

En la escena siguiente puedes observar algunos ejemplos de un suceso y del suceso contrario o complementario.

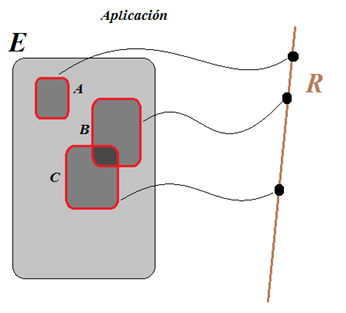

Desde el punto de vista matemático es importantísimo definir en este conjunto de todos los sucesos asociados a un experimento aleatorio, operaciones matemáticas que permitan la manipulación e interacción entre ellos.

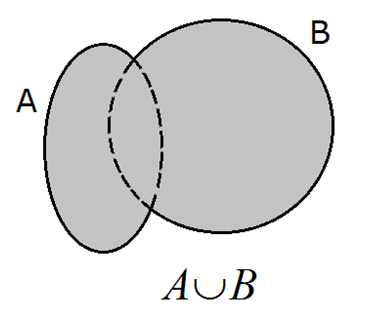

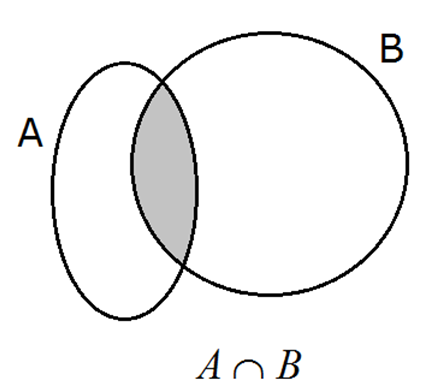

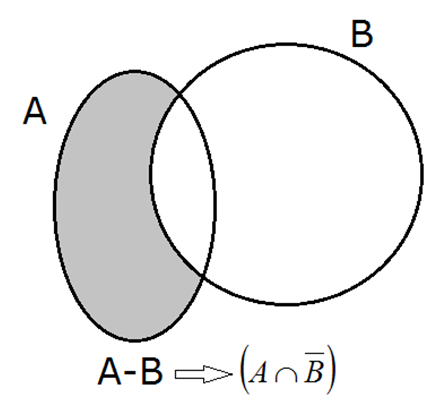

Así se pueden definir en el conjunto de todos los sucesos asociados a cualquier espacio muestral, fundamentalmente dos operaciones que dotarán a dicho conjunto de una sólida estructura matemática importante conocida con el nombre de Álgebra de Boole.

Unión de sucesos