Notas para el curso de Animación por Computadora

Joel Espinosa Longi

Universidad Nacional Autónoma de México

Título de la obra:

Notas para el curso de Animación por Computadora

Autor:

Joel Espinosa Longi

Código JavaScript para el libro: Joel Espinosa Longi, IMATE,

UNAM.

Imagen de portada: Joel Espinosa Longi

Tipografía: WorkSans, Aleo y UbuntuMono

Fórmulas matemáticas: $\KaTeX$

Red Educativa Digital Descartes

Córdoba (España)

descartes@proyectodescartes.org

https://proyectodescartes.org

Proyecto iCartesiLibri

https://proyectodescartes.org/iCartesiLibri/index.htm

https://prometeo.matem.unam.mx/recursos/VariosNiveles/iCartesiLibri/

ISBN: 978-84-18834-98-1

El contenido de esta obra esta bajo una licencia Creative Commons (Atribución-NoComercial-CompartirIgual).

Estas notas surgen con la finalidad de proporcionar un soporte al contenido de un curso “Animación por Computadora”, y presentan de manera general e integrada los temas más relevantes que un estudiante debe conocer sobre la Animación por Computadora. Esta obra aborda la parte teórica del curso y se excluye de este documento gran parte de la información de implementación y prácticas sobre software de modelado y animación, para evitar que la obra se vuelva más extensa de lo debido. Además, la implementación y el software a utilizar puede variar dependiendo del profesor que imparta el curso, por lo que partiendo de la libertad de cátedra no se pretende imponer ninguna metodología para impartir el curso.

Los temas expuestos en estas notas se encuentran ordenados siguiendo en gran medida el pipeline de producción de una animación en 3D, conjuntando conceptos de narración, diseño y computación.

La animación por computadora es omnipresente en el mundo actual y se emplea en numerosos contextos y situaciones. Este fenómeno se atribuye principalmente a la importancia que han adquirido los sistemas informáticos en la vida moderna, lo que ha permitido la creación de animaciones más complejas y realistas. Para comenzar a entender qué es la animación por computadora, es importante definirla y examinar los diferentes tipos y medios en los que se puede encontrar.

La palabra animación (https://dle.rae.es/animación) según la RAE se define como la acción y efecto de animar. El verbo animar (https://dle.rae.es/animar) se deriva del verbo latino animāre que significa: vivificar, reanimar, alegrar, infundir o dar ánimo. Entonces, el término animación se refiere a la acción de otorgar o infundir vida, por lo general, a objetos inanimados que no la poseen de forma natural.

El objetivo de la animación por computadora es crear la ilusión de vida para objetos y personajes que existen en un mundo virtual o digital. Para lograr esto, se llevan a cabo cambios en los atributos de los objetos animados, siendo estos atributos los encargados de definir diversas características como la posición, rotación, escala, color, texturas, visibilidad, entre otras más.

La animación por computadora, también conocida como animación digital, es una subárea de la graficación por computadora que se enfoca en estudiar los algoritmos y técnicas para crear objetos y personajes virtuales que se muevan e interactúen, dando la ilusión de vida. Así mismo la animación se trata del arte de crear imágenes en movimiento mediante el uso de una computadora, y como tal, la computadora es una herramienta esencial en este proceso, ya que facilita y acelera tareas que de otra manera serían monótonas y tediosas para un animador. Algunas de estas tareas incluyen la creación de objetos en dos y tres dimensiones, la simulación de fenómenos físicos, la creación de imágenes para el enriquecimiento visual, la interpolación de valores y la generación de las imágenes finales que componen la animación.

Existen tres formas principales de controlar el movimiento o los cambios que pueden presentar los objetos animados en la animación por computadora: animación artística, animación basada en datos y animación procedural.

La animación artística es la forma más artesanal o manual de realizar una animación, ya que aquí el animador controla y coordina directamente el movimiento de los objetos animados. En este proceso, el animador decide la apariencia de los objetos, su movimiento e interacción con otros elementos, todo con el fin de expresar una idea.

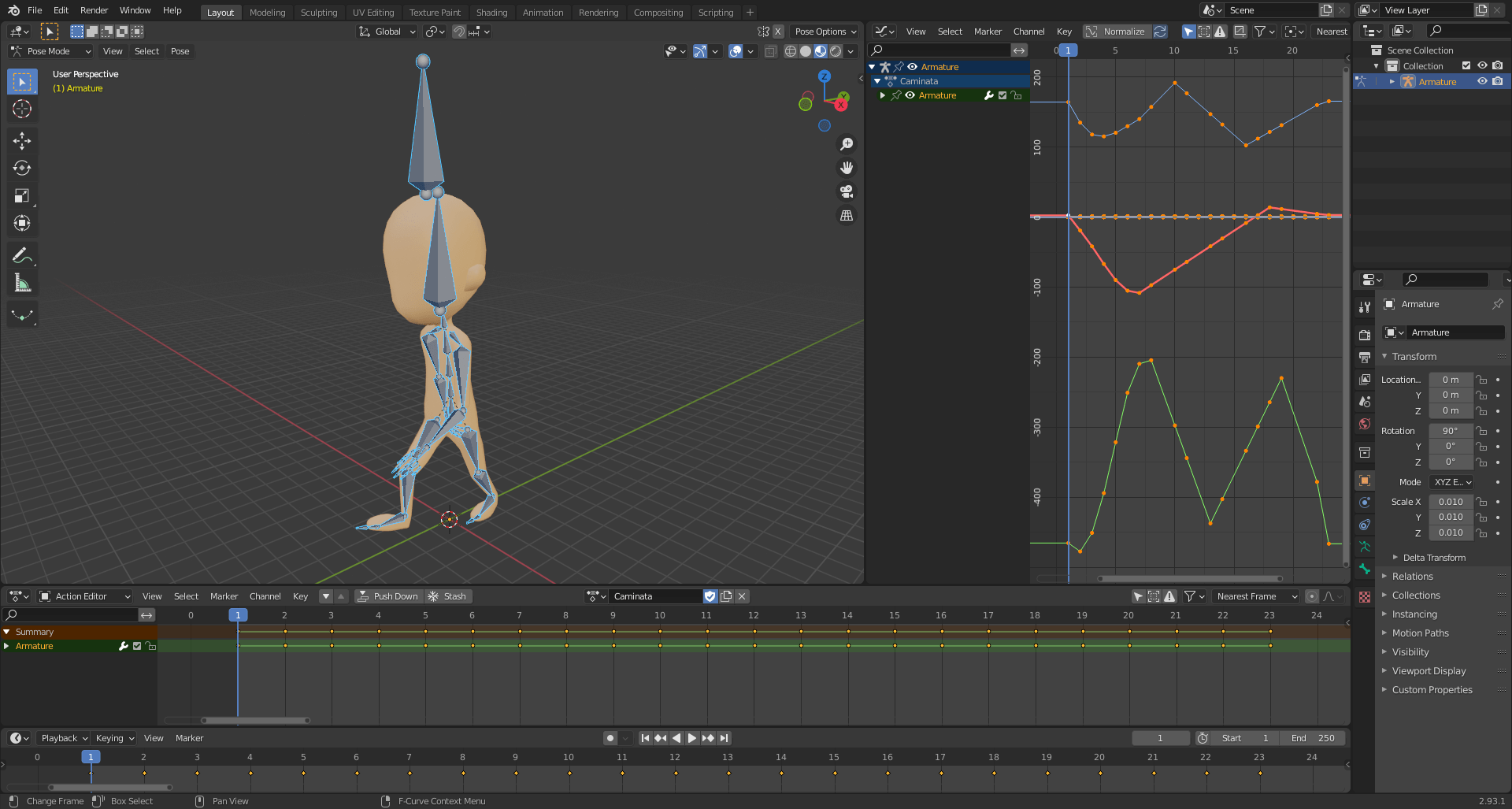

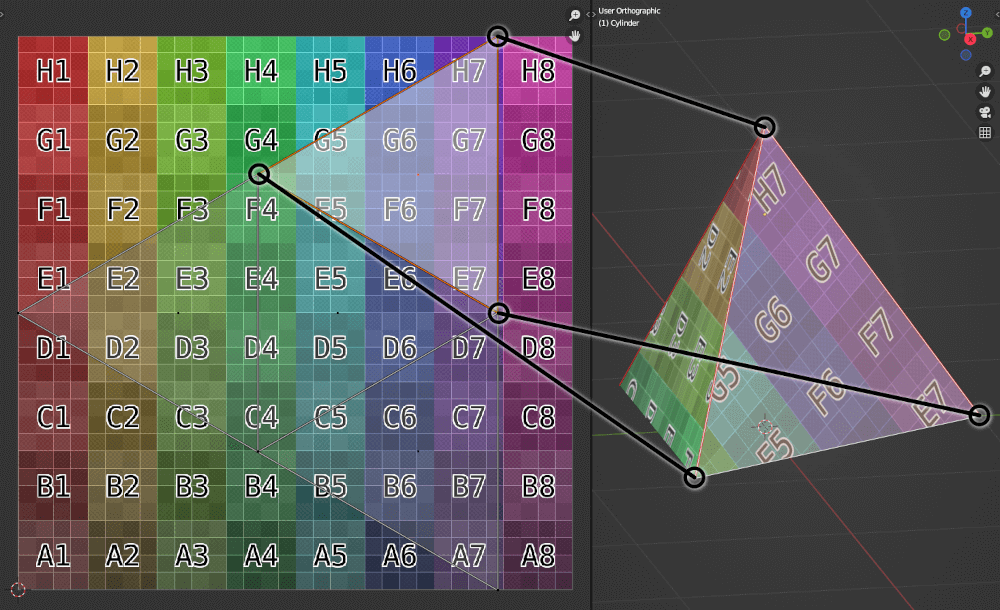

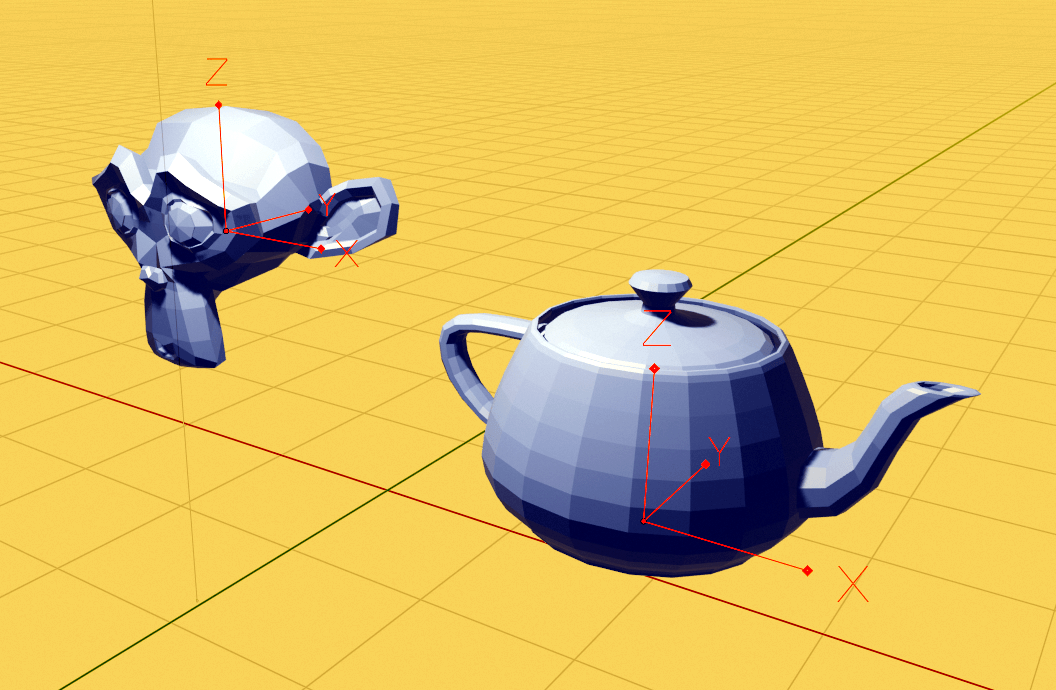

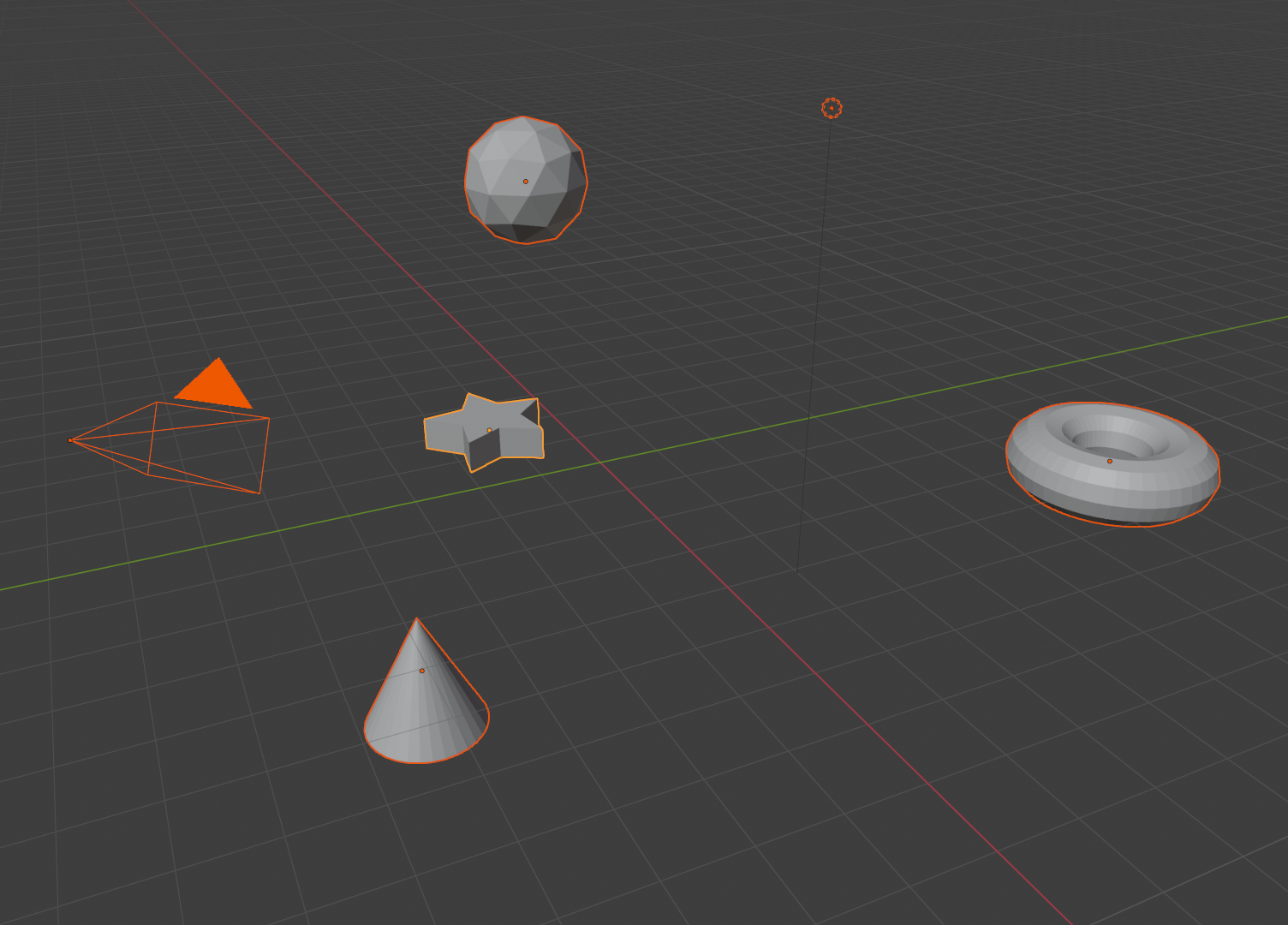

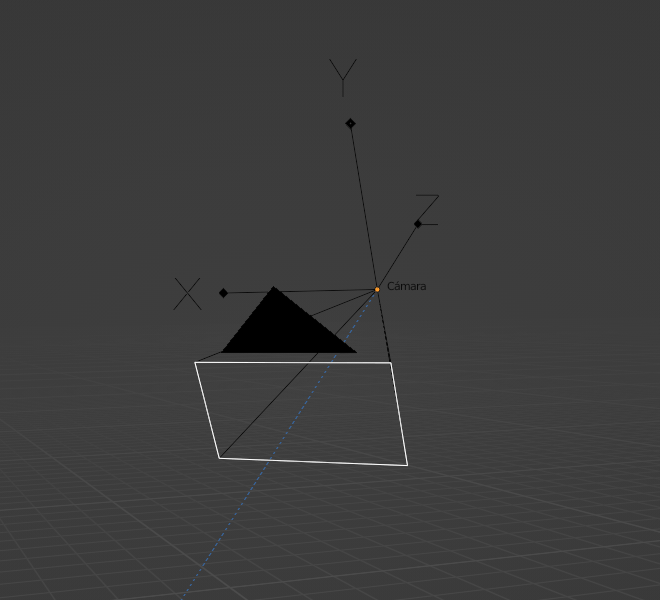

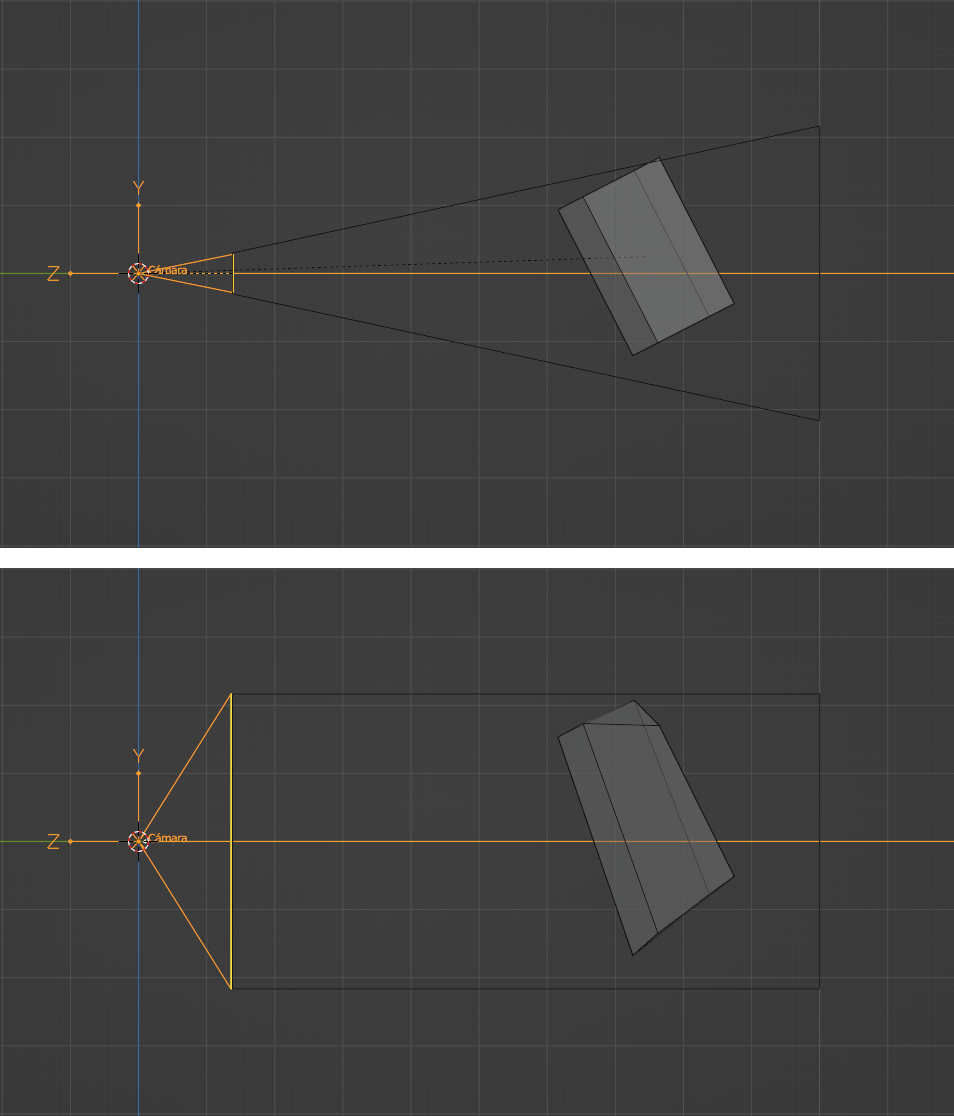

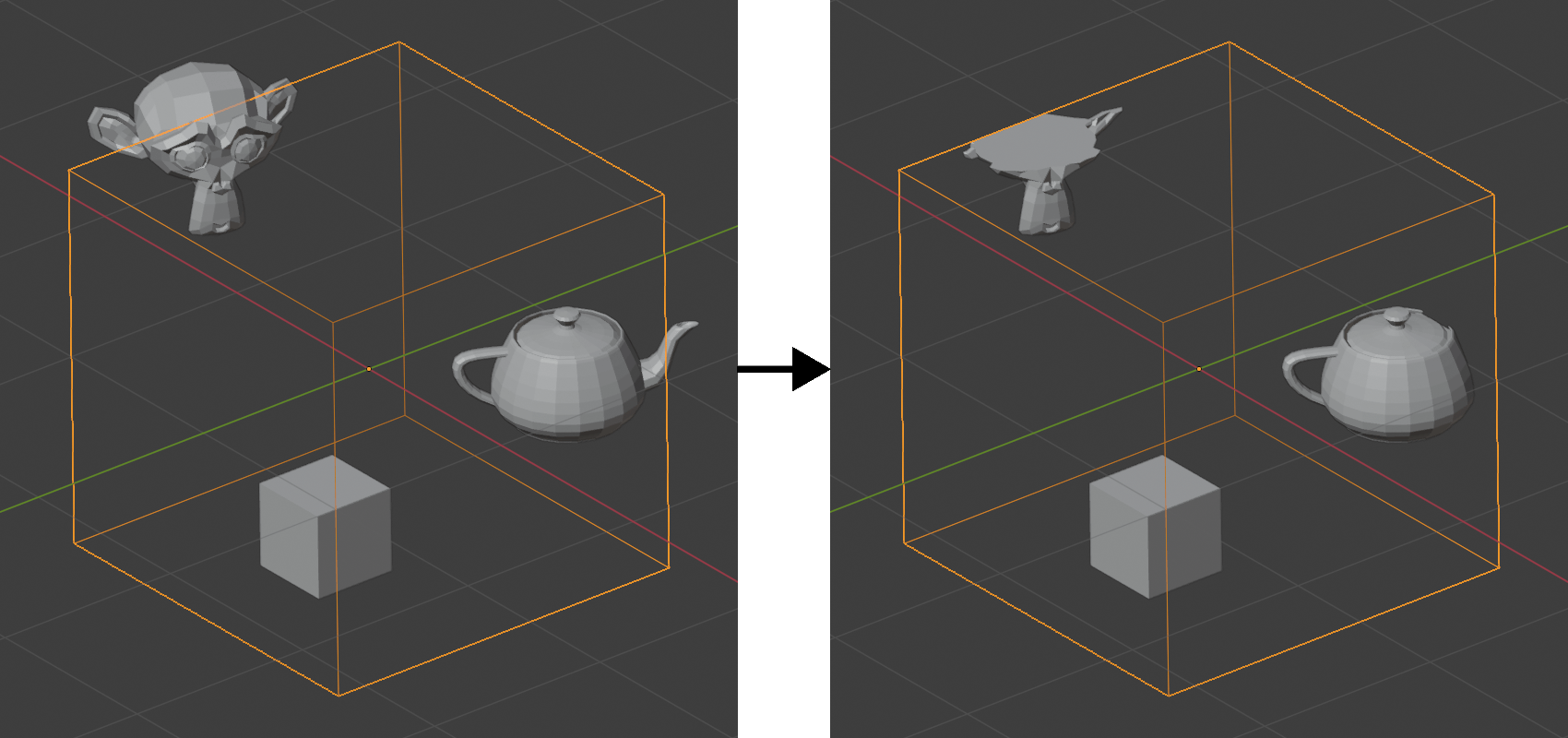

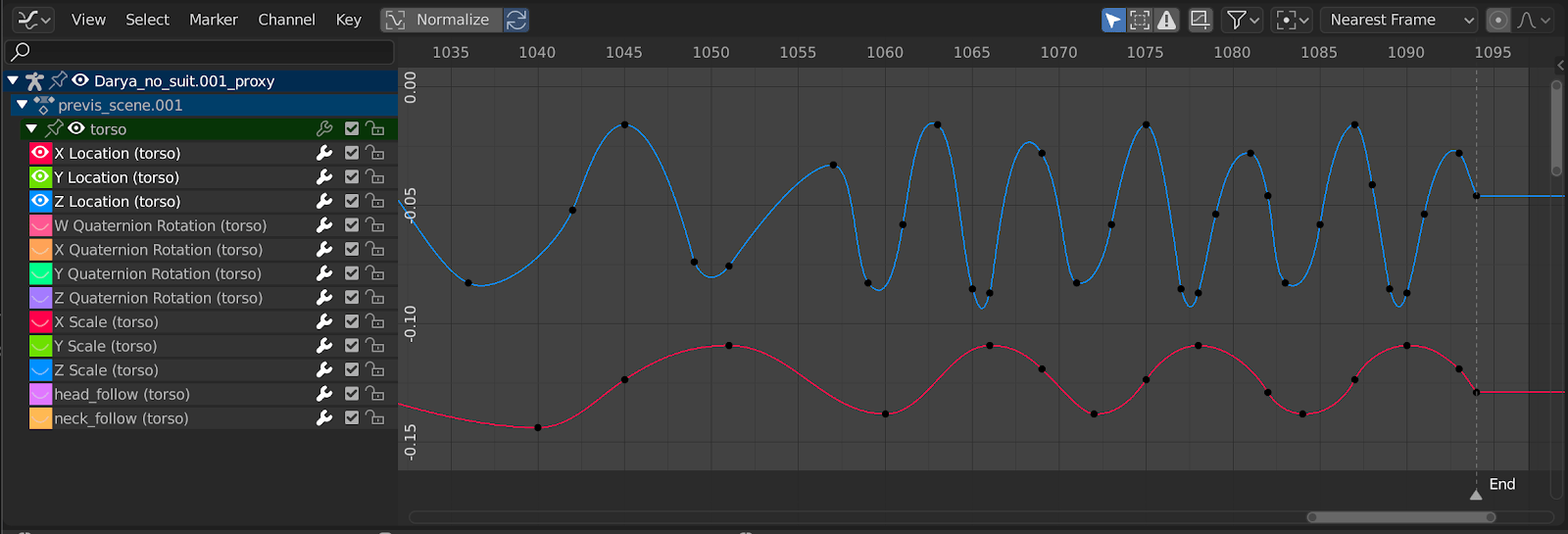

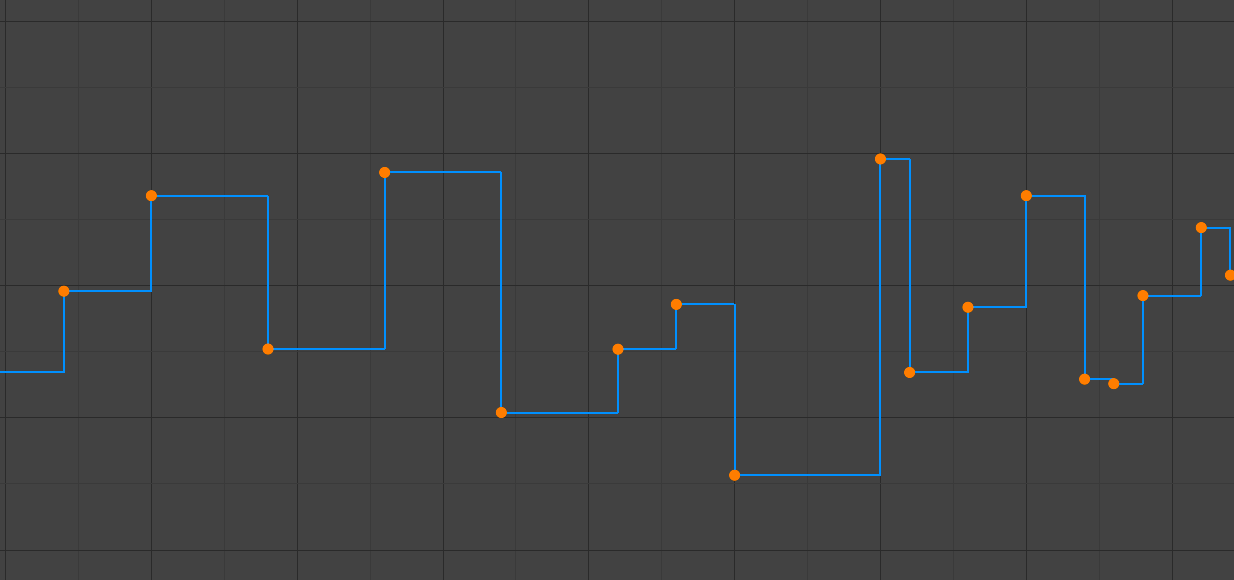

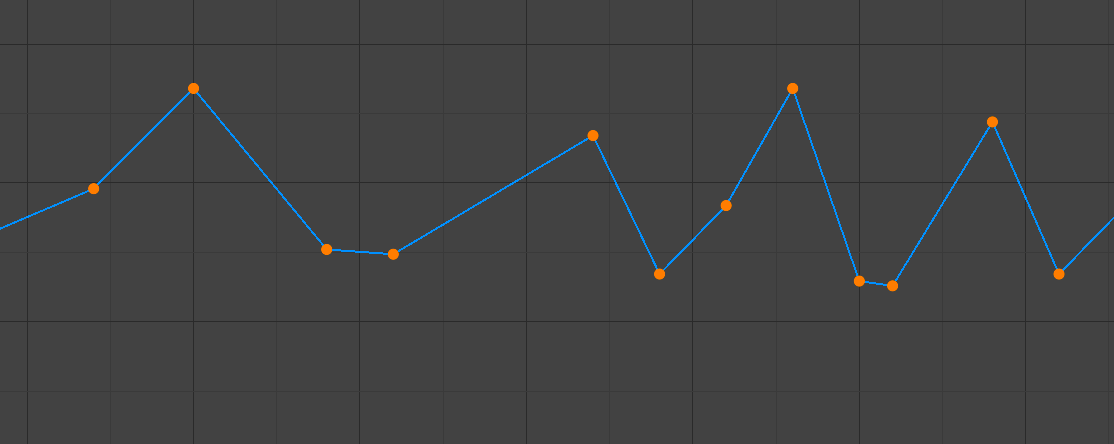

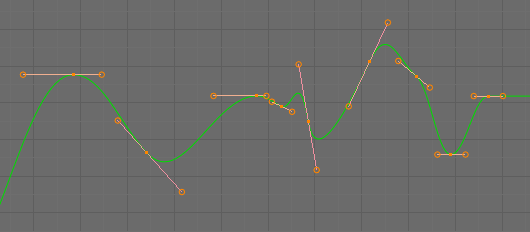

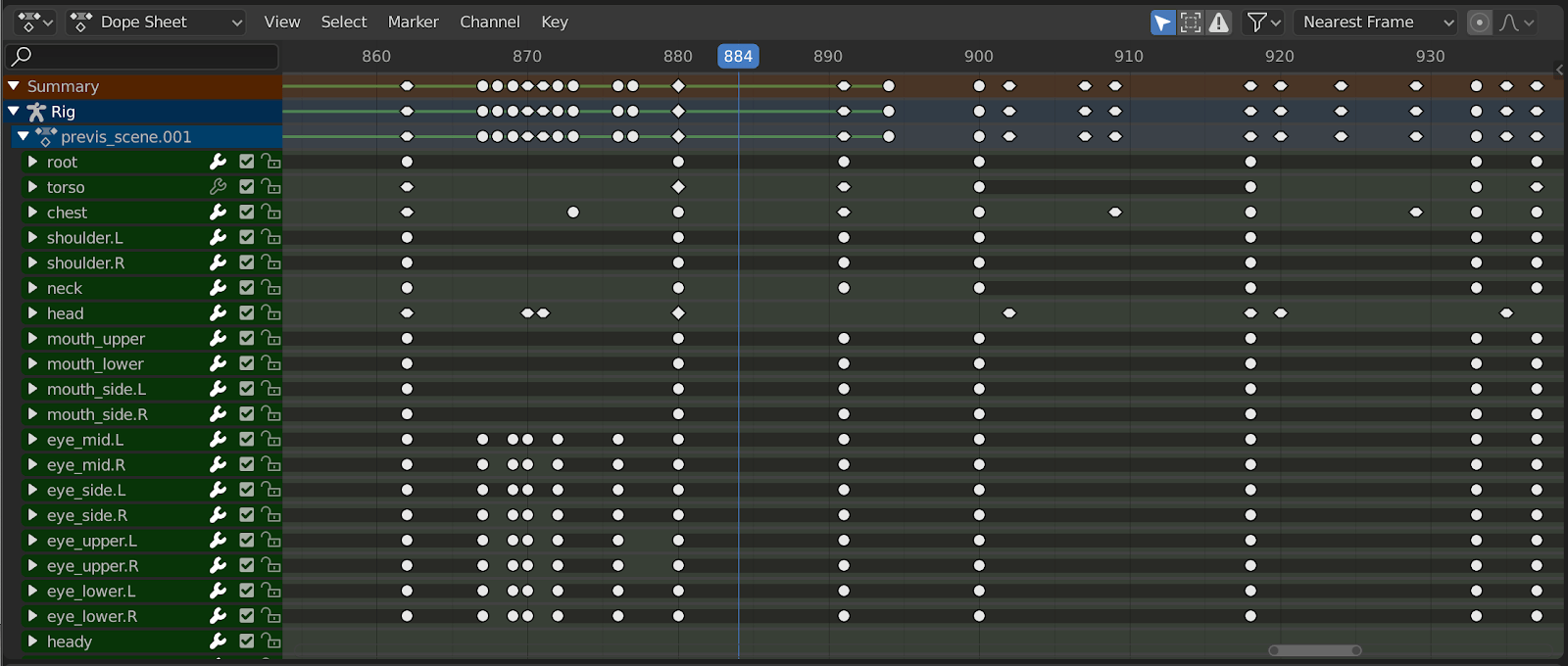

Para lograr este objetivo existen programas de modelado y animación como: Blender, 3ds Max, Maya, entre otros más; los cuales son aplicaciones muy sofisticadas que ofrecen diversas herramientas que permiten al artista manipular, controlar y modificar diferentes atributos de los objetos animados. En la se pueden observar algunas de las herramientas que proporciona Blender para este fin, como la línea de tiempo (parte inferior) y el editor de curvas (a la derecha).

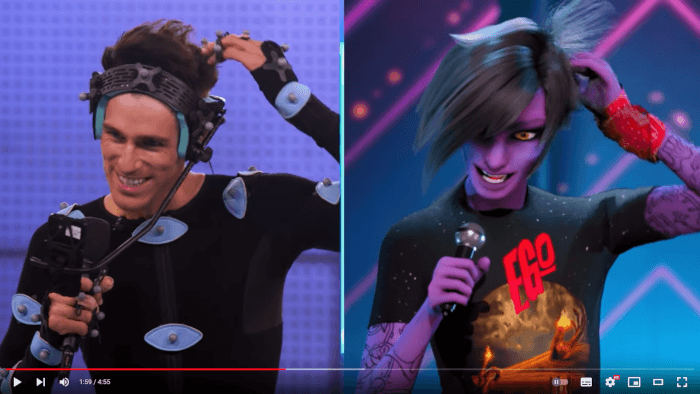

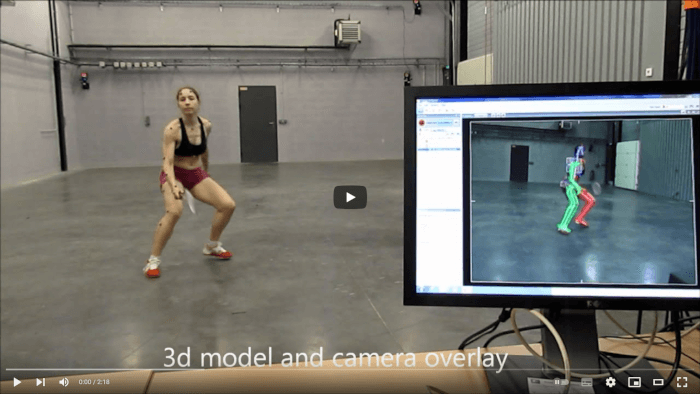

La animación basada en datos (data-driven animation) es un proceso en el que se utilizan datos de movimiento para animar los objetos virtuales. Para ello se emplean diversos sensores que recopilan información del mundo real, con la que se construye una representación computacional de dicha información. Aquí, no se requiere la interacción directa de un animador, ya que los datos de movimiento provienen del mundo real, solo es necesario que intervenga un animador en caso de que los datos requieran algún tipo de ajuste, depuración o modificación particular.

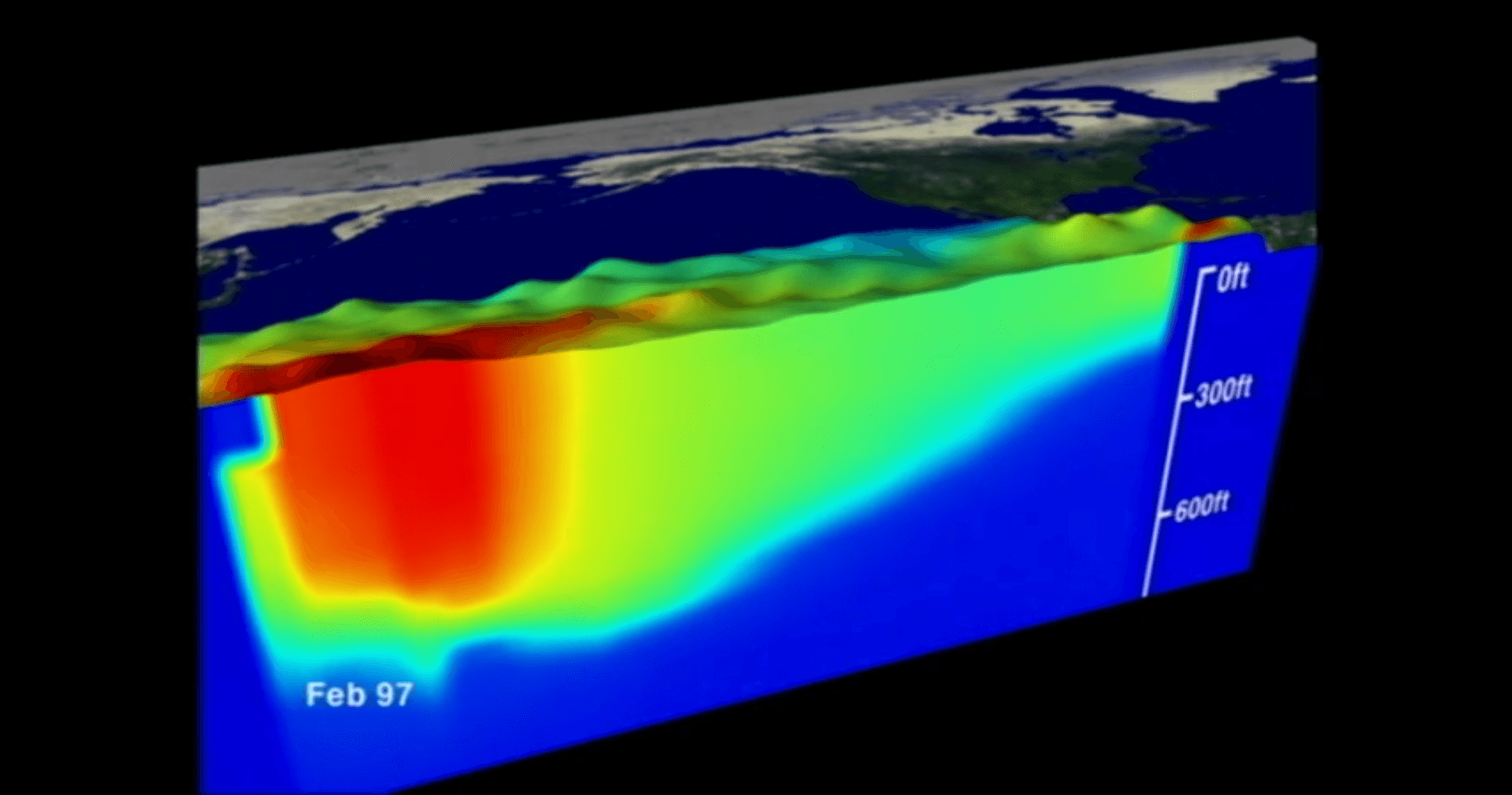

Esta forma de realizar una animación es útil para observar y estudiar fenómenos naturales, por ejemplo, si se tiene un arreglo de boyas en el mar que detectan diversos parámetros, como la temperatura del agua a diferentes profundidades, es posible crear una animación para visualizar los cambios en la temperatura del océano y tener una idea más clara de lo que sucede (ver ). Las animaciones de este estilo se utilizan ampliamente en el campo de la Visualización científica a veces llamada Visualización por Computadora.

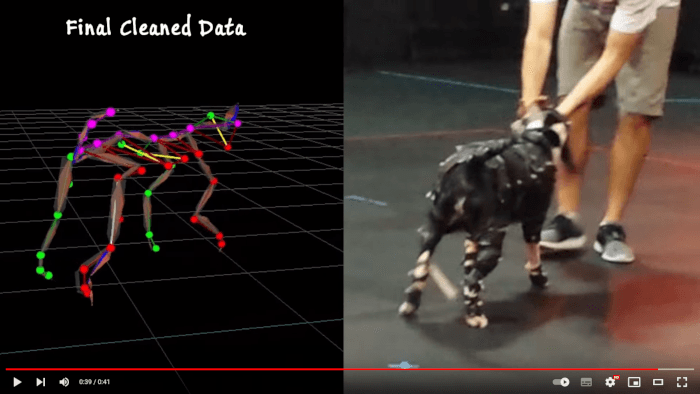

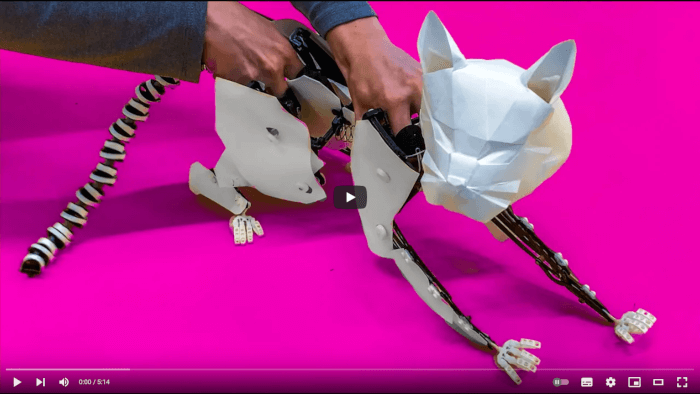

Otro uso común de la animación basada en datos es la captura de movimiento (motion capture), donde se registra el movimiento de una persona o animal mediante un traje o marcadores especiales para copiar o replicar dicho movimiento dentro de una animación ().

La animación procedural se basa en un modelo físico que controla los movimientos y cambios de los objetos. Este tipo de animación se utiliza ampliamente en motores de física de videojuegos para simular partículas, trayectorias balísticas, colisiones, reacciones entre objetos, fluidos y otros efectos más. Las animaciones procedurales por lo general se basan en modelos físicos como las leyes de mecánica de Newton, que dotan a los objetos de atributos como masa, velocidad, aceleración y densidad, así como las diversas fuerzas que interactúan con ellos.

Debido a que estas animaciones están basadas en reglas físicas, los animadores tienen poca participación en su creación, solo intervienen definiendo las condiciones iniciales del sistema y las propiedades de los elementos que serán parte de la simulación.

Estas tres formas de controlar los cambios en el tiempo no son excluyentes y pueden utilizarse conjuntamente para diferentes objetos o momentos dentro de una animación. Por ejemplo, es posible tener un personaje que realiza sus movimientos gracias a información de captura de movimiento (animación basada en datos), mientras que su ropa se mueve por medio de un motor de física que determina cómo las prendas deben comportarse (animación procedural), y para movimientos complicados que no son realizables por un actor, un animador puede realizar dichos movimientos de forma manual (animación artística), creando así una animación completa.

Actualmente, la animación por computadora se utiliza en diversos ámbitos y medios, siendo la ciencia y el entretenimiento los principales exponentes y usuarios de estas técnicas. Aún así existen otros campos que también exploran el uso de la animación por computadora para presentar información de manera creativa y atractiva. En general, la animación por computadora se emplea en cualquier situación en la que se requiere transmitir información de manera visual y mostrar cambios a lo largo del tiempo. Los objetivos de las animaciones pueden variar desde entretener hasta comprender los cambios que ocurren en algún fenómeno natural.

El entretenimiento es una actividad que las personas realizan para disfrutar del tiempo libre, a lo largo del tiempo, esta actividad ha evolucionado, adaptándose a las tendencias y tecnologías de la época. La animación por computadora se ha convertido en un medio importante para el entretenimiento, debido a que aprovecha los avances tecnológicos modernos para contar historias cada vez más diversas e interesantes.

Las películas u obras cinematográficas son un medio de entretenimiento que narra una historia a través de actores, escenarios y las acciones que se desarrollan. La animación por computadora ha ganado importancia en la producción de películas, ya que su uso facilita la creación de imágenes para componer la obra, permitiendo crear escenarios y personajes fantásticos que no pueden ser creados fácilmente en la vida real.

Hay dos categorías principales de películas creadas mediante la animación por computadora: las completamente animadas y las que utilizan efectos especiales generados por computadora.

Las películas totalmente animadas son un ejemplo claro de lo qué es la animación por computadora, ya que combinan de forma integral técnicas y conceptos de cine, animación tradicional y graficación por computadora. En este tipo de películas, todas las imágenes que componen la obra son generadas enteramente por una computadora.

Es importante destacar que las películas totalmente animadas han ganado una gran popularidad en la industria del cine, ya que al no depender de actores o escenarios reales, se pueden crear mundos y personajes fantásticos que no serían posibles de otra manera. Además, la animación por computadora permite alcanzar un nivel de detalle y precisión que sería muy difícil de lograr con métodos tradicionales.

Actualmente, hay numerosas películas totalmente animadas, y muchos estudios de animación se dedican a su creación. Algunos ejemplos de películas totalmente animadas incluyen:

Los ejemplos anteriores vienen por parte de estudios Hollywoodenses, que son de los más conocidos a nivel mundial, aún así existen diversos estudios de animación en todo el mundo que desarrollan animaciones generadas por computadora.

Por ejemplo, la fundación Blender con sede en Amsterdam, a través de Blender Studio ha creado varios cortos animados para probar las características y necesidades de la herramienta Blender. Algunas de las animaciones que han realizado son:

México cuenta con algunos estudios de animación, como Ánima Estudios y Huevocartoon, que comenzaron desarrollando animaciones en 2D, pero actualmente también desarrollan animaciones en 3D. Algunos ejemplos de sus producciones en 3D son:

Otras películas completamente animadas por computadora, desarrolladas en otras partes del mundo, incluyen:

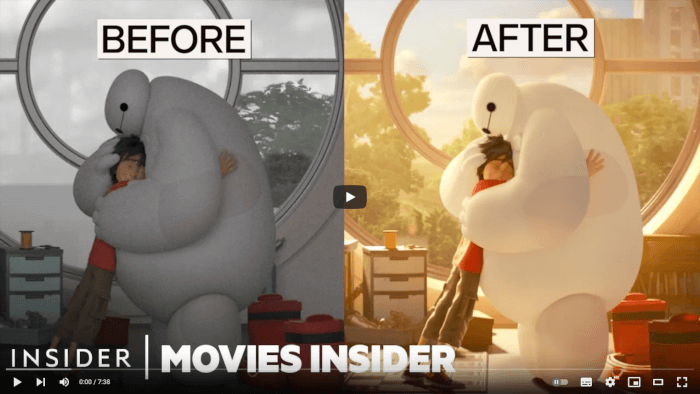

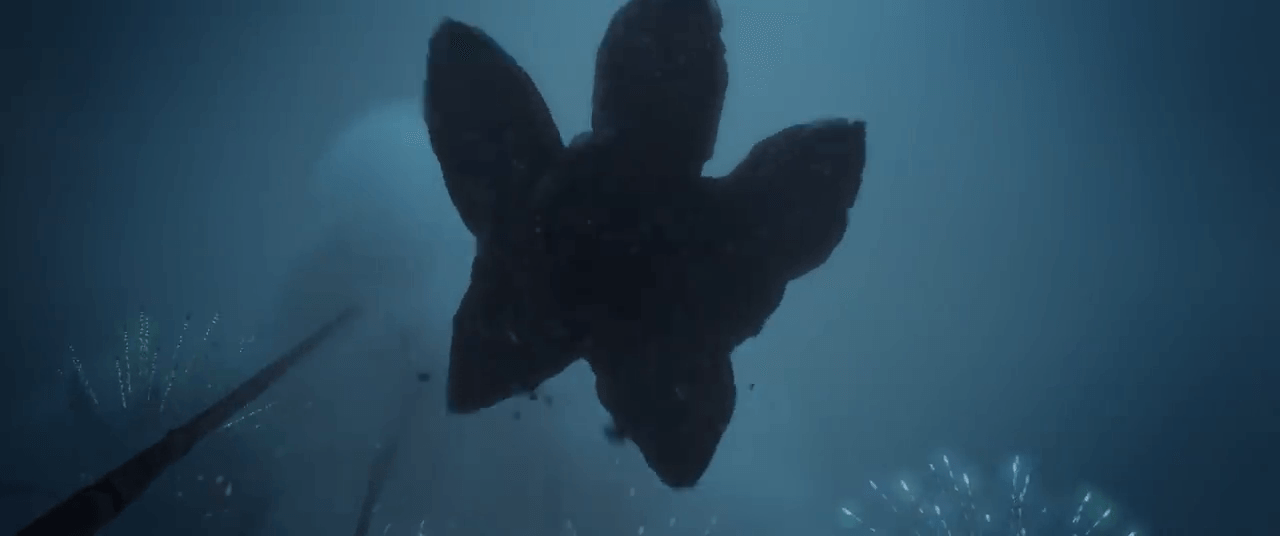

Las películas que utilizan efectos especiales generados por computadora son aquellas en las que se filman actores o escenarios en el mundo real y se agregan elementos generados por computadora, como fondos, personajes u otros elementos. El término “efectos especiales” es muy amplio y puede incluir cualquier elemento visual agregado a una grabación del mundo real mediante una computadora. En estas películas, las gráficas y animaciones generadas por computadora siempre se combinan con elementos producidos y grabados en la vida real.

Un ejemplo clásico de película que utiliza la animación por computadora como efectos especiales es: Tron de 1982 producida por “Walt Disney Productions” (); que se considera la primera película que mezcla imágenes generadas por computadora o CGI (Computer Generated Imagery) con acción en vivo, y es un buen ejemplo de una película que utiliza la animación por computadora como efectos especiales.

Otros ejemplos de películas que utilizan efectos especiales:

La animación por computadora en películas que la utilizan como efectos especiales ofrece la posibilidad de crear elementos difíciles de construir o crear en la vida real, enriqueciendo las posibilidades narrativas del medio permitiendo explorar ideas fuera de la realidad y presentarlas en una pantalla de una manera más realista y convincente.

La televisión es un medio de entretenimiento que presenta obras audiovisuales en horarios predeterminados, que a menudo incluyen pausas para comerciales. Se pueden ver en la televisión, muchos años después, películas que fueron estrenadas en cines; así como programas específicos para este medio, como series televisivas, que cuentan historias largas divididas en varios episodios.

Los servicios de streaming han cambiado algunas cosas de la televisión tradicional, como la forma en que se accede al contenido, lo que permite ver programas sin pausas comerciales en el momento y horario que el espectador desee. Aunque la forma de acceder al contenido ha cambiado, el concepto de serie televisiva sigue siendo popular en los medios de streaming actuales ya que permite dosificar el contenido de una historia en diversos episodios o capítulos.

En cuanto al uso de la animación por computadora en la televisión, se encuentran las mismas dos categorías que en el cine: completamente generadas por computadora y como efectos especiales. Hay que mencionar que las producciones televisivas o de streaming suelen tener más restricciones de presupuesto, tiempo y alcance, que las producciones cinematográficas, lo que se puede observar en la reducción de la calidad visual de las producciones televisivas. Algunos ejemplos de animación en la televisión generada completamente por computadora son:

También es posible encontrar producciones donde se utilizan diversos medios para generar la animación, como es el caso del “El asombroso mundo de Gumball”, donde se pueden observar animación 2D tradicional, animación 3D y elementos de acción en vivo, todo mezclado de forma coherente y que le imprime vida propia a la producción.

Ejemplos de animación en la televisión (o streaming) donde se utiliza la animación por computadora como efectos especiales:

Un videojuego es un sistema electrónico que permite la interacción de un jugador con un mundo virtual, principalmente a través de elementos gráficos como textos, menús, modelos 3D e imágenes. La animación por computadora se utiliza en los videojuegos para presentar el estado del juego a través de gráficas interactivas, como la animación del personaje principal y las interacciones con otros objetos, y para videos pregrabados que cuentan la historia del juego.

La animación por computadora se utiliza en los videojuegos con dos propósitos principales:

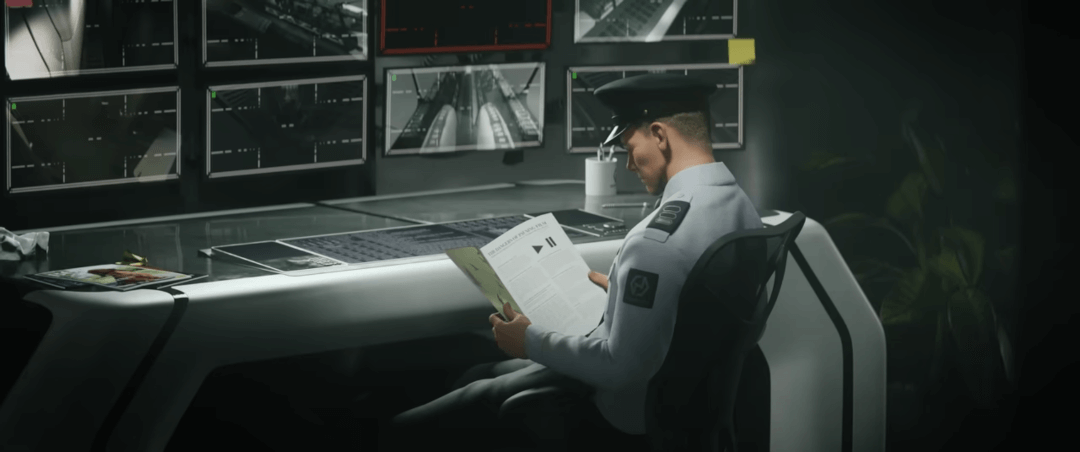

Hace muchos años atrás, se apreciaba una gran diferencia en la calidad visual entre las gráficas interactivas y las cinemáticas, ya que las cinemáticas solían utilizar animaciones generadas previamente u offline (como en una película), mientras que las gráficas interactivas se generan en tiempo real por lo que su calidad depende del poder de cómputo de la máquina que ejecuta el videojuego. Sin embargo, con el avance de la tecnología la distinción se ha vuelto cada vez menor, haciendo que en la actualidad muchas de las animaciones presentadas en las cinemáticas utilicen las mismas gráficas de la parte interactiva, limitando solo la interacción del jugador y ecualizando su presentación.

Los videojuegos clásicos como Pong, Space Invaders, Pac Man, entre otros muchos más, a pesar de su apariencia simple en comparación con los videojuegos modernos, utilizan elementos esenciales de la animación por computadora para presentar los cambios e interacciones entre los objetos. La animación de personajes y objetos, detección de colisiones, programación de inteligencia artificial y física del juego que se desarrollaron en estos juegos sentaron las bases para muchos videojuegos modernos, siendo pioneros en el desarrollo de videojuegos al proporcionar las bases de muchos de los elementos que se utilizan actualmente.

Debido a las limitaciones tecnológicas de la época en la que fueron desarrollados, estos juegos no podían hacer uso de gráficos avanzados en 3D o animaciones complejas. En su lugar, se valieron de animaciones simples pero efectivas para mejorar la interacción y la presentación del juego. Por ejemplo, en el caso de Pong, la animación del movimiento de la pelota y las paletas, la detección de colisiones y el cambio de dirección de la pelota se realiza mediante técnicas de simulación, graficación y animación por computadora.

Con el avance de la tecnología, los videojuegos han experimentado un cambio significativo logrando representaciones visuales más ricas y atractivas. Un elemento fundamental en esta evolución ha sido el uso de imágenes conocidas como sprites, que son gráficos en 2D empleados para representar personajes, objetos y elementos del escenario dentro del juego. Los sprites han estado presentes desde las etapas iniciales del desarrollo de videojuegos, siendo un recurso esencial para la presentación visual de los mismos. Estos gráficos se han vuelto cada vez más complejos y detallados; y en la actualidad, los desarrolladores pueden crear sprites de alta resolución y detalles diseñados minuciosamente, permitiendo una representación atractiva de los elementos del juego.

Además de su uso para representar elementos del juego, los sprites pueden ser manipulados de diferentes maneras para crear efectos visuales interesantes. Por ejemplo, se puede hacer que un sprite cambie de tamaño o se desvanezca en la pantalla para crear una sensación de profundidad y movimiento, así mismo se pueden crear capas de sprites para crear un efecto de paralaje, que da la sensación de que los elementos del juego se mueven a diferentes velocidades.

Algunos ejemplos de juegos que utilizan sprites se muestran a continuación:

Existen juegos que combinan imágenes en 2D (sprites) con mundos tridimensionales, donde se conjuntan las técnicas de animación 2D con las 3D, a este tipo de mezcla se le conoce como 2.5D haciendo referencia a algo intermedio entre dos y tres dimensiones. En este tipo de videojuegos, aunque los mundos y a veces los personajes sean tridimensionales, el movimiento está restringido a dos dimensiones, es decir, a diferencia de los juegos completamente en 3D, el movimiento está limitado a un plano de acción o a una cámara que generalmente se encuentra fija durante el movimiento del personaje, por lo que no es posible manipular libremente la cámara para explorar el entorno. Algunos ejemplos serían:

Una de las ventajas de los juegos en 2.5D es que pueden utilizar sprites detallados con los que se ofrecen mundos visualmente atractivos, sin la necesidad de tener una computadora muy potente, como se requeriría para un juego completamente en 3D.

El aumento en el poder de cómputo ha permitido la representación de mundos virtuales cada vez más complejos, estas mejoras en las capacidades computacionales ha dado lugar a la creación de nuevos algoritmos que representan la realidad de manera más fiel y proporcionan herramientas más sofisticadas para la creación y animación de estos mundos.

Los avances en la tecnología de motores de videojuegos y herramientas de creación han permitido a los desarrolladores diseñar entornos virtuales más detallados y realistas que nunca, lo cual contribuye a experiencias de juego más inmersivas y atractivas. Las grandes producciones de videojuegos suelen utilizar gráficos en 3D para ofrecer una representación del juego lo más realista o estilizada posible.

Con los avances tecnológicos en motores de videojuegos como Unreal Engine y Unity, y en herramientas para la creación de modelos, texturas y animaciones como MetaHuman o Blender, el realismo en los videojuegos se ha convertido en un factor que los jugadores valoran y buscan. Gracias a esto, los desarrolladores pueden crear mundos virtuales cada vez más detallados y realistas, lo que permite a los jugadores sumergirse en experiencias de juego cada vez más estimulantes e inmersivas. Además, los motores de videojuegos modernos ofrecen una amplia gama de herramientas para crear efectos visuales impresionantes, como iluminación dinámica, sombras y efectos climáticos, lo que contribuye aún más a la sensación de realismo.

Algunos ejemplos de juegos en 3D que buscan el fotorrealismo:

En los videojuegos, se busca tanto la representación realista en 3D como la emulación de diferentes estilos artísticos. Por ejemplo, los juegos con estilo anime o caricaturesco utilizan técnicas como texturas y sombras, colores saturados y formas simplificadas para lograr una apariencia estilizada y artística. Estos estilos pueden ser atractivos para los jugadores en busca de una experiencia visualmente única y creativa.

Ejemplos de juegos 3D que intentan parecer 2D:

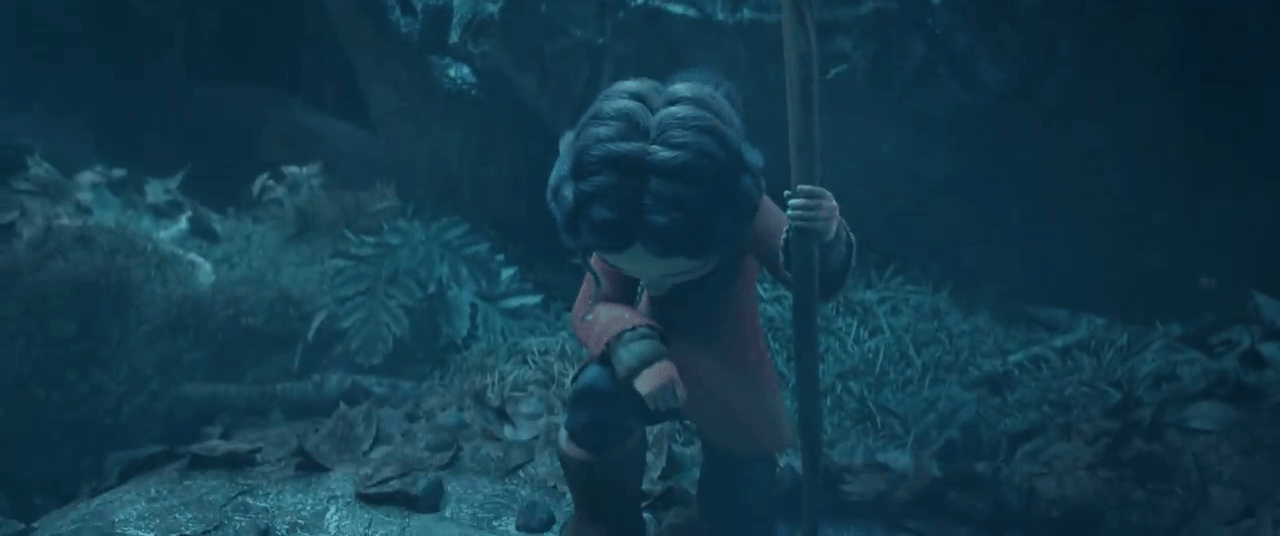

A continuación se presentan un par de videos y , donde se pueden ver las gráficas utilizadas en el juego Final Fantasy VII original de 1997 y su remake lanzado en 2020. Al observar los videos se puede apreciar cómo la tecnología ha permitido a los desarrolladores crear gráficas más avanzadas y realistas en el remake, lo que refleja la evolución de la industria de los videojuegos en los últimos años. Además, el remake realiza una reinterpretación del estilo artístico del juego original para adaptarse a las expectativas de los consumidores y su capacidad para crear gráficas más detalladas y realistas.

La principal diferencia entre la animación utilizada en cine y televisión con la empleada en videojuegos, radica en el grado de interacción que tiene el usuario (o espectador). En el cine y la televisión, el espectador es un mero receptor pasivo que observa un contenido pregrabado, mientras que en los videojuegos, el usuario se convierte en un actor que controla las acciones de un personaje y se vuelve un elemento fundamental de la experiencia. Aunque es cierto que algunos videojuegos utilizan cinemáticas para narrar partes de la historia, esto no es una característica presente en todos ellos y, en cualquier caso, no constituye la totalidad del videojuego.

La publicidad tiene tres objetivos fundamentales:

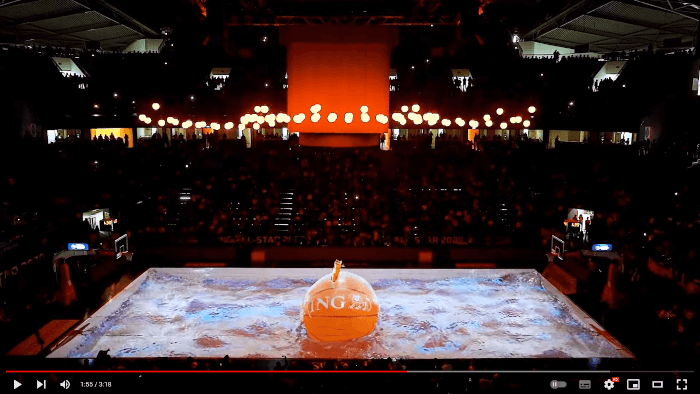

Siguiendo estos tres objetivos, la animación publicitaria se enfoca en presentar un producto o servicio de forma concisa, creativa y dinámica, con la intención de fomentar su consumo. Los anuncios publicitarios, también conocidos como comerciales o spots, suelen ser animaciones breves y claras que buscan atraer la atención de los posibles clientes y vender un producto o servicio de la manera más rápida y eficiente posible.

La animación por computadora ofrece una serie de ventajas para la creación de anuncios publicitarios. Una de las más importantes es que permite a los publicistas crear escenas que serían imposibles de filmar en la vida real, lo que proporciona una gran libertad creativa para diseñar anuncios que sean memorables y que capten la atención de los consumidores. Otra ventaja es que los publicistas pueden hacer cambios y ajustes fácilmente a lo largo del proceso de producción, lo que es muy útil para cumplir con plazos y presupuestos ajustados, y así mismo permite a los publicistas explorar diferentes opciones creativas antes de decidir cuál es la mejor para su anuncio.

Ejemplos de publicidad:

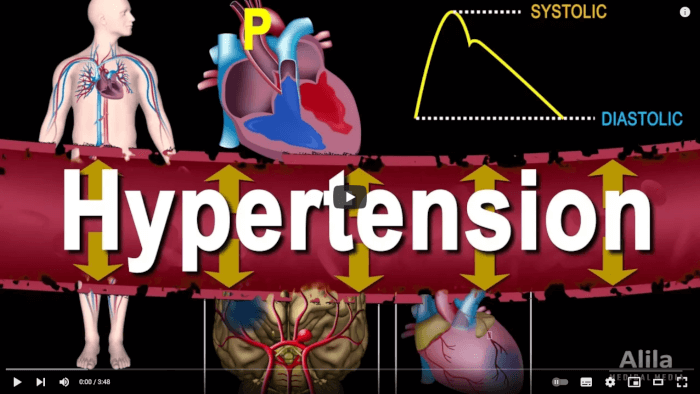

La animación desempeña un papel vital en el ámbito científico al facilitar la explicación y comprensión de fenómenos físicos, químicos o biológicos. Su objetivo principal es proporcionar una visualización clara que permita estudiar e interpretar las características fundamentales de dichos procesos.

Desde una perspectiva educativa, la animación ha adquirido un rol crucial en la ciencia, al ofrecer una herramienta invaluable para presentar procedimientos médicos y biológicos difíciles de observar directamente. Esto no solo facilita la enseñanza del conocimiento, sino que también hace que la comprensión de estos conceptos sea más accesible para los estudiantes.

En el contexto de las animaciones científicas, se enfatiza la transmisión de información precisa y efectiva sobre un fenómeno en particular. Muchas representaciones basadas en datos reales permiten replicar procesos naturales con una alta grado de precisión, no obstante, es igualmente posible emplear técnicas más artísticas siempre que se pueda transmitir la información de manera clara y eficiente.

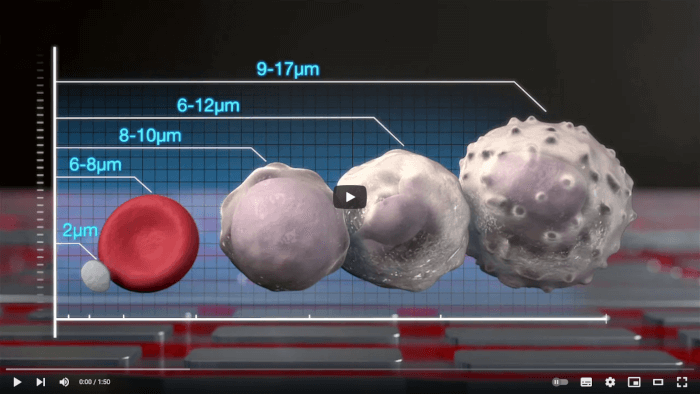

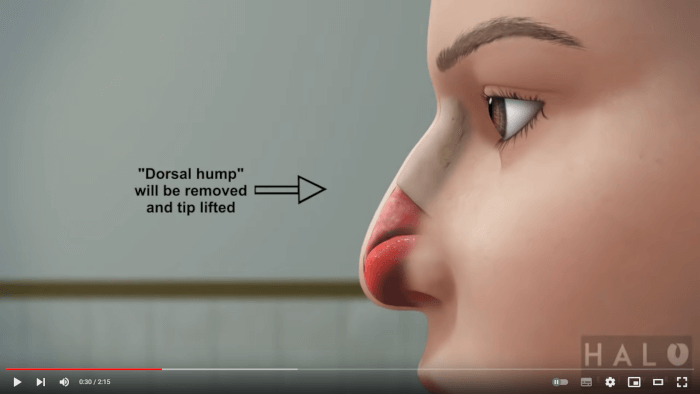

La animación 3D es ampliamente utilizada en el campo de la medicina para visualizar y exponer procesos biológicos complejos y diversas enfermedades. También desempeña un papel fundamental en la comunicación de procedimientos clínicos, proporcionando una representación detallada que facilita la comprensión del paciente y del personal médico, principalmente en situaciones donde las grabaciones reales no son posibles.

Ejemplos de procesos biológicos:

Ejemplos de procedimientos médicos:

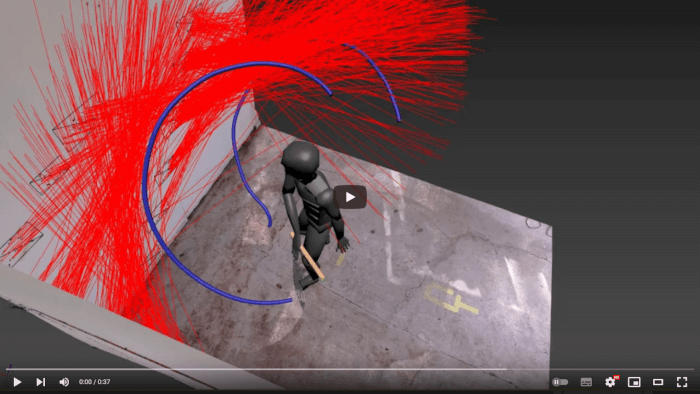

La animación también se utiliza en el análisis forense, especialmente para recrear escenas de crímenes, esto proporciona una visión más clara de los sucesos que tuvieron lugar en diferentes tipos de delitos y facilita una comprensión más completa de los hechos.

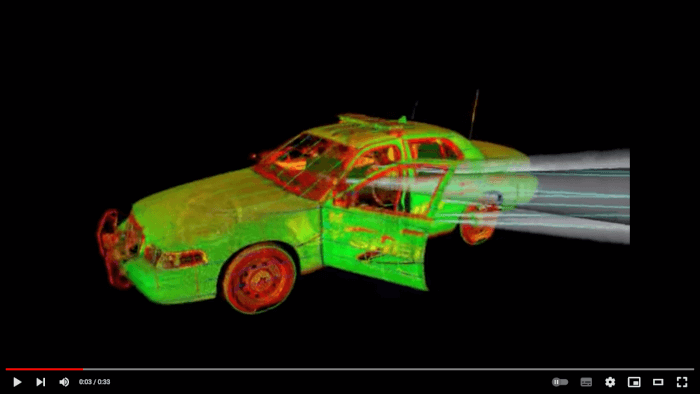

Para recrear las circunstancias en las que ocurrió un delito, se aplican técnicas de simulación y animación, que incluye la localización de los objetos e individuos involucrados, así como la trayectoria de las balas y otros datos obtenidos en el lugar del crimen. La animación forense se ha convertido en una herramienta esencial para los criminalistas, ya que proporciona información relevante en situaciones donde los testigos son limitados o poco confiables.

Además, es posible analizar estos elementos desde múltiples perspectivas, lo cual permite obtener una comprensión más completa y precisa de los hechos, de esta manera la animación forense puede aportar información vital en el desarrollo de pruebas sólidas que contribuyen a resolver los delitos.

Algunos ejemplos de animación en el análisis forense:

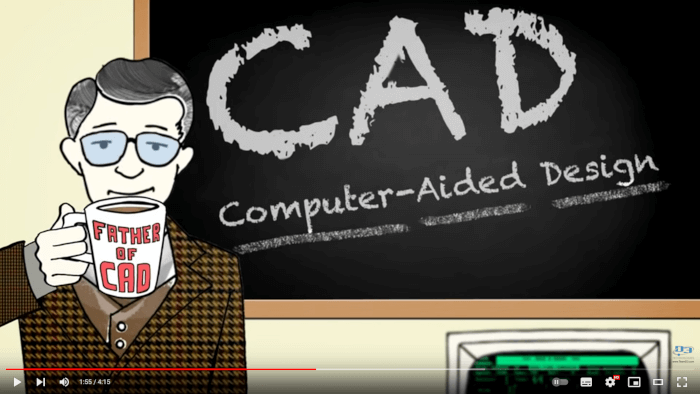

La utilización del software de diseño asistido por computadora (Computer-Aided Design, CAD) se remonta prácticamente al inicio de la graficación por computadora, ofreciendo la posibilidad de simplificar y mejorar el proceso de creación y diseño de planos arquitectónicos.

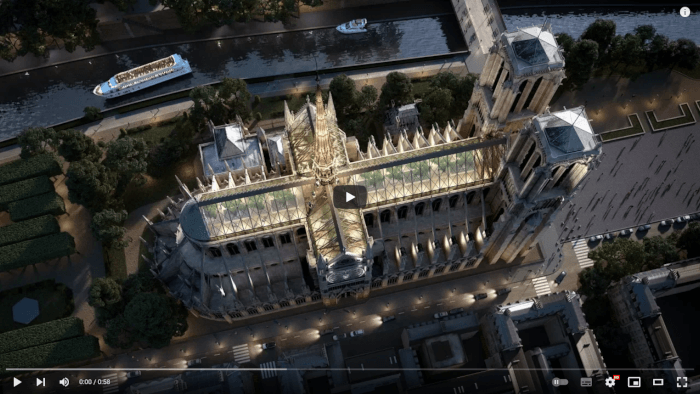

La animación por computadora se ha convertido en una herramienta útil para los arquitectos, ya que les permite mostrar la construcción de estructuras arquitectónicas como parte del proceso de diseño y planificación. De esta forma, pueden manipular y visualizar la construcción antes de comenzar con el trabajo en el mundo real, lo que facilita la exploración de diferentes tipos de materiales y acabados, así como de diversas técnicas de construcción.

Algunos ejemplos de animación en la arquitectura:

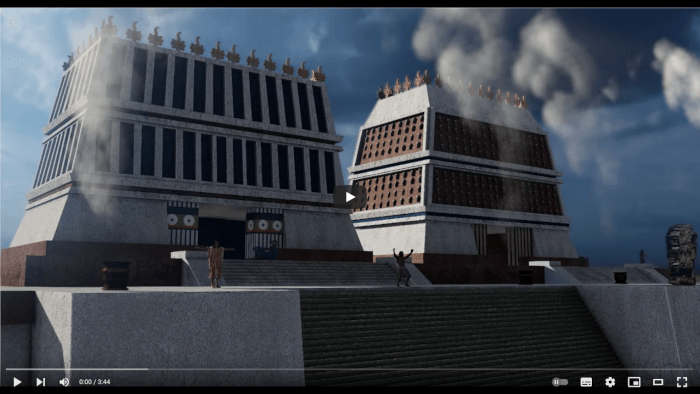

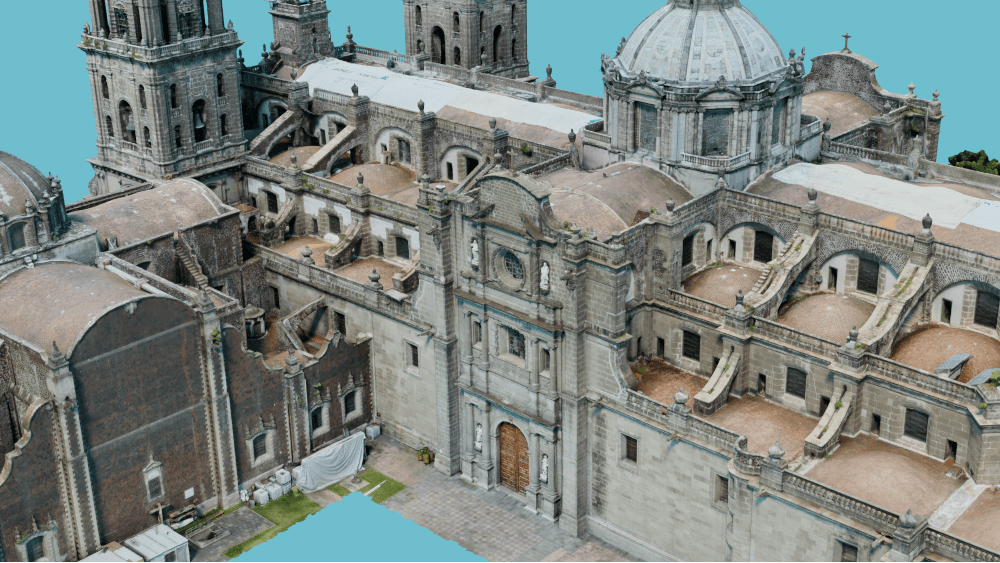

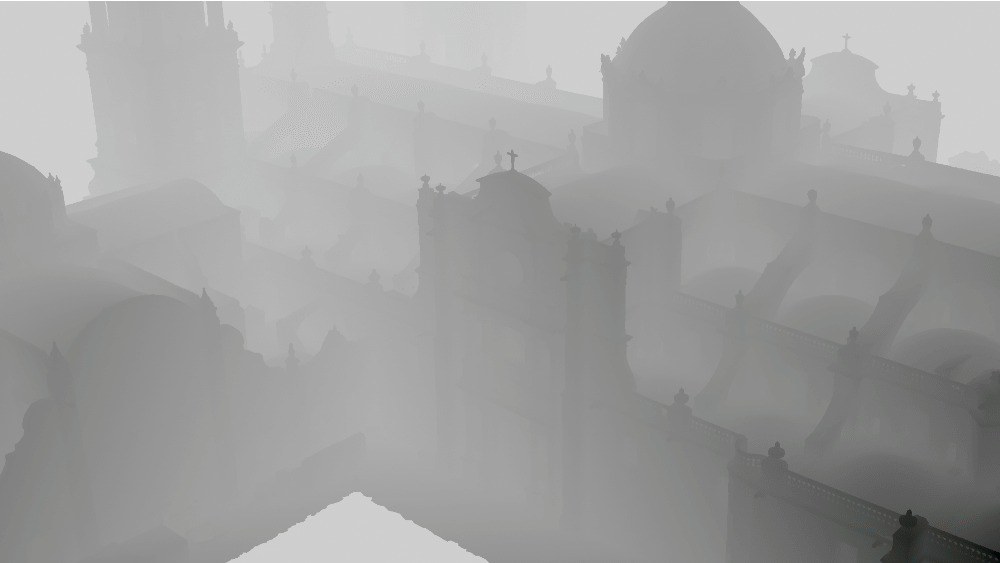

Además, la animación por computadora ofrece la posibilidad de realizar reconstrucciones virtuales para visualizar áreas dañadas o lugares que ya no existen en la actualidad, lo que permite preservar y estudiar el patrimonio arqueológico de forma no destructiva, brindando una visión tridimensional del pasado. A este uso de la animación se le conoce como arqueología virtual.

Algunos ejemplos se muestran a continuación:

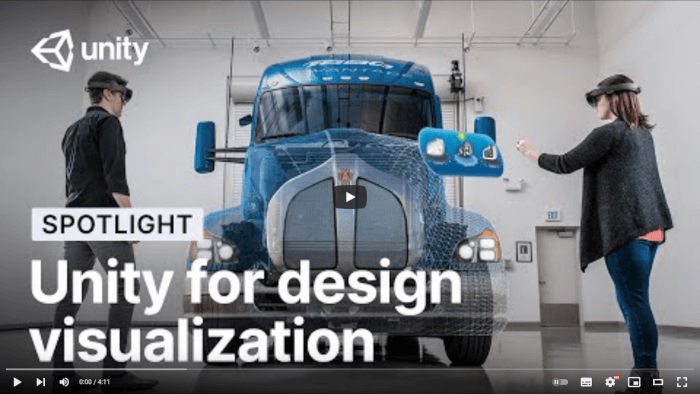

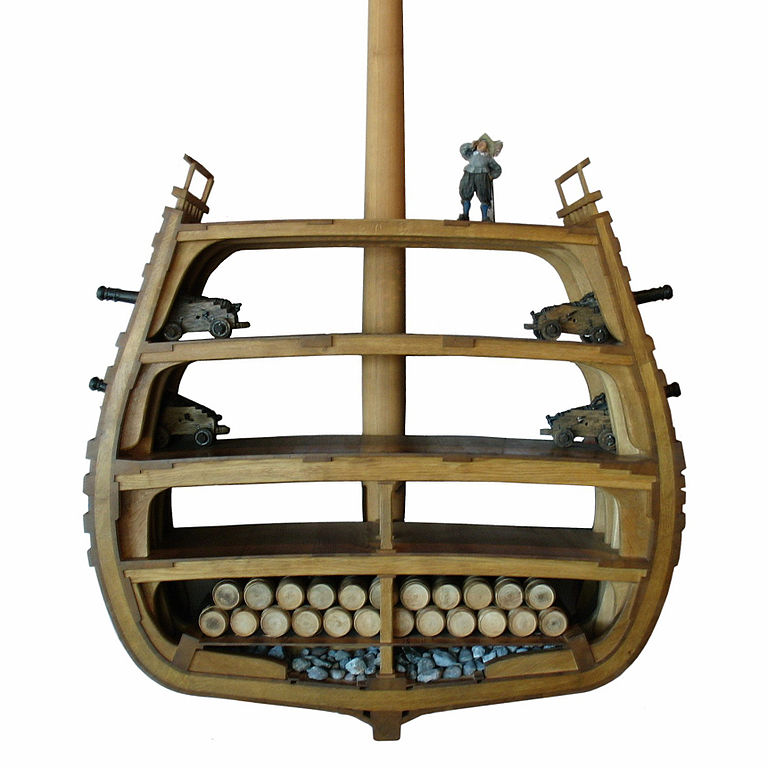

Los sistemas CAD también se utilizan para el diseño y visualización de productos, y en este caso la animación permite mostrar el procedimiento de ensamblado de los diversos componentes que forman un producto. Esta técnica ayuda en la manufactura y construcción, permitiendo probar el procedimiento más efectivo para desarrollar y producir un producto antes de llevarlo a las líneas de producción.

Ejemplos de productos y prototipos:

La animación por computadora no solo es una herramienta utilizada en la industria del entretenimiento o en la ciencia, sino que también desempeña un papel relevante en diversos campos como el arte, los medios experimentales y las plataformas de interacción social.

En el arte, la animación va más allá del cine (también conocido como el séptimo arte), ya que se han explorando nuevas formas de utilizar la animación por computadora para enriquecer, para mejorar y potenciar diferentes tipos de expresiones artísticas.

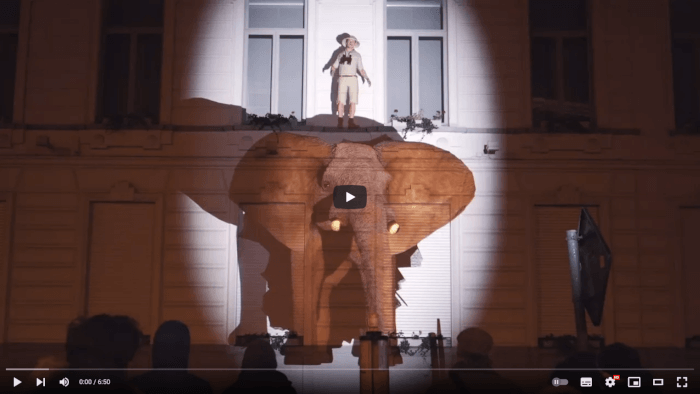

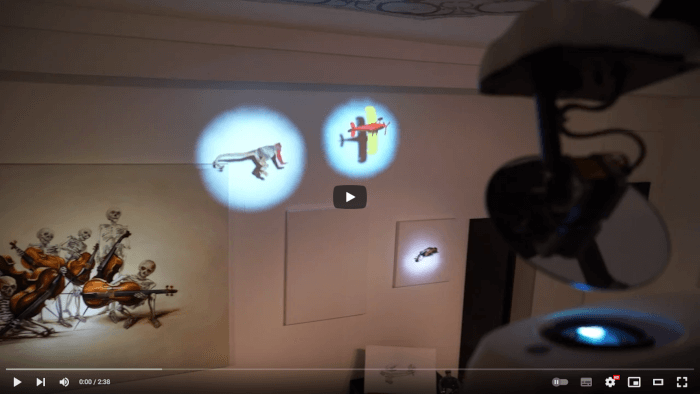

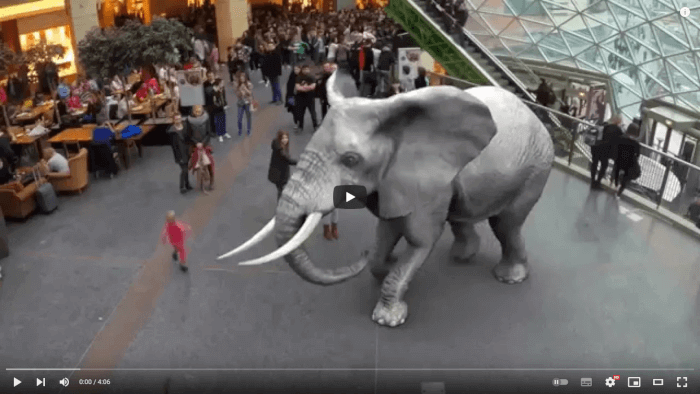

Una técnica que se ha utilizado en los últimos años es el projection mapping o video mapping, la cual se encarga de proyectar imágenes generadas por computadora dentro de espacios físicos reales, como galerías de arte, museos o construcciones urbanas; con la finalidad de hacer la experiencia más lúdica, interesante y entretenida para el público.

Algunos ejemplos:

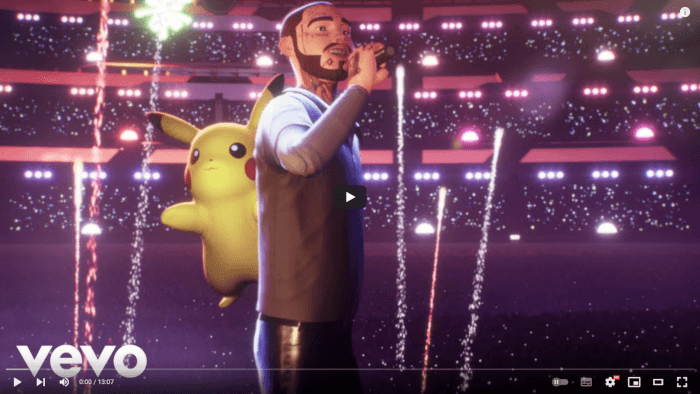

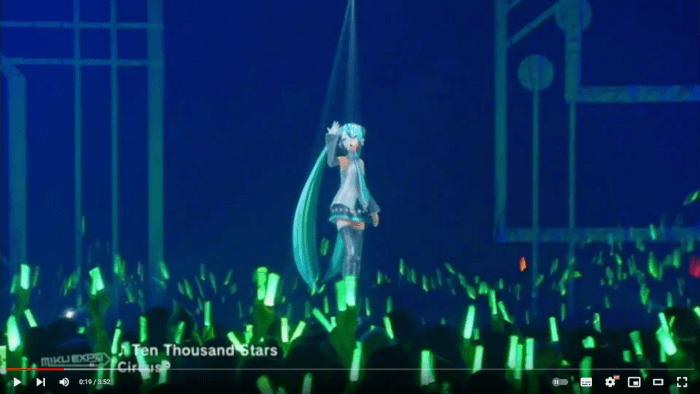

Se han realizado diversos experimentos para usar la animación por computadora y complementar o mejorar las experiencias musicales, desde la creación de artistas virtuales y vídeos musicales animados, así como la integración de tecnologías de realidad virtual y aumentada. Estos desarrollos no solo enriquecen la experiencia musical, sino que también abren nuevas oportunidades para la creatividad y la innovación en la industria de la música. Con el avance constante de la tecnología, se espera que aparezcan más formas innovadoras de combinar música y animación, llevando la experiencia auditiva y visual a nuevos niveles.

Dado el progreso tecnológico, la realidad aumentada y la realidad virtual se han convertido en herramientas cada vez más populares y accesibles para una amplia variedad de personas, desde los usuarios de dispositivos móviles hasta los desarrolladores de juegos y aplicaciones.

La realidad aumentada superpone información virtual en el mundo real, mejorando la experiencia del usuario en sectores como la educación, el turismo, comercio electrónico, entre otros.

Ejemplos de realidad aumentada:

Por otro lado, la realidad virtual crea entornos virtuales completamente inmersivos que pueden ser experimentados a través de dispositivos como visores de realidad virtual o controladores de movimiento. Esto puede generar experiencias emocionantes y realistas en áreas como el entretenimiento, el entrenamiento o terapias de rehabilitación.

Algunos ejemplos de realidad virtual:

En ambos tipos de realidades (virtual y aumentada) la creación de personajes y escenarios generados por computadora es esencial para crear experiencias convincentes y realistas. Los personajes virtuales pueden interactuar con el usuario en tiempo real y proporcionar información útil, mientras que los escenarios pueden ser diseñados para ser detallados y realistas, permitiendo al usuario sentir que están realmente dentro del mundo virtual. La capacidad de crear mundos virtuales también permite a los desarrolladores de software experimentar con diseños y escenarios que serían imposibles o demasiado peligrosos de probar en la vida real.

Motion graphics es una técnica de animación que se utiliza para presentar información de manera visualmente atractiva y comprensible, donde por medio del movimiento de texto y gráficos, se busca comunicar de manera efectiva un mensaje o idea. Esta técnica es utilizada en diversos campos, como el diseño gráfico, la publicidad, el cine y la televisión, y ha ganado gran popularidad en los últimos años debido a su capacidad para capturar la atención del espectador y comunicar información compleja de manera clara y concisa.

Los avances en la animación por computadora permite crear avatares cada vez más realistas y personalizados, lo que contribuye a mejorar la experiencia del usuario en las interacciones virtuales. Los avatares se utilizan en diversas aplicaciones, desde juegos en línea hasta reuniones virtuales de trabajo, permitiendo a los usuarios interactuar en un entorno virtual de manera natural y efectiva.

En los videojuegos, por ejemplo, los avatares se utilizan para crear personajes personalizados que los jugadores pueden controlar para explorar un mundo virtual. Los avatares también se utilizan en redes sociales y aplicaciones de mensajería, permitiendo a los usuarios comunicarse y compartir información en un entorno virtual personalizado.

En el ámbito educativo el uso de avatares ha ganando popularidad, ya que se utilizan para representar a los estudiantes en entornos virtuales de aprendizaje, permitiendo a los educadores crear experiencias de aprendizaje más interactivas y personalizadas; permitiendo que los estudiantes puedan participar en discusiones en línea, realizar tareas y experimentos virtuales, así como participar en actividades de aprendizaje colaborativo.

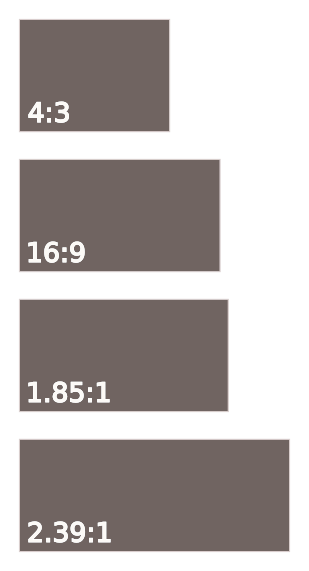

Existen distintos tipos de animación por computadora y su uso dependerá principalmente de los siguientes factores:

En conclusión, la animación por computadora se utiliza en diversos contextos como películas, videojuegos, publicidad y presentaciones virtuales. Su uso está influenciado por el presupuesto, la calidad de la imagen y el tipo de interacción requerida. La capacidad de la animación por computadora para mejorar la experiencia del usuario hace que su uso sea cada vez más común y diverso en la industria del entretenimiento y la ciencia.

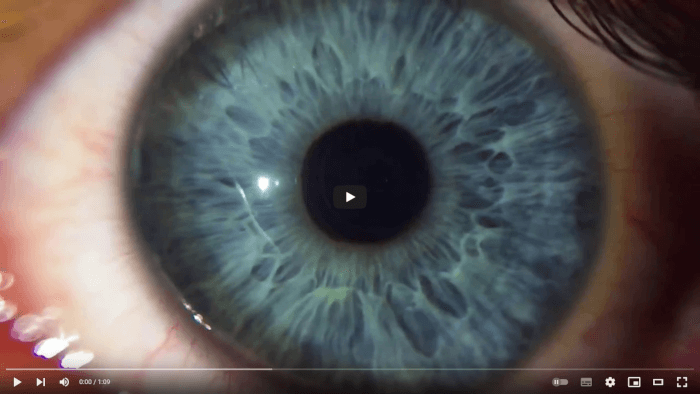

El sistema visual de muchos seres vivos ha evolucionado para percibir e interpretar el movimiento con el fin de sobrevivir en entornos peligrosos y en constante cambio.

La animación se basa en una ilusión óptica que se produce cuando se presenta una serie de imágenes con pequeñas variaciones, a una velocidad lo suficientemente alta para que el espectador interprete las diversas imágenes como una única imagen en movimiento. Este efecto se logra gracias al complejo mecanismo ojo-cerebro que permite ver e interpretar el mundo.

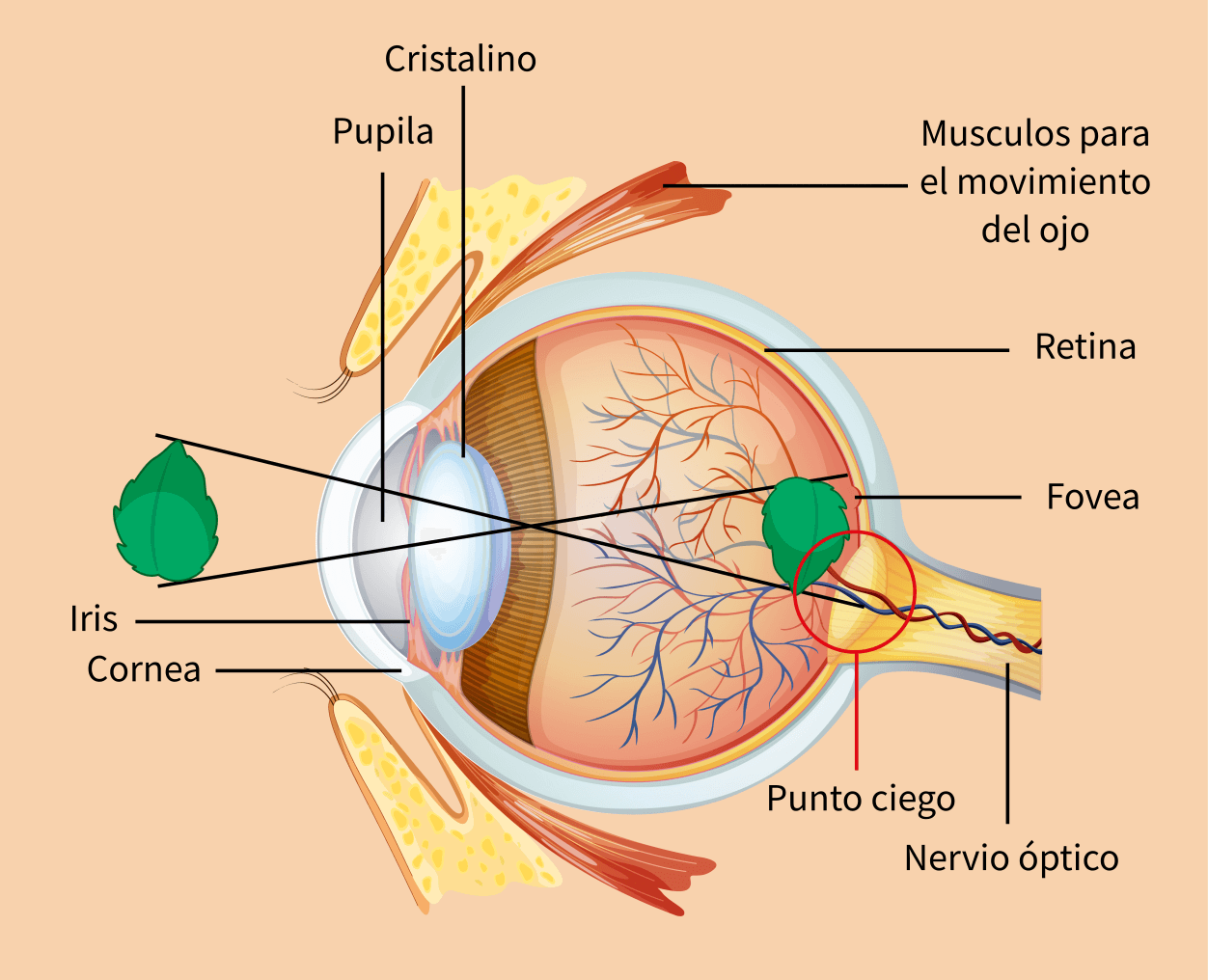

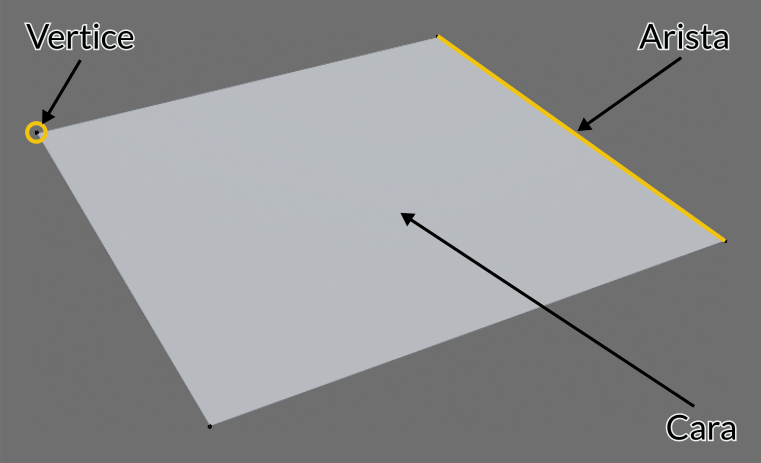

Los ojos humanos tienen diversas partes con funciones muy específicas que permiten observar y percibir imágenes. En la se muestran las diferentes partes que componen el ojo humano. Y a continuación, se describe brevemente cómo se percibe una imagen.

Lo primero que se necesita para percibir una imagen es una fuente de iluminación, ya que sin ella no sería posible ver nada. En un entorno, la luz procedente de una fuente de iluminación llega a diversos objetos y al interactuar con el material que los compone, una parte de dicha luz se refleja hasta llegar al ojo.

Para ingresar en el ojo la luz pasa a través de la córnea, que es una membrana transparente situada en el exterior del ojo y que sirve como protección contra elementos dañinos.

Una vez que la luz ha pasado a través de la córnea, llega a la pupila, que es el centro del iris y la entrada por donde accede la luz al interior del ojo.

El iris es un músculo que regula la cantidad de luz que entra en el ojo, relajándose o contrayéndose en función de la cantidad de luz presente en el ambiente. Esto provoca que la pupila se dilate en condiciones de poca luz para permitir que entre más luz en el ojo, lo que permite ver en ambientes con poca iluminación. O que se contraiga en ambientes muy iluminados, con la finalidad de prevenir daños en las estructuras internas del ojo.

La luz que pasa por la pupila llega al cristalino, un pequeño lente dentro del ojo que es flexible y puede cambiar su forma para que la luz llegue a la retina o fondo de ojo, enfocando o desenfocando objetos a diferentes distancias.

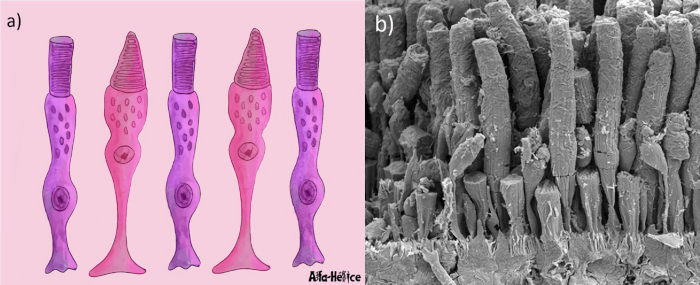

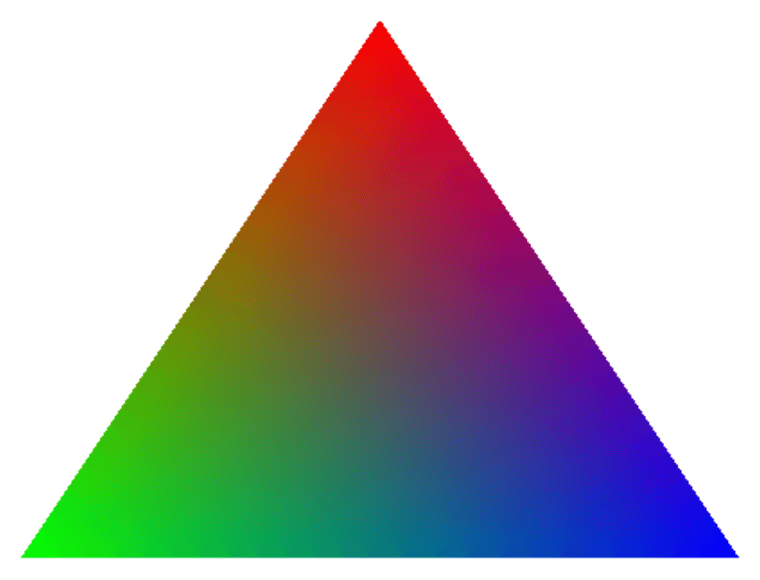

Finalmente, la luz llega al fondo del ojo donde se encuentra la retina, una estructura que contiene dos tipos de células fotosensibles: los conos y los bastones; los cuales se encargan de enviar impulsos eléctricos a través del nervio óptico hacía el cerebro. Los conos y los bastones toman su nombre de su forma y tienen diferentes funciones.

Los bastones son responsables de la percepción visual fuera de la zona de atención, también conocida como la visión periférica. Así mismo son las encargadas de la visión nocturna, ya que son sensibles a los cambios de iluminación.

Los conos por su parte se encargan de la agudeza visual, permitiendo percibir detalles finos, así como la percepción de los colores.

Dentro de la retina existe una pequeña área llamada fovea, que contiene una gran cantidad de conos y es la zona donde las imágenes se ven con mayor nitidez y definición.

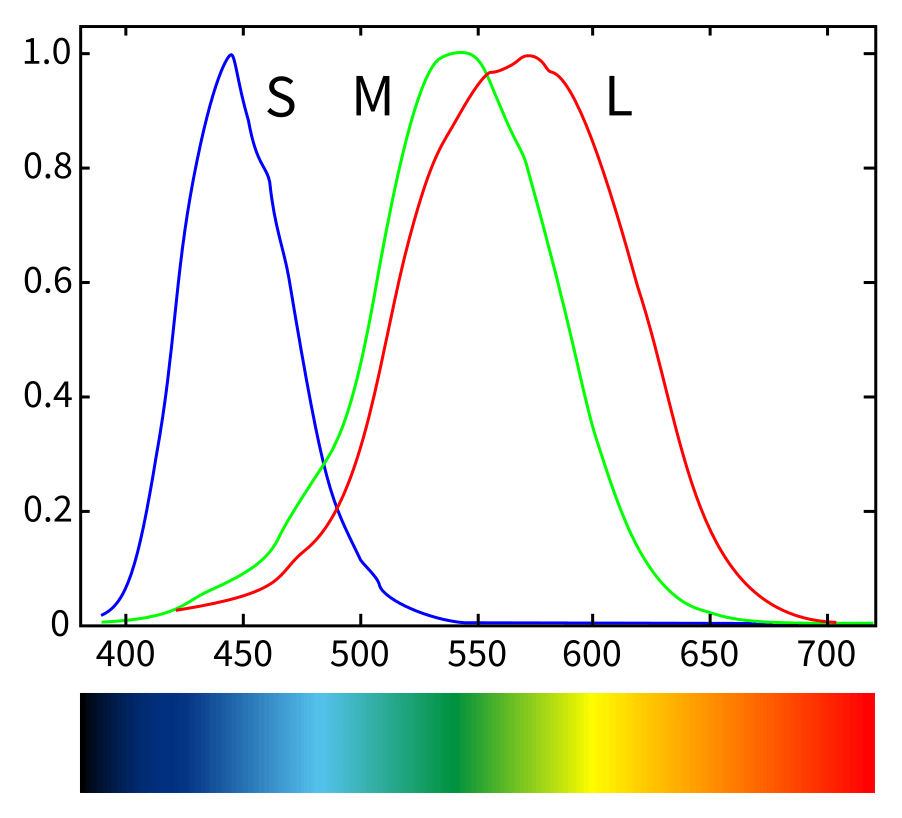

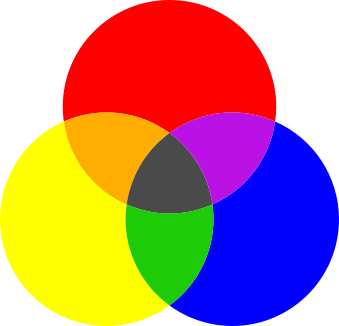

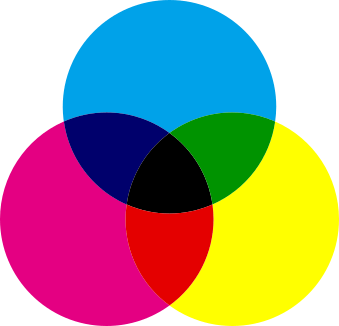

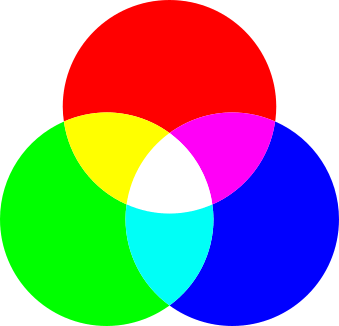

En el ojo humano existen tres tipos de conos especializados en percibir diferentes longitudes de onda de la luz:

Entonces, una vez que la luz interactúa con los objetos y se refleja hasta entrar en el ojo, se estimulan los conos y los bastones en la retina (y la fovea) creando señales eléctricas que pasan por el nervio óptico hasta llegar al cerebro, donde finalmente se interpreta la información y se crea una imagen.

Para convertir la luz en una señal eléctrica, los conos y los bastones realizan un proceso químico que toma aproximadamente 25 milisegundos en ocurrir. Además, cuando los fotorreceptores son estimulados, requieren de un breve periodo para relajarse y regresar a su estado original para continuar procesando la información lumínica recibida.

La persistencia de la visión es un fenómeno que ocurre en el sistema visual humano y que permite que una imagen se mantenga durante un breve período de tiempo en el sistema de visión, incluso después de que el estímulo visual haya desaparecido. Este efecto se produce gracias a la capacidad del cerebro para retener la información visual que ha sido percibida y para integrarla con la nueva información visual que se está recibiendo en tiempo real.

Este efecto se debe al hecho de que las células fotosensibles del ojo necesitan un cierto tiempo para recuperarse después de haber sido estimuladas por la luz. Durante este breve período de recuperación, que dura aproximadamente una quinceava parte de segundo, la imagen anterior que se ha percibido se mantiene en la memoria visual a corto plazo.

Si se muestra una secuencia de imágenes a una velocidad similar o mayor a la del tiempo de recuperación de las células fotosensibles, el cerebro es capaz de integrar estas imágenes en una sola imagen en movimiento o en una secuencia de imágenes que parecen estar en movimiento.

La persistencia de la visión es un fenómeno que ha sido ampliamente estudiado en el campo de la psicología visual y la neurociencia, y es un efecto fundamental para entender cómo funciona el sistema de visión humano y cómo se percibe el mundo.

Es importante mencionar que la persistencia de la visión es clave en el funcionamiento de muchas tecnologías y formas de entretenimiento, como el cine, la televisión, los videojuegos y la animación; permitiendo crear la ilusión de movimiento y haciendo que una secuencia de imágenes parezca cobrar vida.

El parpadeo o flicker ocurre cuando las imágenes no se muestran a una velocidad adecuada y no logran crear la ilusión de movimiento, lo que provoca una secuencia intermitente de imágenes. Esto puede ser molesto y cansado para algunos espectadores debido a los continuos cambios visuales, sin embargo, es utilizado intencionalmente en técnicas de animación y producción de efectos visuales. El parpadeo ocurre cuando la velocidad de presentación de las imágenes es demasiado lenta en comparación con el tiempo que las células fotosensibles del ojo necesitan para recuperarse, lo que crea una brecha temporal entre la información visual procesada y la siguiente, interrumpiendo así el flujo de información visual.

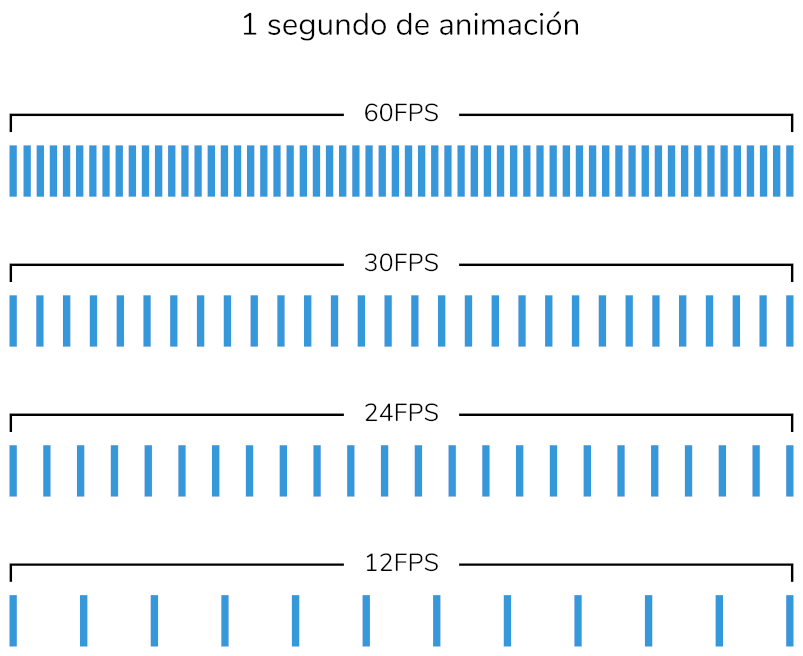

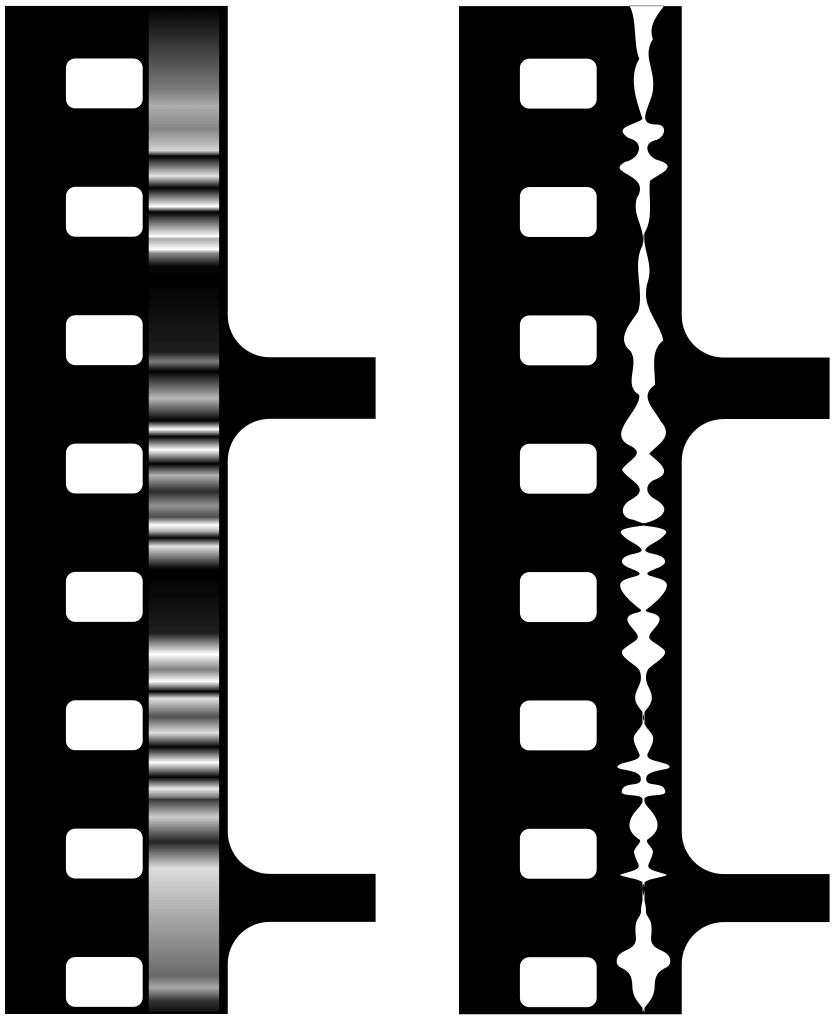

Los cuadros por segundo también conocidos como fotogramas por segundo (fps), es un término utilizado en la animación por computadora y otros medios audiovisuales para medir la cantidad de imágenes que se muestran durante un segundo (). Esta métrica es importante ya que determina la fluidez y la calidad del movimiento en la animación.

Para crear la ilusión de movimiento, es necesario presentar una secuencia de imágenes que cambian ligeramente en cada cuadro o fotograma. Cuanto mayor sea la cantidad de cuadros por segundo, más suave y natural será el movimiento percibido por el espectador. Por otro lado, si la velocidad de los cuadros es demasiado baja, el movimiento se percibirá como entrecortado y poco natural.

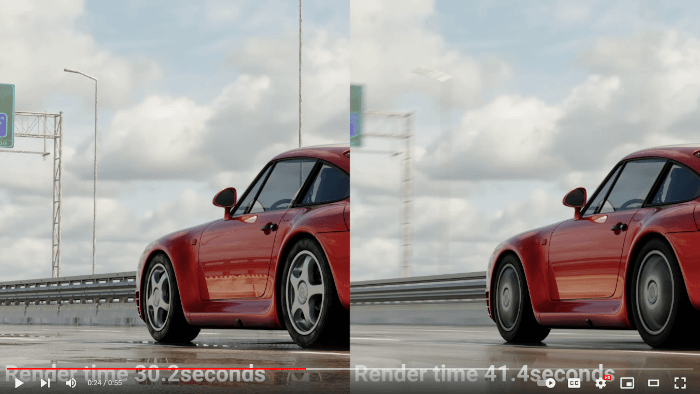

Es importante tener en cuenta que la cantidad de cuadros por segundo también puede afectar el tiempo y el costo de producción de una animación, ya que cuantos más cuadros se utilicen, mayor será el esfuerzo necesario para crear y renderizar cada imagen. Por lo tanto, los animadores deben encontrar un equilibrio entre la calidad de la animación, el tiempo y el costo de producción.

Los seres humanos pueden percibir una sucesión de imágenes como movimiento a partir de los 10 cuadros por segundo, aunque el efecto mejora al presentar más fotogramas. Por ejemplo, en la animación tradicional se utilizan 24 fotogramas por segundo y, por lo general, se repite una misma imagen durante dos cuadros consecutivos, lo que se conoce como dibujar en dos.

Durante la época de la televisión analógica, la mayoría de los países en Norte y Centro América, así como Japón, utilizaban el sistema de televisión NTSC (National Television System Committee), que tenía una tasa de cuadros de 29.97fps. Por otro lado, en Europa y África se utilizaba el sistema PAL (Phase Alternating Line), que tenía una tasa de cuadros de 25fps.

Con la llegada de la televisión digital, se han ampliado las posibilidades de tasa de cuadros, ya que ahora se pueden transmitir entre 23.976fps hasta 60fps. Las tasas de cuadros que se utilizan en la televisión digital dependen de la televisora y del tipo de contenido que se está transmitiendo. Una mayor tasa de cuadros permite una imagen más fluida y suave, especialmente en escenas de acción o movimiento rápido. En los videojuegos, una tasa de cuadros más alta también puede mejorar la jugabilidad al hacer que los movimientos del jugador se sientan más responsivos y precisos. Por otro lado, una tasa de cuadros más baja puede ser suficiente para la transmisión de ciertos tipos de contenido, como programas de televisión con un ritmo más lento o películas con escenas estáticas.

La película El hobbit: un viaje inesperado fue pionera al ser filmada y proyectada en 48fps, el doble de la tasa de cuadros de las películas tradicionales. Este aumento en la cantidad de cuadros por segundo permitió mostrar tomas más suaves y definidas, sin embargo, algunos espectadores expresaron que esta técnica hace que la película se sienta diferente a lo que están acostumbrados con los 24fps, lo que afecta la experiencia del cine tradicional.

En lo que respecta a los fotogramas por segundo, se ha argumentado que no es posible ver o distinguir más de 30 cuadros en un segundo, algunos dicen que el límite es 60fps; sin embargo, la capacidad de percibir una gran cantidad de cuadros por segundo depende de factores fisiológicos como la edad y la estructura ocular del espectador, ya que como se mencionó anteriormente las células fotosensibles necesitan de un breve periodo de tiempo para que perciban nueva información y esto varía de persona en persona y se vuelve más lento con la edad.

Es importante tener en cuenta que incluso si no es posible distinguir más de 30 fotogramas por segundo, tener una mayor cantidad de fotogramas puede ayudar a reducir el efecto de parpadeo (o flicker) y hacer que la animación se sienta más fluida y realista para la mayoría de los espectadores.

El desenfoque de movimiento o motion blur es un efecto visual que ocurre cuando se observan objetos que se mueven a una velocidad mayor a la que el sistema visual puede procesar. En otras palabras, el cerebro no puede construir una imagen nítida de lo que se observa debido a la velocidad del movimiento, lo que da lugar a una imagen borrosa. Este efecto es algo muy común en la vida cotidiana, por ejemplo, cuando se observa un coche que pasa a gran velocidad, o cuando se mueve la cabeza rápidamente mientras se mira un objeto.

En la animación por computadora, el desenfoque de movimiento es una técnica muy importante para conseguir un resultado más realista y natural en las escenas que involucran movimiento. En las películas que utilizan animación por computadora, replicar el efecto de desenfoque es esencial para que la animación parezca más natural y se acerque a la realidad.

El desenfoque de movimiento también se puede producir debido al movimiento propio del ojo. A pesar de que los ojos parecen rígidos, en realidad son un objeto gelatinoso que presenta cierta inercia en su estructura al moverse. Esto puede causar un ligero desenfoque de movimiento en la imagen que se percibe, especialmente si se mueve la cabeza o los ojos rápidamente.

La animación es una forma de arte que ha existido durante siglos y que ha evolucionado significativamente a lo largo del tiempo. Desde los dibujos animados tradicionales hasta la animación por computadora, esta forma de arte ha sido una herramienta poderosa para contar historias y transmitir mensajes a través de imágenes en movimiento.

La animación por computadora, ha surgido gracias a una serie de avances tecnológicos que se han producido en los últimos años. Sin embargo, para entender completamente la historia de la animación por computadora, es importante mirar en conjunto los diversos desarrollos tecnológicos y considerar el contexto en el que se han producido. La fotografía, el cine y la computación han sido elementos clave en el surgimiento de la animación por computadora, y cada uno de ellos ha tenido un papel significativo en su evolución.

En este capítulo, se exploran algunos de los eventos más significativos de la historia de la animación por computadora, desde sus orígenes hasta su posición actual en la industria del entretenimiento. También se presenta cómo los avances tecnológicos y las innovaciones creativas han impulsado el desarrollo de la animación por computadora y cómo esta forma de arte ha transformado la manera en que se crean producciones audiovisuales.

El taumátropo es un dispositivo mecánico que consta de un disco plano unido por una cuerda en sus bordes, con imágenes diferentes en cada lado, de tal manera que al girarlo rápidamente se observa una superposición de las imágenes, dando la impresión de una sola imagen compuesta.

Este dispositivo demuestra cómo la velocidad de presentación de las imágenes puede engañar al cerebro y crear una ilusión visual, lo que se conoce como la persistencia de visión. Este fenómeno es fundamental para el desarrollo de la animación y otros medios de entretenimiento visual. A pesar de que el taumátropo es un juguete sencillo, su valor radica en su capacidad para mostrar de forma simplificada cómo la mezcla de imágenes puede crear una ilusión visual.

En el siglo XIX, Joseph Nicéphore Niépce (), un inventor francés, estaba obsesionado con la idea de capturar imágenes de la realidad y almacenarlas de forma permanente. Para ello, trabajó en la creación de un material fotosensible que permitiera fijar una imagen de manera más eficiente y permanente que los métodos utilizados hasta ese momento.

Después de varios años de experimentación, en 1826 Niépce logró capturar lo que se considera la primera imagen fotográfica de la historia. Para ello, utilizó una cámara oscura y un material fotosensible conocido como betún de Judea, que se aplicaba sobre una placa de metal pulido. La imagen que capturó Niépce fue una vista desde el balcón de su casa en Le Gras, Francia (). La exposición de la placa de metal a la luz de la cámara oscura duró alrededor de ocho horas, tiempo durante el cual la luz fue proyectando la imagen en la placa y el betún fue fijando los detalles.

Aunque la imagen resultante era poco clara y tenía una resolución baja, la fotografía de Niépce fue un hito en la historia de la fotografía, ya que demostró que era posible fijar de manera permanente una imagen capturada por una cámara oscura. Además, sentó las bases para el desarrollo de la fotografía tal como se conoce hoy en día.

La fotografía de Niépce es considerada una obra maestra de la técnica y la persistencia, ya que para conseguirla tuvo que superar múltiples dificultades técnicas y trabajar durante años en el desarrollo de su método. Su legado ha sido fundamental para el avance de la fotografía y ha permitido a la humanidad capturar momentos únicos y preciosos para la posteridad.

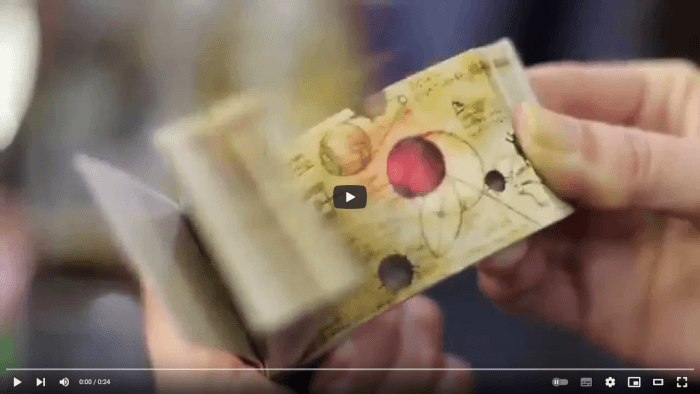

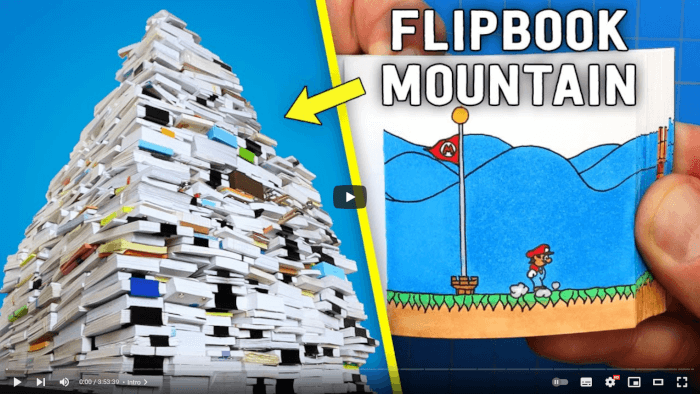

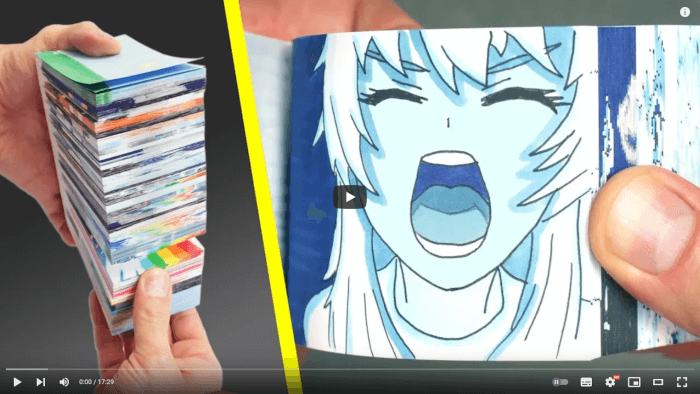

El folioscopio o flip book es un dispositivo que consiste en un conjunto de páginas dispuestas en forma de libro, en las cuales se encuentran una serie de imágenes que varían ligeramente de una página a otra. Al pasar rápidamente las páginas con el pulgar, las imágenes parecen moverse y crear una animación. Es otro mecanismo en el que se puede explorar la persistencia de visión de forma sencilla.

El folioscopio es una forma popular de entretenimiento, ya que permite a las personas crear sus propias animaciones de forma sencilla y sin necesidad de equipos especializados. La importancia del folioscopio radica en que permitió la creación y difusión de la animación de forma accesible y económica, sentando las bases para la posterior evolución de la animación como medio artístico y de entretenimiento.

En la actualidad, el folioscopio sigue siendo utilizado por animadores y artistas para crear animaciones de estilo tradicional, y su formato ha sido adaptado a las nuevas tecnologías, como la animación digital. Además, sigue siendo una forma de entretenimiento popular entre niños y adultos por su simplicidad y efectividad en crear animaciones caseras. Algunos ejemplos modernos se puede observar en los siguientes vídeos:

El fenaquistoscopio es un juguete óptico que consiste en un disco plano que tiene varias imágenes ligeramente diferentes entre sí distribuidas en forma radial. Cuando el disco se gira rápidamente y se observa una posición fija dentro del disco, se puede ver cómo las imágenes se combinan para formar una animación. En otras palabras, cada imagen se superpone a la anterior de forma suave y continua, creando una ilusión de movimiento o cambio. La razón por la que el fenaquistoscopio es tan efectivo es porque la rotación del disco permite que las imágenes cambien a una velocidad y estable, de esta manera, la animación se muestra de forma más fluida y sin saltos o interrupciones en el movimiento.

Este juguete óptico fue un gran avance en su época, ya que permitió a las personas experimentar con la animación de una forma mucho más sencilla que antes. Además ayudó a sentar las bases para el desarrollo de tecnologías más avanzadas en el futuro.

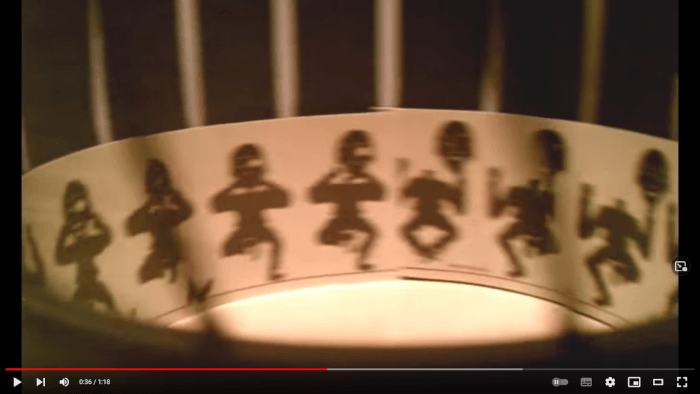

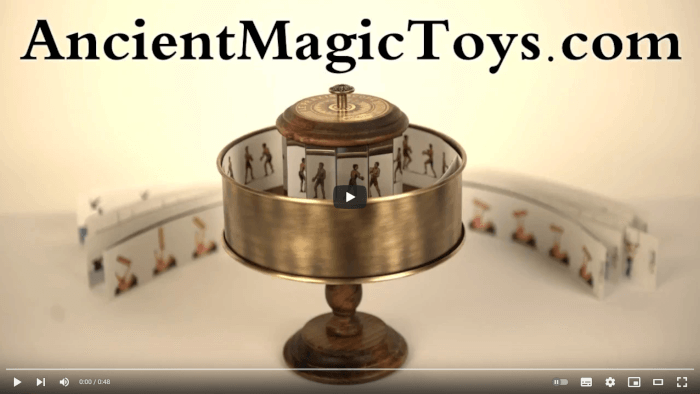

El zoótropo o máquina estroboscópica es un dispositivo que consta de un cilindro con cortes verticales a través de los cuales se puede ver hacia su interior. Dentro del cilindro, se coloca una tira con una secuencia de imágenes, y al girar el cilindro y mirar por uno de los cortes, se percibe el cambio de las imágenes. Este juguete al igual que el fenaquistoscopio utiliza la rotación para mostrar de forma estable las diferentes imágenes que componen una animación.

El efecto que se logra con las imágenes al interior del cilindro del zoótropo también se puede obtener con objetos tridimensionales.

El praxinoscopio consiste en un tambor con espejos colocados alrededor de su borde interior, y una serie de imágenes dibujadas en una tira de papel o cartón que se coloca en el centro del tambor. Cuando el tambor gira, las imágenes se reflejan en los espejos y parecen moverse, creando la ilusión de una animación. Este dispositivo representó un avance sobre los dispositivos previos, ya que al usar espejos en su interior las imágenes se ven con mayor claridad y nitidez, lo que permite apreciar la animación desde diferentes ángulos sin perder calidad.

Todos estos dispositivos se utilizaron como entretenimiento o simples curiosidades, pero en el fondo incorporan y emplean los conceptos fundamentales en los que se basa la animación. Gracias a estos artefactos, posteriormente fue posible idear y construir mecanismos más sofisticados, que dieron lugar al cine y, en particular, a la animación.

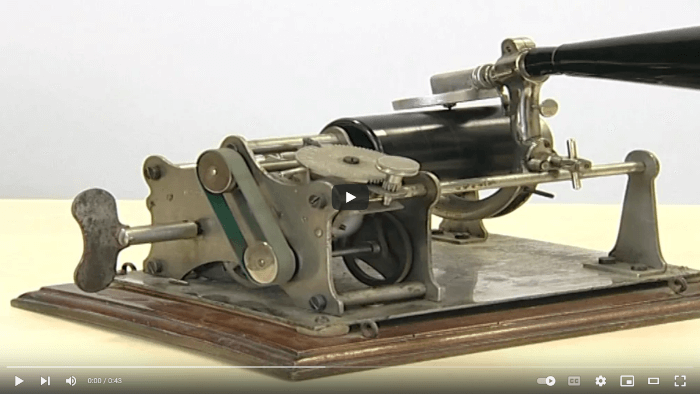

El fonógrafo fue uno de los primeros dispositivos mecánicos capaces de grabar y reproducir sonido. Su funcionamiento se basaba en el uso de cilindros de cera, que se grababan mediante la vibración de un diafragma que se conectaba a un punzón o aguja. El punzón era el encargado de dejar una huella en la cera, que posteriormente podía ser reproducida mediante un proceso inverso.

El fonógrafo fue un gran avance en su época, ya que permitió la grabación y reproducción de sonidos de forma mecánica, lo que representó una revolución en el mundo de la música y la comunicación. Además, el fonógrafo sentó las bases para la incorporación del sonido al cine, ya que los mecanismos utilizados para grabar y reproducir el sonido en los cilindros de cera, posteriormente se adaptaron para ser utilizados en las películas sonoras.

Eadweard Muybridge fue un fotógrafo e investigador del siglo XIX que realizó importantes experimentos fotográficos que serían fundamentales para el desarrollo del cine. Una de sus principales contribuciones fue el desarrollo de técnicas para capturar imágenes consecutivas de alta velocidad, lo que le permitió fotografiar el movimiento de objetos en movimiento, como caballos, personas y otros animales.

En uno de sus trabajo más conocidos, Muybridge colocó múltiples cámaras a lo largo de una pista de carreras y utilizó estas cámaras para capturar imágenes consecutivas de un caballo en movimiento. Al analizar estas imágenes en secuencia, Muybridge pudo observar que los cuatro cascos de un caballo están en el aire al mismo tiempo durante ciertas fases del galope, lo que contradecía la creencia común en la época de que los cascos delanteros y traseros nunca estaban en el aire al mismo tiempo ().

Muybridge también realizó fotografías de personas y animales en diferentes actividades, utilizando la técnica de la fotografía estroboscópica para capturar el movimiento de los sujetos en una secuencia de imágenes fijas. Estos experimentos fueron muy importantes para el desarrollo del cine, ya que demostraron que era posible crear la ilusión de movimiento a partir de una serie de fotografías, lo que fue una de las bases para el futuro cinematógrafo.

Además de las técnicas para capturar las imágenes Muybridge desarrollo un dispositivo para la presentación y proyección de dichas imágenes, el zoopraxiscopio.

El zoopraxiscopio es un dispositivo de proyección que utiliza un disco de cristal para almacenar las imágenes a proyectar, de manera similar al fenaquistoscopio. Las imágenes que se presentan son dibujadas o pintadas a mano en el disco, de manera distorsionada para permitir su posterior proyección.

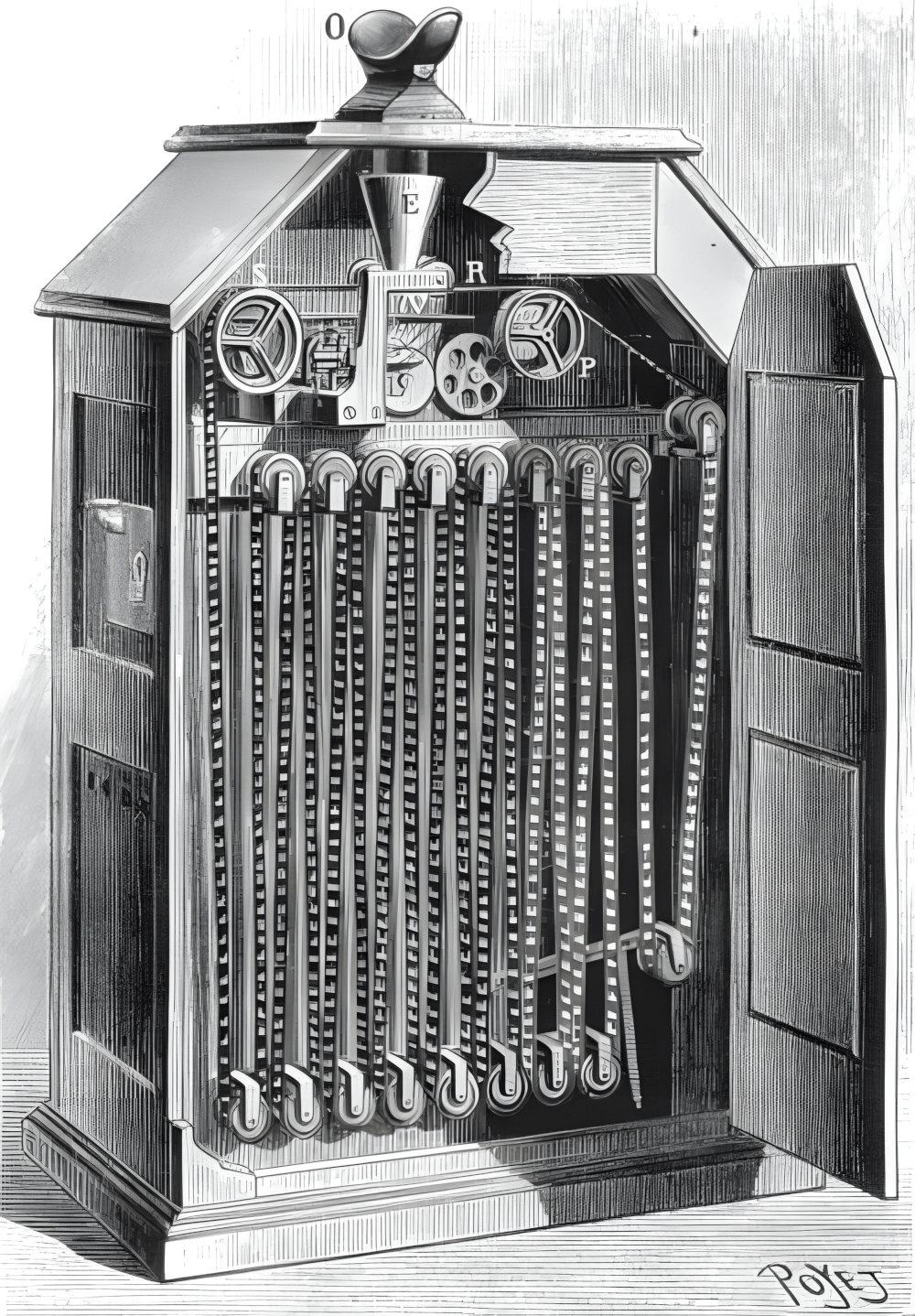

El quinetoscopio fue un dispositivo que consistía en una caja de madera con un visor en la parte superior y un carrete de película en su interior. Al mirar a través del visor, se podían ver películas cortas que eran creadas por una serie de fotografías presentadas rápidamente.

Aunque el quinetoscopio solo podía ser usado por un espectador a la vez, fue un gran avance para su época ya que a diferencia de sus predecesores, permitió visualizar una mayor cantidad de imágenes, sentando el precedente en la manera en que se almacenarían las imágenes de las películas, ya que al utilizar una tira perforada se abrió la posibilidad de mover y presentar un conjunto de imágenes mediante engranajes para mantener una velocidad constante y adecuada para aprovechar la persistencia de la visión.

El quinetoscopio fue un paso importante hacia lo que actualmente se conoce como el cine, proporcionando una experiencia que se centraba en un solo espectador donde era posible ver una película corta por una moneda. Además, el quinetoscopio fue uno de los primeros dispositivos en incorporar el uso del fonógrafo para presentar películas con sonido, lo que también lo convierte en el precursor del cine sonoro. Esta innovación permitió agregar una dimensión adicional a la experiencia cinematográfica.

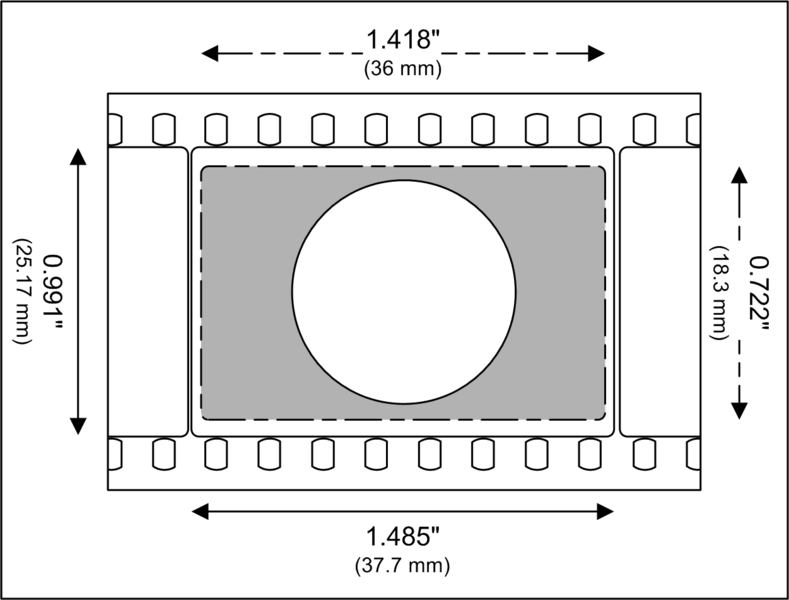

El cinematógrafo fue un invento desarrollado por los hermanos Lumière en 1895 y consistía en una cámara y un proyector de cine portátil, con el cual es posible filmar imágenes que se almacenan en una tira de película y además se pueden proyectar en una habitación oscura para ser vistas por el público.

En 1895 se presento la primera película de los hermanos Lumière, “La sortie de l'usine Lumière à Lyon” (); donde se muestra la salida de los trabajadores de la fábrica Lumière. Estos 46 segundos marcaron un punto de inflexión, dando origen a lo que en la actualidad se conoce como el séptimo arte y es considerada como la primera película documental de la historia del cine.

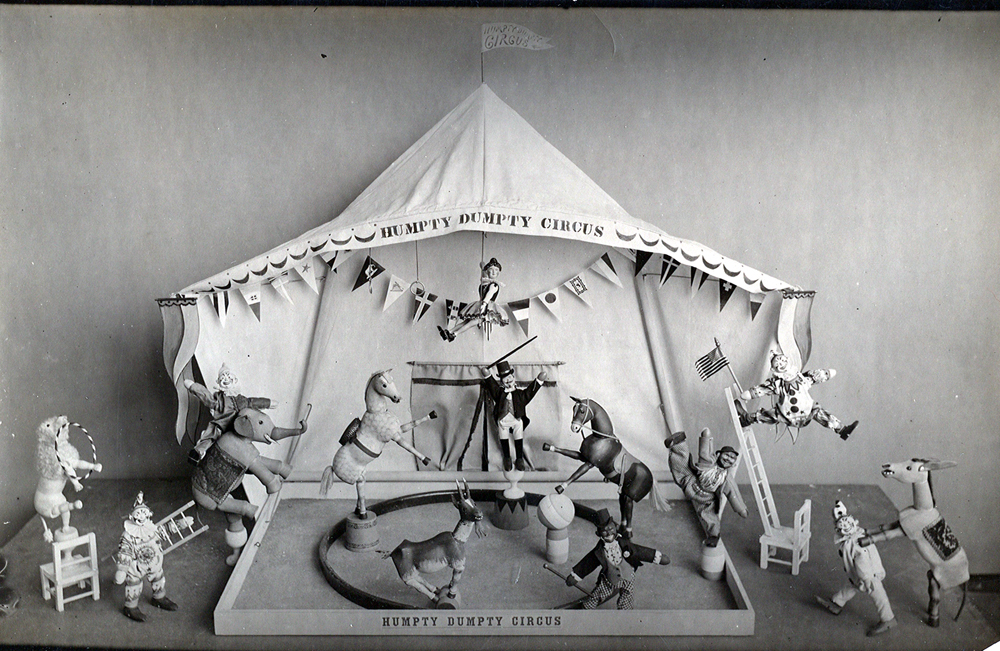

The Humpty Dumpty Circus fue la primera película en utilizar la técnica de animación cuadro a cuadro (stop motion) para crear la ilusión de movimiento en objetos reales inanimados. Aunque desafortunadamente no se dispone de una copia de The Humpty Dumpty Circus, se sabe que la película mostraba una serie de actos circenses realizados por juguetes, que incluían malabarismos, equilibrios y trapecios.

La técnica de animación cuadro a cuadro consiste en tomar una serie de fotografías de un objeto inanimado en diferentes posiciones, y luego reproducir esas fotografías en secuencia para crear la ilusión de movimiento.

Una vez que el cinematógrafo se popularizó y el concepto de película se hizo conocido, al igual que con cualquier nueva tecnología, surgió una etapa de experimentación en la que se puso a prueba cuán lejos se podía llevar dicha tecnología. En el cine, varias personas comenzaron a realizar experimentos en torno a las películas, tratando de aprovechar de forma efectiva todas las cualidades que ofrecía.

Georges Méliès fue un ilusionista y cineasta francés que vivió a finales del siglo XIX y principios del siglo XX. Es conocido por haber sido un pionero en la realización de efectos especiales en el cine, así como en el uso de técnicas de producción y narrativas que revolucionaron la forma en que se hacían las películas en su época.

Entre sus contribuciones más importantes al cine se encuentra el uso de la exposición múltiple, la cámara rápida, la disolución de imágenes y otras técnicas innovadoras para crear efectos especiales. Méliès también fue uno de los primeros cineastas en utilizar guiones gráficos, un método para planificar una película en el que se dibujan los escenarios y los movimientos de cámara antes de filmarlos.

A través de sus películas, Méliès logró contar historias fantásticas y mágicas, utilizando la técnica de la ilusión cinematográfica para crear mundos imaginarios y transportar al espectador a lugares nunca antes vistos. Sus innovaciones técnicas y narrativas abrieron el camino para el desarrollo del cine como una forma de arte y entretenimiento, y su legado continúa influyendo en la industria del cine hasta el día de hoy. En el se presenta una animación en un video de 360º que ofrece un tributo a las diversas películas y aportes de Georges Méliès.

Le Voyage dans la Lune, también conocida como El viaje a la luna, es una película muda francesa realizada en 1902 por el cineasta Georges Méliès. Se inspiró en la novela “De la tierra a la luna” de Julio Verne y en otras obras de ficción científica de la época.

La película sigue las aventuras de un grupo de astrónomos que construyen un cohete para viajar a la luna. Una vez allí, los astronautas exploran el terreno lunar, encuentran una tribu de alienígenas hostiles y finalmente regresan a la Tierra. Esta película es considerada como la primera película de ciencia ficción.

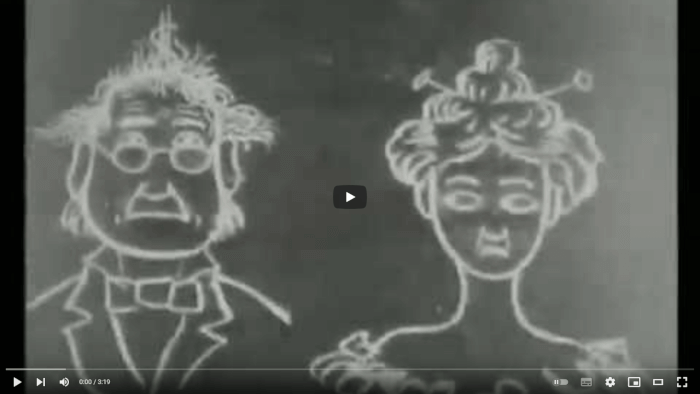

Humorous Phases of Funny Faces es una caricatura animada muda, en la que cada imagen de la animación fue dibujada a mano en un pizarrón y luego fotografiada con una cámara.

Esta animación no cuenta con una trama estructurada, sino que se enfoca en explorar las posibilidades creativas que ofrece la técnica de animación de dibujo cuadro a cuadro, donde el animador dibuja y borra imágenes sobre el pizarrón para crear efectos cómicos y mostrar diferentes expresiones faciales.

The Haunted Hotel es una película muda de terror y comedia que se estrenó en 1907. La trama sigue a un viajero que decide pasar la noche en un hotel embrujado y se enfrenta a diversas escenas espeluznantes y divertidas. Es considerada una de las primeras películas de terror y se destacó por el uso de técnicas innovadoras de efectos especiales, las cuales impresionaron a los espectadores de la época. Además, la película fue pionera en el uso de la comedia como género complementario al terror, sentando un precedente para futuras producciones.

El cortometraje tenía como objetivo representar una casa encantada y para ello se utilizaron técnicas de animación de stop motion para animar los objetos “embrujados” que se mueven por sí solos.

Fantasmagories es una obra pionera en el cine de animación que utilizó la idea de Humorous Phases of Funny Faces, consistente en dibujar y fotografiar imágenes para crear una animación.

La trama de la película es sencilla pero muy imaginativa, y sigue a un personaje que se transforma y se mueve a través de diversos escenarios surrealistas y fantásticos, enfrentando obstáculos y aventuras en su camino. En esta pequeña animación, se pueden apreciar movimientos más sofisticados de animación, con personajes que realizan una variedad de acciones e interacciones. Se considera que Fantasmagorie es la primera caricatura animada en la historia del cine.

Winsor McCay fue un caricaturista estadounidense, reconocido por ser uno de los primeros en introducir historias narrativas en las tiras cómicas. Además, se destacó como un pionero en el ámbito de la animación, siendo uno de los primeros en crear películas animadas populares.

McCay experimentó con técnicas avanzadas para su época, como el uso del color en las animaciones, así como la interacción de personajes animados con personas reales en las películas. La importancia de Winsor McCay en la historia del cine de animación radica en que abrió un camino para el desarrollo del género, al demostrar las posibilidades narrativas y estéticas de la animación y al inspirar a otros animadores a experimentar con nuevas técnicas y estilos.

La animación Little Nemo de Winsor McCay se basa en el personaje homónimo de sus tiras cómicas, y fue su primer intento de crear una película animada con un argumento y personajes expresivos. En la película, Nemo tiene una serie de aventuras oníricas y surrealistas en un mundo imaginario, que es una representación de su propia mente. Este pequeño corto dura alrededor de 11 minutos y fue presentado con una orquesta en vivo que ambientaba la animación.

En esta animación es posible observar una evolución en comparación con los experimentos anteriores, ya que poco a poco las animaciones se vuelven más expresivas y detalladas.

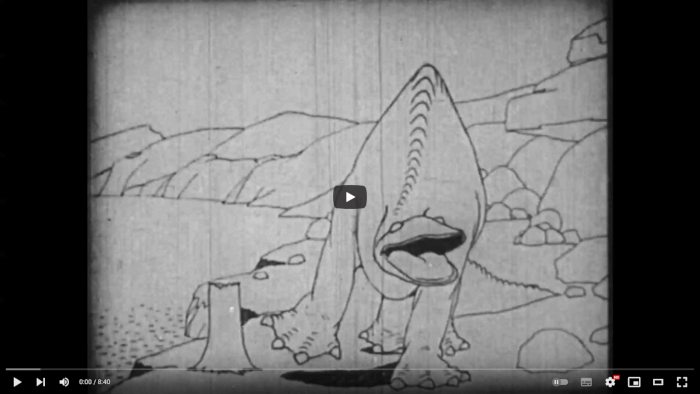

La animación de Gertie el Dinosaurio es una obra destacada por presentar una interesante interacción entre personas del mundo real y un dinosaurio dibujado (en hojas de tamaño de 6.5 por 8.5 pulgadas), pero animado de manera magistral. Gertie logra transmitir una personalidad muy definida, gracias a las simples pero muy atractivas animaciones que la caracterizan; logrando una gran expresividad y demostrando el potencial que puede alcanzar una animación bien hecha.

McCay introdujo técnicas de animación innovadoras, como el uso de fotogramas clave o keyframes, así como la reutilización de dibujos, siendo técnicas que influenciaron la forma en la que se crean las animaciones.

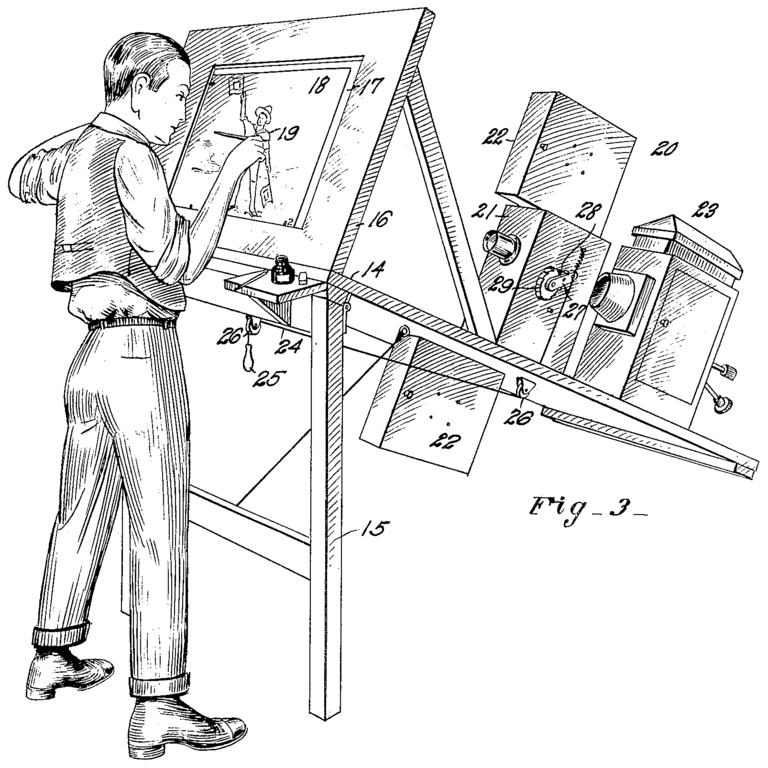

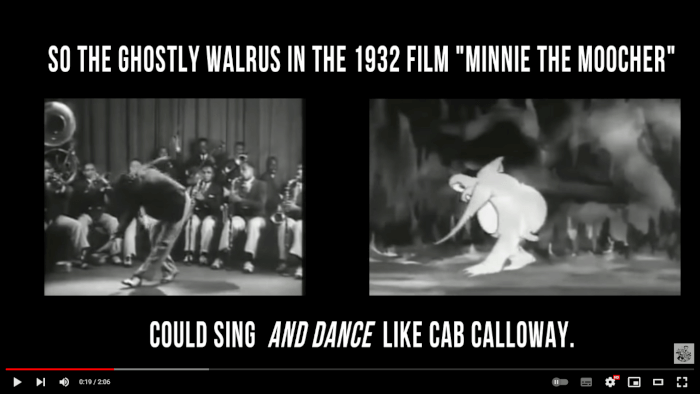

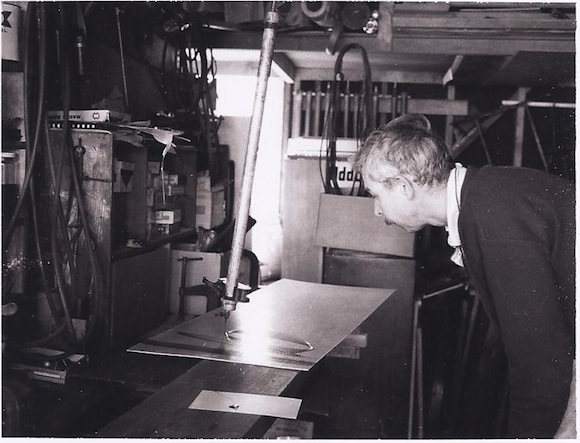

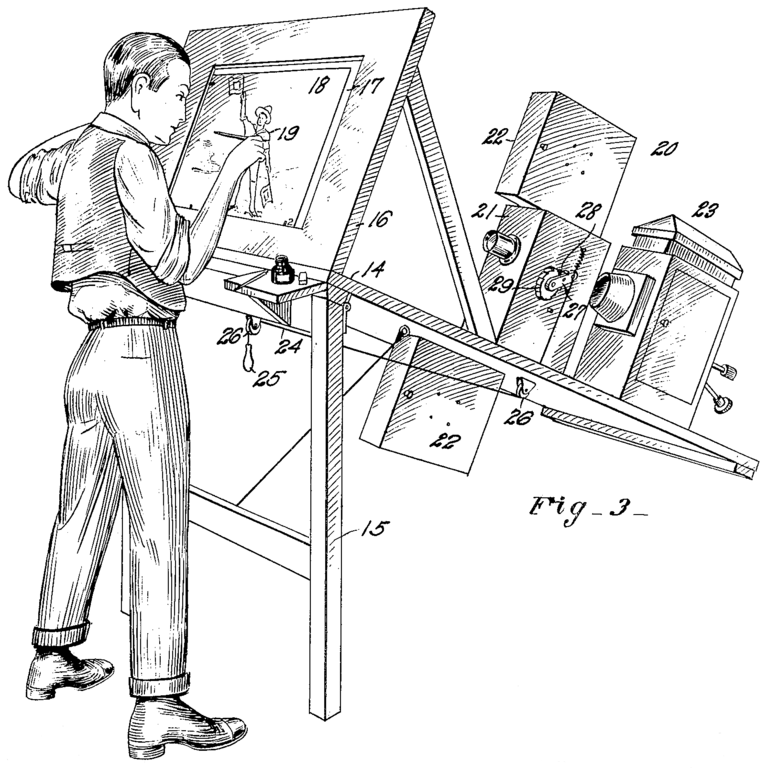

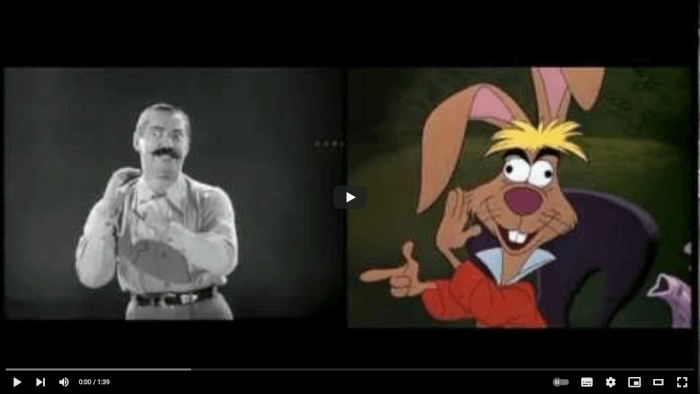

A medida que la animación se consolidaba como una forma de expresión, se desarrollaron tecnologías que permitían mejorar y optimizar la creación de animaciones. Una de estas tecnologías es el rotoscopio, un dispositivo que proyecta imágenes en una pantalla para que los animadores puedan utilizarlas como referencia para los cuadros de una animación. El rotoscopio fue inventado por Max Fleischer en 1915 y se utilizó por primera vez en los cortos The Out of the Inkwell de Fleischer.

Al utilizar el rotoscopio, los animadores pueden reproducir movimientos del mundo real en personajes animados, lo que permite crear animaciones con acciones más detalladas y realistas. De hecho, se puede considerar al rotoscopio como el precursor de la tecnología de captura de movimiento moderna, ya que permite ambos se basan en replicar movimientos del mundo real.

Felix el gato es un personaje de animación creado en 1919 por el caricaturista Pat Sullivan y animado por Otto Messmer. Es considerado como uno de los primeros personajes de dibujos animados con personalidad propia y con animaciones que presentaban una trama más elaborada. Siendo la caricatura muda más popular y lucrativa de mediados de 1920.

Felix el gato fue importante para la animación por varias razones. Primero, su popularidad ayudó a consolidar la animación como una forma de entretenimiento en la cultura popular. Además, Felix fue un precursor de los personajes animados con características humanas y con personalidades distintivas. Su diseño simple pero icónico lo convirtió en un símbolo reconocible para la audiencia, lo que inspiró la creación de otros personajes de animación con características similares.

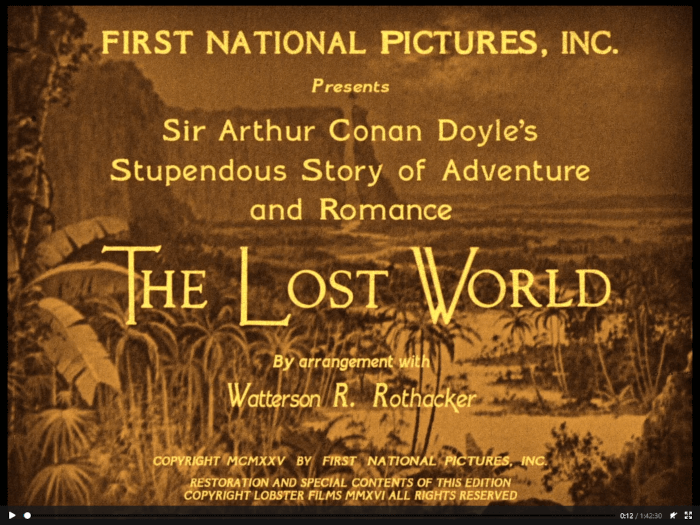

The Lost World es una película estadounidense de aventuras y ciencia ficción, dirigida por Harry O. Hoyt y estrenada en 1925. La película está basada en la novela homónima de Arthur Conan Doyle y cuenta la historia de un grupo de exploradores que viajan a una meseta aislada en Sudamérica donde descubren una tierra perdida en el tiempo habitada por dinosaurios y otros animales prehistóricos.

Uno de los mayores aportes de The Lost World fue su uso pionero de técnicas de animación cuadro a cuadro o stop motion para crear las animaciones de los dinosaurios y otros animales prehistóricos. El animador Willis O'Brien (quien posteriormente trabajó en la película “King Kong”), fue el encargado de crear los modelos animados de los dinosaurios y logró que estos se mezclaran con los actores reales en las escenas de la película. El uso de la técnica de stop motion fue un gran logro técnico en su época y permitió crear animaciones impresionantes.

Esta película ha sido seleccionada para su preservación en el Registro Nacional de Películas (National Film Registry) debido a su gran importancia cultural, histórica y estética. Puede ser vista a través del siguiente enlace:

https://upload.wikimedia.org/wikipedia/commons/2/2e/The_Lost_World_(1925).webm

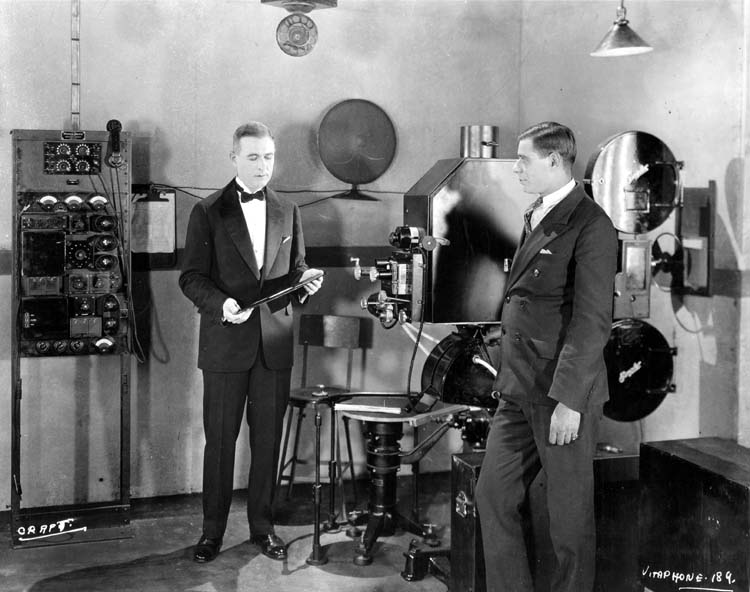

The Jazz Singer es una película estadounidense de 1927, dirigida por Alan Crosland, que cuenta la historia de un joven llamado Jakie Rabinowitz (interpretado por Al Jolson) que quiere convertirse en cantante de jazz, pero su padre, un rabino ortodoxo, quiere que siga la tradición familiar y se convierta en cantor en la sinagoga. La película explora los conflictos entre el deseo de Jakie de seguir su pasión y su lealtad a su familia y su herencia cultural.

Lo que hace que The Jazz Singer sea una película históricamente importante es que se considera el primer largometraje comercial con sonido sincronizado. Antes de esta producción, el sonido en las películas era incorporado de forma separada, por ejemplo, con orquestas tocando en vivo durante la proyección de la película.

Con The Jazz Singer se utilizó el sistema Vitaphone desarrollado por la compañía Warner Bros. (), que permitía grabar el sonido en discos para ser reproducidos de forma sincronizada con la proyección de la película. El sistema Vitaphone se convirtió en un importante avance en la tecnología del cine sonoro, al permitir la sincronización precisa de la música y el diálogo con la imagen en la pantalla. A partir de aquí, las películas sonoras se fueron convirtiendo poco a poco en la norma de la industria del cine y rápidamente fueron desplazando a las películas mudas.

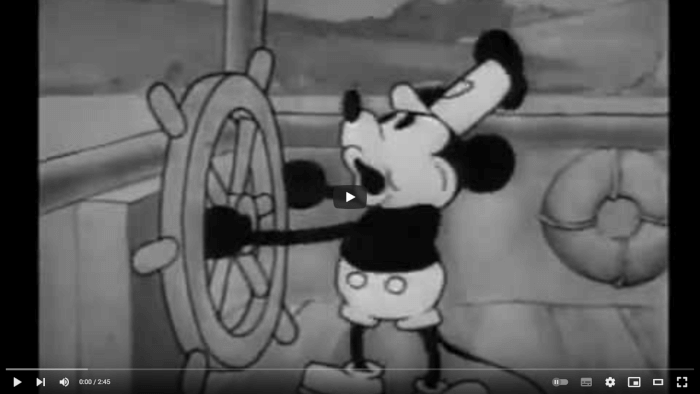

Steamboat Willie es un corto animado dirigido por Walt Disney y Ub Iwerks, que cuenta la historia de Mickey Mouse, quien trabaja como timonel en un barco de vapor y se enfrenta a situaciones cómicas mientras trata de realizar sus tareas.

Este cortometraje es significativo porque fue el primer corto animado en tener sonido sincronizado, lo que significa que los efectos de sonido y la música se ajustan perfectamente a la animación. En ese momento, la tecnología de sonido en el cine aún estaba en sus primeras etapas, por lo que esta innovación allanó el camino para la incorporación de sonido en las animaciones. La técnica de sincronización de sonido se logró utilizando el sistema de grabación y reproducción de sonido llamado Powers Cinephone, desarrollado por la empresa británica DeForest Phonofilm.

A pesar de ser la tercera animación de Mickey Mouse, se considera su verdadero debut ya que fue la primera vez que se presentó al público con las características que acompañarían al ratón animado en el futuro. Además, fue el primer cortometraje distribuido por Disney que tuvo gran popularidad, lo que ayudó al éxito futuro de la compañía.

En la actualidad, los primeros segundos de este corto se han convertido en parte de la animación de introducción de algunas películas de Disney, como un pequeño guiño a las raíces de la compañía. Y desde el 1 de enero de 2024, después de más de 95 años de su debut, Steamboat Willie entró en el dominio público.

Skeleton Dance es un cortometraje animado producido y dirigido por Walt Disney en el que cuatro esqueletos se levantan de sus tumbas para bailar y jugar en un cementerio. La música y los efectos de sonido, junto con los movimientos divertidos y rítmicos de los personajes, crean una atmósfera alegre y característica del estilo de Disney.

Uno de los aspectos más importantes de Skeleton Dance es que se destacó por ser una de las primeras animaciones que presentó la idea de que la personalidad del personaje es lo que impulsa sus acciones y movimientos. Es decir, más allá de mostrar las capacidades de la tecnología, se enfocó en crear personajes con una personalidad única que conectara con el público.

Skeleton Dance fue el primer corto animado de la serie Silly Symphonies, que fue una colección de cortometrajes musicales producidos por Disney durante los años 30.

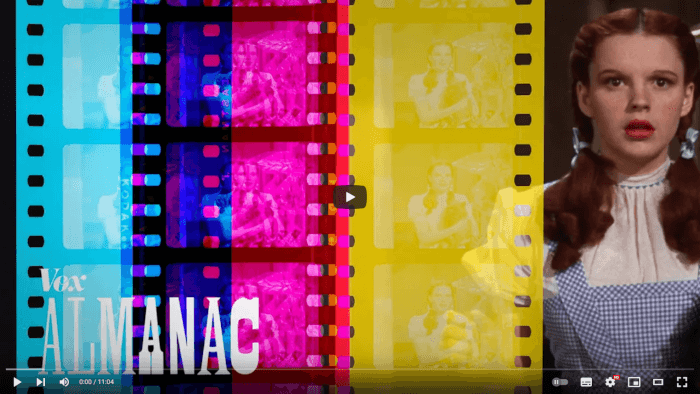

El proceso utilizado por Technicolor, de forma simplificada, se basa en la separación de los colores de una imagen por medio de prismas para grabarlos en películas en blanco y negro, que luego pasando por filtros se proyectan de forma simultánea en el cine para obtener una imagen a todo color. Esta técnica revolucionó la producción y consumo de películas al ser la primera en producir imágenes a todo color, y su utilización transformó la industria cinematográfica.

Con el tiempo, las películas en blanco y negro fueron reemplazadas gradualmente por las nuevas películas a todo color, lo que supuso un gran avance tecnológico en el cine. La capacidad de Technicolor para crear películas en color fue crucial para este cambio, y su legado se puede apreciar en las películas actuales que usan tecnologías similares para crear imágenes más vibrantes y realistas.

Con la intención de mantenerse a la vanguardia de la tecnología en la industria cinematográfica, Disney no solo aprovechó la tecnología sonora, sino que también exploró las posibilidades inherentes a las tecnologías emergentes, como fue el uso del color en producciones animadas.

En 1932, Walt Disney Productions produjo Flowers and Trees, un cortometraje animado que se convirtió en la primera película animada en color de la serie Silly Symphonies. Este cortometraje utilizó el proceso Technicolor de tres colores y relata la competencia entre árboles y flores por la atención de una hermosa dama. Es importante mencionar que, Flowers and Trees ganó el primer Premio de la Academia otorgado a un cortometraje animado en color.

El estudio de animación de Disney no sólo utilizaba las tecnologías desarrolladas por otros, sino que también desarrollaron sus propias innovaciones tecnológicas para mejorar sus animaciones y destacar frente a otros estudios de animación.

La cámara multiplano es un mecanismo creado por Disney que permite separar un cuadro de una animación en múltiples planos o capas, lo que proporciona una mayor sensación de profundidad en las tomas y simplifica la producción de composiciones complejas. La importancia de la cámara multiplano radica en que permitió a los animadores de Disney crear escenas más complejas y detalladas que eran visualmente impresionantes y únicas.

Con la cámara multiplano, los animadores podían separar diferentes elementos de una escena en diferentes capas y controlar su movimiento y velocidad individualmente para crear una sensación de profundidad y perspectiva. Además, esta técnica permitió a los animadores agregar detalles más realistas a las escenas, lo que hizo que las animaciones de Disney se destacaran por su belleza y realismo.

Actualmente los programas de dibujo digital, edición de imágenes y de video utilizan este concepto y separan los elementos visuales en diversas capas virtuales, logrando de esta manera aislar los diferentes elementos que componen una imagen y así permitir su edición de forma independiente.

La película King Kong cuenta la historia de un gorila gigante que vive en una isla remota y que es capturado y llevado a la ciudad de Nueva York, donde se libera y comienza a causar destrozos subiendo al Empire State llevando a ser atacado para que al final caiga del edificio y muera. Es considerada un hito en la historia del cine debido a que los efectos especiales realizados por O'Brien fueron innovadoras para la animación e influyeron en la industria durante varias décadas.

Los escenarios de la isla de Kong se crearon utilizando modelos en miniatura y proyecciones en pantalla, mientras que los efectos especiales de los animales de la isla se crearon por medio de animación stop motion. Para las escenas en las que King Kong interactuaba con actores humanos, estas se filmaron por separado y luego se combinaron en postproducción. La película fue filmada en blanco y negro y se utilizó música y efectos de sonido para aumentar el drama.

La creación de King Kong fue un gran logro técnico y artístico y ha dejado un legado en la historia del cine, ya que en gran medida, determinó diversas técnicas que se siguen utilizando hoy en día en la animación hecha por stop motion, como por ejemplo, el uso de marionetas con un esqueleto metálico con el que se logran diversas poses de los personajes, así como la combinación de imágenes del mundo real con los personajes animados.

La computadora Z1, diseñada por el ingeniero alemán Konrad Zuse, fue una de las primeras computadoras electromecánicas programables en el mundo. A pesar de su diseño mecánico la Z1 incluía muchos componentes que se encuentran en las computadoras modernas, como memoria, operaciones de punto flotante, dispositivos de entrada y salida, así como una unidad central de procesamiento o unidad de control. Además, la Z1 utilizaba una cinta de película perforada para proporcionar instrucciones al sistema, lo que la convierte en una de las primeras computadoras programables. En esencia, esta máquina permitía realizar cálculos complejos y estaba diseñada para ejecutar cálculos estadísticos, así como funciones de matemáticas e ingeniería.

Desafortunadamente, la computadora Z1 no se construyó completamente antes del inicio de la Segunda Guerra Mundial y fue dañada durante un ataque aéreo en 1943. A pesar de esto, se continuó trabajando en el diseño de computadoras y eventualmente Zuse creó otras máquinas, como la Z2 y la Z3, que fueron versiones mejoradas de la Z1 y utilizadas en aplicaciones militares durante la guerra.

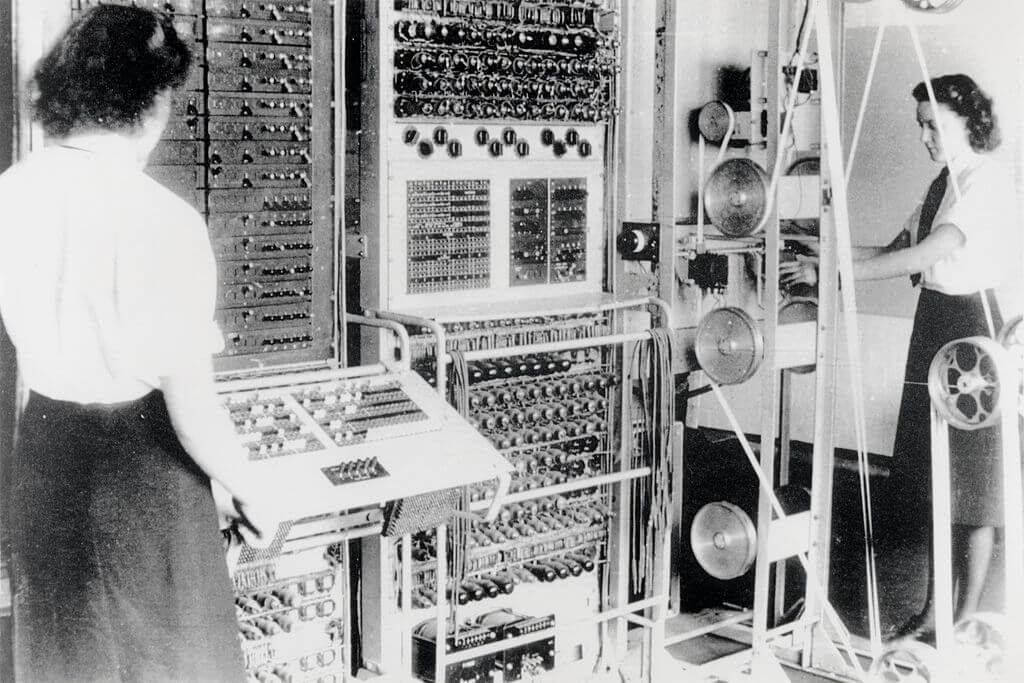

Durante la Segunda Guerra Mundial, la máquina de cifrado Lorenz era utilizada por las fuerzas alemanas para comunicarse con sus fuerzas en el campo de batalla. El cifrado era tan complejo que los expertos en criptografía de los aliados no podían descifrar los mensajes. Para enfrentar este desafío, un equipo de ingenieros liderado por el matemático y científico de la computación Alan Turing, en la base secreta de Bletchley Park, Inglaterra, desarrolló la primera computadora digital electrónica programable de propósito especial del mundo: la computadora Colossus.

La Colossus se basó en la tecnología de tubos de vacío y su capacidad de procesamiento superó con creces a las máquinas electromecánicas anteriores utilizadas para la criptografía. Fue capaz de procesar grandes cantidades de información y descifrar mensajes en minutos, lo que antes llevaba días o incluso semanas.

A través de su innovadora tecnología de computación digital, Colossus pudo resolver problemas matemáticos y lógicos extremadamente complejos de manera más rápida y eficiente que cualquier otra máquina anterior.

El uso de la computadora Colossus se mantuvo en secreto durante muchos años después del fin de la Segunda Guerra Mundial, pero finalmente se reveló al público. La creación y uso de Colossus en la guerra ha sido acreditada como una contribución significativa a la victoria de los aliados, ya que permitió descifrar mensajes enemigos y anticipar sus movimientos, permitiendo que los aliados tomarán medidas para frustrar los planes del enemigo y ganar ventaja en el campo de batalla.

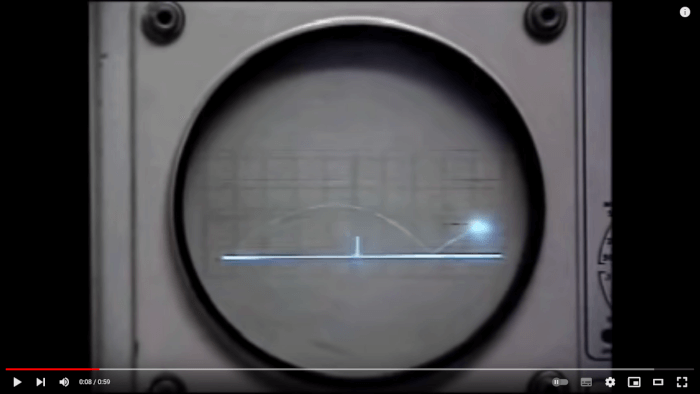

Tennis for two es un videojuego pionero creado por el físico estadounidense William Higinbotham en 1958.

El juego se considera una de las primeras incursiones en la creación de videojuegos y es conocido por utilizar un osciloscopio para dibujar sus gráficos. Un osciloscopio es una pantalla que se utiliza para medir la amplitud de las señales eléctricas, y en este caso se utilizó para mostrar una vista lateral de una cancha de tenis en la que los jugadores interactuaban con una pelota de luz mediante un control mecánico sencillo.

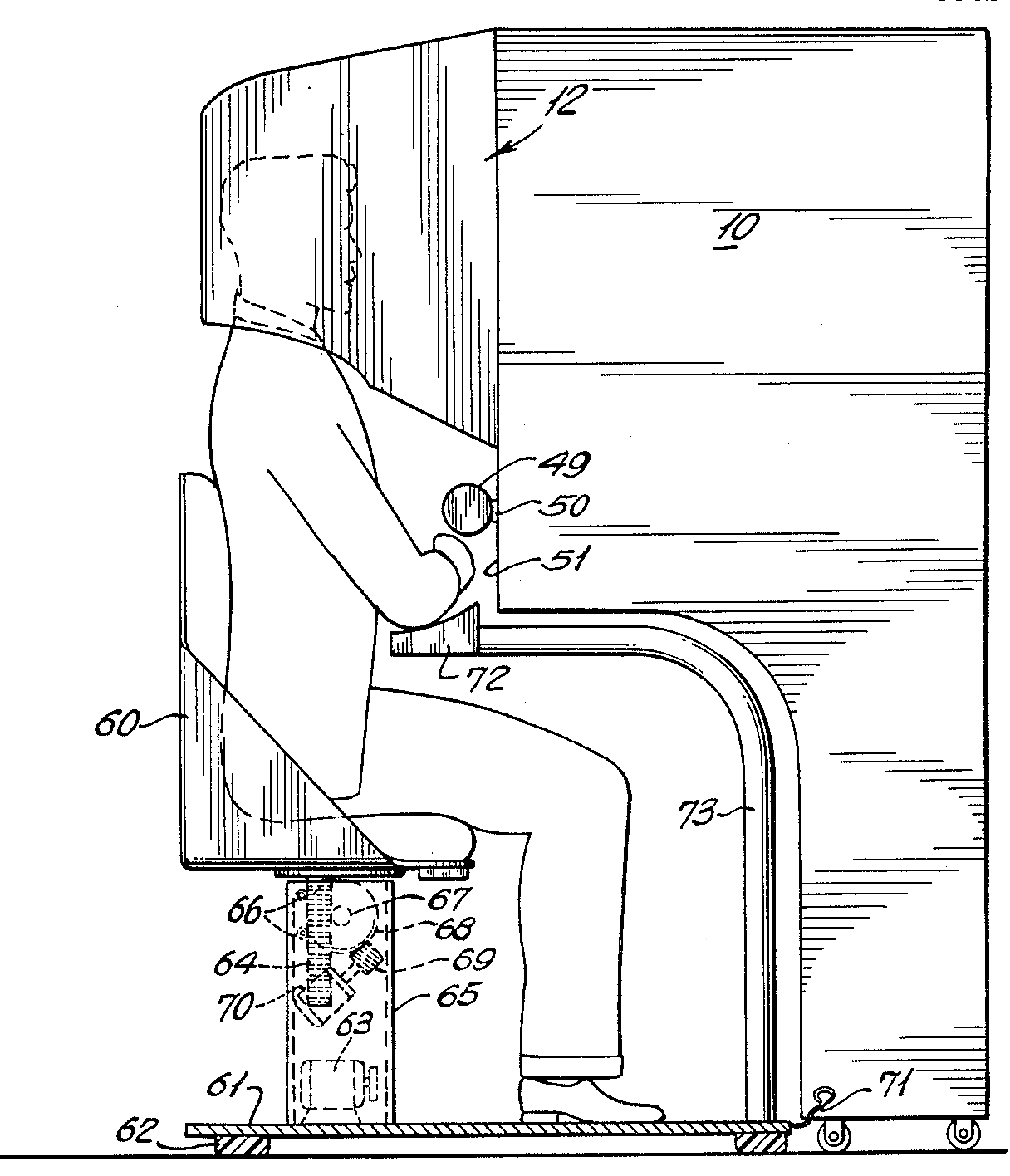

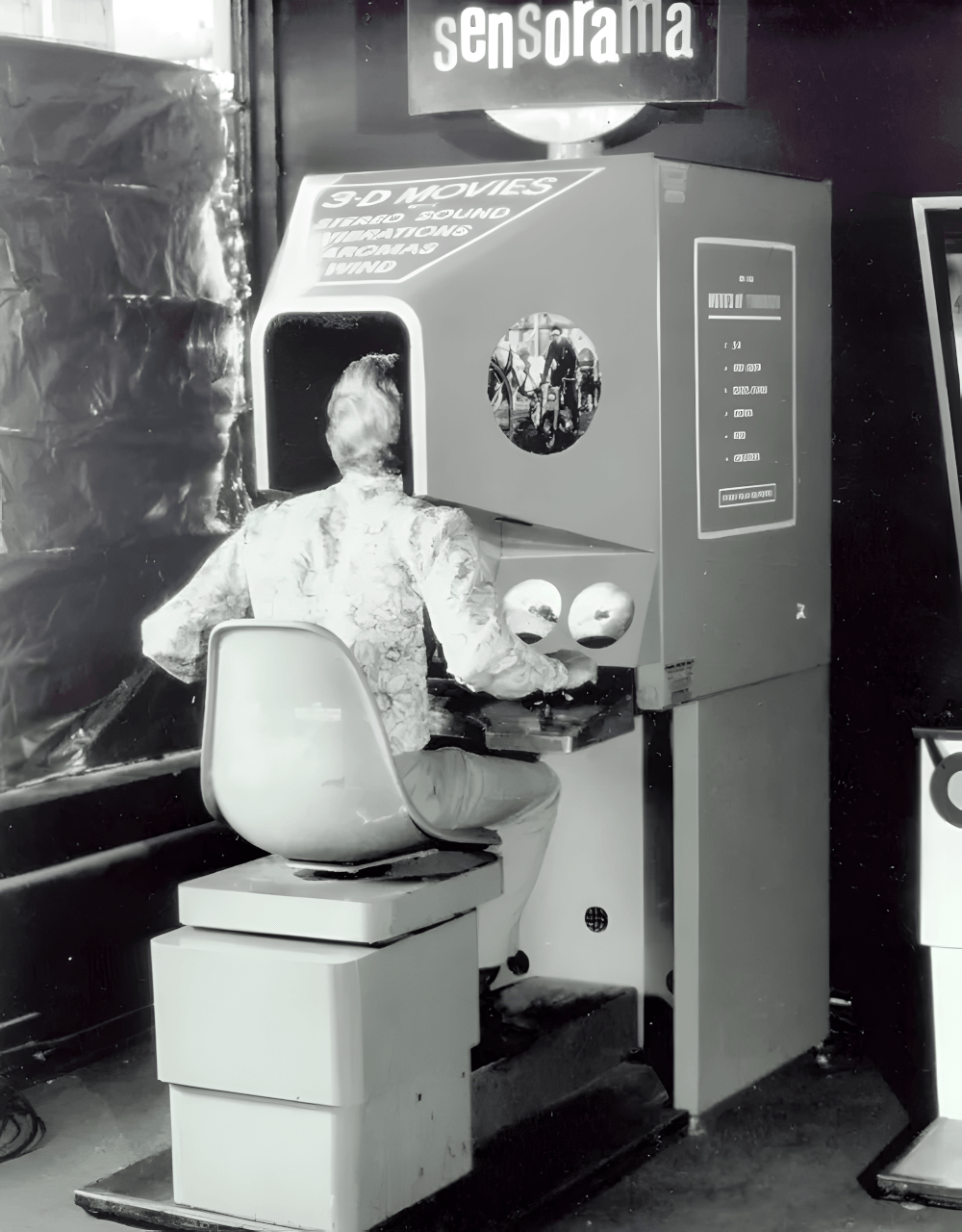

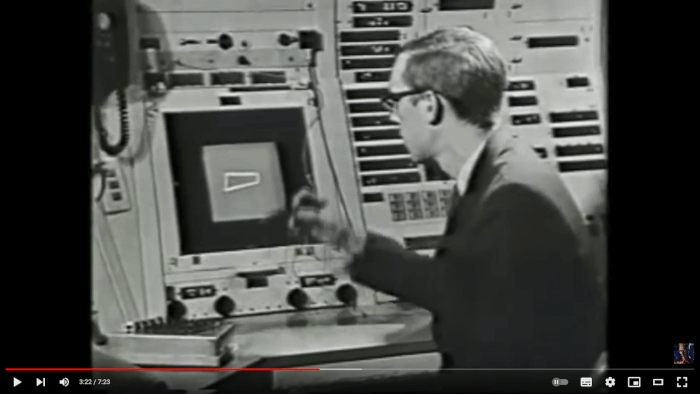

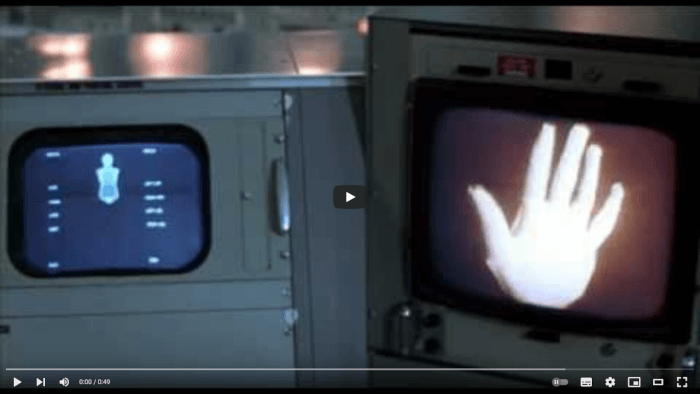

La secuencia de créditos de la película Vértigo es una animación icónica en la historia del cine y la animación por computadora. Fue creada por John Whitney utilizando una computadora antiaérea de la Segunda Guerra Mundial y una plataforma giratoria con un péndulo colgando sobre ella ().

Para crear los elementos en espiral que aparecen en la secuencia, Whitney programó la computadora para generar patrones matemáticos y geométricos que se combinaron para crear la animación. Estos patrones incluyen formas en espiral, líneas curvas y círculos concéntricos.

La secuencia se considera la primera animación por computadora utilizada en un largometraje.

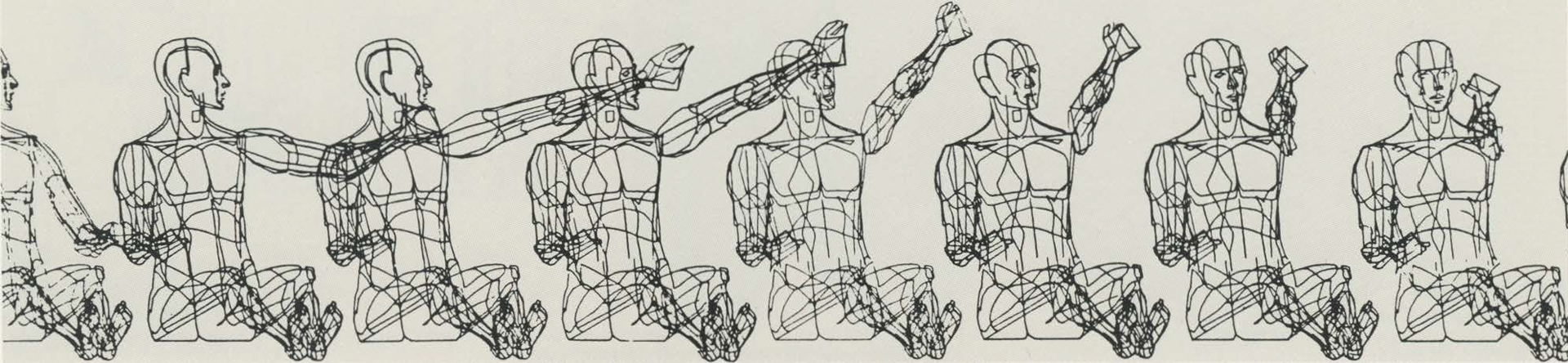

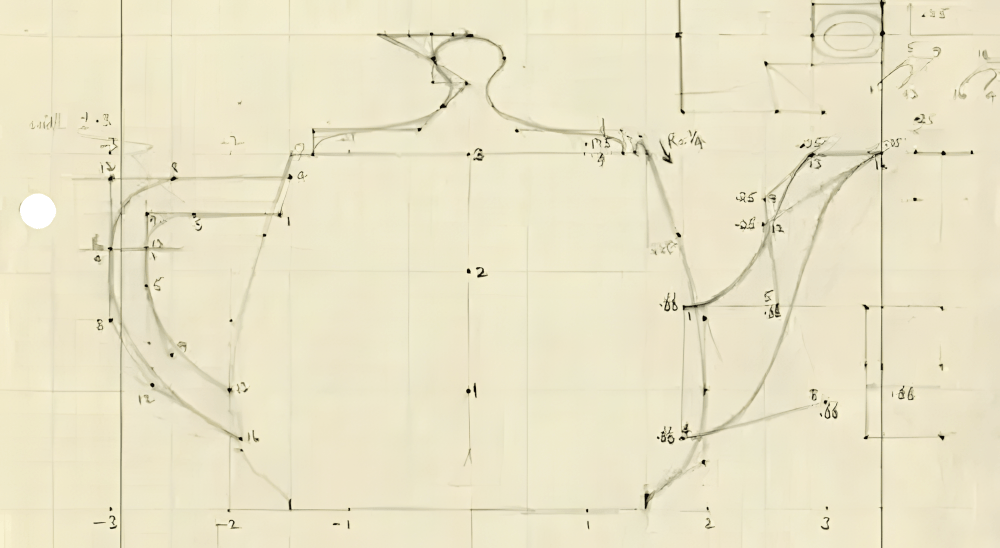

William Fetter fue un diseñador gráfico e industrial, pionero en el campo de la graficación por computadora. Durante la década de 1960, trabajó en la compañía de aviones Boeing, donde creó el primer modelo 3D de una persona: el Boeing man. Este modelo se utilizó para diseñar cabinas de aviones y mejorar la ergonomía de los asientos.

Fetter es reconocido por haber acuñado el término “Computer Graphics” el cual utilizó para referirse a su trabajo.

Catalog es una animación experimental generada por computadora, creada por John Whitney, el mismo que estuvo a cargo de los créditos de la película Vértigo. La animación presenta patrones abstractos que cambian y se mueven al ritmo de la música, todo ello realizado mediante el uso de la computadora analógica mecánica que construyó.

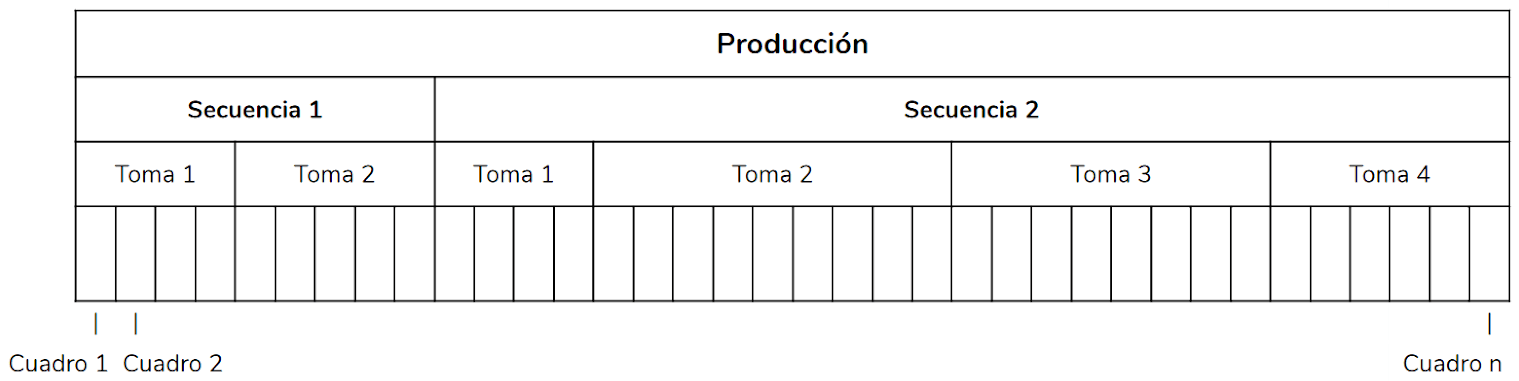

Es importante destacar que Catalog fue una recopilación (o catalogo) de los efectos visuales que Whitney había generado previamente.