Elementos de una Gobernanza del Riesgo

Segunda Edición

INTERACTIVO

Juan Guillermo Rivera Berrío

Institución Universitaria Pascual Bravo

Fondo Editorial Pascual Bravo

Medellín

Título de la obra:

Elementos de uan Gobernanza del Riesgo

Autores:

Juan Guillermo Rivera Berrío

2ª edición – 2019

Diseño del libro: Juan Guillermo Rivera Berrío

Código JavaScript para el libro: Joel Espinosa Longi, IMATE, UNAM.

Recursos interactivos: DescartesJS

Fuentes: Lato y UbuntuMono

Fondo Editorial Pascual Bravo

Calle 73 73A-226

PBX: (574) 4480520

Apartado 6564

Medellín, Colombia

www.pascualbravo.edu.co

ISBN: 978-958-56476-5-7

Tabla de contenido

Prefacio

Este libro digital interactivo se ha diseñado utilizando el editor de DescartesJS, de tal forma que se pueda leer en ordenadores y dispositivos móviles sin necesidad de instalar ningún programa o plugin.

El contenido del libro se basa en el curso de "Elementos de una Gobernanza del Riesgo", asignatura de la Maestría CTS+i del Instituto Tecnológico Metropolitano. El libro ha sido desarrollado para cumplir con el alcance y la competecnia de esta asignatura.

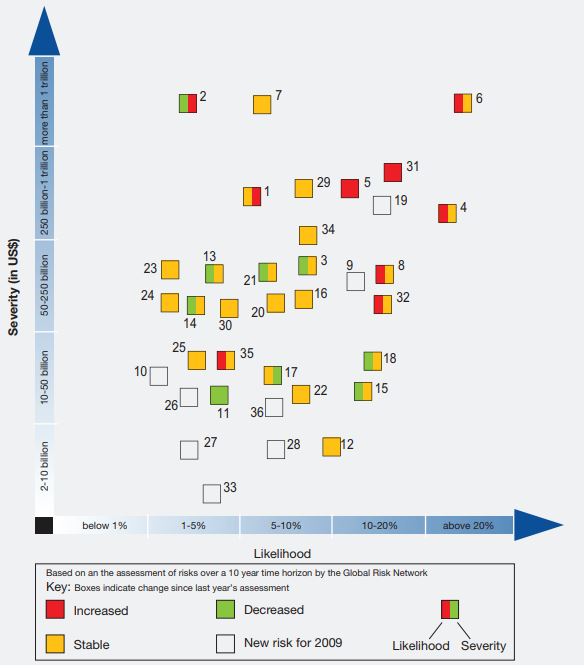

Los estudios sobre el riesgo se han centrado, en su mayoría, en tres preocupaciones fundamentales: i) ¿cómo gestionar el riesgo?, ii) ¿cómo se percibe el riesgo?, y iii) ¿cómo comunicar el riesgo? La primera preocupación es propia de administradores (privados y públicos), técnicos y hacedores de políticas públicas. Los diferentes modelos de gestión (incluidos los de gobernanza) son procesos que tienen actividades en común como la identificación (causas y efectos) y la evaluación.

La diferencia se establece en la formulación de acciones y estrategias, en tanto que son dependientes del tipo de riesgo que se pretende gestionar. Otro grupo de investigadores ha dedicado su atención al segundo interrogante que, independiente del tipo de riesgo, genera diferentes puntos de vista y modelos que tratan de explicar por qué unos riesgos se perciben menos que otros y, en otros casos, por qué la percepción del experto es diferente a la del público lego. La literatura, incluida la de tipo filosófico, relacionada a este segundo interrogante, se ha centrado en el análisis y discusión del paradigma psicométrico (Slovic, et al., 1981), de la teoría cultural (Douglas & Wildavsky, 1982) y de la Sociedad del Riesgo (Beck, 1986).

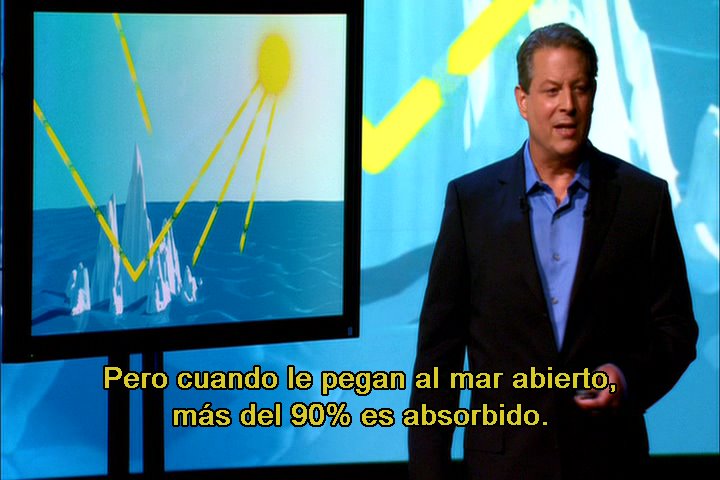

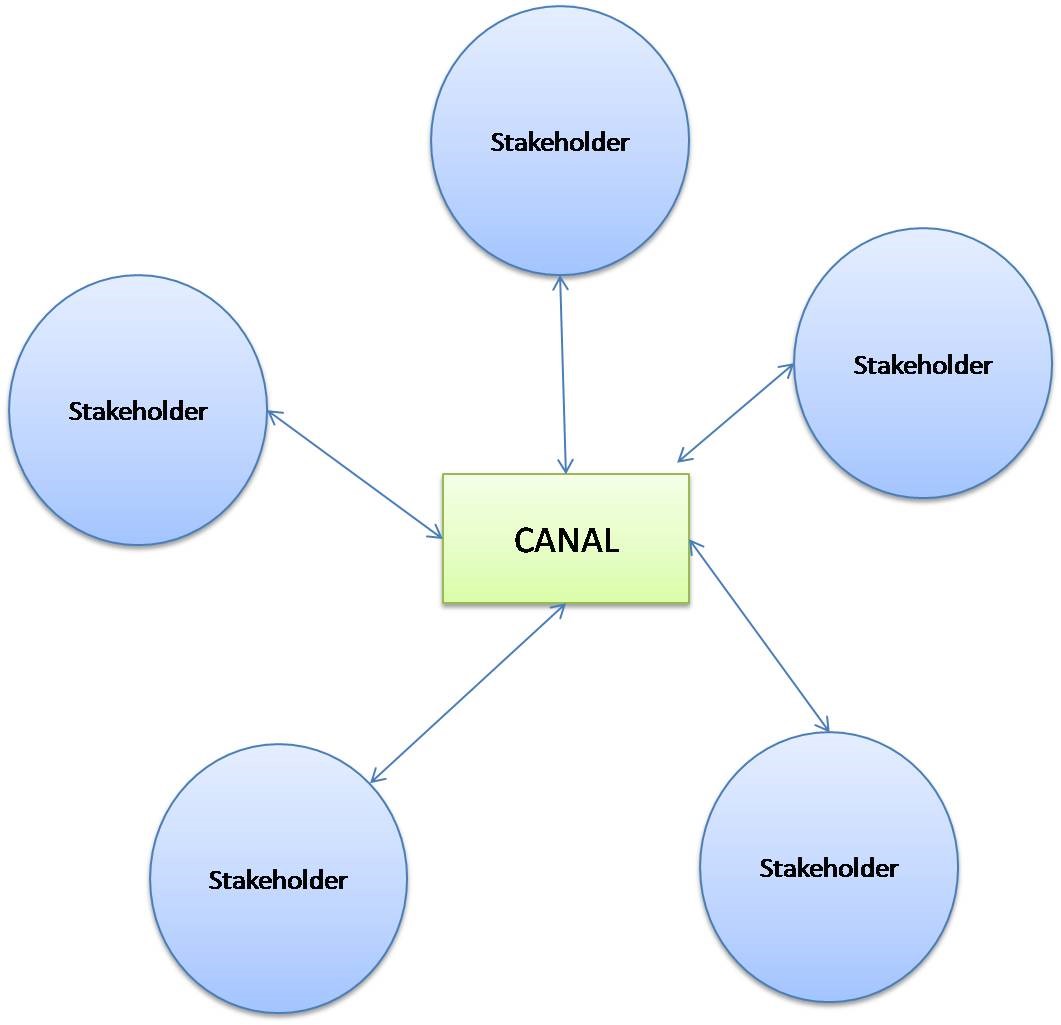

Un elemento común, entre los estudios técnicos y sociales, es la comunicación del riesgo; mientras que para los modelos de gestión se constituye en una estrategia, para los estudios sociales es un factor que incide en los niveles de percepción o, si se prefiere, la percepción es un indicador de la efectividad de la comunicación (Armas & Avram, 2007, p.148). Este elemento común, a su vez, es garante de la constitución de modelos de gobernanza. En un nuevo modelo de gobierno en asuntos de evaluación, control y gestión de riesgos se hace imperativo, para conciliar intereses y preferencias de las diferentes agencias, una comunicación efectiva y situacional.

Un programa de posgrado en estudios de CTS debe procurar el análisis de las interrelaciones entre fenómenos tan complejos como la comunicación, la representación y la percepción, haciendo énfasis en aquellos aspectos que pueden contribuir a la construcción de representaciones y comunicaciones efectivas del riesgo. Fenómenos como la percepción, la representación y la comunicación interactúan permanentemente para construir de manera colectiva o individual un concepto acerca de un fenómeno del mundo, el riesgo.

Los demás capítulos presentan discusiones en torno a riesgos globales que demandan una gobernanza, en tanto que se han escapado al control de los gobiernos y requieren de la participación de los llamado stakeholders. Riesgos de origen nuclear, transgénicos, nanoproductos, Cambio climático, Internet, entre otros, hacen parte de la discusión

1. Un modelo de gobernanza para gestionar y controlar el riesgo

1.1 Introducción

Los nuevos desafíos que se presentan con la implementación de las nuevas tecnologías ha generado un nuevo lenguaje como respuesta lógica a los cambios inducidos en nuestro mundo (Hajer & Wagenaar, 2003, p.4). Un término de moda es la gobernanza, que parece ser el sustituto de la noción de gobierno, en tanto que las capacidades de control y gestión de una nueva sociedad en red está erosionada en parte por la desconfianza creciente hacia las políticas públicas y a las decisiones a veces erradas en torno a la implementación de las nuevas tecnologías, o bien porque se han superado los límites estatales donde se es posible intervenir. Las incertidumbres científicas y el surgimiento de efectos no deseados han aumentado el clima de tensión entre las diferentes agencias (ciencia, gobierno, empresas y sociedad civil) afectadas por las decisiones tomadas en asuntos de ciencia y tecnología. Un nuevo modelo de gobierno en asuntos de evaluación, control y gestión de riesgos se hace imperativo para conciliar intereses y preferencias de estas agenciasTradicionalmente en los estados democráticos la participación del pueblo, en la toma de decisiones, se realiza a través de sus representantes; es decir, se trata de una “democracia representativa”. La participación de los ciudadanos se limita a elegir a sus representantes. El nuevo modelo que se impone es aquel que cuenta con mecanismos ciudadanos para participar en el análisis, deliberación y formulación de políticas públicas, así como en la toma de decisiones democráticas para gestionar y controlar el riesgo..

La conciliación agruparía los intereses y objetivos científicos, políticos, económicos y el de la sociedad civil en general, en la búsqueda de un objetivo común: el control y la gestión democrática de los riesgos.

Este nuevo modelo presupone la existencia de algunas condiciones como la voluntad política al cambio, una ciudadanía más informada en el tema de riesgos (Short & Rosa, 2004) y alguna metodología que permita la interacción de grupos heterógeneos.

Los riesgos como constructos mentalesEl concepto de riesgo como construcción mental, según Renn, es una combinación entre lo que se observa y experimenta, permitiendo crear diferentes escenarios de acuerdo a dicha experiencia:

They are not real phenomena but originate in the human mind. Actors, however, creatively arrange and reassemble signals that they get from the ‘real world’ providing structure and guidance to an ongoing process of reality enactment. So risks represent what people observe in reality and what they experience. The link between risk as a mental concept and reality is forged through the experience of actual harm (the consequence of risk) in the sense that human lives are lost, health impacts can be observed, and the environment is damaged or buildings collapse. The invention of risk as a mental construct is contingent on the belief that human action can prevent harm in advance. Humans have the ability to design different futures, i.e. construct scenarios that serve as tools for the human mind to anticipate consequences in advance and change, within constraints of nature and culture, the course of actions accordingly (Renn, 2005, p.23). o sociales presentan niveles de complejidad que hacen difícil su gestión. Es cada vez más evidente la ausencia de la certeza en las evaluaciones (objetivas) de los expertos (cambio climático, vacas locas, Three Mile Island, son algunos ejemplos); es decir, cada vez hay más incertidumbre y desconcierto con los impactos no esperados o no deseados. El nuevo modelo obliga a todas las agencias a sacrificar, en parte, sus intereses y preferencias a través de mecanismos de conciliación que permitan hallar soluciones efectivas a problemas comunes . El advenimiento de nuevos riesgos de carácter global obliga a comprender el fenómeno del riesgo en todos sus contextos: el científico o experto debe acercarse al contexto social, cultural y económico en el que se crea y desarrolla el riesgo y las otras agencias (no expertas) requieren de una mayor información sobre el riesgo para poder participar y emitir juicios dentro de un marco conceptual común.

1.2 La erosión de la neutralidad de la agencia científica

El riesgo evaluado por los científicos o expertos se suele denominar “riesgo objetivo”.

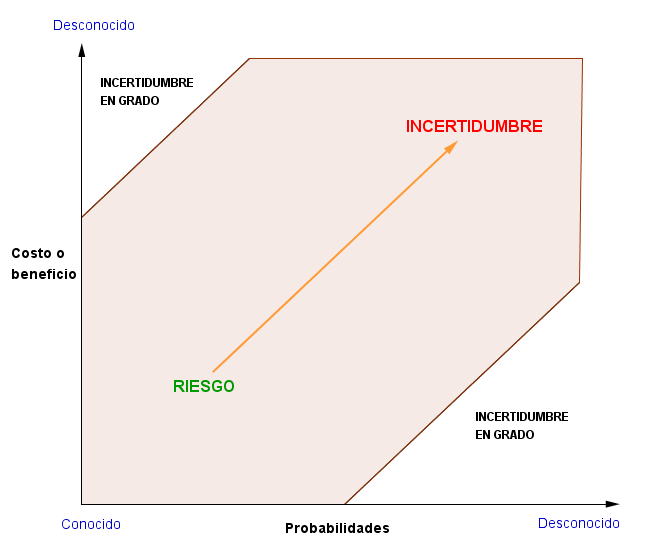

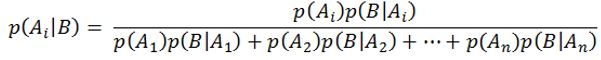

Bajo este concepto, el riesgo es una función de probabilidad que vincula las causas con los efectos positivos o negativos del fenómeno llamado riesgo, relacionado más estrechamente con sucesos mensurables en los cuales las probabilidades juegan un papel importante para el análisis y toma de decisiones.

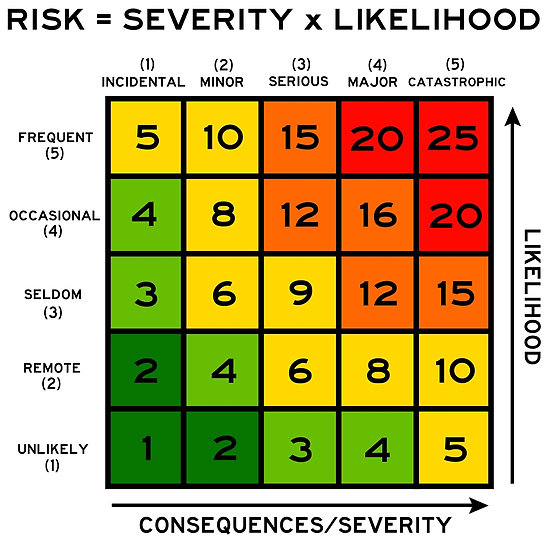

El análisis de riesgos por los expertos sigue normalmente dos fases: evaluación del riesgo (risk assessment) y gestión del riesgo (risk management); en la fase de evaluación se caracterizan los riesgos , se estiman o valoran y finalmente se evalúanLa estimación del riesgo está referida a la “posibilidad” de ocurrencia de efectos adversos en un sistema, en el cual se identifica el riesgo. Esta estimación, en modelos de identificación y evaluación de riesgos como el AS/NZS (Council of Standards Australia, 1999) de Australia y Nueva Zelanda, se calcula como una “probabilidad” que expresa los niveles de severidad de los efectos adversos, en gradaciones de baja a alta. Igualmente, se estiman (valoran) los controles existentes para determinar, finalmente, el nivel de exposición al riesgo. Por otra parte, en la evaluación del riesgo se establecen prioridades (análisis costo beneficio), frente a las cuales se toman de decisiones de aceptabilidad, es decir: “riesgo aceptable” o “riesgo inaceptable”. Por mor a la claridad, bajo el esquema caracterización → estimación (análisis) → evaluación → gestión, discutiremos este apartado.. La discusión actual en torno a la estimación y la valoración de los riesgos es su validación entre los mismos expertos a través de modelos que permiten un mayor consenso científico ; pero, en cuanto a la evaluación, la no participación de las otras agencias ha generado intensos debates en tanto que en esta etapa de análisis es en la que se toman las decisiones.

Es en la evaluación de los riesgos donde se toma la decisión de aceptarlo o rechazarlo. Aceptar el riesgo es aceptar un nuevo desarrollo tecnológico, es aceptar la implementación de una política con los impactos o consecuencias que ello conlleva, es aceptar el daño mínimo justificado en el bienestar general, es la subjetividad del riesgo objetivo: “Puesto que las decisiones tecnológicas, así como la identificación, estimación, valoración y gestión del riesgo no son asépticas ni están libres de intereses, las conclusiones de una evaluación muy difícilmente serán unánimemente aceptadas” (Olivé, 2004, p.305). La blindada neutralidad científica se erosiona, mientras que las llamadas evaluaciones objetivas del riesgo son ahora cuestionadas por los grupos de no expertos, por su incompatibilidad con las creencias del público.

Los científicos sociales, por su parte, ven en estas evaluaciones la posibilidad de suposiciones idóneas e inciertas, pues existen razones para creer en el juicio subjetivo de los expertos, igual que en el de los no expertos, no se escapan las normas, los valores sociales o culturales, ni a las creencias e intereses de todo tipo, como señala Sjöberg:

Experts make risk judgments on the basis of factors and thought structures that are similar to those of the public, but their level of perceived risk will be drastically lower than that of the public […] there is a dramatic gap between experts’ and managers’ risk perceptions and those of the public and many politicians, this is clearly a conflict that needs to be resolved (Sjöberg, 2004, p.48).

No se puede negar que el estudio del riesgo realizado por los expertos se fundamenta en las más sofisticadas herramientas de la estadística y las matemáticas y en el análisis científico de las diferentes variables asociadas al riesgo en estudio.

Las evaluaciones, en principio, son sometidas a discusión hasta lograr un consenso dentro de una comunidad de científicos o expertos:

The conventional approach to science advising is to search for consensus so far as this is at all possible. Scientific expert committees have a strong tendency to opt for compromises whenever possible. Even if the initial differences of opinion are substantial, discussions are continued until consensus has been reached. It is extremely unusual for minority opinions to be published (Hansson, 2001, p.11).

Pero estas evaluaciones no pueden seguir relegadas a la subjetividad de los expertos. Tanto en las evaluaciones, como en las decisiones bajo riesgo, en el contexto de un modelo de gobernanza del riesgo, todos los grupos de interés (stakeholder), así como los afectados o posibles afectados por las decisiones, deben tener la oportunidad de debatir o deliberar. Esta intervención no es extensiva a todo tipo de riesgos.

No se trata de coadministrar en asuntos de riesgos administrativos o financieros propios de una empresa o una corporación, aquí los riesgos son locales y su gestión es corporativa. Tampoco se trata de intervenir en los sistemas de administración de riesgos cuya especificidad ha evidenciado que las decisiones demandan un conocimiento científico igualmente específico (virus informáticos, transbordadores espaciales, etcétera). La participación en la toma de decisiones referidas a riesgos, en especial su evaluación (aceptabilidad o no aceptabilidad), así como en las acciones de mitigación o prevención, es inherente a todos los afectados por el riesgo (verbigracia, el cambio climático). Igualmente, riesgos con tendencia a la incertidumbre están en el ámbito de un modelo de gobernanza del riesgo (los asociados a los transgénicos, a las nanotecnologías, o los que generan una intervención militar en otro país, entre otros).

1.3 Entre la desconfianza y la precaución

El contexto ecológico, cultural, económico y social, también demanda una participación en decisiones que pueden afectar a una comunidad en particular o a la sociedad en general (riesgos asociados a la implementación de las células madre o la clonación, para citar algunos ejemplos); demanda que se justifica en la afectación surtida por la decisión y a la subjetividad científica antes discutida. No obstante, no se debe confundir decisiones bajo riesgo, con decisiones bajo incertidumbre. Esta confusión está presente en muchas de las críticas a los expertos, especialmente en los llamados riesgos de la posmodernidad, o los riesgos globales de Beck, en su Sociedad del Riesgo.Algunas de las críticas más relevantes a las evaluaciones de los expertos, en realidad no versan sobre el riesgo. Son evaluaciones de la incertidumbre. Es importante destacar que críticas como las de Shrader-Frechette sobre las equivocaciones evidenciadas en las estimaciones de los expertos, no eran estimaciones equivocadas sobre el riesgo, sino sobre la incertidumbre (Shrader-Frechette, 1995, pp.117-122; Shrader-Frechette, 1991, pp.53-55; Short & Rosa, 2004, págs. 135-149). Algunos estudios sobre la evaluación del riesgo, especialmente en la salud, incluyen la incertidumbre como parámetro para tener en cuenta, elaborando modelos estocásticos e incluso de lógica difusa, ver por ejemplo (Kentel & Aral, 2004).

Actuar con precaución es actuar con cautela para evitar posibles inconvenientes, dificultades o daños; es decir, cuando no hay suficientes razones para creer que un curso de acción está libre de riesgos. Cuando las evaluaciones científicas se topan con la incertidumbre, el concurso de las agencias no expertas para la toma de decisiones se hace más complejo, dado que una de las características de la deliberación es el conocimiento sobre lo que se discute. Decisiones bajo incertidumbre son arriesgadas, incluso para los mismos expertos; aquí la gobernanza es riesgo.

Un modelo racional es el denominado principio de precaución al que se acude cuando no se conocen los posibles impactos que genera la toma de decisiones de carácter técnico o científico; es decir, cuando los datos científicos o tecnológicos no permiten una evaluación del riesgo. Gracias a este principio es posible, por ejemplo, regular la distribución y uso de tecnologías cuyos efectos en la salud o el medio ambiente son inciertos. Renn (2005, p.46), en el contexto de la gobernanza del riesgo, expresa que “…the management of risks characterized by multiple and high uncertainties should be guided by the precautionary approach”. Una mirada ética, ontológica, democrática y lógica en situaciones bajo incertidumbre (Shrader-Frechette, 1995) hace más compleja la participación públicaAcerca de la incertidumbre, ya habíamos advertido la descripción de Elster (1990), que permite comprender el porqué se hace más compleja la toma de decisiones democráticas, en tanto que, bajo incertidumbre, el agente o conjunto de agentes no pueden asignar probabilidades numéricas a la ocurrencia de un suceso, ni especificar los posibles estados del mundo. Tomar decisiones bajo incertidumbre, es tomar decisiones desde la ignorancia. Existe una vasta literatura acerca de las decisiones bajo riesgo, ambigüedad e incertidumbre, en la cual se hace presente la discusión frente a la distinción entre riesgo e incertidumbre; ver entre otros a Ahmed & Skogh (2006) y los modelos de simulación de escenarios bajo incertidumbre en Linkov & Burmistov (2005)..

A los errores fruto de la toma de decisiones bajo incertidumbre se suman una serie de interrogantes que cuestionan la otrora aceptada neutralidad científica, como fiel reflejo de la desconfianza hacia la empresa científica:

¿Hasta dónde los científicos están dispuestos o se les ha permitido comunicar o divulgar los resultados de sus investigaciones? ¿Es posible que resultados adversos a los intereses económicos de quienes financian la investigación se pongan en discusión pública? ¿Los intereses políticos y económicos están por encima de la ética científica y, por consiguiente, del bien común? Si estos supuestos se dieran por superados, ¿estarían los científicos dispuestos a confiar en la “racionalidad del público” para una acertada toma de decisiones?

La desconfianza de los expertos en la racionalidad del público se acentúa cuando el uso del principio de precaución (sin argumentos sólidos) detiene el desarrollo de las innovaciones tecnológicas (Renn, 2005, p.52). Los algoritmos o modelos racionales que utilizan los no expertos en la evaluación del riesgo no son aceptados ni validados por los expertos . La presencia de prejuicios y supersticiones, intereses y preferencias, el déficit cognitivo, los valores religiosos y culturales, y las emociones, se entremezclan afectando seriamente, según el punto de vista de los expertos, la racionalidad en la evaluación y posterior toma de decisiones. Sin embargo, estos factores, en mayor o menor grado, también afectan a los científicos, pero parecen ignorarloEl caso de las células madre es un ejemplo de la incidencia que puedan tener las creencias religiosas en el momento de tomar una decisión de tipo científico. La creencia o no del alma presente en un embrión, no sólo afecta al público lego o a sus representantes religiosos. ¿Un embrión es un ser humano? es una pregunta que para un científico religioso carece de sentido: el ser humano debe ser respetado y tratado como persona desde el mismo momento de la concepción. En contraste, para otros científicos, la experimentación con células madre no presenta ningún tipo de problema moral, no poseen ningún tipo de neurona, no tiene cerebro y por tanto no son poseedoras de conciencia, espíritu, alma o algo parecido.. En los científicos las creencias religiosas, prejuicios, valores culturales y emociones afectan en algo su evaluación final sobre un riesgo específico . Obviamente, la objetividad científica en una decisión racional tiene un fundamento de más peso en la información que se tiene sobre el tema tratado o analizado por los expertos o científicos, en tanto que,

an action is rational if it satisfies three optimality conditions […] First, the action has to be the best means of realizing the agent's desires, given his beliefs about ends-means relationships and other factual matters.

Secondly, these beliefs themselves have to be optimal, given the information available to the agent. The process of belief formation, that is, must not be distorted by 'cold' mistakes in information processing or 'hot' mistakes caused by motivational biases […]

Thirdly the amount of information, or more accurately the amount of resources spent on acquiring information, must itself be optimal, given the agent's prior beliefs about the costs and benefits of information-acquisition and the importance of the decision to him (Elster, 1996, pp.1392-1393).

Es decir, la información es el factor clave en la toma de decisiones. Esta información debe ser óptima, de fuentes confiables, que en el contexto de una gobernanza del riesgo se suministre desde la misma comunidad científica. No obstante, la desconfianza en la racionalidad del lego, en concordancia con la segunda condición de Elster, crece cuando la información óptima se mezcla con informaciones previas suministradas por los medios de comunicación. Esta influencia de los medios en la percepción del riesgo es, a menudo, negativa:

there is a widespread belief amongst sections of the risk community and some experts in government agencies, departments and industry that the media are important sources of risk perceptions […] the media are nearly always perceived as negative influences in this regard, allegedly prone to dramatization, distortion, sensationalism, misrepresentation, attention seeking and error – in general ‘blowing risks out of proportion’ and being anti-science and technology (Petts, et al., 2001, pp.2-3).

En ese sentido, los debates públicos (entre no expertos) siguen procedimientos que son lejanos a los procedimientos científicos, aflorando la doxa sin los suficientes argumentos de base científica. Estos procedimientos de análisis se fundamentan en información de diversas fuentes: Internet, prensa y, a veces, desde la ciencia misma . En estos debates, entonces, es común hablar con propiedad de temas para los cuales no hay una sólida formación o, al menos, una mínima culturización, generando, a su vez, mayor desconfianza en los expertos al no encontrar un par para el debate.

Despreciar riesgos por estar debajo de los umbrales de aceptabilidad del riesgo, es una práctica que ha sido delegada a los expertos. Estas decisiones donde los afectados e interesados no han participado son responsabilidad de los expertos que tiene, como efectos colaterales, resultados no contemplados por la ausencia o la débil presencia de valores morales y éticos en las evaluaciones realizadas, que afectan en última instancia a todos los involucrados en el complejo fenómeno del riesgoLos umbrales mínimos se conocen también como el método “De Mínimis” para la toma de decisiones bajo riesgo, generalmente fijado en un nivel que causaría menos de un incremento 10-6 en la probabilidad promedio anual de una fatalidad para una persona. Léase, para mayor ampliación a Shrader-Frechette (1991, p.71) y a Olivé (2004)., generando también desconfianza hacia este tipo de decisiones. Generalmente los umbrales definidos se basan en pérdidas humanas (decesos), dejando a un lado otros efectos como personas lesionadas de por vida, física o mentalmente, así como la pérdida de patrimonios o del entorno social y cultural.

La desconfianza del público se fortalece mientras que a las evaluaciones no democráticas del riesgo, por parte de los expertos, se suma la influencia de intereses políticos o económicos. El caso más conocido de este tipo de influencias se evidencia en las estimaciones de riesgo nuclear presentadas en el informe de Norman Rasmussen (ver apartado 1.1.4.7). Los resultados obtenidos por Rasmussen contradicen los hechos ocurridos en Three Mile Island (cinco años después) y Chernóbil (12 años más tarde). El creciente temor del público hacia la energía nuclear y su consecuente rechazo a la distribución y uso de este tipo de tecnología parecía que podría disiparse con un informe como el de Rasmussen; pero el temor renace desde los accidentes presentados, ¿por qué se equivocó el experto? Otro ejemplo es la influencia política en la evaluación del riesgo como el asociado a la presencia de armas de destrucción masiva en Irak; las evaluaciones posteriores a los miles de muertos demostraron lo contrario.

En todo este contexto, la desconfianza crece en los dos sentidos, del experto al no experto y viceversa, situación que no facilita los debates, los hace estériles, en tanto que las decisiones estarán lejanas de un consenso democrático.

1.4 Entre la objetividad y la subjetividad del lego

Toda experiencia individual, incluida la de los expertos, es subjetiva. Según el relativismo cultural, el riesgo depende del agente perceptor y nada puede ser medido más allá de esa percepción; es decir, rechazan cualquier idea de riesgo objetivo. Los realistas, por su parte, afirman que el riesgo existe independiente de si es percibido o no. Al margen de este debate, los hallazgos en los estudios de percepción del riesgo evidencian la tendencia del lego a subestimar las probabilidades. Para el lego es más relevante la prominencia del desastre que la baja probabilidad en un riesgo, contrario a la débil imagen de los efectos de un riesgo de alta probabilidad de ocurrencia, como la muerte por fumar tabaco (Slovic 1987, 2000). En general, el experto presta más atención a las probabilidades y el lego a las consecuencias (Sjöberg, 1999). He ahí la irracionalidad del riesgo subjetivo proclamado por los expertos. Lo cierto es que el lego percibe muchos riesgos sin necesidad de recurrir al análisis matemático o probabilista. Es un riesgo cruzar las vías de alto tráfico, el nadar en un río turbulento, el contacto con personas infectadas con un virus, el transitar por una calle desconocida a altas horas de la noche y en una ciudad con marcados índices de violencia, el navegar en Internet sin una protección contra virus… Pero, la percepción de estos riesgos parece no ser suficientemente efectiva; igual son muchos los muertos y heridos en accidentes automovilísticos, siempre existirán los ahogados, los infectados y los atacados en una calle a altas horas de la noche:

The subjective assessment of probability resembles the subjective assessments of physical quantities such as distance or size. These judgments are all based on data of limited validity, which are processed according to heuristic rules (Kahneman, 2002, p.465).

Estas reglas heurísticas basadas en datos de validez limitada, como enuncia Kahneman, son las que han permitido la supervivencia del lego en la sociedad del riesgo.

El bajo nivel de conocimiento que tiene el lego sobre ciertos estados del mundo, lo obliga a recurrir a estas reglas. Sus decisiones son bajo incertidumbre no bajo riesgo, siguen patrones no formales en los que no incluyen las llamadas probabilidades objetivas. Describen posibles estados del mundo e incluyen lo que Kahneman ha llamado “probabilidades subjetivas” Según Kahneman & Tversky, los juicios intuitivos no son más simples que los modelos racionales. Los juicios intuitivos bajo incertidumbre se basan en la accesibilidad, representatividad y en el anclaje heurístico que constituyen las probabilidades subjetivas o el estimativo (no calculado) de la probabilidad de un evento. Para mayor información sobre los prejuicios en la toma de decisiones bajo incertidumbre, ver (Gilovich, et al., 2002).. Sin embargo, tanto el experto como el lego hacen uso de estas probabilidades subjetivas, al evaluar eventos inciertos como el resultado de unas elecciones, el de un partido de fútbol o la propagación de un virus como el de la gripe porcina en México en 2009. La no participación de la sociedad civil en la evaluación y gestión del riesgo ha generado una especie de modelo protestatario, que acompaña el fin del viejo contrato social. Desde los años 60 del siglo pasado, el viejo contrato social para la ciencia empieza a caducar (Luján & López Cerezo, 2004, p.83), el modelo lineal de innovación y la confianza plena en las decisiones de la empresa científica es cuestionado. Los debates en torno a los impactos fruto de las decisiones unilaterlaes propician el surgimiento de entidades oficiales y no oficiales como un modelo incipiente de regulación del riesgo.

Este modelo fundamentado en la opinión pública y apoyado por los movimientos de protesta hacia las decisiones en ciencia y tecnología hace más notoria la dicotomía riesgo objetivo – riesgo subjetivo.

Sean reglas heurísticas o simples atajos cognitivos, la brecha entre expertos y legos parece estar relegada a la cantidad de información que uno y otro maneja. Las decisiones del lego y su método de estimación de los riesgos comunes presentes en su vida cotidiana no se pueden solapar a riesgos más complejos, puesto que carecen de la información pública suficiente o cuyos mecanismos de divulgación han sido débiles. La información que se debe comunicar al público, relacionada con el riesgo objetivo en términos cuantitativos, es un proceso considerado crítico por los expertos.

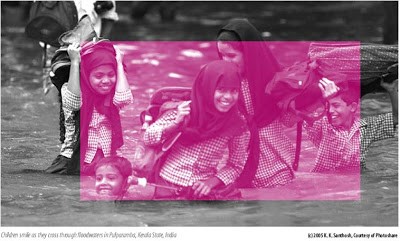

Las bases estadísticas chocan con los factores subjetivos del legoFactores como el miedo a los posibles efectos catastróficos, el control individual sobre el riesgo, el tiempo y el espacio de materialización del riesgo han sido ampliamente investigados por los psicólogos en el contexto del paradigma psicométrico (Slovic, et al., 1981; Renn & Rohrmann, 2000).. La toma de decisiones sobre la aceptabilidad de riesgos y la consecuente formulación de estrategias que permitan su gestión, en el contexto de un modelo de gobernanza, demanda la participación de todas las agencias, demanda una participación pública para que tanto las decisiones y responsabilidades sean democráticas. En riesgos globales o democráticos, en términos de Beck, las decisiones, las políticas, las culpas y las consecuencias son democráticas. Pero, ¿cómo lograr una efectiva participación pública en asuntos de riesgo?

Al principio podríamos adherirnos a una participación de tipo consultiva a través de cuestionarios, referendos o encuestas de opinión; sin embargo, el papel de los afectados o interesados seguiría siendo pasivo, y el cuestionamiento de los expertos a la subjetividad de estos mecanismos sería más activo.

Rowe & Frewer describen posibles vías y niveles que permiten introducirnos en nuestra propuesta de un modelo de gobernanza del riesgo:

A general definition of public participation with which few would argue is the practice of involving members of the public in the agenda-setting, decision-making, and policy-forming activities of organizations/ institutions responsible for policy development […] This definition of participation is, however, arguably too broad, leaving room for variable interpretation, because the public may be involved (in policy formation, etc.) in a number of different ways or at a number of levels—as has been noted by others […] in some cases, the public may “participate” by being the passive recipients of information from the regulators or governing bodies concerned; in other cases, public input may be sought, as in the solicitation of public opinion through questionnaires; and in still other cases, there may be active participation of public representatives in the decision-making process itself, such as through lay representation on an advisory committee (Rowe & Frewer, 2005, p.253).

Según este modelo, la participación del público puede hacerse a través de diferentes mecanismos como consultas populares, audiencias públicas, foros organizados, cuestionarios, referendos, entre otros mecanismos que son válidos sólo si el público es culturizado sobre el riesgo objetivo, de lo contrario tendrá que recurrir a las reglas heurísticas. Pero esta culturización debe ser en contexto; es decir, no debe ser únicamente desde la mirada “objetiva” del experto:

Conflict resolution and risk communication programs are likely to be rejected by the general public as long as the teaching and communicating processes are not conducted in parallel. While public perception and common sense cannot replace science and policy, they can certainly provide impetus for the decision-making process. At the same time, if decision-makers take into account the factors and needs of public perception, then public willingness to accept rational models for decision-making are likely to increase” (Renn, 2004, pp.412-413).

No se trata de volver experto al lego; lo que se busca es recuperar la confianza del público en los métodos objetivos de evaluación del riesgo y en la empresa científica. Igualmente, los expertos requieren de una formación sobre los factores sociales, económicos, culturales y políticos que inciden en la percepción del riesgo, para formular estrategias de comunicación del riesgo efectivas y situacionales . El modelo de gobernanza que proponemos va más allá de un modelo de democracia participativa pasiva o de un modelo de democracia deliberativa sin acción democrática. La toma de decisiones sobre riesgos “globales” o riesgos comunes que afectan a una comunidad en particular no puede ser ajena a los intereses del público en general o a las evaluaciones objetivas de los expertos; tanto expertos como no expertos tienen algo en común, viven en riesgo: por tanto, la gestión (acción) sobre estos riesgos debe ser democrática y la responsabilidad compartida. En los siguientes apartados profundizaremos en algunos modelos de gobernanza del riesgo, en especial el modelo analítico-deliberativo y nuestra propuesta de un modelo de gobernanza que trasciende a la gestión del riesgo, es decir, no se estanca en la toma de decisiones.

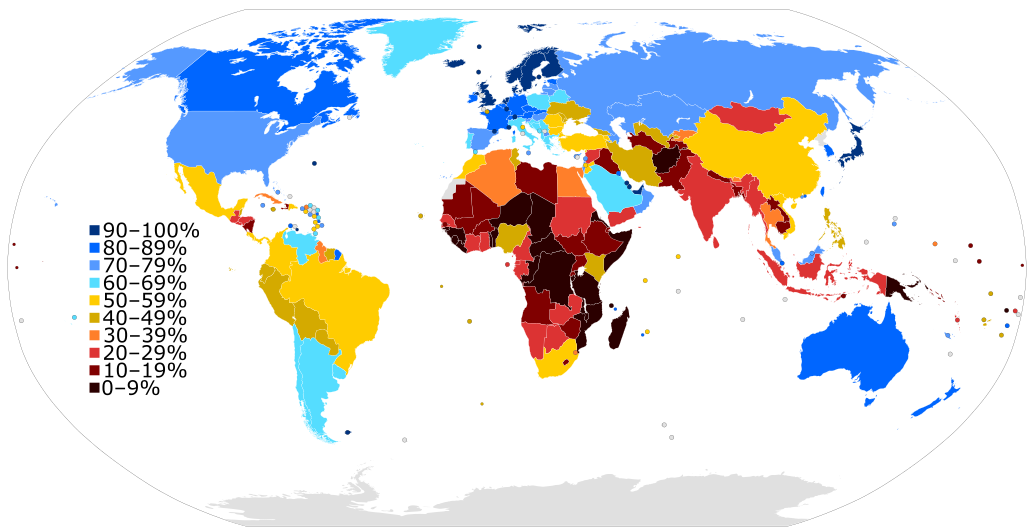

1.5 Un modelo de gobernanza en la búsqueda de la acción democrática

El término gobernanza es reciente y tiende a confundirse con alguna nueva estrategia para el control del estado o con el término gobernabilidad (Hirst, 2000, p.13)No es clara la distinción entre gobernabilidad, gobernanza y gobierno (Adinolfi, 2007, pág. 165). El término gobernabilidad, algunas veces, se asocia al término inglés government, igual traducción presenta el término governance. Parece ser que la distinción se encuentra en el origen del concepto. El concepto de gobernanza se origina en la economía, por ejemplo, para el Banco Mundial existe una relación en el crecimiento económico (ingresos per cápita) y la gobernanza. Los indicadores de gobernanza para este organismo tienen en cuenta: el control de la corrupción, la rendición de cuentas, ausencia de violencia, efectividad gubernamental, calidad regulatoria y el estado de derecho. Algunas de las publicaciones del Banco Mundial relativos a la gobernanza se pueden consultar en: www.worldbank.org/wbi/governance/ entre las que se destacan: Governance Matters V: Governance Indicators for 1996–2005 (2006), A decade of measuring the quality of governance (2006) y Governance Indicators: Where Are We, Where Should We Be Going? (2008). En este último se reitera: “Most scholars, policymakers, aid donors, and aid recipients recognize that good governance is a fundamental ingredient of sustained economic development”. La gobernanza en este contexto económico se confunde en gran parte con la “gestión del sector público” (Prats Catalá, 2004, p.80) o como un nuevo modelo de gobierno del sector público en el cual se destaca la introducción de prácticas comerciales y nuevos estilos de gestión. Al respecto Hirst (2000, p.18) expresa: “a new model of public services distinct from that of public administration under hierarchical control and directly answerable to elected officials”. Finalmente, de la literatura en español encontramos traducciones del término governance como gobernabilidad; por ejemplo, el informe sobre indicadores de gobernanza del Banco Mundial, “Aggregate and Individual Governance Indicators, 1996-2007”, aparece en la página en español como “indicadores de gobernabilidad”; por otra parte, la expresión “risks governance” se traduce como “gobernar los riesgos” en De Marchi & Funtowicz (2004). Dada la confusión, profundizaremos un poco en el término “gobernanza” de cara a precisar el contexto en el cual proponemos un modelo de gobernanza del riesgo.. En la formulación de políticas públicas en general, y de gestión del riesgo en particular, existen varios modelos que describen la relación entre las agencias involucradas (Khademian & Feldman, 2007; Hirst, 2000; Rhodes, 1997).

Cada uno de estos modelos podríamos inscribirlos en un concepto de gobernabilidad o de gobernanza según el rol que desempeña cada una de las agencias en el análisis, evaluación y gestión de riesgos y, especialmente, según el tipo de riesgo.Hannot Rodríguez (2007, p.198) precisa que un modelo de gobernanza debe prestar más atención al predicado, más allá del aspecto sustantivo del concepto. En ello coincidimos, en tanto que una gobernanza del riesgo no puede ser general sino específica: una gobernanza de la Internet, una gobernanza de los transgénicos o una gobernanza del cambio climático no pueden suscribirse al mismo colectivo que analiza, evalúa y toma de decisiones; éste se elige por afinidad al riesgo en discusión, sea por el conocimiento experto, por las partes interesadas, o por el grupo afectado

Sin entrar a discutir la distinción gobernabilidad – gobernanza, en principio, podríamos establecer cuatro tipos de modelos que describen la forma como participan las agencias en la toma de decisiones en asuntos de riesgo. Un primer modelo está centrado en el poder del estado (una sola agencia decide), típico en países con gobiernos autoritarios, el cual no es de interés para nuestros propósitos.

Un segundo modelo, el más común, es aquel que tiene en cuenta a los expertos como asesores para la toma de decisiones y en el que el papel de las otras agencias está inscrito en una democracia pasiva o también llamada “representativa”. Este modelo, así haya o no una cultura de democracia participativa y deliberativa es muy utilizado en presencia de riesgos inminentes. La gripe porcina, en el año 2009, obligó a la toma de decisiones desde dos agencias: el gobierno y la comunidad científica. Las demás agencias se someten, casi sin protestar, a las decisiones tomadas: cierre de escuelas, restaurantes y lugares de esparcimiento, uso de mascarillas, hábitos de higiene, uso de antivirales (revive el tamiflu, se rescata de la crisis financiera a las compañías farmacéuticas) y otras medidas que obedecemos como si la confianza en estas dos agencias nunca se hubiese perdido o menoscabado. ¿Cuál es la explicación a este fenómeno?

El miedo supera los otros factores en la percepción del riesgo. Confiamos en las decisiones científicas y gubernamentales, nos alimentamos de la información en los desacreditados medios de comunicación; tanto la opinión como el informe científico son fuentes consultadas en la búsqueda de la respuesta a la pregunta ¿qué debemos hacer? Se evidencia una fuerte relación percepción del riesgo – miedo a la amenaza.

Un tercer modelo, ideal en los estados democráticos stricto sensu, es el que tiene en cuenta a todos los involucradosLa democracia ideal (utópica en nuestro tiempo) es la democracia clásica (griega), caracterizada como una forma de gobierno en la que la participación de todos los miembros de la comunidad se hace en condiciones de igualdad para la toma de decisiones. En esta democracia existe confianza y las decisiones si no se obtienen por unanimidad, son una salida aceptable para la mayoría (Elster, 1986, p.112). La democracia participativa busca recuperar esos orígenes; sin embargo, sin unos mecanismos adecuados de participación, al final los concurrentes son representantes en tanto las decisiones sean de grupos minoritarios.: tanto los afectados como los diferentes grupos de interés (stakeholders).La National Research Council (2007, p.3) define el término stakeholders como todas las partes interesadas y afectadas. En virtud de este apartado, haremos distinción entre grupos interesados (stakeholders) y grupos afectados (o posibles afectados), en tanto que los últimos pueden estar o no interesados en la evaluación y la gestión de riesgos. Este último es denominado por Khademian & Feldman como un modelo de participación pública que

has its roots in the planning discipline and efforts to include people directly impacted by planning practices, as well as in efforts to democratize the development and implementation of public policies. In this model, the primary role of the public manager is engaging the public impacted by public policy by creating opportunities for participation as well as providing information and facilitating public deliberation and decision making. Public participation in this model is privileged as a means to enhance the quality of the policy process and the eventual policy impact as well as a means to enhance the participatory capacities of members of the public (Khademian & Feldman, 2007, p.308).

En el contexto de este modelo de participación pública enmarcamos nuestro concepto de gobernanza del riesgo. No obstante, un cuarto modelo podría ampliar esta participación a la acción. Es decir, no es suficiente con la participación en la formulación de las políticas que permitan la gestión de los riesgos, esta participación se debe extender a la gestión de los mismos. Descartamos los dos primeros modelos para nuestro análisis, así éstos sean posibles en el contexto económico, en presencia de riesgo inminente, o como una característica propia del nuevo orden mundial.

Por ejemplo, para el Banco Mundial que entiende la gobernanza como “… the manner in which power is exercised in the management of a country’s economic and social resources for development”, no importa si el modelo es autoritario o de poca participación pública.Un indicador en esta gobernanza económica que permite, aparentemente, la participación pública es el de “rendición de cuentas”; sin embargo, en Estados democráticos y corruptos, dueños además de las fuentes de información o de los datos resultados de la gestión, la rendición de cuentas no responde a la realidad. Los datos son alterados o maquillados para que el gobierno de turno no pierda su credibilidad. En Colombia se presentaron las renuncias de dos directores del Departamento Administrativo Nacional de Estadística (DANE), al no permitírseles revelar cifras indicativas que iban en contradicción con las afirmaciones del gobierno, en especial las referidas al desempleo y a la inflación.

Además de los modelos de gobernanza en el contexto económico, existen otras versiones de gobernanza enfocadas a la forma como participan las diferentes agencias.

La gobernanza mundial centrada en el campo de las instituciones internacionales en las que se tratan problemas que no pueden ser controlados localmente; el cambio climático, la regulación del comercio internacional y la actual crisis económica (2009) son ejemplos de ello.

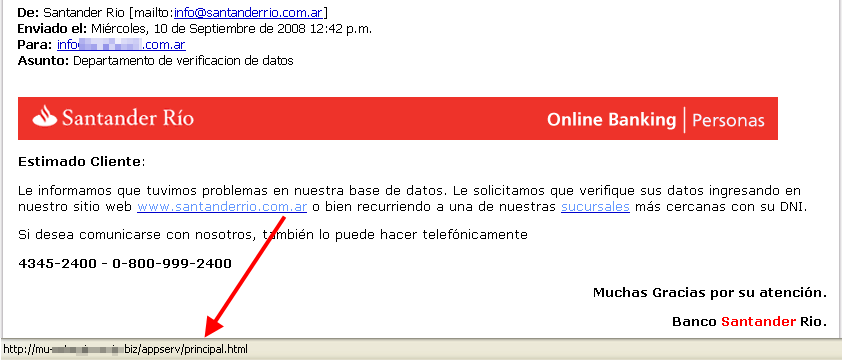

Otra, sobre la cual urgen regulaciones a nivel internacional, es la gobernanza de Internet que procura regular su uso sin control, que ha traído como consecuencia el surgimiento de los nuevos riesgos de la red (virus, troyanos, spyware, correos spam, pishing, pornografía infantil, ciber terrorismo, etcétera).La gobernanza de Internet, a su vez, presenta dos versiones: la gobernanza fruto de la necesidad de regulación tecnológica (dominios especialmente) y la gobernanza social de la Internet como necesidad de dar respuesta a riesgos asociados a la xenofobia, sectas satánicas, racismos, terrorismo, pornografía entre otros, que proliferan en la red. El grupo de trabajo de Gobernanza de la Internet WGIG (Working Group on Internet Governance) formulan el siguiente concepto de gobernanza de Internet: “Internet governance is the development and application by Governments, the private sector and civil society, in their respective roles, of shared principles, norms, rules, decision-making procedures, and programmes that shape the evolution and use of the Internet”.

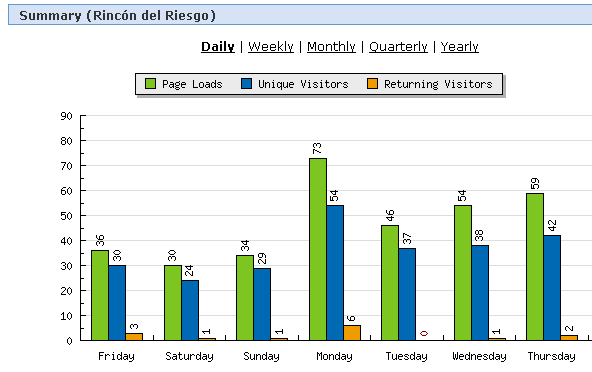

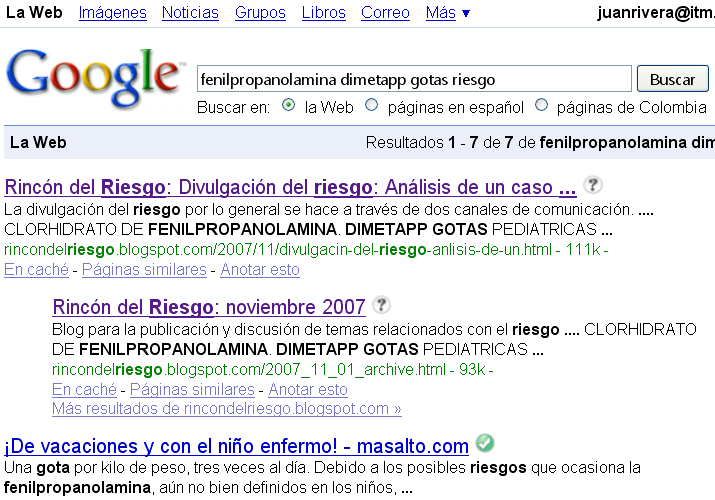

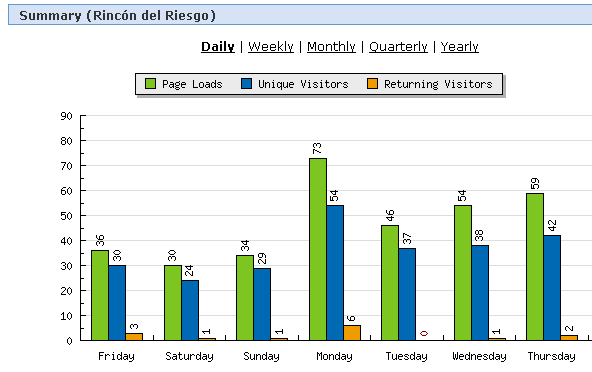

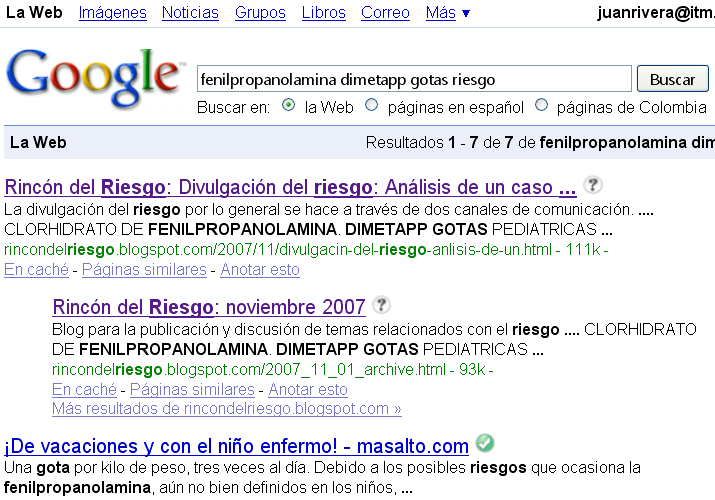

En esta definición, todos los actores involucrados juegan un papel importante, desde cualquiera de las esferas de participación: estado, sector privado o sociedad civil. La misma Internet se constituye en un escenario que facilita la participación. A través de los blogs, los foros o las redes sociales, la participación pública nunca antes había encontrado un mejor aliado para participar. En este tercer entorno (Echeverría, 2007, p.69) se crean redes sociales alrededor de una problemática común en las que la sociedad civil puede entrar a discutir sobre aquellos riesgos que no tienen mayor atención por las otras agencias. Un caso concreto, que puede servir para apoyar nuestra afirmación anterior, es el retiro del mercado de más de 4 millones de baterías por parte de la empresa Dell Computer en el año 2006. Las denuncias en cientos de blogs referidas a las explosiones que se presentaban en los equipos de cómputo propiciaron este resultado.

La proliferación de “noticias” en otros medios hizo que se presentara una reacción mundial frente a las baterías; algunas aerolíneas, por ejemplo, prohibieron el uso de portátiles Dell en sus aviones. El sector privado (Dell, Apple, Sony) tuvieron que aceptar sus errores tecnológicos y soportar el costo económico que esto implicaba.

La gobernanza corporativa es otro modelo que busca regular y proteger los intereses de los inversionistas y los accionistas (shareholders) de las empresas, compañías y corporaciones en general. Contrario al concepto de gobernanza, al cual nos acogemos, el estado y la sociedad civil no juegan un papel importante en este modelo, excepto por su injerencia a través de acciones como las del caso anterior, desde las cuales las corporaciones se ven obligadas a regular para no perder su poder competitivo en el mercado.

La “buena gobernanza” es una versión utilizada en la comunidad europea que se acoge a cinco principios: apertura, participación, responsabilidad, eficacia y coherencia. Cada uno de estos principios son esenciales para una gobernanza más democrática, participativa y deliberativa. No obstante, la participación pública precisa de una capacidad de las agencias para deliberar.

En ese sentido, las agencias no expertas requieren una comunicación efectiva de los expertos para obtener capacidad de debate; los expertos, por su parte, deben acercarse a los diferentes contextos afectados por las decisiones para conocer impactos no evaluados. Una buena gobernanza se concibe como aquella donde hay una amplia participación en la toma de decisiones. Una gobernanza que trascienda al estado, incorporando al sector privado y a la sociedad civil, crea una ambiente político, social y económico favorable para la gestión del riesgo.

Las soluciones a los problemas derivados de los riesgos serán en consenso y sus resultados, serán de responsabilidad compartida.

Los debates sobre la subjetividad u objetividad en la evaluación del riesgo serán fecundos si existe un discurso participativo y deliberativo, en el que tanto los modelos matemáticos como las creencias y valores sean ampliamente discutidas (Renn, 2005, p.52). En ese sentido nos acogemos a dos modelos de gobernanza del riesgo que posibilitan una mejor gestión del riesgo; el primero es un modelo analítico-deliberativo que se ubica en el contexto de la “buena gobernanza” y el segundo es un modelo analítico-deliberativo de acción compartida, que trasciende la participación más allá de la decisión; es decir, hacia la acción.

1.6 Modelo analítico – deliberativo

Inviting the public to be part of the decision making process in risk analysis and management has been a major objective in European and American risk policy arenas (Renn, 1999, p.3049; Renn, 2006, p.34)

El paradigma de la democracia deliberativa se fortalece como mecanismo de legitimación de las decisiones tomadas para gestionar los riesgos. La complejidad de los nuevos riesgos hace más difícil su control y gestión desde modelos de democracia fundamentados en el poder . Se abre paso, entonces, un nuevo modelo fundamentado en la razón, el modelo analítico - deliberativo.

No se trata de participar en la elección de representantes a través de las mayorías, se busca participar y deliberar en torno a la toma de decisiones. El surgimiento de nuevos riesgos y la desconfianza en la empresa científica y en los tomadores de decisiones generada por causa de los impactos no esperados, plantea la necesidad de una participación pluralista en torno a su análisis y control democrático.

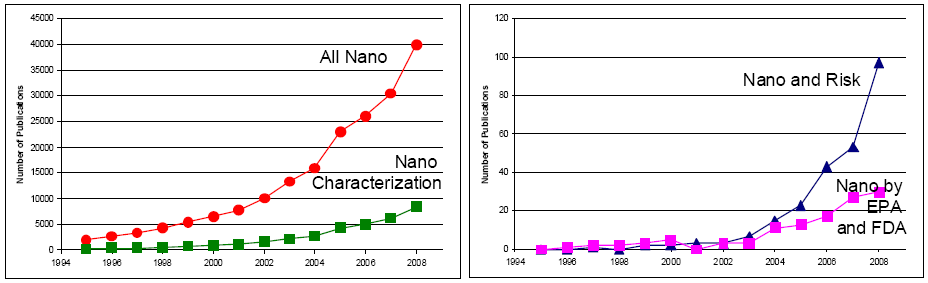

La sombra de la incertidumbre presente en estos nuevos riesgos demanda una caracterización discursiva y una toma de decisiones a través de una comunicación deliberativa y racional en procura de llegar a acuerdos que le den legitimidad a dichas decisiones (Arias M., 2003, p.168).Los conflictos que emergen con las nuevas tecnologías son cada vez mayores en tanto que la incertidumbre en torno a los impactos crecen. Un ejemplo de ello se observa con las nanociencias y las nanotecnologías, que se caracterizan por una lucha de percepciones entre las promesas y las amenazas (Macnaghten, et al., 2005). Desde sus promesas, es innegable el excelente futuro que se prevé para la optimización de ordenadores, el surgimiento de nuevos productos farmacéuticos, la medicina, nuevos materiales y las telecomunicaciones. Por contraste, las preocupaciones éticas, sociales, y ambientales crecen en torno a la toxicidad potencial de las nanopartículas, demandando la necesidad de una regulación más estricta (Macnaghten, et al., 2005, p.272). El control democrático de los riesgos exige una mayor participación y acción sobre las decisiones que permite, a su vez, comprender el rol ciudadano y sus responsabilidades, construyendo y gestionando socialmente el riesgo.

Por contraste al modelo de una democracia pasiva, la caracterización del riesgo se realiza desde dos procesos estrechamente vinculados: análisis y deliberación. El análisis del riesgo demanda, como hemos visto, métodos rigurosos desarrollados por expertos; sin embargo, en el nuevo modelo de gobernanza del riesgo, este análisis es retroalimentado con el concurso deliberativo de todas las agencias (ciencia, gobierno, sector privado, sociedad civil) que podrían utilizar teorías y métodos propios de las ciencias naturales, de las ciencias sociales, la ingeniería, las matemáticas, la jurisprudencia, entre otros (Stern & Fineberg, 1996, pp.30, 97). En la deliberación se discute y reflexiona sobre los resultados del análisis y sus implicaciones o afectaciones a los intereses de las diferentes agencias convocadas (Rodríguez, 2007, p.196).

El rol de los expertos en el proceso deliberativo es brindar el conocimiento objetivo y neutral necesario sobre los resultados obtenidos, que igualmente pretenden ser objetivos y neutrales.

Sin embargo, el modelo presenta problemas que no son fáciles de resolver: un problema surge desde el concepto del riesgo, en tanto que algunos actores del proceso lo perciben sólo desde sus posibles consecuencias o impactos . Otro problema se asocia a la polarización de algunas de las agencias en torno a uno o varios intereses o preferencias que irían en contra de los objetivos de caracterizar el riesgo (Stern & Fineberg, 1996) y reducirlo eficiente y eficazmente (Renn, 1999, p.3049).

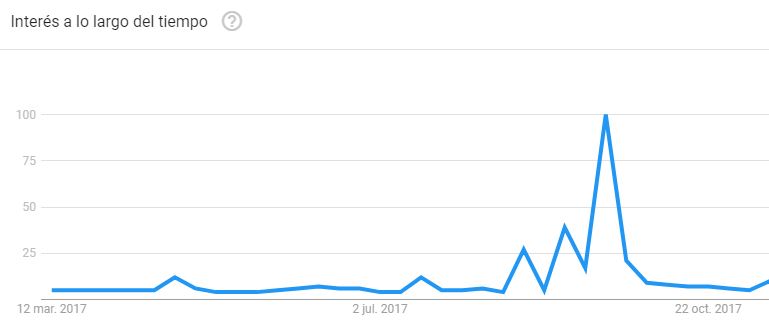

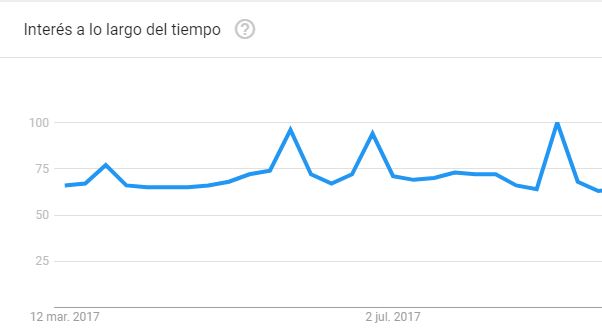

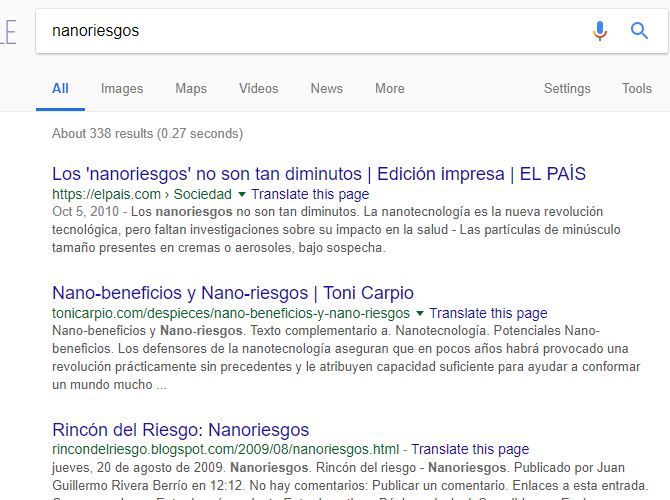

La falta de información suficiente que permita una toma de decisiones desde el conocimiento del riesgo se constituye en otra agenda de problemas que ameritan un análisis más profundo (nanoriesgos, por ejemplo).A esta agenda de problemas se vincula la tardanza para lograr un consenso, como se evidenció en el caso del cambio climático: “la comunidad científica, excepto en casos muy inusuales, tardaría mucho tiempo en llegar a un consenso acerca de lo que muestran las pruebas, si se insiste en alcanzar un consenso” (Cranor, 2004, p.109). Un consenso que se desprenda de la seguridad científica a partir de pruebas concluyentes es difícil de lograr, en tanto que los nuevos riesgos de origen tecnológico o científico cada vez presentan un mayor número de incertidumbres. Por otra parte,

when argument relations are noncomparable, dialogue cannot ensure consistent recommendations and simultaneously prepare for political decision making in a (noncreative and) democratic manner, that is, by uncensored priority setting, respecting argumentative unanimity, and observing argumentative nondominance (Sager, 2002, p.373).

No es de extrañar, entonces, que las decisiones sobre la implementación y difusión de nuevas tecnologías o la comercialización de productos técnico científicos, se haga, en muchos casos, sin el concurso de los posibles afectados y, peor aún, sin pruebas concluyentes de sus posibles efectos : “En Estados Unidos hay cerca de 100.000 sustancias o sus derivados registradas para uso comercial, pero la mayoría no han sido bien evaluadas en cuanto a sus efectos para la salud (U.S. Congress, OTA, 1995)” (Cranor, 2004). Véase (Stern & Fineberg, 1996, p.120) sobre el análisis de la incertidumbre y sus limitaciones.

El balance costo beneficio produce, a su vez, tensiones que pueden llevar a decisiones económicamente equivocadas . En ese sentido, es necesario un mecanismo que permita obtener un público más informado e imparcial para su interrelación con los expertos y el logro de una toma de decisiones imparcial. Los “representantes” de los diferentes grupos de interés deben ser, entonces, competentes, lo que se traduce en el diseño de otros mecanismos para la selección objetiva de estos representantes. No obstante una buena elección no siempre puede garantizar la eliminación de estos u otros problemas:

The best designed analytic-deliberative processes cannot eliminate all the problems and controversy associated with contentious risk decisions. They cannot guarantee acceptance of an agency’s risk decision or even a risk characterization. Controversies often reflect basic differences in values or interests: the more that is at stake and more that values and interests conflict, the less likely it is a decision will be widely accepted (Stern & Fineberg, 1996, p.83).

Este colectivo de deliberación, como bien lo define Rodríguez (2007, p.237), es otro riesgo en el proceso de toma de decisiones si no es competente para articular y evaluar el amplio abanico de problemas inherentes al riesgo. Como señala Renn,

competence, in this sense, relates to the use of the best available knowledge and listening and communications skills, as well as the ability to articulate, evaluate, and refute arguments about an issue. When the purpose of public participation is to produce a collective decision, competent understandings about terms, concepts, definitions, and language use; the objectified world of outer nature (nature and society); the social cultural world of norms and values; and the subjective worlds of individuals are all essential. This is accomplished through the use of established procedures (Renn, 1999, p.3049).

Este modelo de gobernanza del riesgo sería una primera fase en la gestión democrática de los riesgos que, en principio, suavizaría las tensiones existentes. No obstante, además de superar los problemas planteados, se hace necesario trascender el modelo a la acción democrática; es decir, la ejecución también democrática de las decisiones tomadas. Proponemos, entonces, un modelo que haga efectivas las decisiones tomadas. Este modelo debe permitir el control y gestión de los riesgos a partir de las decisiones y en un proceso interactivo desde los resultados de las decisiones, analizar y deliberar nuevamente en torno al riesgo.

1.7 Modelo deliberativo-participativo de acción compartida

El modelo anterior, como hemos afirmado, es más efectivo si trasciende la toma de decisiones democráticas a la acción. En asuntos de gobierno democrático nos hemos preocupado por las formas de gobierno y, en nuestro caso, por los modelos de gobernanza pero desde un solo lado de la ecuación, los gobernantes o tomadores de decisiones. Un modelo de gobernanza debe contemplar el otro extremo de la ecuación, los gobernados; en tanto que gobernantes y gobernados se mezclan en uno sólo para determinar los cursos de acción sobre los temas que afectan al colectivo.

Por ello, como señala Rodríguez,

lo realmente importante para una gestión del riesgo no es el carácter de la representación del riesgo, esto es, la adecuación con respecto a un riesgo externo, sino más bien la “readecuación” del colectivo mismo o las relaciones socionaturales donde es el riesgo constituido (Rodríguez, 2007, p.226).

Desde la mirada tradicional, los diferentes análisis y evaluaciones del riesgo (democráticos o no), arrojan innumerables informes, regulaciones y, en general, buenas intenciones.En países como Colombia, por ejemplo, las regulaciones sobre la construcción sismo resistente prohíben expresamente las edificaciones en mampostería no estructural. Sin embargo, la mayoría de las viviendas en los sectores de más bajos recursos no cumplen con la normatividad. ¿Por qué no se cumple?, ¿dónde está el control y gestión del riesgo sísmico? En la formulación de los planes de ordenamiento territorial y en la regularización de los sectores urbanos existe participación amplia de los afectados e interesados; no obstante, las normas se siguen incumpliendo. Las decisiones se convierten en buenas intenciones.

En el modelo de gobernanza del riesgo que proponemos, además de las bondades del modelo de Renn, contempla la acción; propende por la implementación de las acciones, las verifica y corrige que, en consecuencia, implica una readecuación social, cultural y económica del colectivo. Es un modelo en el cual las decisiones se convierten en política a seguir y éstas en acción:

The realm of politics is first and foremost a realm of human action. While there is a sense in which every human thought, every event, every utterance (called ‘speech acts’ by certain philosophers) can be regarded as an action, our definition intends a somewhat narrower and more common usage. Action here suggests building or closing a hospital, starting or concluding a war, taxing or exempting a corporation, initiating or deferring a welfare plan… in other words, doing (or not doing), making (or not making) something in the physical world that limits human behavior, changes the environment, or affects the world is some material way. Where there is no action (or no noaction of consequence), there is no politics (Barber, 2004, p.122).

Como lo enuncia Barber, donde no hay acción no hay política . En ese sentido, nuestro modelo de gobernanza institucionaliza las decisiones, bien sea local o globalmente, y propicia mecanismos de participación en la acción. Una gobernanza del cambio climático, por ejemplo, debe trascender los extensos informes o las espectaculares representaciones del riesgo; si bien éstas aportan al conocimiento del riesgo, las decisiones se quedan en buenas intenciones, así se plasmen en protocolos internacionales. Estas decisiones serán efectivas si todos los involucrados e interesados en los efectos del cambio climático desempeñaran su rol desde unos compromisos institucionalizados (regulación).

La agencia política deberá comprometerse a establecer las medidas regulatorias que se requieran o se desprendan de las decisiones tomadas, la agencia científica profundizará en el análisis de los riesgos caracterizados, la agencia económica propiciará los recursos financieros necesarios para la implementación de las políticas, la sociedad civil acatará la normatividad que emerge en este proceso de gobernanza y, en todos los ámbitos, la gestión y control del riesgo será de responsabilidad compartida; es decir, en el caso de riesgos como el cambio climático es de todos nosotros.Barber propone un modelo que denomina “democracia fuerte” donde los conflictos se resuelven de acuerdo al modelo de una democracia participativa a través de un proceso que permita la creación de una comunidad política capaz de transformar individuos dependientes y privados en ciudadanos libres e intereses parciales en bienes públicos (Barber, 1984, p. 132). La acción, como virtud de la “democracia fuerte”, es el fin último que inicia con la deliberación: “Activity is its chief virtue, and involvement , commitment, obligation, and service –common deliberation, common decision, and common work- are its hallmarks” (Barber, 1984, p.133).

Dada la complejidad del problema, las soluciones igualmente serán complejas, afectando los aspectos de tipo económico y político, además del cambio cultural y social.

Sin embargo, la implementación de este modelo fortifica la democracia, en tanto que la participación no se limita a la formulación de políticas sino que trasciende hacia un compromiso de hacerlas cumplir y cumplirlas. Pero, ¿cómo hacer efectivo el modelo? Por una parte, es necesario legitimar la toma de decisiones y, por otra parte, garantizar la ejecución de las decisiones. En la legitimación de las decisiones no se puede esperar a que todos los interesados y afectados participen y deliberen; esto se logra con una amplia participación, mas no con toda la participación. Para ello, existen mecanismos que permiten la presencia de todas las diferentes organizaciones, tanto civiles como de las demás agencias. Lo más complejo del modelo es lograr la participación activa y responsable en la acción, complejidad que se puede minimizar si se utilizan los mecanismos que hacen posible tal participación en presencia de riesgos inminentes.

Un buen ejemplo de acción democrática se presentó en el año 2009, con el advenimiento del virus AH1N1, divulgado como gripe porcina. El anuncio de la Organización Mundial de la Salud de una pandemia inminenteLa Organización Mundial de la Salud (OMS) establece seis fases previas a la declaración de una pandemia. Las dos últimas fases se caracterizan por: la propagación del virus de persona a persona al menos en dos países de una región de la OMS (fase cinco) -un indicio de la inminencia de una pandemia- y la aparición de brotes comunitarios en al menos un tercer país de una región distinta (fase seis). Por su parte, la Real Academia Española define pandemia como “enfermedad epidémica que se extiende a muchos países o que ataca a casi todos los individuos de una localidad o región”., sumado a los cientos de infectados y de algunos casos fatales, dispara el factor miedo confirmándolo como el principal aliado de la comunicación y percepción del riesgo.

Si bien el análisis y la deliberación no fue democrática (no tenía por qué serlo), la acción si lo fue.Ciertas decisiones no pueden ser democráticas, en tanto que la complejidad de los temas tratados y la inminencia de efectos adversos demandan oportunidad y celeridad en la decisión. Un proceso inmerso en el modelo analítico-deliberativo requiere de procedimientos para la selección del grupo, culturización sobre el tema, análisis, deliberación y, finalmente, toma de decisiones. El virus AH1N1 no nos permite la ejecución de este proceso, las decisiones entran en el ámbito de la emergencia:

Sometimes, governmental decision making must be completed rapidly, and the inclusion of necessarily slow citizen deliberation practices would make such decisions difficult to reach. When facing a compelling public policy problem, such as an impending environmental hazard or an international security crisis, rapid responses would obviate putting together a citizen panel or consensus conference (Hamlett, 2003, p.130).

Obviamente los errores, fracasos o éxitos serán de responsabilidad de los tomadores de decisiones, en tanto decisión, y de los que acataron tales decisiones, en tanto acción.

Al igual del casi consenso para el ataque y exterminio de los talibanes en Afganistán, las decisiones de las agencias científicas y gubernamentales se aceptan y se acatan, millones de mexicanos sacrifican su bienestar para minimizar el riesgo. En la conmoción generada por el advenimiento del virus, la desconfianza pierde poder, la fé en las instituciones se constituye en un paliativo para el miedo, el vituperado Tamiflu y la estigmatizada industria farmacéutica son ahora los salvadores. El modelo mexicano se extiende, al igual que el virus, a otros países en todo el orbe.

¿Cuáles son, entonces, esos mecanismos que hacen viable el modelo? Para dar respuesta a este interrogante es importante precisar en qué contexto es aplicable el modelo. Si bien es un modelo de gobernanza del riesgo, no todos los riesgos son susceptibles de gobernanza o, en un sentido práctico, no ameritan un proceso de gobernanza: los riesgos inminentes son un ejemplo de ello. Los eventos donde la incertidumbre es un factor predominante no son objeto de acción democrática (véase el apartado 1.1.4 sobre la distinción riesgo – incertidumbre).

Otros riesgos cuyas medidas de control son ampliamente aceptadas, tampoco requieren del modelo (ataque de virus a ordenadores, accidentes laborales, la mayoría de riesgos sanitarios, etc.). En otras palabras, aquellos riesgos, sin carácter de inminencia, donde existe conocimiento sobre posibles causas y posibles efectos, pero cuyos posibles controles (decisiones) puedan afectar a un sistema social, cultural, ecológico, económico o político, demandan gobernanza.

En los modelos de democracia participativa, en la “democracia fuerte” de Barber, o en el modelo de Renn, no encontramos mecanismos integrados para la participación, la deliberación, la evaluación, la toma de decisiones y la acción sobre el riesgo. Sin embargo, cada elemento constitutivo de la gestión del riesgo, en un contexto de gobernanza, presenta aisladamente sus propias estrategias y mecanismos. La deliberación es prolífica en mecanismos como las conferencias de consenso del modelo danés, que convoca a expertos y legos durante un período de tiempo, obteniendo como resultado un informe final por parte de los no expertos ; en los jurados de ciudadanos, que toma una muestra aleatoria de ciudadanos para la exposición de escenarios posibles generados por los expertos, permitiendo a través de la deliberación, la creación de nuevos escenarios (Hamlett, 2003, p.119) . Por otra parte, para la toma de decisiones es frecuente recurrir a mecanismos tales como el referéndum, la consulta popular, foros o paneles de ciudadanos y, comúnmente en Europa, los comités . No obstante, para la acción democrática no se encuentran mecanismos que permitan gestionar efectivamente el riesgo y, en consecuencia, el modelo de gobernanza se estanca en la etapa de toma de decisiones.

Sólo en momentos de crisis (riesgo inminente o durante el desastre) surgen mecanismos que, a veces, pueden ser efectivos o, en otros casos, agravan la situación de riesgo.

1.8 El riesgo nuclear - Una gobernanza no declarada

El riesgo entendido como la probabilidad de que un evento no deseado pueda o no ocurrir, es el significado técnico estándar del término en la teoría de la decisión. “Por decisión en condiciones de riesgo se entiende decisión con probabilidades definidas” (Hansson, 2005, p.70; López Cerezo & Luján, 2000, p.50), es el riesgo hecho probabilidad (Slovic & Weber, 2002, p.4), en el cual hay un mayor consenso entre los expertos. La estimación probabilista del riesgo de la ingeniería nuclear que puede arrojar como “resultado” un accidente nuclear, la estimación cuantitativa del riesgo carcinógeno de un producto químico o la probabilidad de que exista una serpiente cascabel en un cajón de nuestro escritorio, se basan en modelos teóricos, modelos que en muchos casos están cargados de presunciones subjetivas de quien o quienes lo formulan.

El mejor ejemplo de la subjetividad de este riesgo probabilista, también denominado riesgo objetivo, se encuentra en las estimaciones de riesgo nuclear presentadas en el conocido informe de Norman Rasmussen (López Cerezo & Luján, 2000, pp.43-46), ingeniero nuclear, quien por encargo de la Comisión de Energía Atómica de los Estados Unidos realizó en 1974 un estudio sobre la probabilidad de un accidente nuclear grave. Sin entrar en detalles de su modelo, Rasmussen estimaba que una fusión del núcleo en una central nuclear sólo se daría una vez en un millón de años de operación del reactor y que un accidente grave sólo es esperable una vez cada 10,000 millones de años. No hubo necesidad de esperar tantos años, en 1979 las cadenas de noticias de todo el mundo anunciaban: “Fue declarado el estado de alerta esta mañana en una central nuclear norteamericana en Pensilvania.

La rotura de una bomba de alimentación de agua…” (Verón, 1983, p.18). Se trataba del accidente de la central nuclear de Three Mile Island (TMI). La verdad es que no se trató de una rotura de una bomba como se anunció en un principio (distorsión del riesgo), sino de una serie de errores humanos que desencadenó una apertura (no rotura) de válvulas de seguridad para inyectar agua fría al reactor, las cuales fueron cerradas (otro error humano) generando altas temperaturas en el corazón del reactor y la expulsión a la atmósfera de gases radiactivos. Este último hecho constituye el accidente, el riesgo real. Los efectos del accidente de TMI aún no se han divulgado. El modelo de Rasmussen quizá no contempló el factor humano como fuente de riesgo. Otra predicción probabilista del riesgo nuclear arrojaba, para las personas vecinas a un reactor, una probabilidad anual de morir por un accidente en un reactor de una entre 300 millones. Es decir riesgo “cero” en el contexto del llamado “riesgo aceptable”; sin embargo, Chernóbil falsa el modelo.

Ejemplos como éstos abundan en la sociedad de la incertidumbre. A pesar de los modelos, la incertidumbre juega un papel importante. A pesar de los algoritmos que permiten las sofisticadas simulaciones, la subjetividad presente en el ingreso de los datos genera fisuras de conocimiento que llevan a resultados como el del accidente de TMI. A pesar de los grandes avances tecnológicos, las creencias son las que en últimas definen el modelo probabilista a utilizar. No obstante las consecuencias no deseadas, los modelos probabilistas ganan terreno en la configuración del riesgo. El consenso intersubjetivo que acepta dichos modelos permite un encuentro entre los expertos, crea el llamado riesgo objetivo.

El rigor y la objetividad científica tiene un valor especial en las cortes de los Estados Unidos, que especifican las reglas para decidir qué constituye evidencia científica y si ésta es confiable y por lo tanto admisible para tenerse en cuenta (Wing, 2003, pág. 1813).

La admisibilidad de la evidencia científica, en estas cortes americanas, se ha basado en criterios como la existencia de una hipótesis comprobable (testable), una metodología sujeta a la revisión de pares, resultados aceptables dentro del porcentaje de error estimado, un adecuado soporte y aceptación de la metodología por parte de una comunidad científica y calificaciones profesionales del experto adecuadas. En este contexto entenderemos la llamada objetividad científica. No obstante, no podemos ignorar que, a pesar del cumplimiento de estos mínimos, la metodología presenta exceso de objetividad. Entendido este exceso como la confianza plena en el modelo científico, excluyendo otros factores (el humano, por ejemplo) que pueden incidir en los resultados.

Los accidentes de Three Mile Island (TMI) en 1979 y de Chernóbil en 1986, que analizaremos en este apartado, son ejemplos del exceso de objetividad en los modelos de plantas nucleares.Wing (2003, p.1816) propone una “objetividad fuerte” en la que el científico o el experto considere otros factores como las fuerzas sociales que configuran el conocimiento creado o construido por estos expertos: “Strong objectivity demands that scientists critically evaluate how the knowledge they create is shaped at every point by historical social forces”. En el contexto de Wing, lo que llamamos exceso de objetividad podría expresarse como una “objetividad débil”. El exceso lo proponemos en el sentido de una polarización hacia el conocimiento experto. Por su parte, Sarewitz (2004, p.389) considera que hay exceso de objetividad cuando la empresa científica extrae de los hechos diversas interpretaciones que permitan apoyar una posición preexistente (la justificación de las plantas nucleares, por ejemplo). Los grados de percepción del riesgo de accidentes en estas instalaciones parecen confirmarse a través del comportamiento de la población en dos casos; Chernóbil por sus efectos adversos, ampliamente conocidos, y TMI por la falta de una historia de desastres similares.Posterior al desastre de Chernóbil se realizaron encuestas sobre este tipo de riesgos. A pesar del desastre, aún se desconocía la verdadera magnitud del mismo. Por ejemplo, en noviembre de 1986 se aplicó una encuesta a 52 médicos (entre pediatras y obstetras) en Massachusetts, evidenciando en algunas de las respuestas el desconocimiento de los impactos de una accidente nuclear: “Physicians’ responses reveal a great deal of uncertainty about the dangers of low level radiation to their patient population. In their answers to question 17, which is concerned with a safe threshold level of radiation, slightly more than half of the respondents are either undecided or disagree with the belief that there is a safe level of radiation” (Winder, et al., 1988, p.133); incluso, algunos encuestados estuvieron de acuerdo en que existía una exageración de los efectos radioactivos. Tres años después se aplica una encuesta referida a los basureros radioactivos cuyos resultados contrastan con la encuesta anterior, en tanto que la mayoría de los encuestados los califican de peligrosos, tóxicos y mortales (Slovic, et al., 1991). Para el caso del basurero en Yucca Mountain:

Nevadans were asked whether or not they would vote in favor of a repository at Yucca Mountain; 69.4% said they vote against it, compared to 14.4% who would vote for it. About 68% of the Nevadans surveyed said they agreed strongly with the statement, ‘The State of Nevada should do all it can to stop the repository’; another 12.5% agreed somewhat with this statement; only 16.0% disagreed (Ibid, p.254).

Los riesgos asociados a la energía nuclear se encuentran rodeados de múltiples intereses económicos, políticos y sociales.

Tres casos han generado fuertes polémicas en torno a la conveniencia o no de la construcción de nuevas plantas nucleares . Cada uno de ellos ha evidenciado la desconfianza en el exceso de objetividad de técnicos y científicos cuyas predicciones han resultado erradas o, en otros casos como en Chernóbil, ha sido maquillada.

En el accidente de TMI se presentan los factores que el modelo objetivo no contempló. Una descripción resumida del acontecimiento presentada por Mariotte (2004, p.3) permite comprender la incidencia de estos factores:Véase Verón (1983) para una información más amplia del accidente y la forma como se divulga en los diferentes medios de comunicación; se destaca en especial el interés por los detalles técnicos y la poca importancia a los posibles impactos en la población. Para una versión oficial consúltese el documento "Fact Sheet on the Three Mile Island Accident” de la United States Nuclear Regulatory Commission (U.S. NRC) en http://www.nrc.gov.

Entre las 3 y las 4 de la madrugada del 28 de marzo de 1979, se realizaban tareas de mantenimiento en el sistema de refrigeración secundario del edificio de la turbina del reactor 2 de Three Mile Island (TMI-2). La empresa Metropolitan Edison (MetEd), subsidiaria de General Public Utilities (GPU), compañía propietaria de TMI, operaba los dos reactores de la central nuclear. Aproximadamente a las 4 de la madrugada, se cerró una válvula del condensador haciendo que el circuito de refrigeración secundario se detenga. Las dos bombas de agua de alimentación principales se detuvieron por falta de agua, la turbina también se detuvo y, por ende, los generadores de vapor siguieron emitiendo calor sin ser refrigerados. Al no funcionar los generadores de vapor, la presión y temperatura del circuito de refrigeración primario comenzó a ascender. Debido a que la creciente presión podía provocar la ruptura de tubos, se abrió automáticamente una válvula, para liberar vapor/agua. A continuación, el reactor se cerró automáticamente cuando se liberaron sus barras de control. Hasta aquí, todo funcionaba como estaba previsto en cierres de emergencia.

Los problemas se agravaron cuando la presión del circuito primario comenzó a descender. En ese momento, la válvula de alivio debería haberse cerrado para evitar que el circuito de refrigeración libere demasiada agua, no obstante, la válvula siguió abierta, pese a que un indicador en la sala de control demostraba erróneamente que estaba cerrada. Este problema fue provocado por una falla de diseño: el indicador solamente mostraba el suministro eléctrico hacia la válvula, pero no si la válvula estaba cerrada o no. La válvula abierta hizo que más y más agua escapara del reactor. Cuando se encendieron las bombas refrigerantes de emergencia del circuito secundario ocurrió otro problema.

Dos válvulas de los tubos de agua de alimentación estaban bloqueadas y, por consiguiente, no se podía abastecer de agua a los generadores de vapor, los cuales quedaron secos. Luego de ocho minutos, las válvulas fueron abiertas manualmente.

Mientras la válvula de alivio seguía perdiendo refrigerante, los instrumentos con los que contaban los operarios del reactor daban información confusa. Ninguno de los instrumentos mostraba el nivel de agua real en el reactor. Los operarios lo calcularon basándose en el nivel del presurizador, que seguía siendo alto e hizo que desconocieran el nivel de agua decreciente en el núcleo del reactor. A raíz del calor residual en el combustible de uranio y la falta de suficiente refrigerante, el revestimiento del combustible comenzó a reventarse y el combustible empezó a fundirse. En menos de ocho horas el núcleo ya estaba (parcial o completamente) seco y el combustible fundido caído en el fondo de la vasija del reactor. Más tarde se descubrió que se había fusionado aproximadamente la mitad del núcleo.

El 28 y 30 de marzo, la planta liberó gases radioactivos. El público desconocía cuál era la situación en la planta. El 30 de marzo, el gobernador de Pennsylvania decidió evacuar a todas las mujeres embarazadas y niños dentro de un radio de 5 millas (8 kilómetros) desde el reactor. Otras 200.000 personas abandonaron el lugar voluntariamente debido a que no confiaban en la información que ofrecía MetEd.

Del texto se infieren tres tipos de errores: i) deficiencias en el diseño, ii) fallas de algunos elementos de la planta y, el menos contemplado en los modelos objetivos, iii) el error humano. Este accidente evidencia una contradicción a las estimaciones de riesgo nuclear presentadas en el conocido informe de Norman Rasmussen (ver apartado 1.1.4.7), cuya predicción de un accidente grave era esperable una vez cada 10.000 millones de años. Esta predicción es falsada por TMI y, posteriormente y en forma contundente, por el accidente de Chernóbil: